資訊專欄INFORMATION COLUMN

摘要:一項由清華大學(xué)計算機(jī)系智能技術(shù)與系統(tǒng)國家重點實驗室清華國家信息實驗室清華大學(xué)計算機(jī)科學(xué)與技術(shù)系英特爾中國研究院清華大學(xué)電子工程系的研究人員共同參與的關(guān)于高效視覺目標(biāo)檢測的研究已經(jīng)被接收。

一項由清華大學(xué)計算機(jī)系智能技術(shù)與系統(tǒng)國家重點實驗室、清華國家信息實驗室、清華大學(xué)計算機(jī)科學(xué)與技術(shù)系、英特爾中國研究院、清華大學(xué)電子工程系的研究人員共同參與的關(guān)于高效視覺目標(biāo)檢測的研究已經(jīng)被 CVPR 2017 接收。論文題目是 RON: Reverse Connection with Objectness Prior Networks for Object Detection。研究者包括孔濤、孫富春、Anbang Yao、劉華平、Ming Lu 和陳玉榮。

基于深度網(wǎng)絡(luò)的目標(biāo)對象檢測可以分為 region-based 和 region-free 兩種方法

目標(biāo)對象檢測領(lǐng)域正在取得重大進(jìn)展,這主要得益于深度網(wǎng)絡(luò)。當(dāng)前較好的基于深度網(wǎng)絡(luò)的目標(biāo)檢測框架可以分為兩個主要方法流派:基于區(qū)域的方法(region-based)和不基于區(qū)域(region-free)的方法。

基于區(qū)域的方法將對象檢測任務(wù)分為兩個子問題:第一階段,將一個專用的候選區(qū)域生成網(wǎng)絡(luò)(region proposal generation network)嫁接到可以生成高質(zhì)量候選框的深度卷積神經(jīng)網(wǎng)絡(luò)(CNN)上;然后,在第二階段,一個區(qū)域性的子網(wǎng)(region-wise subnetwork)被設(shè)計來分類和改進(jìn)這些候選框。使用非常深的 CNN ,F(xiàn)ast R-CNN 工作流程最近在主流對象檢測基準(zhǔn)上顯示出了高精度。

region proposal 階段可以拒絕大多數(shù)背景樣本,因此對象檢測的搜索空間大大減少。多階段訓(xùn)練過程一般是開發(fā)用于區(qū)域候選生成和后檢測的聯(lián)合優(yōu)化。在 Fast R-CNN 中,區(qū)域性子網(wǎng)反復(fù)評估成千上萬個 region proposal,以給出檢測分?jǐn)?shù)。在 Fast R-CNN 工作流程下,F(xiàn)aster R-CNN 與檢測網(wǎng)絡(luò)共享全圖像卷積特征,實現(xiàn)幾乎零成本的 region proposal。最近,R-FCN 試圖通過添加敏感位置的分?jǐn)?shù)圖,使 Faster R-CNN 的 unshared per RoI 計算可共享。然而,R-FCN 仍然需要區(qū)域候選網(wǎng)絡(luò)產(chǎn)生的 region proposal。為了確保檢測精度,所有方法都將圖像的大小調(diào)整到足夠大的尺寸。在訓(xùn)練和推理時間內(nèi),將圖像投喂給深度網(wǎng)絡(luò)時,會有資源和時間的消耗。例如,使用 Faster R-CNN 預(yù)測(將約 5GB GPU 內(nèi)存用于 VGG-16 網(wǎng)絡(luò))每個圖像通常需要 0.2 s。

另一個解決方案是不基于區(qū)域(region-free)的方法。這些方法將對象檢測視為一次性(a single shot)問題,使用全卷積網(wǎng)絡(luò)(FCN),從圖像像素一直處理到邊界框坐標(biāo)。這些檢測器的主要優(yōu)點是效率高。從 YOLO 開始,SSD 試圖用多層深度 CNN 處理物體檢測問題。使用低分辨率輸入,SSD 檢測器可以獲得較先進(jìn)的檢測結(jié)果。然而,這些方法的檢測精度仍有改進(jìn)的余地:(a)沒有 region proposal,檢測器必須在檢測模塊就要抑制所有的負(fù)候選框。這將增加對檢測模塊進(jìn)行訓(xùn)練的難度;(b)YOLO 用最頂端的CNN 層檢測物體,沒有深入探索不同層的檢測能力。 SSD 嘗試通過添加前一層的結(jié)果來提高檢測性能。然而,SSD 仍然受困于 small instance 的問題,主要是由于中間層的信息有限。這兩個主要瓶頸影響了方法的檢測準(zhǔn)確性。

是否能夠結(jié)合兩種方法的優(yōu)勢,并消除其缺點?

這兩個解決方案的成功,也引出了一個關(guān)鍵問題:是否可能開發(fā)一個能夠巧妙地結(jié)合兩種方法的優(yōu)勢并消除其主要缺點的良好框架?通過彌合基于區(qū)域的和不基于區(qū)域的方法之間的 gap,研究者對這一問題進(jìn)行了回答。為了實現(xiàn)這一目標(biāo),研究者關(guān)注兩個基本問題:(a)多尺度對象定位。各種尺度的物體可能出現(xiàn)在圖像的任何位置,因此應(yīng)考慮成千上萬個具有不同位置/尺度/方位的區(qū)域。先前的研究表明,多尺度表征將顯著改善各種尺度的物體檢測。然而,這些方法總是在網(wǎng)絡(luò)的一層檢測到各種尺度的對象。利用研究者提出的反向連接,對象將在其相應(yīng)的網(wǎng)絡(luò)尺度上被檢測到,這更容易優(yōu)化;(b)負(fù)空間挖掘(Negative space mining)。對象和非對象樣本之間的比例嚴(yán)重不平衡。因此,對象檢測器應(yīng)該具有有效的負(fù)挖掘策略。為了減少對象搜索空間,研究者在卷積特征圖上創(chuàng)建了 objectness prior,并在訓(xùn)練階段用檢測器聯(lián)合優(yōu)化。

因此,研究者提出了 RON(Reverse connection with Objectness prior Networks)對象檢測框架,將基于區(qū)域和不基于區(qū)域的方法的優(yōu)點聯(lián)系起來。

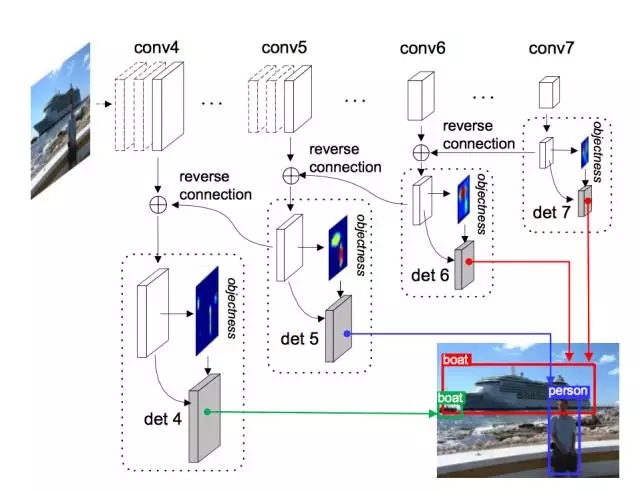

上圖是 RON 對象檢測總覽。給定一張輸入圖像,網(wǎng)絡(luò)首先計算骨干網(wǎng)絡(luò)的特征。然后,(a)添加反向連接;(b)生成 objectness prior;(c)在相應(yīng)的 CNN 尺度和位置上檢測物體。

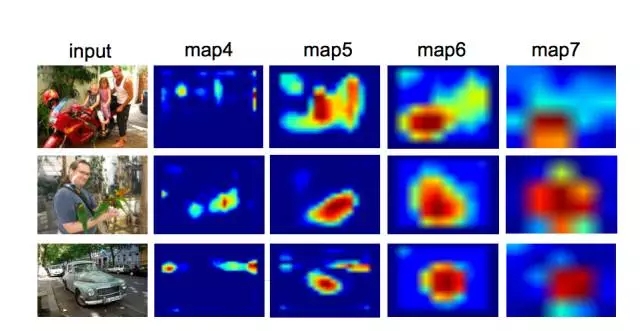

上圖是生成自特定圖像的 objectness prior。在此例中,沙發(fā)表現(xiàn)為(a)和(b),棕色的狗表現(xiàn)為(c),斑點狗表現(xiàn)為(d)。在 objectness prior 的引導(dǎo)下,網(wǎng)絡(luò)生成了檢測結(jié)果。

更多根據(jù)圖像生成的 Objectness Prior 圖

摘要

我們提出了 RON,一個有效、高效的通用對象檢測框架。我們的想法是巧妙地結(jié)合基于區(qū)域(region-based,例如 Faster R-CNN)和不基于區(qū)域(region-free,例如 SSD)這兩種方法的優(yōu)點。在全卷積架構(gòu)下,RON 主要關(guān)注兩個基本問題:(a)多尺度對象定位和(b)負(fù)樣本挖掘。為了解決(a),我們設(shè)計了反向連接,使網(wǎng)絡(luò)能夠檢測多層 CNN 中的對象。為了處理(b),我們提出了 objectness prior,顯著減少對象搜索空間。我們通過多任務(wù)損失函數(shù)聯(lián)合優(yōu)化了反向連接、objectness prior 和對象檢測,因此RON 可以直接預(yù)測各種特征圖所有位置的最終檢測結(jié)果。

在PASCAL VOC 2007,PASCAL VOC 2012 和 MS COCO 基準(zhǔn)測試的大量實驗證明了 RON 的出色性能。具體來說,使用 VGG-16 和低分辨率 384×384 輸入,網(wǎng)絡(luò)在 PASCAL VOC 2007 上獲得 81.3% mAP,在 PASCAL VOC 2012 數(shù)據(jù)集上獲得80.7% mAP。數(shù)據(jù)集越大,難度越大,優(yōu)勢就越明顯。在 MS COCO 數(shù)據(jù)集上的結(jié)果就證明了這一點。測試階段使用 1.5G GPU 內(nèi)存,網(wǎng)絡(luò)速度為 15 FPS,比 Faster R-CNN 計數(shù)器快 3 倍。

論文地址:https://arxiv.org/abs/1707.01691

商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價值的辦法,實際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://specialneedsforspecialkids.com/yun/4575.html

摘要:本屆會議共收到論文篇,創(chuàng)下歷史記錄有效篇。會議接收論文篇接收率。大會共有位主旨演講人。同樣,本屆較佳學(xué)生論文斯坦福大學(xué)的,也是使用深度學(xué)習(xí)做圖像識別。深度學(xué)習(xí)選擇深度學(xué)習(xí)選擇不過,也有人對此表示了擔(dān)心。指出,這并不是做學(xué)術(shù)研究的方法。 2016年的計算機(jī)視覺領(lǐng)域國際頂尖會議 Computer Vision and Pattern Recognition conference(CVPR2016...

摘要:目前目標(biāo)檢測領(lǐng)域的深度學(xué)習(xí)方法主要分為兩類的目標(biāo)檢測算法的目標(biāo)檢測算法。原來多數(shù)的目標(biāo)檢測算法都是只采用深層特征做預(yù)測,低層的特征語義信息比較少,但是目標(biāo)位置準(zhǔn)確高層的特征語義信息比較豐富,但是目標(biāo)位置比較粗略。 目前目標(biāo)檢測領(lǐng)域的深度學(xué)習(xí)方法主要分為兩類:two stage的目標(biāo)檢測算法;one stage的目標(biāo)檢測算法。前者是先由算法生成一系列作為樣本的候選框,再通過卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行樣本...

摘要:在本次競賽中,南京信息工程大學(xué)和帝國理工學(xué)院的團(tuán)隊獲得了目標(biāo)檢測的最優(yōu)成績,最優(yōu)檢測目標(biāo)數(shù)量為平均較精確率為。最后在視頻目標(biāo)檢測任務(wù)中,帝國理工大學(xué)和悉尼大學(xué)所組成的團(tuán)隊取得了較佳表現(xiàn)。 在本次 ImageNet 競賽中,南京信息工程大學(xué)和帝國理工學(xué)院的團(tuán)隊 BDAT 獲得了目標(biāo)檢測的最優(yōu)成績,最優(yōu)檢測目標(biāo)數(shù)量為 85、平均較精確率為 0.732227。而在目標(biāo)定位任務(wù)中Momenta和牛津...

摘要:何愷明和兩位大神最近提出非局部操作為解決視頻處理中時空域的長距離依賴打開了新的方向。何愷明等人提出新的非局部通用網(wǎng)絡(luò)結(jié)構(gòu),超越。殘差連接是何愷明在他的年較佳論文中提出的。 Facebook何愷明和RGB兩位大神最近提出非局部操作non-local operations為解決視頻處理中時空域的長距離依賴打開了新的方向。文章采用圖像去噪中常用的非局部平均的思想處理局部特征與全圖特征點的關(guān)系。這種...

摘要:在過去幾年中,深度學(xué)習(xí)改變了整個人工智能的發(fā)展。在本文中,我將介紹年深度學(xué)習(xí)的一些主要進(jìn)展,與年深度學(xué)習(xí)進(jìn)展版本一樣,我沒有辦法進(jìn)行詳盡的審查。最后的想法與去年的情況一樣,年深度學(xué)習(xí)技術(shù)的使用持續(xù)增加。 在過去幾年中,深度學(xué)習(xí)改變了整個人工智能的發(fā)展。深度學(xué)習(xí)技術(shù)已經(jīng)開始在醫(yī)療保健,金融,人力資源,零售,地震檢測和自動駕駛汽車等領(lǐng)域的應(yīng)用程序中出現(xiàn)。至于現(xiàn)有的成果表現(xiàn)也一直在穩(wěn)步提高。在學(xué)術(shù)...

閱讀 369·2023-04-25 16:38

閱讀 1482·2021-09-26 09:46

閱讀 3326·2021-09-08 09:35

閱讀 2778·2019-08-30 12:54

閱讀 3248·2019-08-29 17:06

閱讀 1017·2019-08-29 14:06

閱讀 3344·2019-08-29 13:00

閱讀 3466·2019-08-28 17:53