資訊專欄INFORMATION COLUMN

摘要:本屆會議共收到論文篇,創下歷史記錄有效篇。會議接收論文篇接收率。大會共有位主旨演講人。同樣,本屆較佳學生論文斯坦福大學的,也是使用深度學習做圖像識別。深度學習選擇深度學習選擇不過,也有人對此表示了擔心。指出,這并不是做學術研究的方法。

2016年的計算機視覺領域國際頂尖會議 Computer Vision and Pattern Recognition conference(CVPR2016)昨天在美國拉斯維加斯召開,會議將持續到當地時間6月30日下午。

本屆會議共收到論文 2145 篇,創下歷史記錄(有效 1865 篇)。會議接收論文 643 篇(接收率 29.9%)。其中,今年的大會還特別開設 Spotlight Session,讓 123 篇論文的講者有 4 分鐘的時間口頭介紹其研究核心。

大會共有 3 位主旨演講人。第一天是 Amnon Shashua,著名計算機視覺算法公司 Mobileye 的聯合創始人。第二天,也就是今天的主旨演講,由哈佛大學心理系教授 Elizabeth Spelke 進行,主題是科學研究中的男女性別平等。明天的主旨演講者是牛津大學人類未來研究所的教授 Nick Bostrom。這樣看,不僅僅是計算機視覺和模式識別,主辦方連科研性別平等和人工智能發展趨勢都考慮了進去。

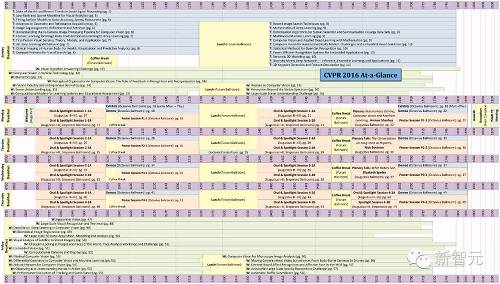

CVPR2016 活動日程表。短短三天,承載這么多的內容。

深度學習一統計算機視覺江湖

?

根據 Twiiter 上的消息,主要展臺都各有看點。例如 Twitter Cortex,剛剛收了 Magic Pony,展臺前聚集了很多人。

Twitter Cortex 展臺前人群聚集。來源:Twitter

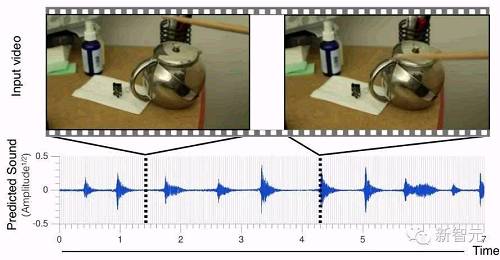

MIT的研究者在會議上發布了給視頻配音的研究。

谷歌也在 Google Research Blog 刊登出了 CVPR 2016 相關內容,論文、口頭報告、研討會,加起來總共十幾項。

TechCrunch 具體報道了谷歌與幾所高校合作的項目。

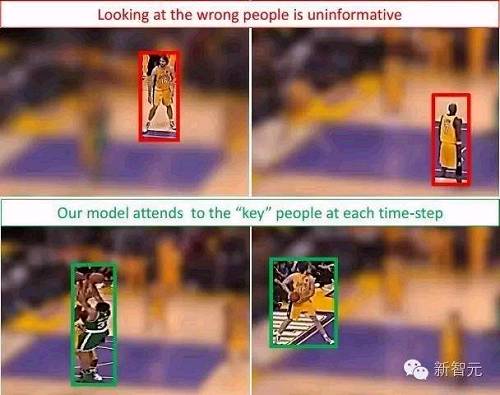

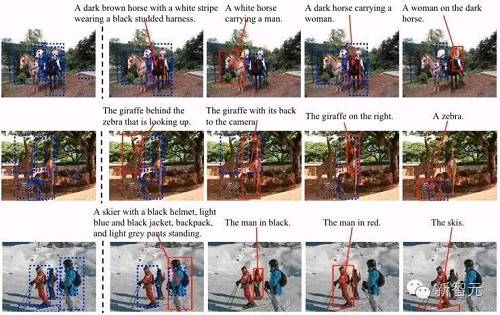

其中,谷歌與斯坦福大學合作,教計算機學會分辨場景中的關鍵信息。這項研究的目的是在同時有多人場景的視頻中跟蹤關鍵目標。論文以籃球比賽視頻為例,計算機需要識別出場上最應該注意的球員。

從畫面中識別出關鍵目標才能提供更大信息量

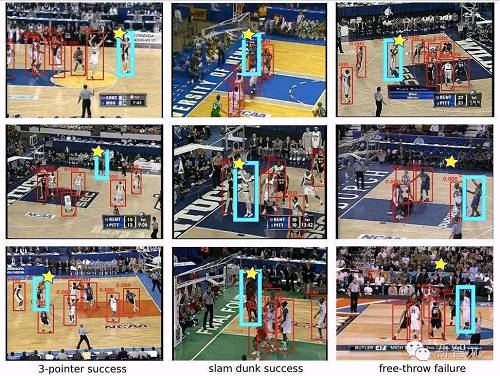

研究人員利用遞歸神經網絡設計了一個計算機視覺系統,下圖就是計算機查看每一幀畫面時的“注意力模式”(attention mask)。圖中紅框標注場上球員,五角星代表籃球,持球運動員則用藍框表示。

三分球、成功搶到籃板球和投籃失敗的場景

經過訓練后,這個使用遞歸神經網絡的系統不僅能夠識別出當前畫面中的關鍵目標,也可以預測接下來即將成為關鍵目標的是什么,這樣畫面與畫面之間的動作變化則將前后的關鍵部分連接起來。

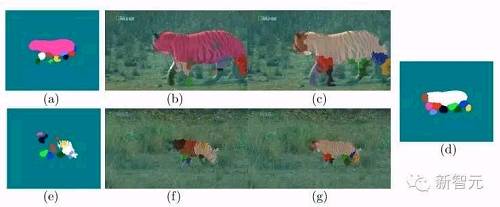

谷歌與愛丁堡大學合作的一項研究,圖像識別系統的任務是學會找出每一幀畫面里,老虎的四條腿是如何運動的,并且預測接下來它將如何邁步。以往的研究是將畫面中活動的物體當做一個整體,這項研究則分別跟蹤老虎的四條腿,并分別預測接下來每條腿的運動軌跡。

谷歌與 UCLA、牛津大學以及約翰霍普金斯大學合作的研究,訓練圖像識別系統理解照片中不同部分的互動關系,生成更較精確的描述。

當然,上面介紹的這三篇論文都使用了深度學習。實際上,正如 TechCrunch 報道最后所說,放眼望去,深度學習幾乎成了如今計算機視覺研究的標配。

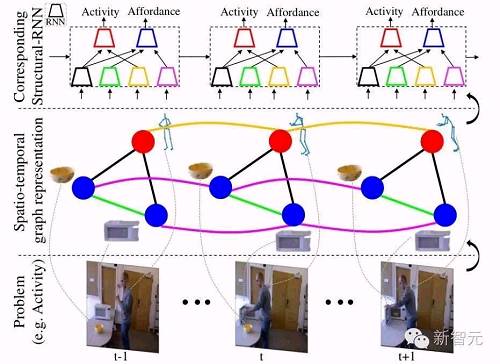

同樣,本屆 CVPR 2016較佳學生論文、斯坦福大學的 “Structural-RNN: Deep Learning on Spatio-Temporal Graphs”,也是使用深度學習做圖像識別。

深度學習 ≠ 選擇

?

不過,也有人對此表示了擔心。

?

法國 Inria 研究所的研究員 Nikos Paragios 在 LinkedIn 撰文指出,直到 2010年,計算機視覺領域相關會議所涉及的專題,無論是從內容上還是從方法上都相對完善,包括早期視覺、分割和組合、運動檢測和跟蹤、視覺識別以及三維視覺,而且幾乎所有研究都用到了統計、幾何和優化的方法。參加這樣的一次會議,能讓人對計算機視覺技術的現狀、問題及發展獲得全面的了解。

?

但如今,絕大部分研究都使用了深度學習。當然,Paragios 也表示,每個時期都自有其主導的潮流:20 世紀 80 年代是立體視覺(stereo)、20 世紀 90 年代是連續方法和分割組合,世紀之交離散方法上位,人們也開始再次關注視覺識別和描述。與此同時,機器學習作為一股后浪隨著前浪襲來,但盡管如此,當時的計算機視覺研究還算多樣化,任選一個子領域就能看見新的想法。

?

但現在情況則大不相同。各個研究都專注于使用深度學習的方法解決計算機視覺問題,會議接收的論文里,發表的論文中有 80% 到 90%,口頭報告更是接近 100% 都來自深度學習領域。Paragios 在文章中寫道,雖然這樣做沒有問題,這些論文也都體現了實力,但他想知道這些研究“增加的”科學價值在哪里。

在 Paragios 看來,除了一小部分人還在堅持做基礎研究,探索深度學習方法的理論概念,大部分人似乎都跑去搭建更復雜、更龐大的框架——而且從所提交的論文看,基本上所有描述的框架都是不可擴展的。也就是說,盡管表面上看去成果豐碩,但深究起來這些論文背后幾乎沒有什么理論論證,因此也談不上為某個基準增添了性能。Paragios 指出,這并不是做學術研究的方法。眾人的注意力都放在更快的速度更高的效率上,但追求的目標還是與以往一樣,并不遠大,而且眾人眼中實現目標的方法也僅剩一條了。

?

不僅會議如此,科研基金也如此,而這就直接導致了計算機視覺研究“理論深度”變淺,研究方向單一。Paragios 接著寫道,如果這只是因為近年來計算力和大數據崛起推動所致,那么這股熱潮自會過去,計算機視覺也會遵循計算機圖形的發展軌跡,從活動和學術研究的量上說,逐漸成為一門邊緣學科。

?

如果不是的話,Paragios 表示——那么問題來了:計算機視覺的下一步發展將是什么?“你怎么讓那些剛從學校出來,很有可能連統計學習、模式識別、歐氏幾何、連續和離散優化都沒聽說過的的博士生提出新的想法?”

?

雖然事情不至于這么極端,但照這樣發展下去,Paragios 寫道,結果就只有兩條:要么是大家走向共和,實現 David Marr 的假說——單一計算框架能解決所有視覺感知問題,當然這也是一項成就;但萬一要是沿著深度學習走下去,最終卻無法解決各種各樣的計算機視覺問題……

Paragios 稱自己是深度學習懷疑論者、接受者、倡導者中的后兩種,但對前景還很迷茫。不過,他主張的研究多樣化,的確值得深思。

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4352.html

摘要:于月日至日在意大利比薩舉行,主會于日開始。自然語言理解領域的較高級科學家受邀在發表主旨演講。深度學習的方法在這兩方面都能起到作用。下一個突破,將是信息檢索。深度學習在崛起,在衰退的主席在卸任的告別信中這樣寫到我們的大會正在衰退。 SIGIR全稱ACM SIGIR ,是國際計算機協會信息檢索大會的縮寫,這是一個展示信息檢索領域中各種新技術和新成果的重要國際論壇。SIGIR 2016于 7月17...

摘要:對于大多數想上手深度學習的小伙伴來說,我應當從那篇論文開始讀起這是一個亙古不變的話題。接下來的論文將帶你深入理解深度學習方法深度學習在前沿領域的不同應用。 對于大多數想上手深度學習的小伙伴來說,我應當從那篇論文開始讀起?這是一個亙古不變的話題。而對那些已經入門的同學來說,了解一下不同方向的論文,也是不時之需。有沒有一份完整的深度學習論文導引,讓所有人都可以在里面找到想要的內容呢?有!今天就給...

摘要:年月日,將標志著一個時代的終結。數據集最初由斯坦福大學李飛飛等人在的一篇論文中推出,并被用于替代數據集后者在數據規模和多樣性上都不如和數據集在標準化上不如。從年一個專注于圖像分類的數據集,也是李飛飛開創的。 2017 年 7 月 26 日,將標志著一個時代的終結。那一天,與計算機視覺頂會 CVPR 2017 同期舉行的 Workshop——超越 ILSVRC(Beyond ImageNet ...

摘要:但年在機器學習的較高級大會上,蘋果團隊的負責人宣布,公司已經允許自己的研發人員對外公布論文成果。蘋果第一篇論文一經投放,便在年月日,斬獲較佳論文。這項技術由的和開發,使用了生成對抗網絡的機器學習方法。 GANs「對抗生成網絡之父」Ian Goodfellow 在 ICCV 2017 上的 tutorial 演講是聊他的代表作生成對抗網絡(GAN/Generative Adversarial ...

摘要:第二次則是今年初,論文被深度學習盛會拒絕。表示遺憾乃至憤怒的人不在少數。他認為,使從其他學術實驗室中脫穎而出的,是它的跨領域文化。騰訊也在籌建人工智能實驗室,近期消息就會正式公布。 牛津大學和 DeepMind 的研究人員合作,開發出一款能夠閱讀唇語的系統,這個名叫 Watch, Attend and Spell(WAS)的軟件在實際表現中遠遠超越了人類專家的水平。研究人員使用計算機視覺和機...

閱讀 2561·2023-04-25 18:13

閱讀 768·2021-11-22 12:10

閱讀 2968·2021-11-22 11:57

閱讀 2137·2021-11-19 11:26

閱讀 2163·2021-09-22 15:40

閱讀 1460·2021-09-03 10:28

閱讀 2703·2019-08-30 15:53

閱讀 1949·2019-08-30 15:44