資訊專欄INFORMATION COLUMN

摘要:目前目標檢測領域的深度學習方法主要分為兩類的目標檢測算法的目標檢測算法。原來多數的目標檢測算法都是只采用深層特征做預測,低層的特征語義信息比較少,但是目標位置準確高層的特征語義信息比較豐富,但是目標位置比較粗略。

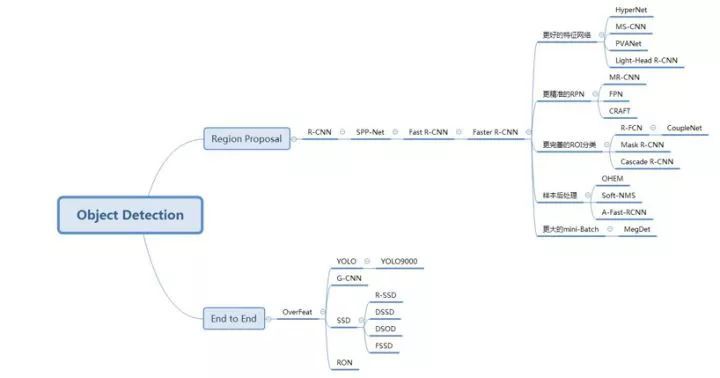

目前目標檢測領域的深度學習方法主要分為兩類:two stage的目標檢測算法;one stage的目標檢測算法。前者是先由算法生成一系列作為樣本的候選框,再通過卷積神經網絡進行樣本分類;后者則不用產生候選框,直接將目標邊框定位的問題轉化為回歸問題處理。正是由于兩種方法的差異,在性能上也有不同,前者在檢測準確率和定位精度上占優,后者在算法速度上占優。

目標檢測算法脈絡

1. two stage的方法

在早期深度學習技術發展進程中,主要都是圍繞分類問題展開研究,這是因為神經網絡特有的結構輸出將概率統計和分類問題結合,提供一種直觀易行的思路。國內外研究人員雖然也在致力于將其他如目標檢測領域和深度學習結合,但都沒有取得成效,這種情況直到R-CNN算法出現才得以解決。

1.1 R-CNN

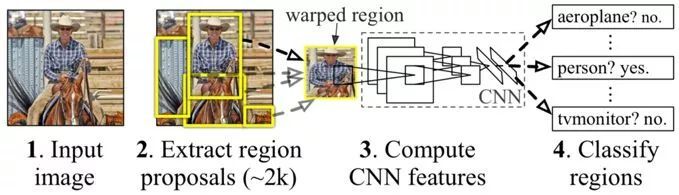

2014年加州大學伯克利分校的Ross B. Girshick提出R-CNN算法,其在效果上超越同期的Yann Lecun提出的端到端方法OverFeat算法,其算法結構也成為后續two stage的經典結構。

R-CNN算法利用選擇性搜索(Selective Search)算法評測相鄰圖像子塊的特征相似度,通過對合并后的相似圖像區域打分,選擇出感興趣區域的候選框作為樣本輸入到卷積神經網絡結構內部,由網絡學習候選框和標定框組成的正負樣本特征,形成對應的特征向量,再由支持向量機設計分類器對特征向量分類,最后對候選框以及標定框完成邊框回歸操作達到目標檢測的定位目的。

雖然R-CNN算法相較于傳統目標檢測算法取得了50%的性能提升,但其也有缺陷存在:訓練網絡的正負樣本候選區域由傳統算法生成,使得算法速度受到限制;卷積神經網絡需要分別對每一個生成的候選區域進行一次特征提取,實際存在大量的重復運算,制約了算法性能。

圖1.1 R-CNN

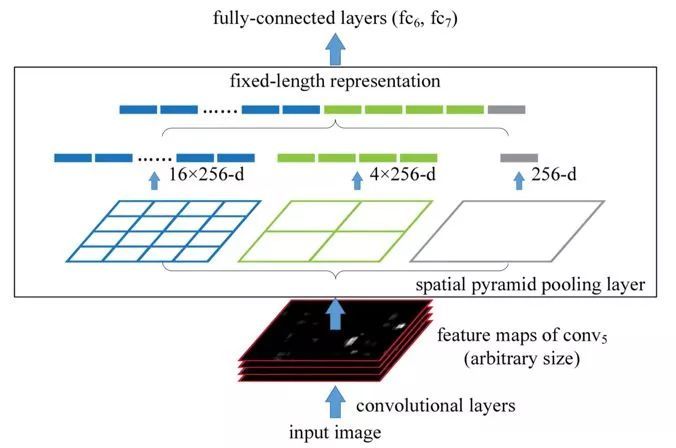

1.2 SPP-Net

圖1.2 spatial pyramid pooling layer

針對卷積神經網絡重復運算問題,2015年微軟研究院的何愷明等提出一種SPP-Net算法,通過在卷積層和全連接層之間加入空間金字塔池化結構(Spatial Pyramid Pooling)代替R-CNN算法在輸入卷積神經網絡前對各個候選區域進行剪裁、縮放操作使其圖像子塊尺寸一致的做法。

利用空間金字塔池化結構有效避免了R-CNN算法對圖像區域剪裁、縮放操作導致的圖像物體剪裁不全以及形狀扭曲等問題,更重要的是解決了卷積神經網絡對圖像重復特征提取的問題,大大提高了產生候選框的速度,且節省了計算成本。但是和R-CNN算法一樣訓練數據的圖像尺寸大小不一致,導致候選框的ROI感受野大,不能利用BP高效更新權重。

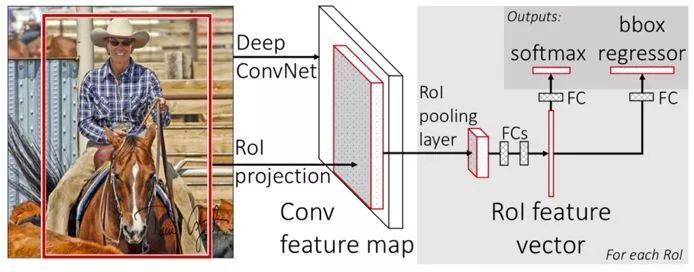

1.3 Fast R-CNN

針對SPP-Net算法的問題,2015年微軟研究院的Ross B. Girshick又提出一種改進的Fast R-CNN算法,借鑒SPP-Net算法結構,設計一種ROI pooling的池化層結構,有效解決R-CNN算法必須將圖像區域剪裁、縮放到相同尺寸大小的操作。

提出多任務損失函數思想,將分類損失和邊框回歸損失結合統一訓練學習,并輸出對應分類和邊框坐標,不再需要額外的硬盤空間來存儲中間層的特征,梯度能夠通過RoI Pooling層直接傳播。但是其仍然沒有擺脫選擇性搜索算法生成正負樣本候選框的問題。

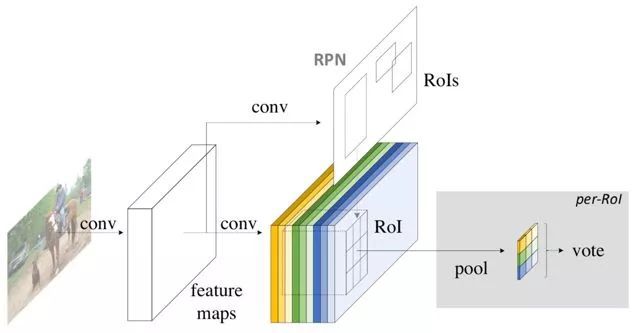

圖1.3 Fast R-CNN

1.4 Faster R-CNN

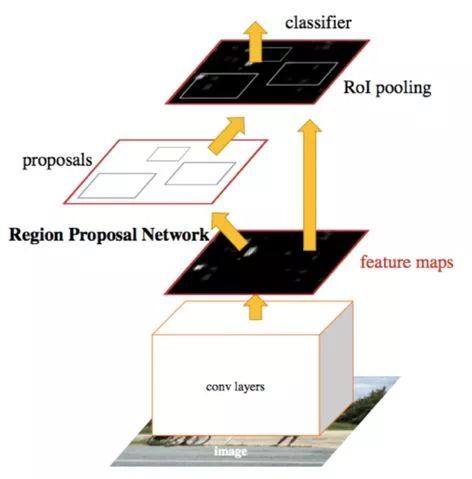

為了解決Fast R-CNN算法缺陷,使得算法實現two stage的全網絡結構,2015年微軟研究院的任少慶、何愷明以及Ross B Girshick等人又提出了Faster R-CNN算法。設計輔助生成樣本的RPN(Region Proposal Networks)網絡,將算法結構分為兩個部分,先由RPN網絡判斷候選框是否為目標,再經分類定位的多任務損失判斷目標類型,整個網絡流程都能共享卷積神經網絡提取的的特征信息,節約計算成本,且解決Fast R-CNN算法生成正負樣本候選框速度慢的問題,同時避免候選框提取過多導致算法準確率下降。

但是由于RPN網絡可在固定尺寸的卷積特征圖中生成多尺寸的候選框,導致出現可變目標尺寸和固定感受野不一致的現象。

圖1.4 Faster R-CNN

1.5 MR-CNN

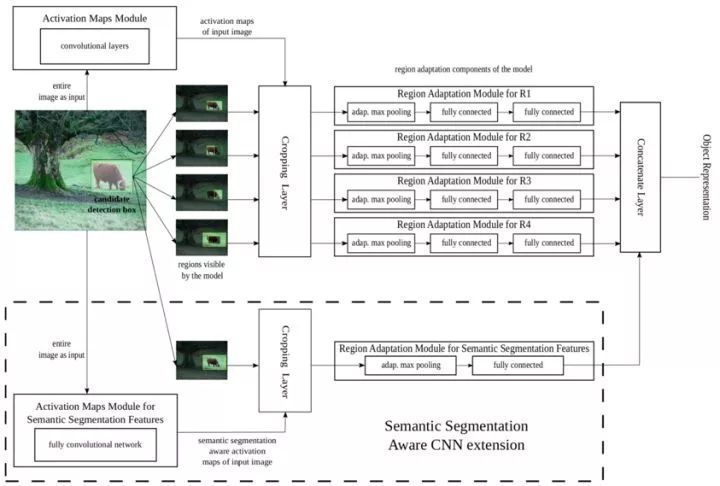

2015年巴黎科技大學提出MR-CNN算法,結合樣本區域本身的特征,利用樣本區域周圍采樣的特征和圖像分割的特征來提高識別率,可將檢測問題分解為分類和定位問題。

圖1.5 MR-CNN

分類問題由Multi-Region CNN Model和Semantic Segmentation-Aware CNN Model組成。前者的候選框由Selective Search得到,對于每一個樣本區域,取10個區域分別提取特征后拼接,這樣可以強制網絡捕捉物體的不同方面,同時可以增強網絡對于定位不準確的敏感性,其中adaptive max pooling即ROI max pooling;后者使用FCN進行目標分割,將最后一層的feature map和前者產生的feature map拼接,作為最后的feature map。

為了較精確定位,采用三種樣本邊框修正方法,分別為Bbox regression、Iterative localization以及Bounding box voting。Bbox regression:在Multi-Region CNN Model中整幅圖經過網路的最后一層卷積層后,接一個Bbox regression layer,與RPN不同,此處的regression layer是兩層FC以及一層prediction layer,為了防止Selective Search得到的框過于貼近物體而導致無法很好的框定物體,將候選框擴大為原來的1.3倍再做。

Iterative localization:初始的框是Selective Search得到的框,然后用已有的分類模型對框做出估值,低于給定閾值的框被篩掉,剩下的框用Bbox regression的方法調整大小,并迭代篩選。Bounding box voting:首先對經過Iterative localization處理后的框應用NMS, IOU = 0.3,得到檢測結果,然后對于每一個框,用每一個和其同一類的而且IOU >0.5的框加權坐標,得到最后的目標樣本框。

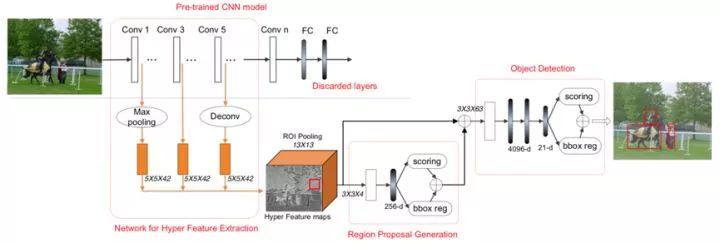

1.6 HyperNet

2016年清華大學提出HyperNet算法,其利用網絡多個層級提取的特征,且從較前層獲取的精細特征可以減少對于小物體檢測的缺陷。將提取到的不同層級feature map通過較大池化降維或逆卷積擴增操作使得所有feature map尺寸一致,并利用LRN正則化堆疊,形成Hyper

Feature maps,其具有多層次抽象、合適分辨率以及計算時效性的優點。接著通過region proposal generation module結構進行預測和定位,僅保留置信度較高的N個樣本框進行判斷。

圖1.6 HyperNet

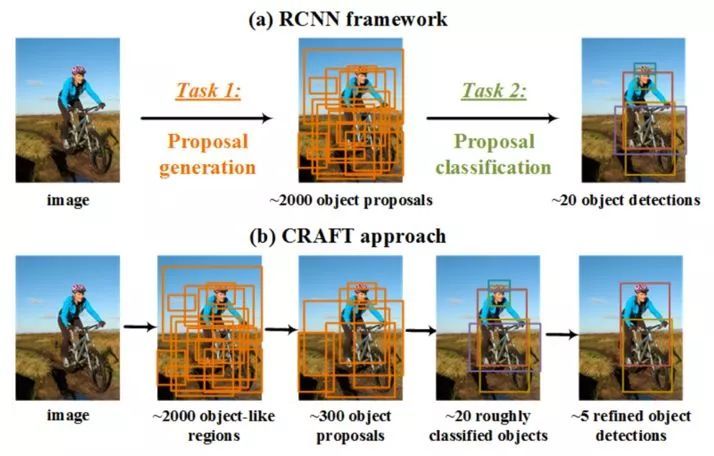

1.7 CRAFT

圖1.7 CRAFT

R-CNN系列算法的第一階段是生成目標proposals,第二階段是對目標proposals進行分類,2016年中科院自動化所提出的CRAFT算法分別對Faster R-CNN中的這兩個階段進行了一定的改進。

對于生成目標proposals階段,在RPN的后面加了一個二值的Fast R-CNN分類器來對RPN生成的proposals進行進一步的篩選,留下一些高質量的proposals;對于第二階段的目標proposals分類,在原來的分類器后又級聯了N個類別(不包含背景類)的二值分類器以進行更精細的目標檢測。

1.8 R-FCN

圖1.8 R-FCN

隨著全卷積網絡的出現,2016年微軟研究院的Jifeng Dai等提出R-FCN算法。相較于Faster R-CNN算法只能計算ROI pooling層之前的卷積網絡特征參數,R-FCN算法提出一種位置敏感分布的卷積網絡代替ROI pooling層之后的全連接網絡,解決了Faster R-CNN由于ROI

Pooling層后面的結構需要對每一個樣本區域跑一次而耗時比較大的問題,使得特征共享在整個網絡內得以實現,解決物體分類要求有平移不變性和物體檢測要求有平移變化的矛盾,但是沒有考慮到region proposal的全局信息和語義信息。

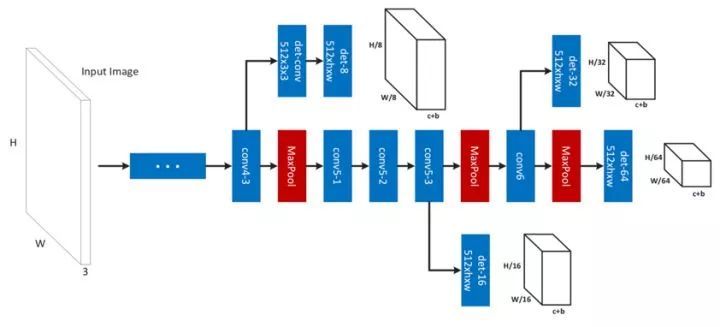

1.9 MS-CNN

針對Faster R-CNN算法的遺留問題,2016年加州大學圣地亞哥分校的Z Cai提出了MS-CNN算法,通過利用Faster R-CNN算法結構的多個不同層級輸出的特征結果來檢測目標,將不同層級的檢測器互補形成多尺度的強檢測器,應用淺層特征檢測小尺寸目標,應用深層特征檢測大尺寸目標。并且利用去卷積層代替圖像上采樣來增加圖像分辨率,減少內存占用,提高運行速度。

圖1.9 MS-CNN的特征網絡

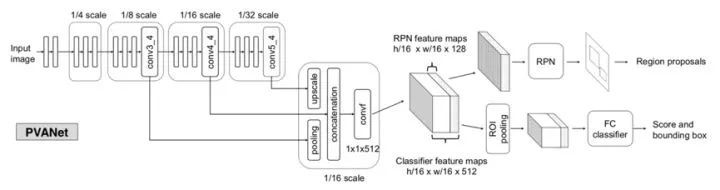

1.10 PVANet

針對的就是算法的運算速度提升問題,2016年底Intel圖像技術團隊提出了一個輕量級的網絡,取得了state-of-the-art的效果。PVANet主要分為特征抽取網絡和檢測網絡,基于多層少通道的基本原則,在網絡淺層采用C.ReLU結構,在網絡深層采用Inception模塊,其中前者是將K×K卷積結構表示1×1 - K×K - 1×1的卷積層的堆疊,后者設計原則是由于為了檢測圖像中的大目標,需要足夠大的感受野,可通過堆疊3×3的卷積核實現,但是為了捕獲小目標,則需要小一點的感受野,可通過1×1的卷積核實現,且可以避免大卷積核造成的參數冗余問題。

PVANet應用多尺度特征級聯較大化目標檢測任務的多尺度性質,權重衰減策略采用一定迭代次數內loss不再下降,則將學習速率降低常數倍的方式,通過batch normalization和residual連接實現高效的訓練。

圖1.10 PVANet

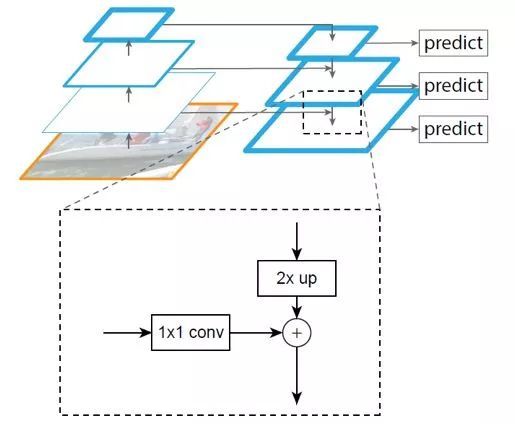

1.11 FPN

2017年Facebook的Tsung-Yi Lin等提出了FPN算法,利用不同層的特征圖進行不同尺寸的目標預測。原來多數的目標檢測算法都是只采用深層特征做預測,低層的特征語義信息比較少,但是目標位置準確;高層的特征語義信息比較豐富,但是目標位置比較粗略。

另外雖然也有些算法采用多尺度特征融合的方式,但是一般是采用融合后的特征做預測,而FPN算法不一樣的地方在于預測是在不同特征層獨立進行的,利用深層特征通過上采樣和低層特征做融合。

FPN算法主網絡是ResNet,結構主要是一個自底向上的線路橫向連接一個自頂向下的線路。自底向上其實就是網絡的前向過程,在前向過程中,feature map的大小在經過某些層后會改變,而在經過其他一些層的時候不會改變,FPN算法將不改變feature map大小的層歸為一個stage,因此每次抽取的特征都是每個stage的最后一個層輸出,這樣就能構成特征金字塔。

自頂向下的過程采用上采樣進行,而橫向連接則是將上采樣的結果和自底向上生成的相同大小的feature map并一一對應進行融合,在融合之后還會再采用3×3的卷積核對每個融合結果進行卷積,目的是消除上采樣的混疊效應。

圖1.11 FPN

1.12 Mask R-CNN

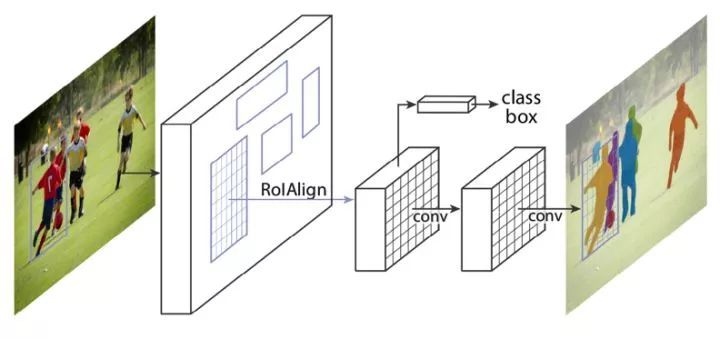

為了解決R-CNN算法為代表的two stage的方法問題,2017年Facebook的何愷明等提出了Mask R-CNN算法,取得了很好的識別效果。

Mask R-CNN算法將ROI_Pooling層替換成了ROI_Align,并且在邊框識別的基礎上添加分支FCN層(mask層),用于語義Mask識別,通過RPN網絡生成目標候選框,再對每個目標候選框分類判斷和邊框回歸,同時利用全卷積網絡對每個目標候選框預測分割掩膜。

加入的掩膜預測結構解決了特征圖像和原始圖像上的ROI不對準問題,避免對ROI邊界做任何量化,而用雙線性插值到對準特征,再用池化操作融合。掩膜編碼了輸入圖像的空間布局,用全卷積網絡預測每個目標候選框的掩膜能完整的保留空間結構信息,實現目標像素級分割定位。

圖1.12 Mask R-CNN

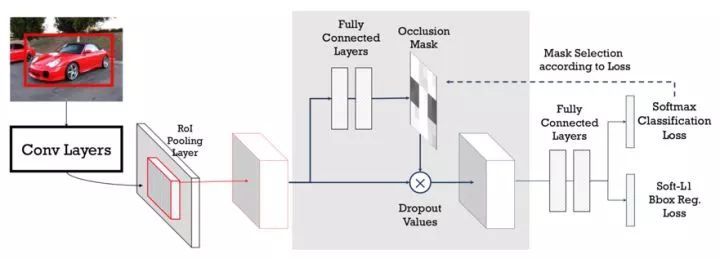

1.13 A-Fast-RCNN

A-Fast-RCNN算法是2017年卡內基梅隆大學提出的,其將對抗學習引入到目標檢測問題中,通過對抗網絡生成一下遮擋和變形的訓練樣本來訓練檢測網絡,從而使得網絡能夠對遮擋和變形問題更加的魯棒。使用對抗網絡生成有遮擋和有形變的兩種特征,兩種網絡分別為ASDN和ASTN。

ASDN利用Fast R-CNN中ROI池化層之后的每個目標proposal卷積特征作為對抗網絡的輸入,給定一個目標的特征,ASDN嘗試生成特征某些部分被dropout的掩碼,導致檢測器無法識別該物體。

在前向傳播過程中,首先使用ASDN在ROI池化層之后生成特征掩碼,然后使用重要性采樣法生成二值掩碼,使用該掩碼將特征對應部位值清零,修改后的特征繼續前向傳播計算損失,這個過程生成了困難的特征,用于訓練檢測器。

ASTN主要關注特征旋轉,定位網絡包含三層全連接層,前兩層是ImageNet預訓練的FC6和FC7,訓練過程與ASDN類似,ASTN對特征進行形變,將特征圖劃分為4個block,每個block估計四個方向的旋轉,增加了任務的復雜度。兩種對抗網絡可以相結合,使得檢測器更魯棒,ROI池化層提取的特征首先傳入ASDN丟棄一些激活,之后使用ASTN對特征進行形變。

圖1.13 A-Fast-RCNN

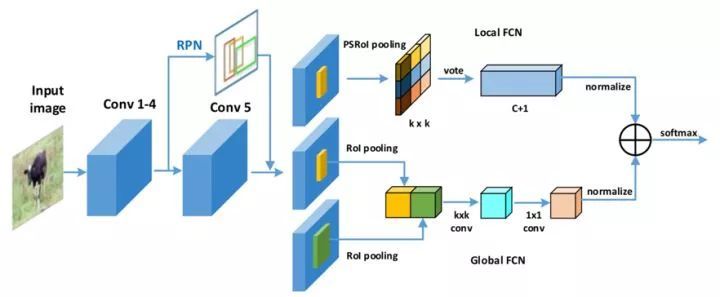

1.14 CoupleNet

針對R-FCN算法沒有考慮到region proposal的全局信息和語義信息的問題,2017年中科院自動化所提出CoupleNet算法,其在原來R-FCN的基礎上引入了proposal的全局和語義信息,通過結合局部、全局以及語義的信息,提高了檢測的精度。

圖1.14 CoupleNet

CoupleNet結構利用三支并行網絡實現檢測,上面的支路網絡使用原本的R-FCN結構的位置敏感分布圖提取目標的局部信息;中間的支路網絡用于提取目標的全局信息,對于一個region proposal,依次通過K×K的ROI Pooling,K×K的conv以及1×1的conv;下面的支路網絡用于提取目標的語義信息,對于一個region proposal,首先選擇以這個proposal為中心,面積是原來2倍的proposal,同樣依次通過K×K的ROI Pooling,K×K的conv以及1×1的conv。最后先各自通過1×1的conv調整激活值的尺寸,然后把Local FCN和Global FCN結果對應位置元素相加,再通過一個softmax實現分類。

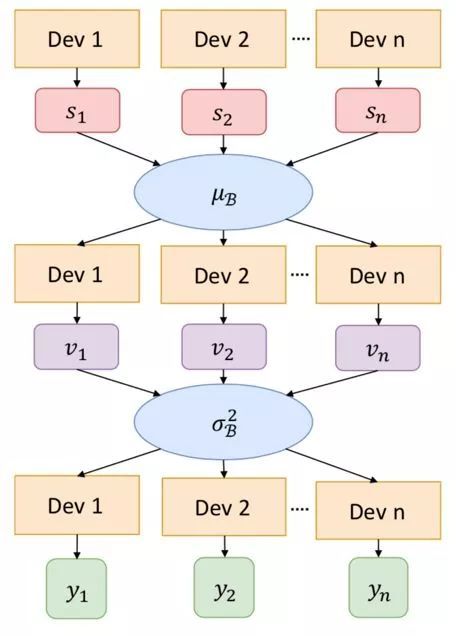

1.15 MegDet

基于CNN的物體檢測研究一直在不斷進步,從R-CNN到Fast/Faster R-CNN,再Mask R-CNN,主要的改進點都在于新的網絡架構、新的范式、或者新的損失函數設計,然而mini-batch大小,這個訓練中的關鍵因素并沒有得到完善的研究。

由于輸入圖片尺寸的增長,圖像檢測所需顯存量也會同比例增長,這也使得已有的深度學習框架無法訓練大mini-batch的圖像檢測模型,而小mini-batch的物體檢測算法又常常會引入不穩定的梯度、BN層統計不準確、正負樣本比例失調以及超長訓練時間的問題。因此,2017年12月Face++提出一種大mini-batch的目標檢測算法MegDet。

圖1.15 多GPU的Batch Normalization

MegDet算法可以使用遠大于以往的mini-batch大小訓練網絡(比如從16增大到256),這樣同時也可以高效地利用多塊GPU聯合訓練(在論文的實驗中最多使用了128塊GPU),大大縮短訓練時間。

同時,解決了BN統計不準確的問題,也提出了一種學習率選擇策略以及跨GPU的Batch Normalization方法,兩者共同使用就得以大幅度減少大mini-batch物體檢測器的訓練時間(比如從33小時減少到僅僅4個小時),同時還可以達到更高的準確率。

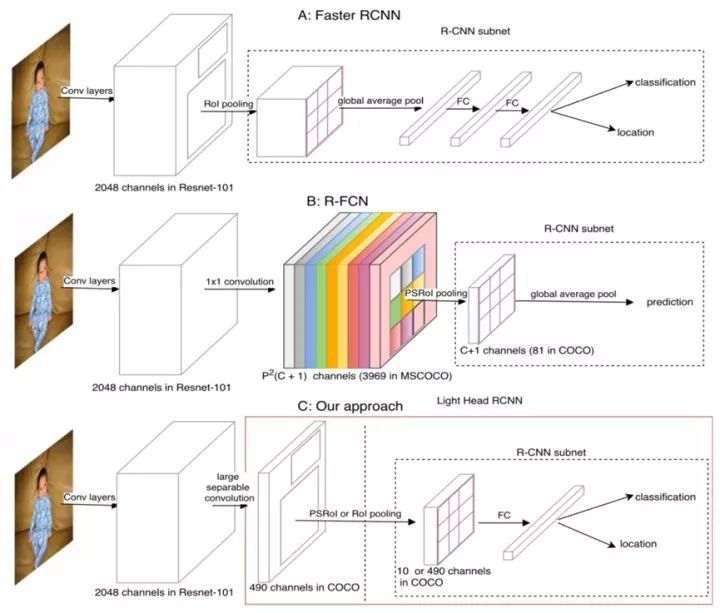

1.16 Light-Head R-CNN

2017年12月Face++提出了一種為了使two stage的檢測算法Light-Head R-CNN,主要探討了R-CNN如何在物體檢測中平衡較精確度和速度。Light-Head R-CNN提出了一種更好的two-stage detector設計結構,使用一個大內核可分卷積和少量通道生成稀疏的特征圖。

該設計的計算量使隨后的ROI子網絡計算量大幅降低,檢測系統所需內存減少。將一個廉價的全連接層附加到池化層上,充分利用分類和回歸的特征表示。因其輕量級頭部結構,該檢測器能夠實現速度和準確率之間的最優權衡,不管使用的是大主干網絡還是小主干網絡。

基于ResNet101網絡達到了新的state-of-the-art的結果40.6,超過了Mask R-CNN和RetinaNet。同時如果是用一個更小的網絡,比如類似Xception的小模型,達到了100+FPS,30.7mmap,效率上超過了SSD和YOLO。

圖1.16 Light-Head R-CNN

2. one stage的方法

以R-CNN算法為代表的two stage的方法由于RPN結構的存在,雖然檢測精度越來越高,但是其速度卻遇到瓶頸,比較難于滿足部分場景實時性的需求。因此出現一種基于回歸方法的one stage的目標檢測算法,不同于two stage的方法的分步訓練共享檢測結果,one stage的方法能實現完整單次訓練共享特征,且在保證一定準確率的前提下,速度得到極大提升。

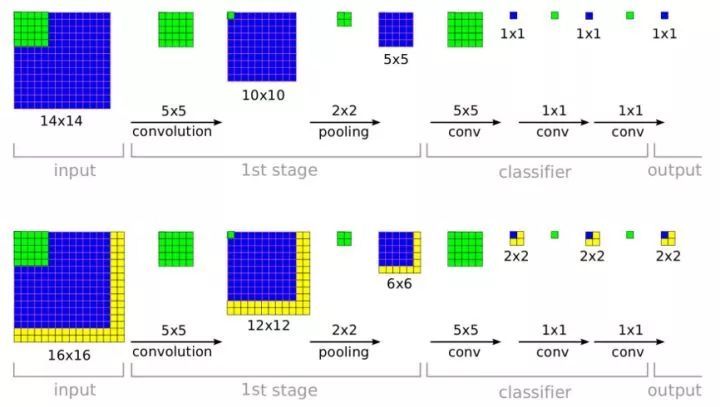

2.1 OverFeat

2013年Yann Lecun在紐約大學的團隊提出了著名的OverFeat算法,其利用滑動窗口和規則塊生成候選框,再利用多尺度滑動窗口增加檢測結果,解決圖像目標形狀復雜、尺寸不一問題,最后利用卷積神經網絡和回歸模型分類、定位目標。該算法首次將分類、定位以及檢測三個計算機視覺任務放在一起解決,獲得同年ILSVRC 2013任務3(分類+定位)的冠軍,但其很快就被同期的R-CNN算法取代。

圖2.1 用于檢測的高效卷積

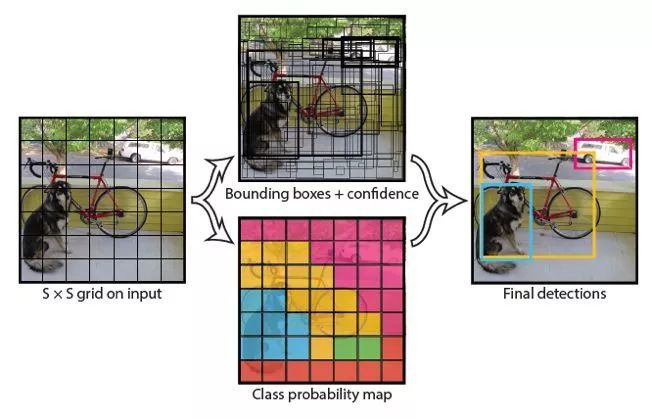

2.2 YOLO

2015年華盛頓大學的Joseph Redmon等提出的YOLO算法繼承了OverFeat算法這種基于回歸的one stage方法,速度能達到每秒45幀,由于其速度優勢迅速成為端到端方法的領先者。YOLO算法是基于圖像的全局信息進行預測的,整體結構簡單,通過將輸入圖像重整到448×448像素固定尺寸大小,并劃分圖像為7×7網格區域,通過卷積神經網絡提取特征訓練,直接預測每個網格內的邊框坐標和每個類別置信度,訓練時采用P-Relu激活函數。但是存在定位不準以及召回率不如基于區域提名方法的問題,且對距離很近的物體和很小的物體檢測效果不好,泛化能力相對較弱。

圖2.2 YOLO

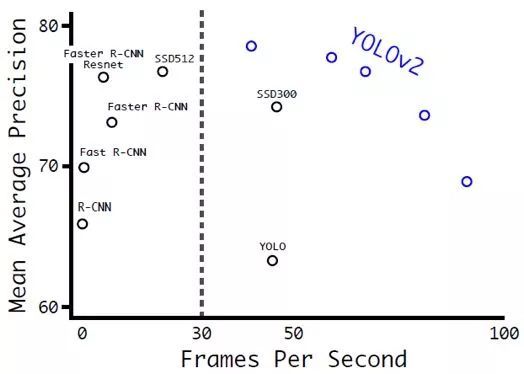

2.3 YOLOv2 & YOLO9000

經過Joseph Redmon等的改進,YOLOv2和YOLO9000算法在2017年CVPR上被提出,并獲得較佳論文提名,重點解決召回率和定位精度方面的誤差。采用Darknet-19作為特征提取網絡,增加了批量歸一化(Batch Normalization)的預處理,并使用224×224和448×448兩階段訓練ImageNet預訓練模型后fine-tuning。

相比于原來的YOLO是利用全連接層直接預測bounding box的坐標,YOLOv2借鑒了Faster R-CNN的思想,引入anchor機制,利用K-Means聚類的方式在訓練集中聚類計算出更好的anchor模板,在卷積層使用anchorboxes操作,增加候選框的預測,同時采用較強約束的定位方法,大大提高算法召回率。結合圖像細粒度特征,將淺層特征與深層特征相連,有助于對小尺寸目標的檢測。

圖2.3 YOLOv2在VOC2007上的速度和精度

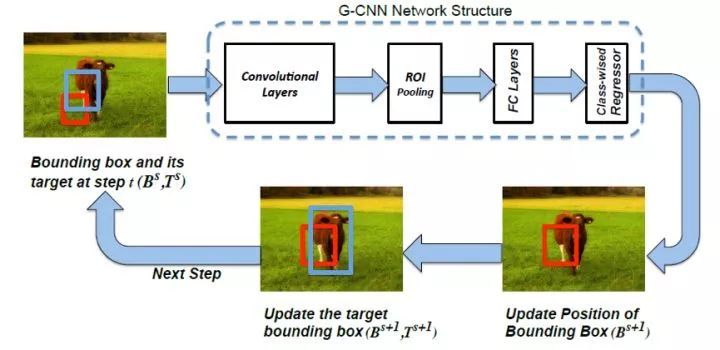

2.4 G-CNN

由于巨大的proposal數量使得后續檢測效率降低,2016年馬里蘭大學的M Najibi等提出一種起始于網格迭代的G-CNN算法。通過初始化對圖像劃分回歸后得到更加接近物體的候選框,再利用回歸框作為原始窗口進行回歸調整,解決了以往的基于區域提名方法通過海量潛在候選框直接進行目標搜索,抑制負樣本的缺陷。

在訓練階段,首先在圖像中獲取疊加的多尺度的規則網格(實際網格相互疊加),然后通過ground truth與每一個網格的IOU進行每一個網格ground truth的分配,并完成訓練過程,使得網格在回歸過程中漸漸接近ground truth。在檢測階段,對于每一個樣本框針對每一類獲得置信分數,用最可能類別的回歸器來更新樣本框的位置。

圖2.4 G-CNN

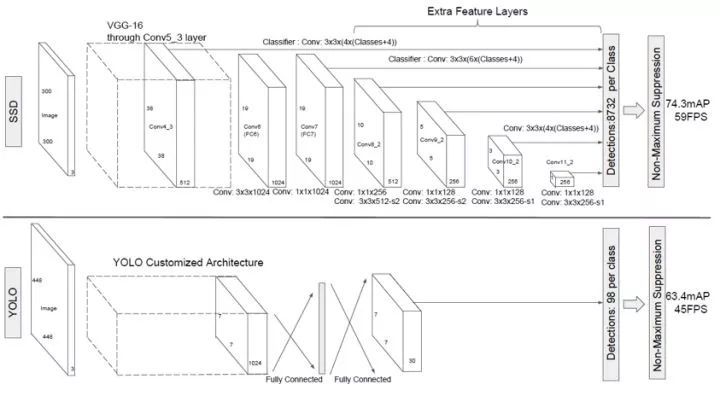

2.5 SSD

針對YOLO類算法的定位精度問題,2016年12月北卡大學教堂山分校的Wei Liu等提出SSD算法,將YOLO的回歸思想和Faster R-CNN的anchor box機制結合。通過在不同卷積層的特征圖上預測物體區域,輸出離散化的多尺度、多比例的default boxes坐標,同時利用小卷積核預測一系列候選框的邊框坐標補償和每個類別的置信度。

在整幅圖像上各個位置用多尺度區域的局部特征圖邊框回歸,保持YOLO算法快速特性的同時,也保證了邊框定位效果和Faster R-CNN類似。但因其利用多層次特征分類,導致其對于小目標檢測困難,最后一個卷積層的感受野范圍很大,使得小目標特征不明顯。

圖2.5 SSD和YOLO網絡結構對比

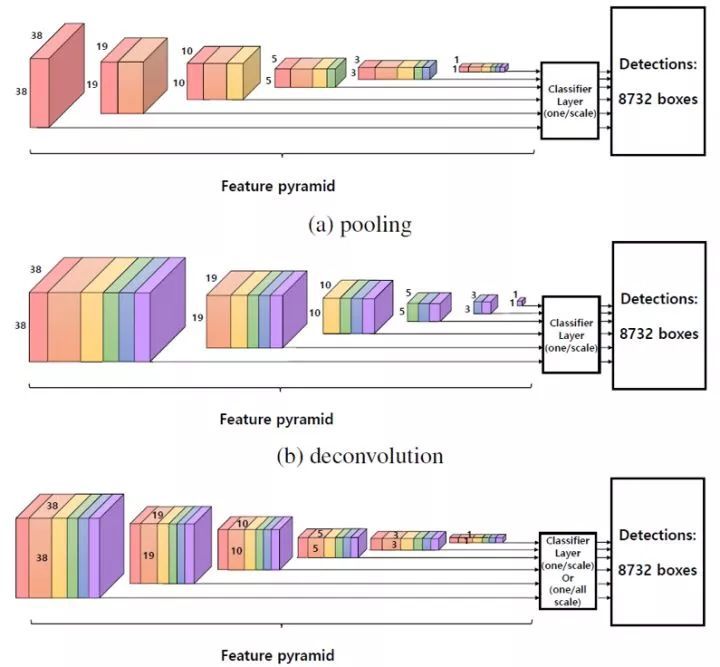

2.6 R-SSD

2017年首爾大學提出了R-SSD算法,解決了SSD算法中不同層feature map都是獨立作為分類網絡的輸入,容易出現相同物體被不同大小的框同時檢測出來的情況,還有對小尺寸物體的檢測效果比較差的情況。R-SSD算法一方面利用分類網絡增加不同層之間的feature map聯系,減少重復框的出現;另一方面增加feature pyramid中feature map的個數,使其可以檢測更多的小尺寸物體。

特征融合方式采用同時利用pooling和deconvolution進行特征融合,這種特征融合方式使得融合后每一層的feature map個數都相同,因此可以共用部分參數,具體來講就是default boxes的參數共享。

圖2.6 三種特征融合方式

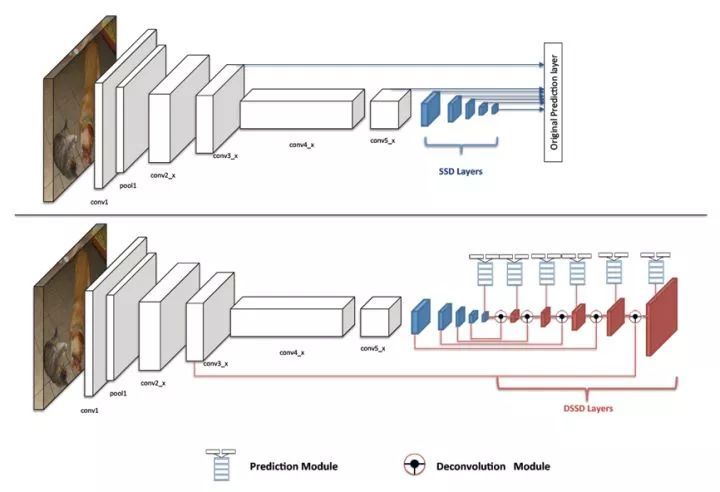

2.7 DSSD

為了解決SSD算法檢測小目標困難的問題,2017年北卡大學教堂山分校的Cheng-Yang Fu等提出DSSD算法,將SSD算法基礎網絡從VGG-16更改為ResNet-101,增強網絡特征提取能力,其次參考FPN算法思路利用去卷積結構將圖像深層特征從高維空間傳遞出來,與淺層信息融合,聯系不同層級之間的圖像語義關系,設計預測模塊結構,通過不同層級特征之間融合特征輸出預測物體類別信息。

DSSD算法中有兩個特殊的結構:Prediction模塊;Deconvolution模塊。前者利用提升每個子任務的表現來提高準確性,并且防止梯度直接流入ResNet主網絡。后者則增加了三個Batch Normalization層和三個3×3卷積層,其中卷積層起到了緩沖的作用,防止梯度對主網絡影響太劇烈,保證網絡的穩定性。

圖2.7 SSD和DSSD網絡結構對比

2.8 DSOD

2017年復旦大學提出DSOD算法,其并不是在mAP上和其他檢測算法做比較,看誰的算法更有效或者速度更快,而是從另一個角度切入說明fine-tune和直接訓練檢測模型的差異其實是可以減小的,也就是說訓練一個檢測模型可以不需要大量的數據和預訓練好的模型。

這是由于預訓練模型的限制導致:遷移模型結構靈活性差,難以改變網絡結構;分類任務預訓練模型和檢測任務訓練會有學習偏差;雖然微調會減少不同目標類別分布的差異性,但深度圖等特殊圖像遷移效果差異較大。

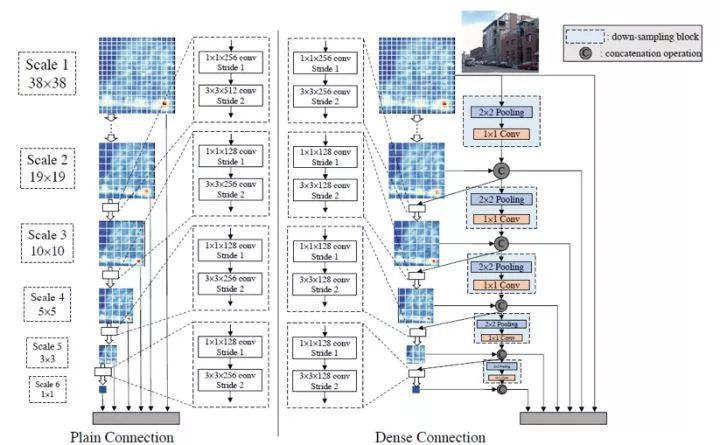

SSD算法是在六個尺度的特征圖上進行檢測,將這六個檢測結果綜合起來,DSOD算法則則根據DenseNet的設計原理,將相鄰的檢測結果一半一半的結合起來。DSOD算法是基于SSD算法基礎上做的修改,采用的特征提取網絡是DenseNet。

采用Dense Block結構,能避免梯度消失的情況。同時利用Dense Prediction結構,也能大大減少模型的參數量,特征包含更多信息。設計stem結構能減少輸入圖片信息的丟失,stem結構由3×3卷積和2×2的max pool層組成,其還可以提高算法檢測的mAP。

圖2.8 DSOD預測層

2.9 RON

2017年清華大學提出了RON算法,結合two stage名的方法和one stage方法的優勢,更加關注多尺度對象定位和負空間樣本挖掘問題。

多尺度對象定位——各種尺度的物體可能出現在圖像的任何位置,因此應考慮成千上萬個具有不同位置/尺度/方位的區域。多尺度表征將顯著改善各種尺度的物體檢測,但是這些方法總是在網絡的一層檢測到各種尺度的對象;

負空間挖掘——對象和非對象樣本之間的比例嚴重不平衡。因此,對象檢測器應該具有有效的負挖掘策略。

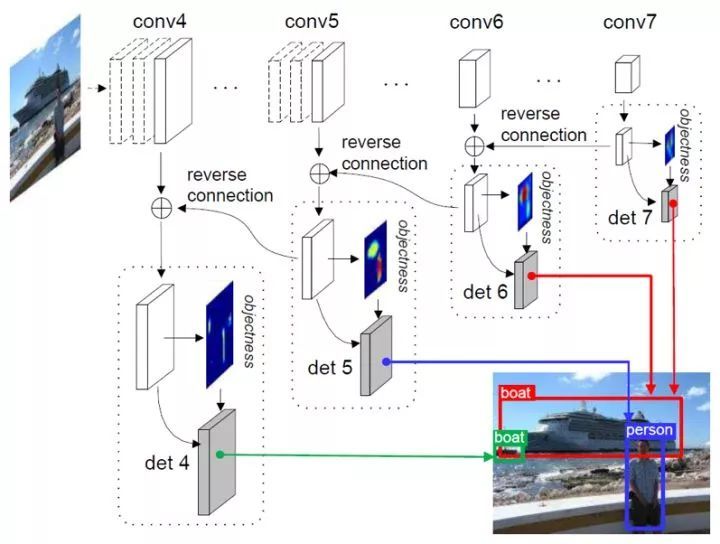

RON算法通過設計方向連接結構,利用多尺度表征顯著改善各種多尺度物體檢測,同時為了減少對象搜索空間,在卷積特征圖創建objectness prior引導目標對象搜索,訓練時將檢測器進行聯合優化。并通過多任務損失函數聯合優化了反向連接、objectness prior和對象檢測,因此可直接預測各種特征圖所有位置的最終檢測結果。

圖2.9 RON

3. 總結

隨著深度學習技術在圖像各領域的研究深入,出現越來越多的新理論、新方法。two stage的方法和基于回歸思想的one stage方法兩者相互借鑒,不斷融合,取得了很好的效果,也為我們展示了一些未來發展趨勢:

參考上下文特征的多特征融合;

多尺度的對象定位;

結合循環神經網絡(RNN)的圖像語義分析。

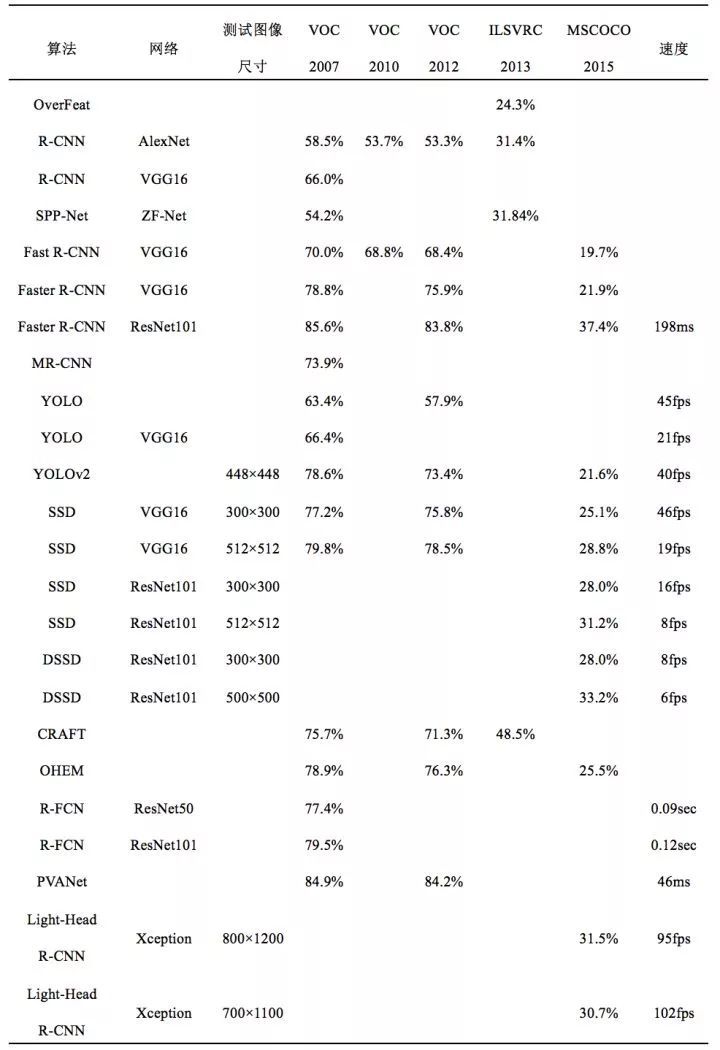

部分目標檢測算法精度和速度對比

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4726.html

摘要:阿里安全一直以來致力于用技術解決社會問題。為了增加對抗驗證碼的識別難度,又不影響正常用戶的體驗,算法專家們又在圖像區域和生成方式上進行了組合擴展,最終生成的對抗樣驗證碼有效抵御了黑灰產的批量破解,成為阿里業務安全的一道銅墻鐵壁。 showImg(https://segmentfault.com/img/remote/1460000018478161); 我們知道,AI 技術將在很長一段...

閱讀 3683·2021-09-22 15:34

閱讀 1194·2019-08-29 17:25

閱讀 3405·2019-08-29 11:18

閱讀 1379·2019-08-26 17:15

閱讀 1745·2019-08-23 17:19

閱讀 1235·2019-08-23 16:15

閱讀 723·2019-08-23 16:02

閱讀 1340·2019-08-23 15:19