資訊專欄INFORMATION COLUMN

摘要:最近在總結完成語義分割任務的輕量級神經網絡時,看到了中對于層的思考,于是我也回過頭重新審視之所以的本質原因。本質上就干了一件事降低數據中信息的冗余度。從本文的觀點來看,因為從數據中拿掉了非冗余信息的部分,會導致余下部分的信息冗余度變高。

最近在總結完成語義分割任務的輕量級神經網絡時,看到了 MobileNet V2 中對于 ReLU 層的思考,于是我也回過頭重新審視 ResNet 之所以 work 的本質原因。以下是一些個人的見解,如有錯誤,還望及時指正。

在談及 ResNet 之前,我們先聊聊故事的背景。

我們知道,在神經網絡中,非線性激活層可以為模型引入了非線性,讓模型具有更強的擬合能力。如果只是單純的線性操作層的疊加,則完全可以等價為一個線性層,這就浪費了深度神經網絡的一身好本領。

所謂針無兩頭尖,那么非線性激活層會帶來一些什么問題呢?我們以 ReLU 為例來進行說明,其他非線性激活層亦同理。

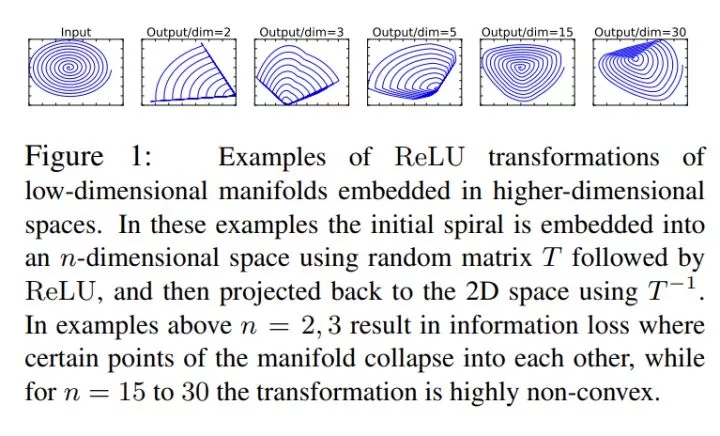

首先,最直觀的,從實驗中我們可以注意到一個事實:ReLU 會造成的低維數據的坍塌(collapse)。顧名思義,即是說,低維度的 feature 在通過 ReLU 的時候,這個 feature 會像塌方了一樣,有一部分被毀掉了,或者說失去了。能恢復嗎?能,但是基本無法百分百還原了。

具體表現出來就是:若是我們對一個 feature,先通過一個給定的變換規則 T,將它映射到它的 embedding space 中,再在該 embedding space 中,利用一個 ReLU 去處理該 feature,最后再把這個 feature 以同樣的變換規則(逆方向)給映射回原始空間,我們會發現,這時,這個 feature 已經變得連親媽都不認得了。如圖↓

圖片來自《MobileNetV2: Inverted Residuals and Linear Bottlenecks》

ReLU 這個東西,其實就是一個濾波器,只不過這個濾波器的作用域不是信號處理中的頻域,而是特征域。那么濾波器又有什么作用呢?維度壓縮,俗話說就是降維啦:如果我們有 m 個 feature 被送入 ReLU 層,過濾剩下 n 個(n 那么,為什么低維數據流經非線性激活層會發生坍塌(信息丟失),而高維數據就不會呢? 打個簡單但不嚴謹的比方:大家都有過年搶高鐵票的經驗吧?幾個人(維度低)幫你搶一張票,肯定沒有一群人(維度高)幫你搶一張票,成功的概率高啊。幾個人里面,大概率全軍覆沒,沒一個能幫上你忙的。而一群人里面,大概率總有那么一個手速驚人的單身青年,幫你搶到你心心念念的回家票。 在數據上也是一個道理,維度低的 feature,分布到 ReLU 的激活帶上的概率小,因此經過后信息丟失嚴重,甚至可能完全丟失。而維度高的 feature,分布到 ReLU 的激活帶上的概率大,雖然可能也會有信息的部分丟失,但是無傷大雅,大部分的信息仍然得以保留。所謂留得青山在,不愁沒柴燒嘛。更何況被 ReLU 截殺的信息,可能只是一些無用游民(冗余信息)。 那么數據的坍塌,是個很嚴重的事嗎? 那事兒可大了。如果把神經網絡比作一個人的話,你這就是給它的某個部位的血管里,丟了個血栓。 當信息無法流過 ReLU 時,該神經元的輸出就會變為 0。而在反向傳播的過程中,ReLU 對 0 值的梯度為 0,即發生了梯度消失,這將導致神經元的權重無法再通過梯度下降法進行更新,這種現象被稱為特征退化。所以這個神經元相當于死掉了,喪失了學習能力。我們說,一旦神經元的輸出陷入 0 值,就無法恢復了。 ? 那么,我們應該怎么去規避數據的坍塌呢?非線性激活層到底是個什么樣的東西? 其實,對于一個數據,利用非線性激活層對其進行激活,其實是從該數據的信息中提取出其潛在的稀疏性,但是這種提取的結果是否正確,就要分情況討論了。 對于一個 M 維的數據,我們可以將其看成是在 M 維空間中的一個 M 維流形(manifold)。而其中的有用信息,就是在該 M 維空間中的一個子空間(子空間的維度記為 N 維,N<=M)中的一個 N 維流形。非線性激活層相當于壓縮了這個 M 維空間的維度(還記得前面提過的維度壓縮嗎?)。若是該 M 維空間中的 M 維流形本來就不含有冗余信息(M=N),那么再對其進行維度壓縮,必然導致信息的丟失。 而維度低的數據其實就是這么一種情況:其信息的冗余度高的可能性本來就低,如果強行對其進行非線性激活(維度壓縮),則很有可能丟失掉有用信息,甚至丟失掉全部信息(輸出為全 0)。 與非線性激活層不同的是,線性激活層并不壓縮特征空間的維度。于是,我們得到了一條使用激活層的原則: 對含有冗余信息的數據使用非線性激活(如 ReLU),對不含冗余信息的數據使用線性激活(如一些線性變換)。 兩種類型的激活交替靈活使用,以同時兼顧非線性和信息的完整性。 由于冗余信息和非冗余信息所攜帶的有用信息是一樣多的,因此在設計網絡時,對內存消耗大的結構較好是用在非冗余信息上。 根據以上的原則設計出來的結構,聰明的你想到了什么?ResNet。不得不贊嘆 Kaiming He 的天才,ResNet 這東西,描述起來固然簡單,但是對它的理解每深一層,就會愈發發現它的精妙及優雅,從數學上解釋起來非常簡潔,非常令人信服,而且直切傳統痛點。 ResNet 本質上就干了一件事:降低數據中信息的冗余度。 具體說來,就是對非冗余信息采用了線性激活(通過 skip connection 獲得無冗余的 identity 部分),然后對冗余信息采用了非線性激活(通過 ReLU 對 identity 之外的其余部分進行信息提取 / 過濾,提取出的有用信息即是殘差)。 其中,提取 identity 這一步,就是 ResNet 思想的核心。 從本文的觀點來看,因為從數據中拿掉了非冗余信息的 identity 部分,會導致余下部分的信息冗余度變高。這就像從接近飽和的溶液中移走了一部分溶質,會使得剩下的溶液的飽和度降低,一個道理。 在這里也引用一下其他的一些觀點,方便大家可以從一個更全面的角度去看這個問題: 從特征復用的觀點來看,提取 identity 部分,可以讓網絡不用再去學習一個 identity mapping(雖然是一樣的東西,但是畢竟又要從頭學起,講真,換你來試試,這其實真的不容易學到),而是直接學習 residual。這就輕松愉快多了:站在巨人的肩膀上,做一點微小的工作什么的... 既然說了 ResNet 解決的痛點,也順便多說幾句它帶來的好處: 由于 identity 之外的其余部分的信息冗余度較高,因此在對其使用 ReLU 進行非線性激活時,丟失的有用信息也會較少,ReLU 層輸出為 0 的可能性也會較低。這就降低了在反向傳播時 ReLU 的梯度消失的概率,從而便于網絡的加深,以大大地發揮深度網絡的潛能。 特征復用能加快模型的學習速度,因為參數的優化收斂得快(從 identity 的基礎上直接學習殘差,總比從頭學習全部來得快)。 最后是兩個小 tips: 如果一個信息可以完整地流過一個非線性激活層,則這個非線性激活層對于這個信息而言,相當于僅僅作了一個線性激活。 解決由非線性激活導致的反向傳播梯度消失的竅門,就是要提高進行非線性激活的信息的冗余度。 如果您覺得本文對您有所幫助,請高抬貴手點個贊~ 接下來會填之前語義軟分割的坑和圖神經網絡的坑,還有一些雜七雜八的:如姿態估計網絡啦、deepSLAM 啦、視覺跟蹤網絡啦、VQA 啦... 最近光忙著看 paper 和寫筆記了,有空再整理后發上來。 以上。

商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4865.html

摘要:大神何愷明受到了質疑。今天,上一位用戶對何愷明的提出質疑,他認為何愷明年的原始殘差網絡的結果沒有被復現,甚至何愷明本人也沒有。我認為,的可復現性經受住了時間的考驗。 大神何愷明受到了質疑。今天,Reddit 上一位用戶對何愷明的ResNet提出質疑,他認為:何愷明 2015 年的原始殘差網絡的結果沒有被復現,甚至何愷明本人也沒有。網友稱,他沒有發現任何一篇論文復現了原始 ResNet 網絡的...

摘要:前面我們通過幾個數值展示了幾個比較經典的網絡的一些特性,下面我們就花一點時間來仔細觀察網絡的變化,首先是在網絡結構上的一些思考,其次是對于單層網絡內部的擴展,最后我們再來看看對于網絡計算的改變。和這類結構主要看中的是模型在局部的擬合能力。 前面我們通過幾個數值展示了幾個比較經典的網絡的一些特性,下面我們就花一點時間來仔細觀察CNN網絡的變化,首先是VGG在網絡結構上的一些思考,其次是Ince...

摘要:在當前的背景下,卷積神經網絡提出之后,深度成為人們要追求的目標。同時,殘差網絡也很好的解決了梯度下降中的梯度彌散的問題。經典網絡目前最主經典的殘差網絡莫過于。 注:整理自各個博客,并且添加個人理解 隨著卷積神經網絡的發展和普及,網絡深度和架構研究早已經成為人們常見的問題,所以,現在卷積神經網絡的趨勢發展趨勢就是:足夠深、足夠廣。足夠深就是網絡層數足夠深,足夠廣就意味著不能從傳統尺度...

摘要:然而,幸運的是,目前更為成功的目標檢測方法是圖像分類模型的擴展。幾個月前,發布了一個用于的新的目標檢測。 隨著自動駕駛汽車、智能視頻監控、人臉檢測和各種人員計數應用的興起,快速和準確的目標檢測系統也應運而生。這些系統不僅能夠對圖像中的每個目標進行識別和分類,而且通過在其周圍畫出適當的邊界來對其進行局部化(localizing)。這使得目標檢測相較于傳統的計算機視覺前身——圖像分類來說更加困難...

摘要:分組卷積的思想影響比較深遠,當前一些輕量級的網絡,都用到了分組卷積的操作,以節省計算量。得到新的通道之后,這時再對這批新的通道進行標準的跨通道卷積操作。 CNN從2012年的AlexNet發展至今,科學家們發明出各種各樣的CNN模型,一個比一個深,一個比一個準確,一個比一個輕量。作者對近幾年一些具有變革性的工作進行簡單盤點,從這些充滿革新性的工作中探討日后的CNN變革方向。本文只介紹其中具有...

閱讀 3209·2021-11-12 10:36

閱讀 1258·2019-08-30 15:56

閱讀 2444·2019-08-30 11:26

閱讀 551·2019-08-29 13:00

閱讀 3609·2019-08-28 18:08

閱讀 2749·2019-08-26 17:18

閱讀 1893·2019-08-26 13:26

閱讀 2432·2019-08-26 11:39