資訊專欄INFORMATION COLUMN

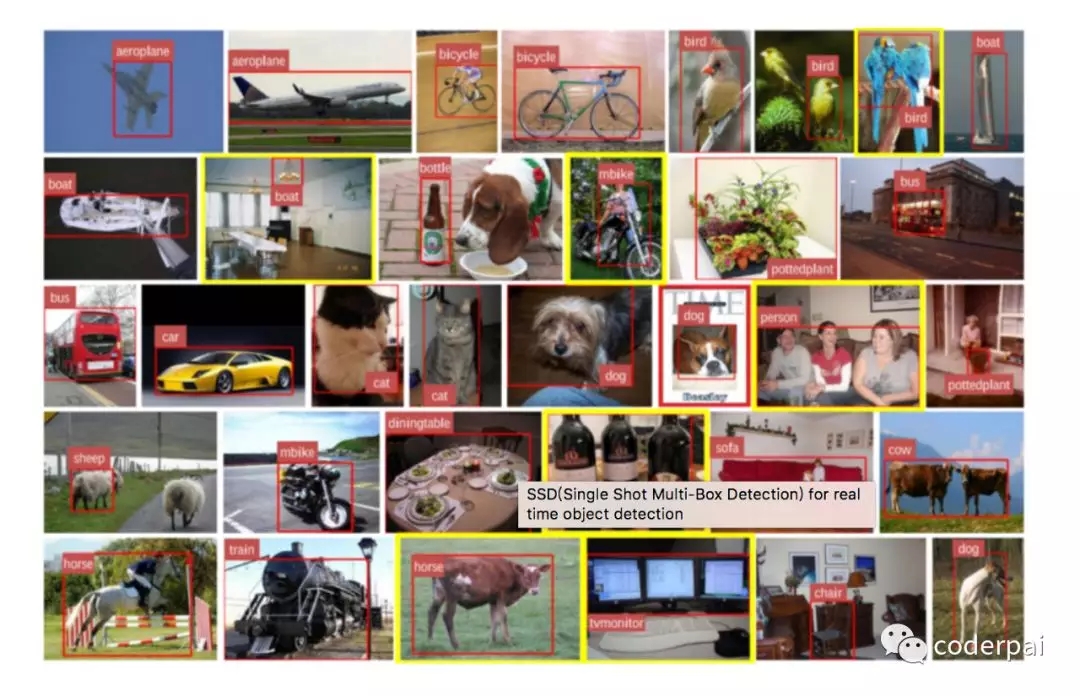

摘要:但是他們對于實(shí)時(shí)監(jiān)測來說,還是有點(diǎn)慢。上圖是我們用于物體檢測的訓(xùn)練數(shù)據(jù)集的示例。分類器在每個(gè)步驟中應(yīng)用于檢測對象。

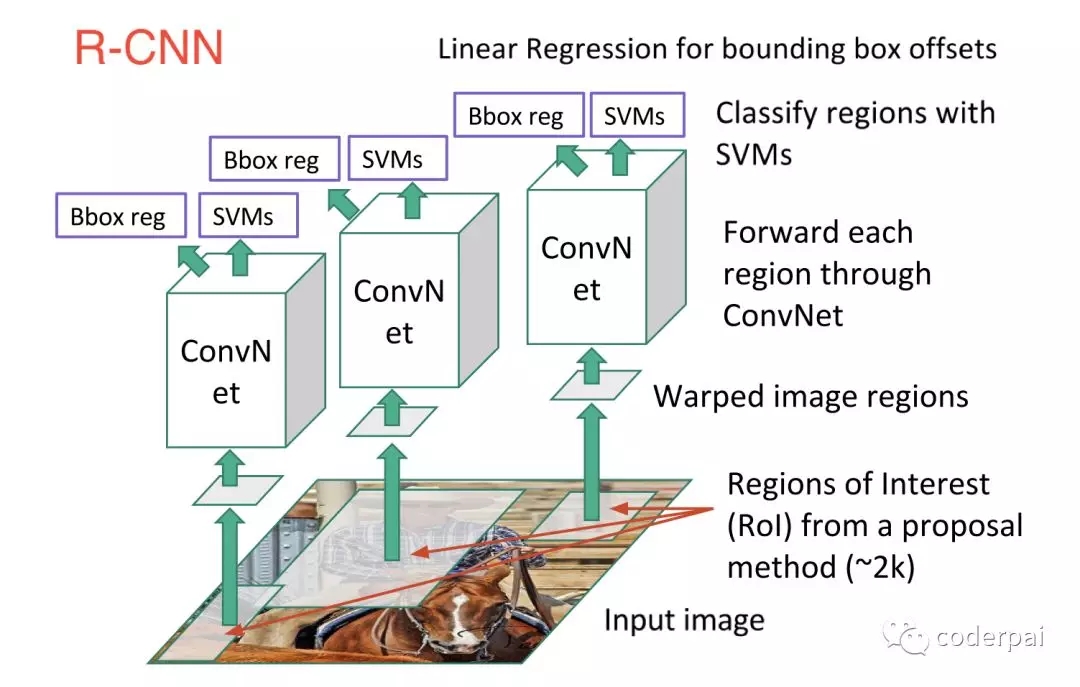

卷積神經(jīng)網(wǎng)絡(luò)(CNN)在物體識別中由于其他的神經(jīng)網(wǎng)絡(luò)架構(gòu),所以研究人員很快對 CNN 進(jìn)行了改進(jìn)以使得它們能更好的對物體進(jìn)行定位和檢測,這種神經(jīng)網(wǎng)絡(luò)架構(gòu)就被稱為 R-CNN(Region-CNN)。R-CNN 的輸出是具有矩形框的圖像,以下是 R-CNN 如何工作的步驟:

使用稱為可能性搜索的算法掃描整個(gè)輸入圖像,用來查詢可能的對象,并生成大約 2000 個(gè)區(qū)域提議;

在每個(gè)區(qū)域提案上運(yùn)行 CNN;

獲取每個(gè) CNN 的輸出并將其輸入:

SVM 對區(qū)域進(jìn)行分類;

如果存在這樣的對象,則利用線性回歸其收緊對象的邊界框;

雖然 R-CNN 比傳統(tǒng)的 CNN 在對象對位,檢測和分類方面取得了很大進(jìn)步,但是在實(shí)時(shí)性上面還是存在一點(diǎn)問題,主要是:

訓(xùn)練數(shù)據(jù)很難處理,而且需要很長時(shí)間;

訓(xùn)練分為兩步進(jìn)行(區(qū)域劃分和分類);

在測試的時(shí)候,網(wǎng)絡(luò)的計(jì)算非常慢;

為了改進(jìn) R-CNN,研究人員想出了很多的算法,比如 Fast-RCNN,F(xiàn)aster-RCNN。后來的幾個(gè)算法在對象檢測上面能得到更準(zhǔn)確的結(jié)果。但是他們對于實(shí)時(shí)監(jiān)測來說,還是有點(diǎn)慢。SSD 就能同時(shí)解決這兩個(gè)問題,它在準(zhǔn)確性和計(jì)算速度方面具有良好的平衡。

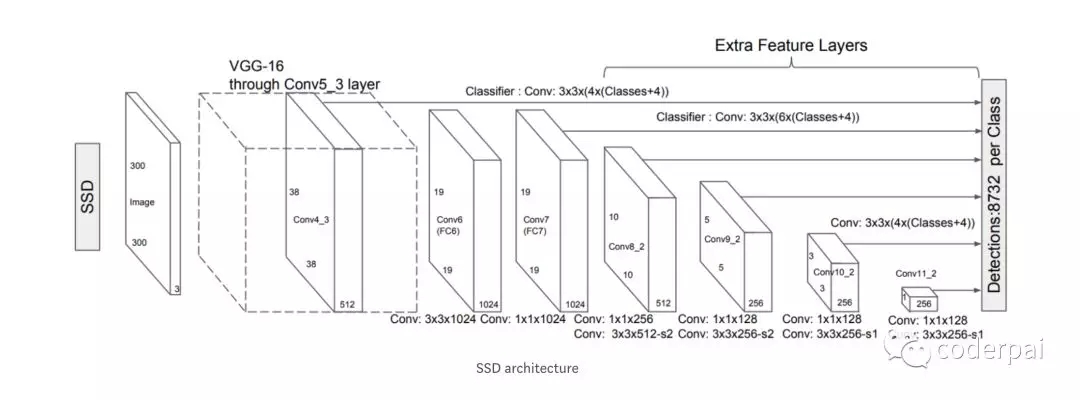

SSD(Single Shot MultiBox Detector)

SIngle Shot:對象定位和分類在同一個(gè)前向網(wǎng)絡(luò)中完成;

MultiBox:邊界框回歸的技術(shù)

Detector:對檢測到的對象進(jìn)行分類;

具體架構(gòu)如下:

SSD 的架構(gòu)基于 VGG-16 架構(gòu)開發(fā)。但是對 VGG-16 進(jìn)行了一些調(diào)整,我們使用 Conv6 層以上的輔助卷積層而不是完全連接層。使用 VGG-16 作為基礎(chǔ)網(wǎng)絡(luò)層的原因是其高質(zhì)量的圖像分類和遷移學(xué)習(xí)的能力,可以用來改善結(jié)果。使用輔助卷積層,我們可以提取多個(gè)尺度的特征,并逐步減小每個(gè)后續(xù)層的尺寸。在下面介紹的工作原理圖中,你可以看到 VGG-16 架構(gòu)處理的圖像。

工作機(jī)制

為了訓(xùn)練我們的算法,我們需要一個(gè)包含帶有對象的圖像訓(xùn)練集,這些對象必須在他們上面有邊界框。通過這種方式學(xué)習(xí),算法可以學(xué)會如何將舉行放置子啊何處。我們最小化邊界框和實(shí)際的框的誤差,以優(yōu)化我們的模型可以正確的檢測到對象。與 CNN 不同的是,我們不僅預(yù)測圖像中是否存在該物體,而且還需要預(yù)測物體在圖像中的位置。在訓(xùn)練期間,算法學(xué)習(xí)調(diào)整對象中矩陣框的高度和寬度。

上圖是我們用于物體檢測的訓(xùn)練數(shù)據(jù)集的示例。這些數(shù)據(jù)集必須包含在圖像中標(biāo)記其類的對象。更多默認(rèn)框?qū)е赂鼫?zhǔn)確的檢測。

如果你是一個(gè)初學(xué)者,可以先使用 Pascal VOC 和 COCO 來進(jìn)行學(xué)習(xí)。

處理規(guī)模問題

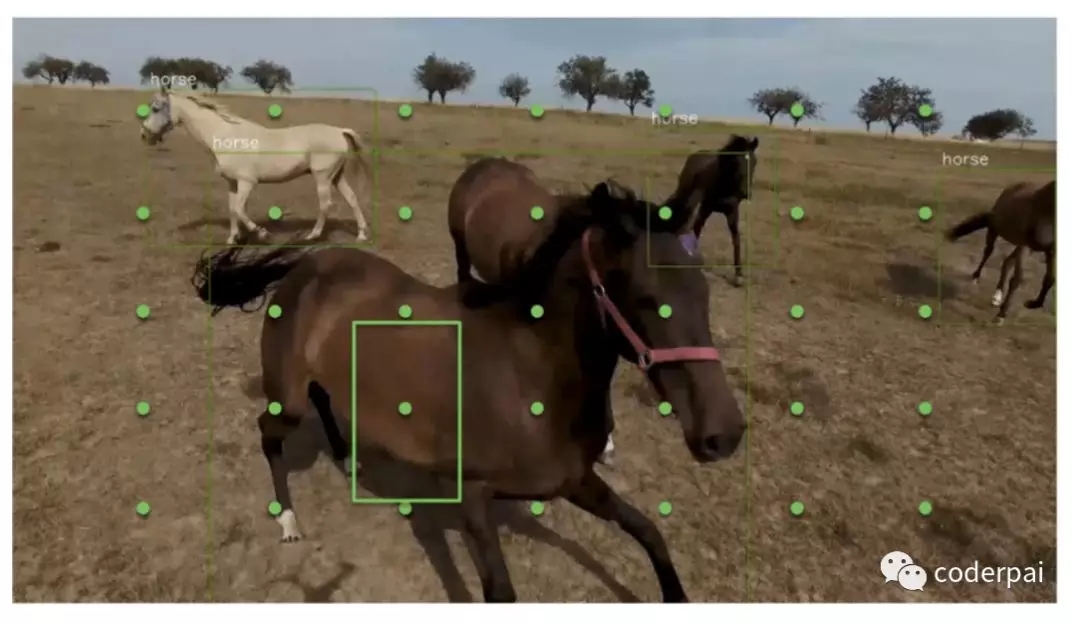

上面的圖,我們的馬匹有很少的圖像。我們將輸入圖像劃分為網(wǎng)格集。然后我們圍繞這些網(wǎng)格制作幾個(gè)不同寬高比的巨星。然后我們子啊這些礦中應(yīng)用卷積來查找這些網(wǎng)絡(luò)中是否存在對象。這里的一匹黑馬在圖像中更靠近相機(jī)。因此,我們繪制的矩形無法識別是否是馬,因?yàn)榫匦螞]有任何識別馬匹的特征。

如果我們看到 SSD 的上述架構(gòu),我們可以在 Conv6 層之后的每個(gè)步驟中看到圖像的大小顯著減小。然后,我們討論的關(guān)于制作網(wǎng)格和在這些網(wǎng)格上查找對象的每個(gè)操作都適用于從網(wǎng)絡(luò)的后面到前面的卷積的每個(gè)步驟。分類器在每個(gè)步驟中應(yīng)用于檢測對象。因此,由于物體在每個(gè)步驟中不斷變小,索引很容易被識別出來。

SSD 算法還知道如何從一個(gè)卷積操作返回到另一個(gè)卷積操作。它不僅學(xué)會前進(jìn)而且學(xué)會如何后腿。例如,如果他在 Conv4 層中看到馬,那么它可以返回到 Conv6 并且算法將在馬周圍進(jìn)行繪制矩形。

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請聯(lián)系小編及時(shí)處理,謝謝!

商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://specialneedsforspecialkids.com/yun/4806.html

摘要:工作原理以前的檢測系統(tǒng)通過重復(fù)利用分類器和定位器來實(shí)現(xiàn)目標(biāo)識別。修改檢測閾值缺省情況下,只顯示信心大于的對象。用法如下這個(gè),呵呵,不完美把白馬識別成綿羊了,把黑狗識別成奶牛了,但確實(shí)很快。 原標(biāo)題:YOLO: Real-Time Object Detection英文原文:https://pjreddie.com/darknet/... 強(qiáng)烈推薦(TED視頻):https://www....

摘要:工作原理以前的檢測系統(tǒng)通過重復(fù)利用分類器和定位器來實(shí)現(xiàn)目標(biāo)識別。修改檢測閾值缺省情況下,只顯示信心大于的對象。用法如下這個(gè),呵呵,不完美把白馬識別成綿羊了,把黑狗識別成奶牛了,但確實(shí)很快。 原標(biāo)題:YOLO: Real-Time Object Detection英文原文:https://pjreddie.com/darknet/... 強(qiáng)烈推薦(TED視頻):https://www....

摘要:目前目標(biāo)檢測領(lǐng)域的深度學(xué)習(xí)方法主要分為兩類的目標(biāo)檢測算法的目標(biāo)檢測算法。原來多數(shù)的目標(biāo)檢測算法都是只采用深層特征做預(yù)測,低層的特征語義信息比較少,但是目標(biāo)位置準(zhǔn)確高層的特征語義信息比較豐富,但是目標(biāo)位置比較粗略。 目前目標(biāo)檢測領(lǐng)域的深度學(xué)習(xí)方法主要分為兩類:two stage的目標(biāo)檢測算法;one stage的目標(biāo)檢測算法。前者是先由算法生成一系列作為樣本的候選框,再通過卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行樣本...

摘要:表示類別為,坐標(biāo)是的預(yù)測熱點(diǎn)圖,表示相應(yīng)位置的,論文提出變體表示檢測目標(biāo)的損失函數(shù)由于下采樣,模型生成的熱點(diǎn)圖相比輸入圖像分辨率低。模型訓(xùn)練損失函數(shù)使同一目標(biāo)的頂點(diǎn)進(jìn)行分組,損失函數(shù)用于分離不同目標(biāo)的頂點(diǎn)。 本文由極市博客原創(chuàng),作者陳泰紅。 1.目標(biāo)檢測算法概述 CornerNet(https://arxiv.org/abs/1808.01244)是密歇根大學(xué)Hei Law等人在發(fā)表E...

摘要:摘要本文介紹使用和完成視頻流目標(biāo)檢測,代碼解釋詳細(xì),附源碼,上手快。將應(yīng)用于視頻流對象檢測首先打開文件并插入以下代碼同樣,首先從導(dǎo)入相關(guān)數(shù)據(jù)包和命令行參數(shù)開始。 摘要:?本文介紹使用opencv和yolo完成視頻流目標(biāo)檢測,代碼解釋詳細(xì),附源碼,上手快。 在上一節(jié)內(nèi)容中,介紹了如何將YOLO應(yīng)用于圖像目標(biāo)檢測中,那么在學(xué)會檢測單張圖像后,我們也可以利用YOLO算法實(shí)現(xiàn)視頻流中的目標(biāo)檢...

閱讀 2311·2021-10-11 10:59

閱讀 2602·2021-10-11 10:58

閱讀 3304·2021-09-08 09:35

閱讀 3783·2021-09-02 15:21

閱讀 1455·2019-08-30 15:53

閱讀 2608·2019-08-29 14:16

閱讀 2068·2019-08-26 14:00

閱讀 2942·2019-08-26 13:52