資訊專(zhuān)欄INFORMATION COLUMN

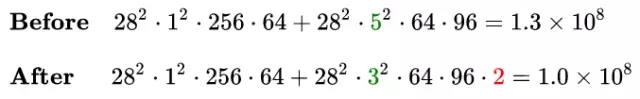

摘要:同樣以里的模塊為例,替換前后的卷積分支復(fù)雜度如下中使用與卷積級(jí)聯(lián)替代卷積中提出了卷積的,在確保感受野不變的前提下進(jìn)一步簡(jiǎn)化。

在梳理CNN經(jīng)典模型的過(guò)程中,我理解到其實(shí)經(jīng)典模型演進(jìn)中的很多創(chuàng)新點(diǎn)都與改善模型計(jì)算復(fù)雜度緊密相關(guān),因此今天就讓我們對(duì)卷積神經(jīng)網(wǎng)絡(luò)的復(fù)雜度分析簡(jiǎn)單總結(jié)一下下。

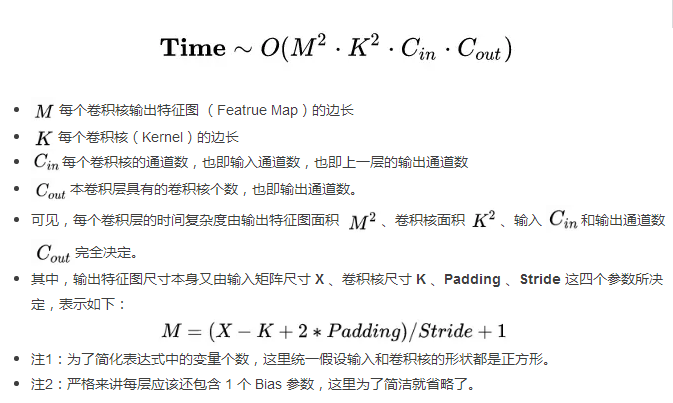

1.時(shí)間復(fù)雜度

1.2 卷積神經(jīng)網(wǎng)絡(luò)整體的時(shí)間復(fù)雜度

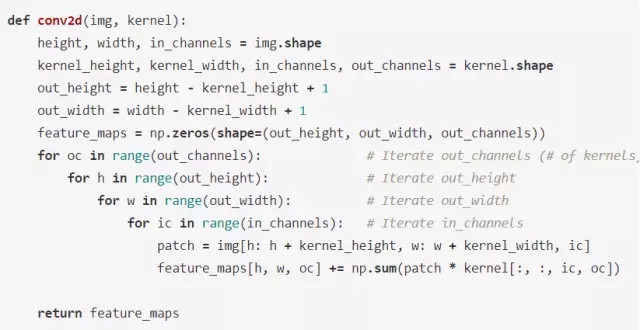

示例:用 Numpy 手動(dòng)簡(jiǎn)單實(shí)現(xiàn)二維卷積

假設(shè) Stride = 1, Padding = 0, img 和 kernel 都是 np.ndarray.

2. 空間復(fù)雜度

空間復(fù)雜度即模型的參數(shù)數(shù)量,體現(xiàn)為模型本身的體積。

可見(jiàn),網(wǎng)絡(luò)的空間復(fù)雜度只與卷積核的尺寸 K 、通道數(shù) C 、網(wǎng)絡(luò)的深度 D 相關(guān)。而與輸入數(shù)據(jù)的大小無(wú)關(guān)。

當(dāng)我們需要裁剪模型時(shí),由于卷積核的尺寸通常已經(jīng)很小,而網(wǎng)絡(luò)的深度又與模型的能力緊密相關(guān),不宜過(guò)多削減,因此模型裁剪通常最先下手的地方就是通道數(shù)。

3. 復(fù)雜度對(duì)模型的影響

時(shí)間復(fù)雜度決定了模型的訓(xùn)練/預(yù)測(cè)時(shí)間。如果復(fù)雜度過(guò)高,則會(huì)導(dǎo)致模型訓(xùn)練和預(yù)測(cè)耗費(fèi)大量時(shí)間,既無(wú)法快速的驗(yàn)證想法和改善模型,也無(wú)法做到快速的預(yù)測(cè)。

空間復(fù)雜度決定了模型的參數(shù)數(shù)量。由于維度詛咒的限制,模型的參數(shù)越多,訓(xùn)練模型所需的數(shù)據(jù)量就越大,而現(xiàn)實(shí)生活中的數(shù)據(jù)集通常不會(huì)太大,這會(huì)導(dǎo)致模型的訓(xùn)練更容易過(guò)擬合。

4. Inception 系列模型是如何優(yōu)化復(fù)雜度的

通過(guò)五個(gè)小例子說(shuō)明模型的演進(jìn)過(guò)程中是如何優(yōu)化復(fù)雜度的。

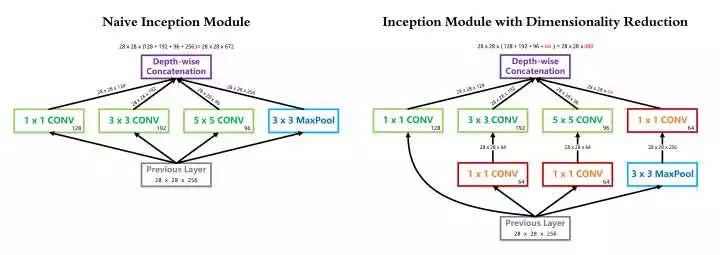

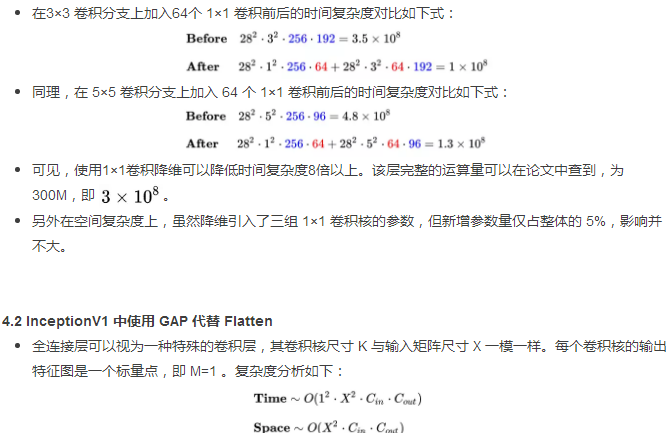

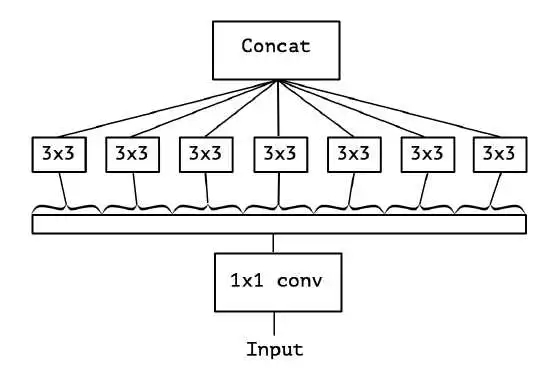

4.1 InceptionV1中的 1×1 卷積降維

InceptionV1 借鑒了 Network in Network 的思想,在一個(gè) Inception Module 中構(gòu)造了四個(gè)并行的不同尺寸的卷積/池化模塊(上圖左),有效的提升了網(wǎng)絡(luò)的寬度。但是這么做也造成了網(wǎng)絡(luò)的時(shí)間和空間復(fù)雜度的激增。對(duì)策就是添加 1 x 1 卷積(上圖右紅色模塊)將輸入通道數(shù)先降到一個(gè)較低的值,再進(jìn)行真正的卷積。

以 InceptionV1 論文中的 (3b) 模塊為例,輸入尺寸為 28×28×256,1×1 卷積核128個(gè),3×3 卷積核192個(gè),5×5 卷積核96個(gè),卷積核一律采用Same Padding確保輸出不改變尺寸。

可見(jiàn),與真正的卷積層不同,全連接層的空間復(fù)雜度與輸入數(shù)據(jù)的尺寸密切相關(guān)。因此如果輸入圖像尺寸越大,模型的體積也就會(huì)越大,這顯然是不可接受的。例如早期的VGG系列模型,其 90% 的參數(shù)都耗費(fèi)在全連接層上。

InceptionV1 中使用的全局較大池化 GAP 改善了這個(gè)問(wèn)題。由于每個(gè)卷積核輸出的特征圖在經(jīng)過(guò)全局較大池化后都會(huì)直接精煉成一個(gè)標(biāo)量點(diǎn),因此全連接層的復(fù)雜度不再與輸入圖像尺寸有關(guān),運(yùn)算量和參數(shù)數(shù)量都得以大規(guī)模削減。復(fù)雜度分析如下:

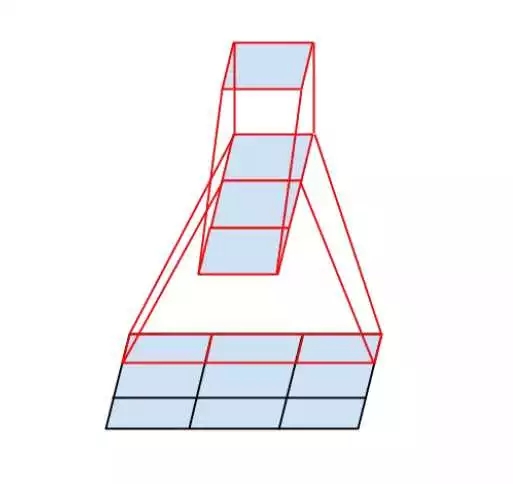

4.3 InceptionV2 中使用兩個(gè) 3×3 卷積級(jí)聯(lián)替代 5×5 卷積分支

根據(jù)上面提到的二維卷積輸入輸出尺寸關(guān)系公式,可知:對(duì)于同一個(gè)輸入尺寸,單個(gè) 5×5 卷積的輸出與兩個(gè) 3×3 卷積級(jí)聯(lián)輸出的尺寸完全一樣,即感受野相同。

同樣根據(jù)上面提到的復(fù)雜度分析公式,可知:這種替換能夠非常有效的降低時(shí)間和空間復(fù)雜度。我們可以把辛辛苦苦省出來(lái)的這些復(fù)雜度用來(lái)提升模型的深度和寬度,使得我們的模型能夠在復(fù)雜度不變的前提下,具有更大的容量,爽爽的。

同樣以 InceptionV1 里的 (3b) 模塊為例,替換前后的 5×5 卷積分支復(fù)雜度如下:

4.4 InceptionV3 中使用 N×1 與 1×N 卷積級(jí)聯(lián)替代 N×N 卷積

InceptionV3 中提出了卷積的 Factorization,在確保感受野不變的前提下進(jìn)一步簡(jiǎn)化。

復(fù)雜度的改善同理可得,不再贅述。

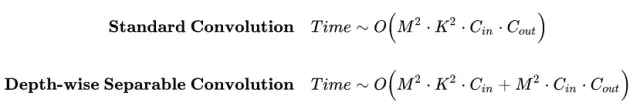

4.5 Xception 中使用 Depth-wise Separable Convolution

我們之前討論的都是標(biāo)準(zhǔn)卷積運(yùn)算,每個(gè)卷積核都對(duì)輸入的所有通道進(jìn)行卷積。

Xception 模型挑戰(zhàn)了這個(gè)思維定勢(shì),它讓每個(gè)卷積核只負(fù)責(zé)輸入的某一個(gè)通道,這就是所謂的 Depth-wise Separable Convolution。

從輸入通道的視角看,標(biāo)準(zhǔn)卷積中每個(gè)輸入通道都會(huì)被所有卷積核蹂躪一遍,而 Xception 中每個(gè)輸入通道只會(huì)被對(duì)應(yīng)的一個(gè)卷積核掃描,降低了模型的冗余度。

標(biāo)準(zhǔn)卷積與可分離卷積的時(shí)間復(fù)雜度對(duì)比:可以看到本質(zhì)上是把連乘轉(zhuǎn)化成為相加。

5.總結(jié)

通過(guò)上面的推導(dǎo)和經(jīng)典模型的案例分析,我們可以清楚的看到其實(shí)很多創(chuàng)新點(diǎn)都是圍繞模型復(fù)雜度的優(yōu)化展開(kāi)的,其基本邏輯就是乘變加。模型的優(yōu)化換來(lái)了更少的運(yùn)算次數(shù)和更少的參數(shù)數(shù)量,一方面促使我們能夠構(gòu)建更輕更快的模型(例如MobileNet),一方面促使我們能夠構(gòu)建更深更寬的網(wǎng)絡(luò)(例如Xception),提升模型的容量,打敗各種大怪獸,歐耶~

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4681.html

早期成果卷積神經(jīng)網(wǎng)絡(luò)是各種深度神經(jīng)網(wǎng)絡(luò)中應(yīng)用最廣泛的一種,在機(jī)器視覺(jué)的很多問(wèn)題上都取得了當(dāng)前較好的效果,另外它在自然語(yǔ)言處理,計(jì)算機(jī)圖形學(xué)等領(lǐng)域也有成功的應(yīng)用。第一個(gè)真正意義上的卷積神經(jīng)網(wǎng)絡(luò)由LeCun在1989年提出[1],后來(lái)進(jìn)行了改進(jìn),它被用于手寫(xiě)字符的識(shí)別,是當(dāng)前各種深度卷積神經(jīng)網(wǎng)絡(luò)的鼻祖。接下來(lái)我們介紹LeCun在早期提出的3種卷積網(wǎng)絡(luò)結(jié)構(gòu)。?文獻(xiàn)[1]的網(wǎng)絡(luò)由卷積層和全連接層構(gòu)成,網(wǎng)絡(luò)...

摘要:其實(shí)我們?cè)谧鼍€性回歸也好,分類(lèi)邏輯斯蒂回歸也好,本質(zhì)上來(lái)講,就是把數(shù)據(jù)進(jìn)行映射,要么映射到一個(gè)多個(gè)離散的標(biāo)簽上,或者是連續(xù)的空間里面,一般簡(jiǎn)單的數(shù)據(jù)而言,我們很好擬合,只要線性變化一下,然后學(xué)習(xí)出較好的就可以了,但是對(duì)于一些比較復(fù)雜的數(shù)據(jù)怎 其實(shí)我們?cè)谧鼍€性回歸也好,分類(lèi)(邏輯斯蒂回歸)也好,本質(zhì)上來(lái)講,就是把數(shù)據(jù)進(jìn)行映射,要么映射到一個(gè)多個(gè)離散的標(biāo)簽上,或者是連續(xù)的空間里面,一般簡(jiǎn)單的數(shù)據(jù)...

摘要:其實(shí)我們?cè)谧鼍€性回歸也好,分類(lèi)邏輯斯蒂回歸也好,本質(zhì)上來(lái)講,就是把數(shù)據(jù)進(jìn)行映射,要么映射到一個(gè)多個(gè)離散的標(biāo)簽上,或者是連續(xù)的空間里面,一般簡(jiǎn)單的數(shù)據(jù)而言,我們很好擬合,只要線性變化一下,然后學(xué)習(xí)出較好的就可以了,但是對(duì)于一些比較復(fù)雜的數(shù)據(jù)怎 其實(shí)我們?cè)谧鼍€性回歸也好,分類(lèi)(邏輯斯蒂回歸)也好,本質(zhì)上來(lái)講,就是把數(shù)據(jù)進(jìn)行映射,要么映射到一個(gè)多個(gè)離散的標(biāo)簽上,或者是連續(xù)的空間里面,一般簡(jiǎn)單的數(shù)據(jù)...

摘要:隨著復(fù)雜和高效的神經(jīng)網(wǎng)絡(luò)架構(gòu)的出現(xiàn),卷積神經(jīng)網(wǎng)絡(luò)的性能已經(jīng)優(yōu)于傳統(tǒng)的數(shù)字圖像處理方法,如和。子網(wǎng)絡(luò)由多個(gè)卷積層組成,而子網(wǎng)絡(luò)由幾個(gè)完全連接層組成。結(jié)論總而言之,模型用信號(hào)分析的角度為我們剖析了卷積神經(jīng)網(wǎng)絡(luò)。 隨著復(fù)雜和高效的神經(jīng)網(wǎng)絡(luò)架構(gòu)的出現(xiàn),卷積神經(jīng)網(wǎng)絡(luò)(CNN)的性能已經(jīng)優(yōu)于傳統(tǒng)的數(shù)字圖像處理方法,如 SIFT 和 SURF。在計(jì)算機(jī)視覺(jué)領(lǐng)域,學(xué)者們開(kāi)始將研究重點(diǎn)轉(zhuǎn)移到 CNN,并相信 ...

摘要:將軀干圖像灰度化后經(jīng)插值運(yùn)算和歸一化變換為大小的矩陣,作為結(jié)構(gòu)的卷積神經(jīng)網(wǎng)絡(luò)的輸入進(jìn)行個(gè)體識(shí)別。卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建為減少數(shù)據(jù)量并保證輸入圖像的細(xì)節(jié)信息,將奶牛軀干圖像灰度化后通過(guò)插值計(jì)算變化為的圖像,并除以歸一化后作為輸入數(shù)據(jù)。 最近看了一個(gè)有趣的人工智能應(yīng)用,給大家分享一下~這是一個(gè)人工智能與農(nóng)業(yè)的結(jié)合,在農(nóng)業(yè)中我們經(jīng)常需要給個(gè)體動(dòng)物做標(biāo)記,目的是對(duì)奶牛做身份識(shí)別,然后可以對(duì)動(dòng)物做養(yǎng)殖和繁殖...

閱讀 1562·2021-11-23 09:51

閱讀 1097·2021-10-12 10:12

閱讀 2816·2021-09-22 16:06

閱讀 3643·2019-08-30 15:56

閱讀 3468·2019-08-30 15:53

閱讀 3113·2019-08-29 16:29

閱讀 2366·2019-08-29 15:27

閱讀 2022·2019-08-26 10:49