資訊專(zhuān)欄INFORMATION COLUMN

摘要:潘新鋼等發(fā)現(xiàn),和的核心區(qū)別在于,學(xué)習(xí)到的是不隨著顏色風(fēng)格虛擬性現(xiàn)實(shí)性等外觀變化而改變的特征,而要保留與內(nèi)容相關(guān)的信息,就要用到。

大把時(shí)間、大把GPU喂進(jìn)去,訓(xùn)練好了神經(jīng)網(wǎng)絡(luò)。

接下來(lái),你可能會(huì)迎來(lái)傷心一刻:

同學(xué),測(cè)試數(shù)據(jù)和訓(xùn)練數(shù)據(jù),色調(diào)、亮度不太一樣。

同學(xué),你還要去搞定一個(gè)新的數(shù)據(jù)集。

是重新搭一個(gè)模型呢,還是拿來(lái)新數(shù)據(jù)重新調(diào)參,在這個(gè)已經(jīng)訓(xùn)練好的模型上搞遷移學(xué)習(xí)呢?

香港中文大學(xué)-商湯聯(lián)合實(shí)驗(yàn)室的潘新鋼、羅平、湯曉鷗和商湯的石建萍,給出了一個(gè)新選項(xiàng)。

他們?cè)O(shè)計(jì)了一種新的卷積架構(gòu),既能讓CNN提升它在原本領(lǐng)域的能力,又能幫它更好地泛化到新領(lǐng)域。

這個(gè)新架構(gòu)叫做IBN-Net。

它在伯克利主辦的WAD 2018 Challenge中獲得了Drivable Area(可行駛區(qū)域)賽道的冠軍。相關(guān)的論文Two at Once: Enhancing Learning and Generalization Capacities via IBN-Net發(fā)表在即將召開(kāi)的計(jì)算機(jī)視覺(jué)頂會(huì)ECCV 2018上。

給神經(jīng)網(wǎng)絡(luò)加個(gè)buff

IBN-Net并不是一個(gè)像ResNet那樣獨(dú)立的神經(jīng)網(wǎng)絡(luò)架構(gòu),它可以和其他深度學(xué)習(xí)模型結(jié)合起來(lái)使用,提升它們的性能,但不會(huì)增加計(jì)算成本。經(jīng)典的DenseNet、ResNet、ResneXt、SENet等等,都能用它來(lái)助攻。

這就相當(dāng)于給深度學(xué)習(xí)模型加了個(gè)buff,或者說(shuō),喂下了一顆大力丸。

同時(shí),它還可以算是遷移學(xué)習(xí)的替代品。

在一個(gè)數(shù)據(jù)集上訓(xùn)練好了模型,如果測(cè)試數(shù)據(jù)和訓(xùn)練集風(fēng)格、顏色上有點(diǎn)不一樣,或者換個(gè)數(shù)據(jù)集來(lái)測(cè)試,模型的性能就會(huì)大打折扣。

這時(shí)候,按套路就該遷移學(xué)習(xí)出場(chǎng)了,用新數(shù)據(jù)給訓(xùn)練好的模型調(diào)參。

數(shù)據(jù)集這么多,現(xiàn)實(shí)世界更是豐富多彩,一個(gè)一個(gè)地去重新搭模型或者調(diào)參數(shù),要多少工程師才夠用?

而IBN-Net就不需要新數(shù)據(jù)來(lái)調(diào)參,能自動(dòng)讓模型更好地適應(yīng)新的領(lǐng)域。

不怕加濾鏡,跨越次元壁

在圖像識(shí)別和語(yǔ)義分割任務(wù)上,IBN-Net都能幫深度學(xué)習(xí)模型提分。

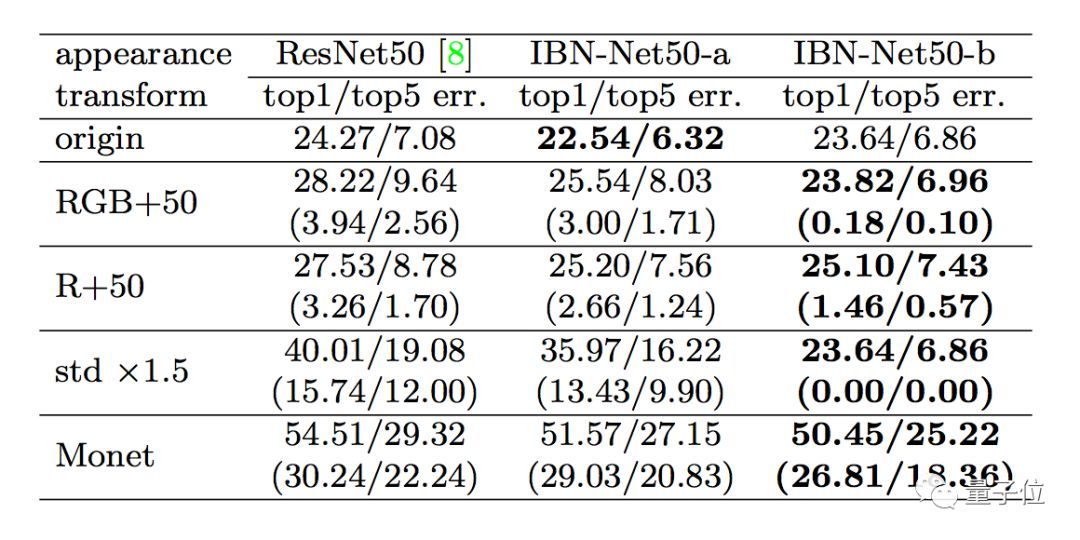

比如在ImageNet上,加了IBN-Net(的各種變體),就能在同樣的參數(shù)設(shè)置,同樣的計(jì)算成本下,讓ResNet50的錯(cuò)誤率下降0.5-1.5個(gè)百分點(diǎn)。

如果測(cè)試數(shù)據(jù)在原始ImageNet的基礎(chǔ)上再做一些變化,調(diào)整一下顏色亮度對(duì)比度,甚至用Cycle-GAN改改風(fēng)格,基本款ResNet50錯(cuò)誤率就會(huì)大幅上升。而加了IBN-Net的版本,錯(cuò)誤率就能少上升一些,如上圖括號(hào)中的數(shù)據(jù)所示。

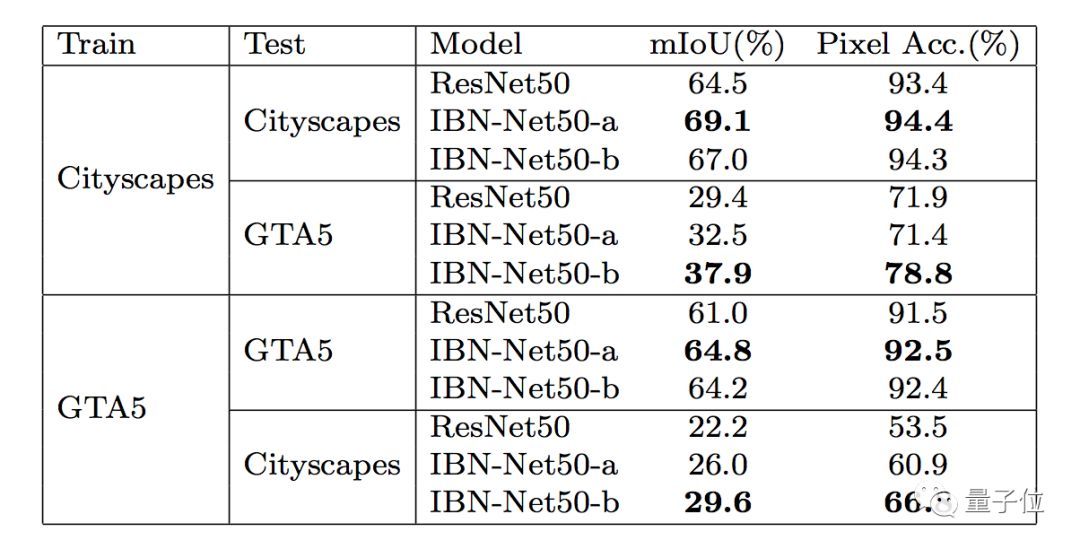

語(yǔ)義分割任務(wù)上也是一樣。

IBN-Net加持的ResNet50,能在現(xiàn)實(shí)世界的城市街道圖像數(shù)據(jù)集Cityscapes、虛擬世界的GTA5數(shù)據(jù)集上都取得比原版更好的成績(jī)。

想讓模型跨越虛擬與現(xiàn)實(shí)之間的次元壁,既能適應(yīng)Cityscapes,也能用在GTA5上,IBN-Net也很擅長(zhǎng)。

論文中說(shuō),將模型從Cityscapes遷移到GTA5,用IBN-Net能讓遷移后的性能少下降8.5%;從GTA5遷移到Cityscapes,則能少下降7.5%。

這種跨越次元壁的遷移可大有用處。比如說(shuō)在自動(dòng)駕駛領(lǐng)域,用游戲來(lái)初步訓(xùn)練無(wú)人車(chē)是個(gè)常見(jiàn)的操作,可是把這樣訓(xùn)練出來(lái)的算法搬到現(xiàn)實(shí)環(huán)境中,顯然要經(jīng)過(guò)大量調(diào)整。

讓模型更快更好地適應(yīng)不同環(huán)境的IBN-Net,簡(jiǎn)直就是效率提升利器。

“IBN”究竟是什么?

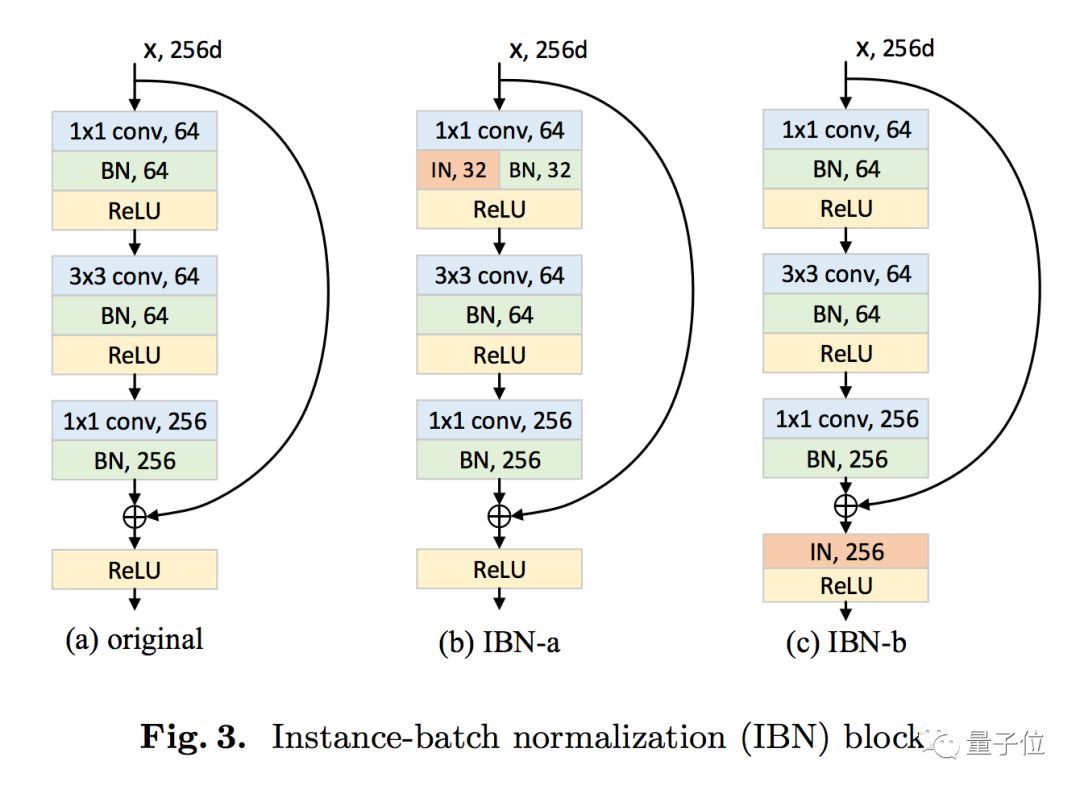

要理解這個(gè)IBN-Net的架構(gòu),要先從兩種標(biāo)準(zhǔn)化方法IN(Instance Normalization,實(shí)例標(biāo)準(zhǔn)化)和BN(Batch Normalization,批標(biāo)準(zhǔn)化)。

它們都能讓神經(jīng)網(wǎng)絡(luò)調(diào)參更簡(jiǎn)單,用上更高的學(xué)習(xí)速率,收斂更快。如果你搭過(guò)圖像分類(lèi)模型,batchnorm(BN)大概很熟悉了,而IN更多出現(xiàn)在風(fēng)格遷移等任務(wù)上。與BN相比,IN有兩個(gè)主要的特點(diǎn):第一,它不是用訓(xùn)練批次來(lái)將圖像特征標(biāo)準(zhǔn)化,而是用單個(gè)樣本的統(tǒng)計(jì)信息;第二,IN能將同樣的標(biāo)準(zhǔn)化步驟既用于訓(xùn)練,又用于推斷。

潘新鋼等發(fā)現(xiàn),IN和BN的核心區(qū)別在于,IN學(xué)習(xí)到的是不隨著顏色、風(fēng)格、虛擬性/現(xiàn)實(shí)性等外觀變化而改變的特征,而要保留與內(nèi)容相關(guān)的信息,就要用到BN。

二者結(jié)合,就成了IBN-Net。

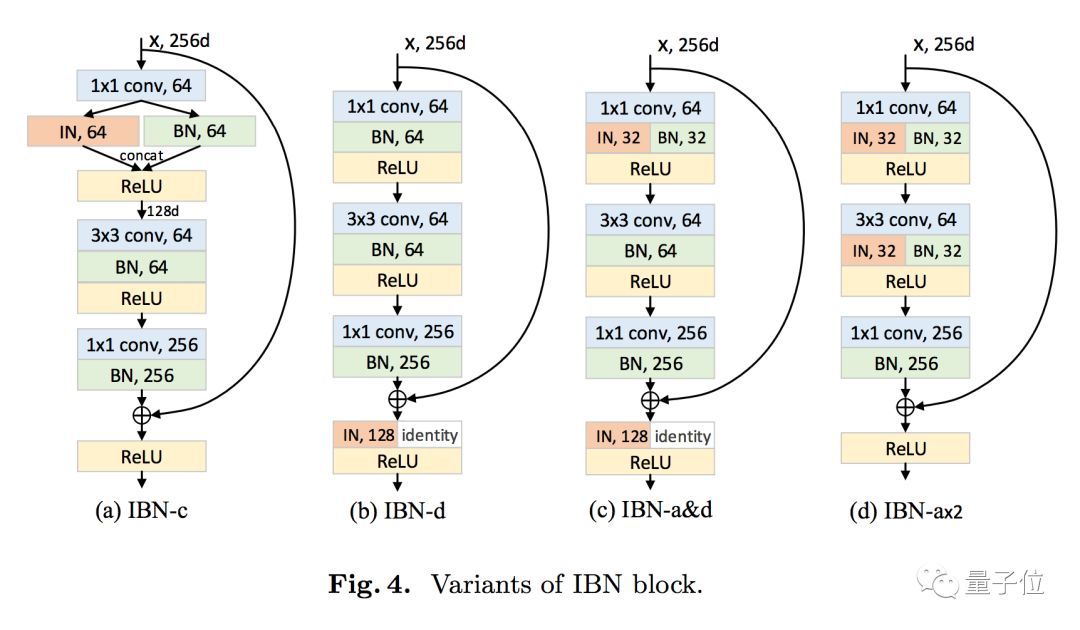

還可以根據(jù)需求,來(lái)調(diào)整IN和BN在模型中的搭配。

各種變體的具體情況,論文中有更清晰的描述。

論文:https://arxiv.org/pdf/1807.09441.pdf

代碼:XingangPan/IBN-Net

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請(qǐng)聯(lián)系小編及時(shí)處理,謝謝!

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4809.html

摘要:年,他把微軟的架構(gòu)組織圖描繪成一幅血淋淋的景象,各大部門(mén)聚集在自己的小圈子里,部門(mén)間則槍口相向。目前,微軟人臉識(shí)別技術(shù)已幫助位走失兒童回家攝。年前,微軟亞洲研究院干脆成立了一個(gè)創(chuàng)新匯。還記得科技漫畫(huà)家Manu Cornet嗎?就是那位后來(lái)進(jìn)入Google的軟件工程師。2011年,他把微軟的架構(gòu)組織圖描繪成一幅血淋淋的景象,各大部門(mén)聚集在自己的小圈子里,部門(mén)間則槍口相向。Manu Cornet...

摘要:沒(méi)錯(cuò),火遍朋友圈的修圖工具的背后就是最近流行的四個(gè)字深度學(xué)習(xí)。這樣處理后得到的僅是圖片的紋理而不是整體布局。這就是提供給我們的修圖效果。以上用一句話概括就是,深度學(xué)習(xí)實(shí)現(xiàn)了藝術(shù)內(nèi)容和藝術(shù)風(fēng)格的分離與重構(gòu)。 引子:有段子手言,地球上的人一半在用Pokemon Go追皮卡丘的時(shí)候,剩下的一半在用Prisma修圖!這款由俄羅斯創(chuàng)業(yè)團(tuán)隊(duì)研發(fā)的圖片處理app,從研發(fā)到上線僅幾個(gè)月就用戶(hù)量驚人,更讓人驚...

閱讀 2052·2019-08-30 15:52

閱讀 2444·2019-08-29 18:37

閱讀 796·2019-08-29 12:33

閱讀 2843·2019-08-29 11:04

閱讀 1532·2019-08-27 10:57

閱讀 2100·2019-08-26 13:38

閱讀 2766·2019-08-26 12:25

閱讀 2453·2019-08-26 12:23