資訊專欄INFORMATION COLUMN

摘要:為此,來(lái)自牛津大學(xué)和倫敦大學(xué)的研究人員提出了一種新的模型,與傳統(tǒng)處理器中的算術(shù)邏輯單元類比,他們稱該結(jié)構(gòu)為神經(jīng)算數(shù)邏輯單元。故而研究者進(jìn)一步提出了,神經(jīng)算數(shù)邏輯單元。結(jié)構(gòu)簡(jiǎn)單,功能強(qiáng)大,盡管論文剛剛發(fā)布數(shù)日,卻已經(jīng)引起熱議。

計(jì)算機(jī)問(wèn)世以來(lái),人類對(duì)于制造智能機(jī)器的興趣便有增無(wú)減。尤其是近年來(lái),第四次技術(shù)革命掀起巨大的風(fēng)暴,機(jī)器學(xué)習(xí)和深度學(xué)習(xí)領(lǐng)域技術(shù)飛速發(fā)展并快速轉(zhuǎn)化為產(chǎn)品走入人們的生活,人工智能儼然成為了全民話題。能識(shí)別人臉,能自動(dòng)駕駛,能診斷疾病,能預(yù)測(cè)未來(lái)……人們?cè)缫验_(kāi)始幻想制造出真正的人工智能時(shí)的景象,探討人類與這位“超人”的關(guān)系。

?

圖一:《極限挑戰(zhàn)》人工智能主題節(jié)目

?

然而,人類距離制造出這樣一個(gè)擁有真正的智能的機(jī)器還有相當(dāng)遙遠(yuǎn)的距離。當(dāng)下人工智能領(lǐng)域當(dāng)之無(wú)愧的明星神經(jīng)網(wǎng)絡(luò),才剛剛學(xué)會(huì)“數(shù)數(shù)”。

?

神經(jīng)網(wǎng)絡(luò)可以在學(xué)習(xí)表示和操縱數(shù)字,但當(dāng)他們遇到超出訓(xùn)練范圍之外的數(shù)值時(shí),卻往往不知所措。圖一中展示了不同多層感知器學(xué)習(xí)標(biāo)量的恒等函數(shù)(f(x)=x)時(shí)的行為。恒等函數(shù)是最簡(jiǎn)單的數(shù)值關(guān)系之一,盡管許多結(jié)構(gòu)在理論上可以表示這一數(shù)值關(guān)系,但在實(shí)踐中它們的表現(xiàn)卻差強(qiáng)人意。

?

圖二:利用 MLP(多層感知器)學(xué)習(xí)恒等函數(shù)。MLP 只“學(xué)會(huì)”了訓(xùn)練數(shù)據(jù)數(shù)值范圍內(nèi)的內(nèi)容。訓(xùn)練數(shù)值外的平均誤差斜向上升。誤差的大小與模型激活函數(shù)的非線性程度相關(guān)。

?

究其原因,是系統(tǒng)結(jié)構(gòu)導(dǎo)致泛化能力的缺失,使得這些模型缺乏對(duì)數(shù)值的推理能力。然而,從像人類一樣的高級(jí)哺乳動(dòng)物到如蜜蜂等昆蟲(chóng)般簡(jiǎn)單的生物,這種能力在生物界十分常見(jiàn)。由此也表明,基本的數(shù)值推理是智能的基本的組成部分。

?

為此,來(lái)自 DeepMind、牛津大學(xué)和倫敦大學(xué)的研究人員提出了一種新的模型 NALU(neural arithmetic logic unit),與傳統(tǒng)處理器中的算術(shù)邏輯單元類比,他們稱該結(jié)構(gòu)為神經(jīng)算數(shù)邏輯單元。

NALU 通過(guò)線性激活函數(shù)表示數(shù)值量,由門結(jié)構(gòu)控制,通過(guò)原始的算術(shù)運(yùn)算來(lái)操縱。實(shí)驗(yàn)結(jié)果表明,通過(guò)該結(jié)構(gòu)加強(qiáng)的神經(jīng)網(wǎng)絡(luò)可以學(xué)習(xí)追蹤時(shí)間、對(duì)數(shù)字圖像進(jìn)行運(yùn)算、將數(shù)值語(yǔ)言轉(zhuǎn)化為實(shí)值標(biāo)量、執(zhí)行計(jì)算機(jī)代碼、計(jì)算圖像中的物體數(shù)目……和傳統(tǒng)結(jié)構(gòu)相比,該結(jié)構(gòu)在訓(xùn)練時(shí)學(xué)習(xí)的數(shù)值范圍之內(nèi)和在外都表現(xiàn)出了更好的泛化能力,可以把握數(shù)據(jù)底層的數(shù)值本質(zhì),推理能力往往可以超出訓(xùn)練中觀測(cè)數(shù)據(jù)幾個(gè)數(shù)量級(jí)。

?

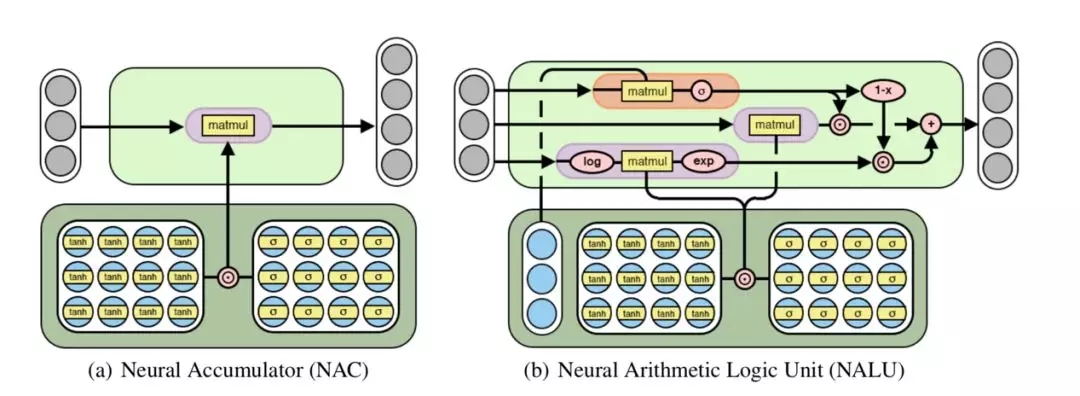

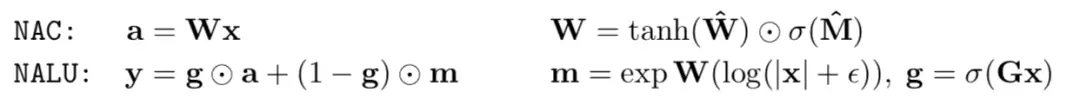

研究人員提出了兩種模型。第一個(gè)模型稱為 NAC(neural accumulator,神經(jīng)累積器)。這是一種特殊的線性層,它的轉(zhuǎn)換矩陣 W 僅僅由 0,-1,1 組成。也就是說(shuō),它的輸出只會(huì)是輸入向量各個(gè)行進(jìn)行加減運(yùn)算的結(jié)果,而不會(huì)像之前的處理包含縮放。因此,不論進(jìn)行多少操作,在整個(gè)模型中,數(shù)值表示的尺度都是不變的。該模型不包含偏置向量,也不對(duì)輸出結(jié)果應(yīng)用任何非線性操作。

?

圖三:NAC 對(duì)其輸入進(jìn)行線性轉(zhuǎn)換。NALU 通過(guò)門結(jié)構(gòu)(b 中橙色部分)控制兩個(gè) NAC 結(jié)構(gòu)的組合和相應(yīng)的權(quán)重實(shí)現(xiàn)加減(b 中小紫色色部分)和乘除(b 中大紫色部分)操作。

?

僅僅可以進(jìn)行加法減法操作并一般化是不夠的,乘法等更為復(fù)雜的操作也是必須的。故而研究者進(jìn)一步提出了 NALU(neural arithmetic logic unit,神經(jīng)算數(shù)邏輯單元)。他通過(guò)學(xué)習(xí)得到兩個(gè)子細(xì)胞(NAC)的不同權(quán)重的和,其中一個(gè)處理加減操作,另一個(gè)處理乘除冪運(yùn)算等。NALU 也表明了 NAC 可以通過(guò)門控制的子操作擴(kuò)展,進(jìn)行新型數(shù)值函數(shù)的端到端學(xué)習(xí)。和 NAC 一樣,NALU 也不包含任何改變數(shù)值表示的尺度的操作。

?

圖四:NAC 與 NALU 的運(yùn)算規(guī)則

?

這項(xiàng)工作可以視為是在深度神經(jīng)網(wǎng)絡(luò)中應(yīng)用線性激活函數(shù)的倡導(dǎo)。正如最近其他結(jié)構(gòu)創(chuàng)新,如 Highway Networks、ResNets 和 DenseNet 等,他們都倡導(dǎo)使用線性連接以減少梯度爆照和梯度消失。盡管由于模型體系的深度增加會(huì)帶來(lái)額外的計(jì)算開(kāi)銷,但這樣的方式的確會(huì)改善性能。這項(xiàng)工作也符合機(jī)器學(xué)習(xí)中更廣泛的主題,即尋求以控制方程的形式確定那些能探索空間中不可見(jiàn)部分的系統(tǒng)的基礎(chǔ)結(jié)構(gòu)。

?

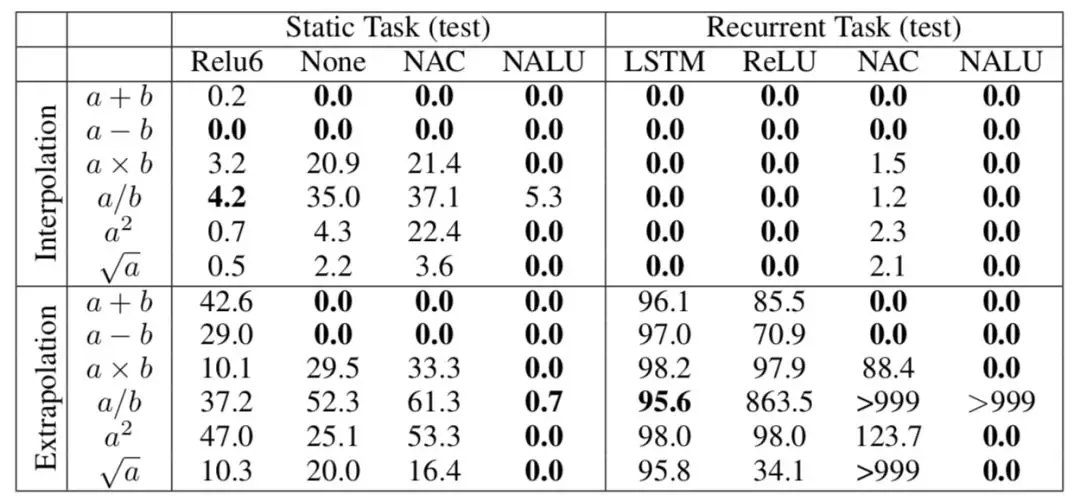

實(shí)驗(yàn)一:簡(jiǎn)單的函數(shù)學(xué)習(xí)任務(wù)

這個(gè)簡(jiǎn)單的實(shí)驗(yàn)意在展示 NAC 結(jié)構(gòu)和 NALU 結(jié)構(gòu)學(xué)習(xí)選擇相關(guān)輸入并對(duì)其應(yīng)用不同算數(shù)方法的能力,也就是設(shè)計(jì)它們的初衷。該任務(wù)分成兩個(gè)部分。第一部分是靜態(tài)任務(wù),每個(gè)輸入作為一個(gè)向量?jī)H僅出現(xiàn)一次。第二個(gè)任務(wù)是循環(huán)的,輸入組成序列依次呈現(xiàn)。

?

圖五:實(shí)驗(yàn)一測(cè)試結(jié)果 插入值(Interpolation)和外推(Extrapolation)錯(cuò)誤率。0.0 是最優(yōu)的表現(xiàn)結(jié)果,100.0 表示隨機(jī)效果,>100.0 表示效果比隨機(jī)初始化的模型還差。

?

圖中的結(jié)果表明,各種模型即使在插值的處理中取得了不錯(cuò)的結(jié)果,但是它們無(wú)一能較好地處理數(shù)值外推的情形。而 NAC 在加法,減法運(yùn)算中均取得了較好的結(jié)果,更為復(fù)雜的 NALU 表現(xiàn)得則更為優(yōu)秀,除了數(shù)值外推的除法運(yùn)算。

?

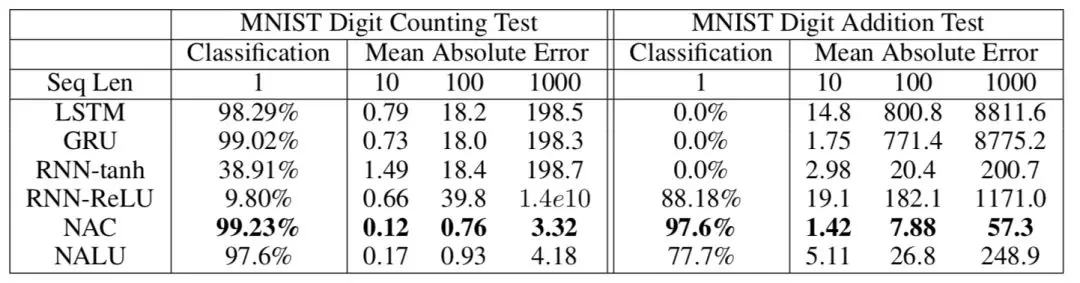

實(shí)驗(yàn)二:MINST 計(jì)數(shù)和算數(shù)任務(wù)

在上一個(gè)任務(wù)中,輸入和輸出已經(jīng)被泛化為可以直接進(jìn)行計(jì)算的形式,需要學(xué)習(xí)的僅僅是中間的操作和表示方法。在這個(gè)任務(wù)中,研究者探究了該模型能否學(xué)習(xí)非數(shù)字化輸入。他們隨機(jī)選擇 10 個(gè) MNIST 數(shù)據(jù)集中的數(shù)字輸入循環(huán)網(wǎng)絡(luò)模型中。在 MNIST 計(jì)數(shù)任務(wù)中,要求其輸出各種類型數(shù)字出現(xiàn)的次數(shù)。在 MNIST 數(shù)字加法任務(wù)中,則要求其輸出這些數(shù)字的和。

?

圖六:實(shí)驗(yàn)二測(cè)試結(jié)果

?

與實(shí)驗(yàn)一呈現(xiàn)出的結(jié)果相同,標(biāo)準(zhǔn)結(jié)構(gòu)盡管可以較好的處理插值,在處理數(shù)值外推方面卻表現(xiàn)欠佳。而 NAC 結(jié)構(gòu)在這兩種情況下都表現(xiàn)優(yōu)異。

?

除此之外,研究者還進(jìn)行了文本數(shù)字轉(zhuǎn)換、程序評(píng)估、時(shí)間追蹤等實(shí)驗(yàn),證明了 NALU 的優(yōu)良性能。這一結(jié)構(gòu)還可以很容易地與各種神經(jīng)網(wǎng)絡(luò)模型結(jié)合使用,提高模型性能。

?

NALU 結(jié)構(gòu)簡(jiǎn)單,功能強(qiáng)大,盡管論文剛剛發(fā)布數(shù)日,卻已經(jīng)引起熱議。GitHub 上已經(jīng)出現(xiàn)了十幾個(gè)利用不同工具對(duì)該結(jié)構(gòu)的實(shí)現(xiàn)和應(yīng)用,其中包括包括 pytorch、tensorflow 等廣泛應(yīng)用的機(jī)器學(xué)習(xí)框架。研究者 Trask 也在 twitter 上不竭余力的為其宣傳,希望其在更多任務(wù)中被嘗試應(yīng)用。

參考:https://arxiv.org/pdf/1808.00508.pdf

github :

https://github.com/search?utf8=%E2%9C%93&q=Neural+Arithmetic+Logic+Units&type

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請(qǐng)聯(lián)系小編及時(shí)處理,謝謝!

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4804.html

摘要:取得博士學(xué)位后,他加入的團(tuán)隊(duì),在多倫多大學(xué)攻讀博士后,在年跟和合著了提出深度信念網(wǎng)絡(luò)的論文。只有充分了解,才能做出強(qiáng)有力的戰(zhàn)略決策。這帶來(lái)的一個(gè)重大問(wèn)題是,個(gè)人隱私數(shù)據(jù)被其他人控制。機(jī)器學(xué)習(xí)是數(shù)據(jù)驅(qū)動(dòng)的,與統(tǒng)計(jì)數(shù)據(jù)緊密相關(guān)。 昨天,谷歌 DeepMind 聯(lián)合創(chuàng)始人 Demis Hassabis 發(fā)布了這樣一條消息:很高興 Yee Whye Teh 和 Simon Osindero 加入團(tuán)隊(duì)...

摘要:是蒙特利爾大學(xué)的計(jì)算機(jī)科學(xué)家,他與以及另外幾個(gè)人被稱為深度學(xué)習(xí)的先驅(qū)。的結(jié)果顯示了深度學(xué)習(xí)的能力。讓人們激動(dòng)的是這一領(lǐng)域的一種學(xué)習(xí)方法深度學(xué)習(xí),能夠應(yīng)用于眾多不同的領(lǐng)域,谷歌機(jī)器智能研究部門負(fù)責(zé)人如今負(fù)責(zé)搜索引擎的表示,谷歌正在使用深度學(xué) 1. 「機(jī)器問(wèn)題」重現(xiàn)從最初的屢屢失敗,到現(xiàn)在的朝氣蓬勃,人工智能會(huì)導(dǎo)致大面積失業(yè)甚至讓人類滅絕嗎?或許歷史會(huì)給我們一些有用的線索。有些人害怕機(jī)器會(huì)搶走所...

摘要:然而反向傳播自誕生起,也受到了無(wú)數(shù)質(zhì)疑。主要是因?yàn)椋聪騻鞑C(jī)制實(shí)在是不像大腦。他集結(jié)了來(lái)自和多倫多大學(xué)的強(qiáng)大力量,對(duì)這些替代品進(jìn)行了一次評(píng)估。號(hào)選手,目標(biāo)差傳播,。其中來(lái)自多倫多大學(xué)和,一作和來(lái)自,來(lái)自多倫多大學(xué)。 32年前,人工智能、機(jī)器學(xué)習(xí)界的泰斗Hinton提出反向傳播理念,如今反向傳播已經(jīng)成為推動(dòng)深度學(xué)習(xí)爆發(fā)的核心技術(shù)。然而反向傳播自誕生起,也受到了無(wú)數(shù)質(zhì)疑。這些質(zhì)疑來(lái)自各路科學(xué)家...

摘要:深度學(xué)習(xí)現(xiàn)在被視為能夠超越那些更加直接的機(jī)器學(xué)習(xí)的關(guān)鍵一步。的加入只是谷歌那一季一系列重大聘任之一。當(dāng)下谷歌醉心于深度學(xué)習(xí),顯然是認(rèn)為這將引發(fā)下一代搜索的重大突破。移動(dòng)計(jì)算的出現(xiàn)已經(jīng)迫使谷歌改變搜索引擎的本質(zhì)特征。 Geoffrey Hiton說(shuō):我需要了解一下你的背景,你有理科學(xué)位嗎?Hiton站在位于加利福尼亞山景城谷歌園區(qū)辦公室的一塊白板前,2013年他以杰出研究者身份加入這家公司。H...

摘要:實(shí)驗(yàn)蒙特祖瑪?shù)膹?fù)仇蒙特祖瑪?shù)膹?fù)仇是上最難的游戲之一。圖蒙特祖瑪?shù)膹?fù)仇的學(xué)習(xí)曲線在第一個(gè)房間中學(xué)習(xí)的子目標(biāo)的可視化呈現(xiàn)。結(jié)論如何創(chuàng)建一個(gè)能夠?qū)W習(xí)將其行為分解為有意義的基元,然后重新利用它們以更有效地獲取新的行為,這是一個(gè)長(zhǎng)期存在的研究問(wèn)題。 論文題目:分層強(qiáng)化學(xué)習(xí)的 FeUdal 網(wǎng)絡(luò)(FeUdal Networks for Hierarchical Reinforcement Learnin...

閱讀 4160·2021-11-22 13:52

閱讀 2074·2021-09-22 15:12

閱讀 1121·2019-08-30 15:53

閱讀 3455·2019-08-29 17:12

閱讀 2190·2019-08-29 16:23

閱讀 1647·2019-08-26 13:56

閱讀 1772·2019-08-26 13:44

閱讀 1880·2019-08-26 11:56