資訊專欄INFORMATION COLUMN

摘要:近日,英偉達(dá)發(fā)表了一篇大規(guī)模語言建模的論文,他們使用塊在小時(shí)內(nèi)使得可以收斂,值得注意的是,他們使用的數(shù)據(jù)集包含的文本,這在以前通常需要花費(fèi)數(shù)周的時(shí)間進(jìn)行訓(xùn)練。表示訓(xùn)練出現(xiàn)發(fā)散。

近日,英偉達(dá)發(fā)表了一篇大規(guī)模語言建模的論文,他們使用 128 塊 GPU 在 4 小時(shí)內(nèi)使得 mLSTM 可以收斂,值得注意的是,他們使用的 Amazon Reviews 數(shù)據(jù)集包含 40GB 的文本,這在以前通常需要花費(fèi)數(shù)周的時(shí)間進(jìn)行訓(xùn)練。這樣的大規(guī)模語言模型能作為一種預(yù)訓(xùn)練模型遷移大量的語言知識(shí),也就是說如果將其應(yīng)用到機(jī)器翻譯、機(jī)器閱讀理解和情感分析等 NLP 任務(wù),數(shù)據(jù)需求量和計(jì)算量都能得到大幅度的降低。

近年來,深度學(xué)習(xí)已經(jīng)成功應(yīng)用到多種問題中。遷移學(xué)習(xí)在計(jì)算機(jī)視覺問題上的成功運(yùn)用使得許多應(yīng)用成為可能:VGG[6] 和 ResNets [7] 等大型 CNN 在 ImageNet 等大型圖像數(shù)據(jù)集上進(jìn)行預(yù)訓(xùn)練 [8,9] 然后在計(jì)算機(jī)視覺任務(wù)中作為骨干網(wǎng)絡(luò)架構(gòu)。這些模型可以為新任務(wù)提取有用的特征,而無需在執(zhí)行每個(gè)任務(wù)時(shí)都從頭開始訓(xùn)練 [2], [10]–[12]。

最近的研究已經(jīng)從無監(jiān)督語言建模中得出了很有潛力的結(jié)果,隨后人們將遷移學(xué)習(xí)應(yīng)用到自然語言任務(wù) [3], [13]。然而,與卷積圖像模型不同,神經(jīng)語言模型還沒有從大規(guī)模和遷移學(xué)習(xí)中受益。神經(jīng)語言模型往往通過在大型語料庫上使用詞嵌入預(yù)訓(xùn)練來實(shí)現(xiàn)大規(guī)模遷移學(xué)習(xí) [14]– [16]。僅遷移詞嵌入會(huì)限制遷移的范圍,因?yàn)樵~嵌入不會(huì)捕獲文本中的序列信息。英偉達(dá)的研究者想要遷移的是具備處理文本序列能力的整個(gè) NLP 模型。

然而,由于在大型數(shù)據(jù)集上訓(xùn)練大型語言模型非常耗時(shí),因此上述情況下的遷移學(xué)習(xí)非常困難。最近發(fā)表的幾篇論文試圖發(fā)揮分布式深度學(xué)習(xí)及可用高性能計(jì)算(HPC)資源的內(nèi)存和計(jì)算能力的優(yōu)勢(shì),通過利用分布式數(shù)據(jù)并行并在訓(xùn)練期間增加有效批尺寸來解決訓(xùn)練耗時(shí)的問題 [1],[17]– [20]。這一研究往往聚焦于計(jì)算機(jī)視覺,很少涉及自然語言任務(wù),更不用說基于 RNN 的語言模型了。由于基于 RNN 的語言模型具有序列性,這些模型在數(shù)值上很難訓(xùn)練,且并行性差。有證據(jù)表明,用于語言建模、語音識(shí)別和神經(jīng)機(jī)器翻譯的 RNN 在大型數(shù)據(jù)集上訓(xùn)練時(shí),準(zhǔn)確率還有提升的空間 [21]。相應(yīng)的,高效訓(xùn)練大型 RNN 模型的技術(shù)將在許多神經(jīng)語言任務(wù)中帶來準(zhǔn)確率的提升。

研究人員專注于在亞馬遜評(píng)論數(shù)據(jù)集上訓(xùn)練一個(gè)單層 4096 神經(jīng)元乘法 LSTM(multiplicative LSTM,mLSTM)字符級(jí)語言模型,這個(gè)數(shù)據(jù)集是目前開源的較大自然語言處理數(shù)據(jù)集之一,他們將該模型遷移到 Binary Stanford Sentiment Treebank (SST) 和 IMDB 電影評(píng)論數(shù)據(jù)集的情感分類的下游任務(wù)中。然后用混合精度 FP16/FP32 算術(shù)運(yùn)算來訓(xùn)練循環(huán)模型,它在單個(gè) V100 上的訓(xùn)練速度比 FP32 快了 4.2 倍。

接著研究人員通過 128GPU 的分布式數(shù)據(jù)并行,使用 32k 的批大小訓(xùn)練了混合精度模型。這比起使用單個(gè) GPU,訓(xùn)練的數(shù)據(jù)量增加了 109 倍。然而,由于批大小變大,需要額外的 epoch 來將模型訓(xùn)練至相同準(zhǔn)確率,最終總訓(xùn)練時(shí)長(zhǎng)為 4 小時(shí)。

此外,他們還訓(xùn)練了一個(gè)有 8192 個(gè)神經(jīng)元的 mLSTM,它在亞馬遜評(píng)論語言模型中的表現(xiàn)超越了當(dāng)前最優(yōu)模型,取得了每字符位數(shù)(BPC)為 1.038,SST 分類準(zhǔn)確率為 93.8% 的性能。

研究人員分析了分布式數(shù)據(jù)并行是如何隨著模型增大而擴(kuò)展的。在使用分布式數(shù)據(jù)并行訓(xùn)練 RNN 時(shí),他們觀察到一些訓(xùn)練時(shí)批量過大會(huì)出現(xiàn)的常見問題。他們研究數(shù)據(jù)集大小、批大小和學(xué)習(xí)率方案之間的關(guān)系,以探索如何有效地利用大批量來訓(xùn)練更為常見的大型自然語言處理(NLP)數(shù)據(jù)集。

在這篇論文中,作者們表示這項(xiàng)工作為商業(yè)應(yīng)用以及深度學(xué)習(xí)研究提供了大規(guī)模無監(jiān)督 NLP 訓(xùn)練的基礎(chǔ)。作者在 GitHub 項(xiàng)目中展示了實(shí)現(xiàn)無監(jiān)督情感分析的實(shí)驗(yàn),其中大規(guī)模語言模型可以作為情感分析的預(yù)訓(xùn)練模型。

項(xiàng)目地址:https://github.com/NVIDIA/sentiment-discovery

論文:Large Scale Language Modeling: Converging on 40GB of Text in Four Hours?

論文地址:https://arxiv.org/pdf/1808.01371v1.pdf

摘要:近期有許多研究關(guān)注如何在大型數(shù)據(jù)集上快速訓(xùn)練卷積神經(jīng)網(wǎng)絡(luò),然后將這些模型學(xué)習(xí)到的知識(shí)遷移到多種任務(wù)上。跟隨 [Radford 2017] 研究的方向,在這項(xiàng)研究中,我們展示了循環(huán)神經(jīng)網(wǎng)絡(luò)在自然語言任務(wù)上相似的可擴(kuò)展性和遷移能力。通過使用混合精度算術(shù)運(yùn)算,我們?cè)?128 塊英偉達(dá) Tesla V100 GPU 使用 32k 的批大小進(jìn)行分布式訓(xùn)練,因此可以在 40GB 的亞馬遜評(píng)論(Amazon Reviews)數(shù)據(jù)集上針對(duì)無監(jiān)督文本重建任務(wù)訓(xùn)練一個(gè)字符級(jí) 4096 維乘法 LSTM(multiplicative LSTM, mLSTM),并在 4 個(gè)小時(shí)完成 3 個(gè) epoch 的訓(xùn)練。這個(gè)運(yùn)行時(shí)相比于之前在相同數(shù)據(jù)集、相同大小和配置上花費(fèi)一個(gè)月訓(xùn)練一個(gè) epoch 的工作很有優(yōu)勢(shì)。大批量 RNN 模型的收斂一般非常有挑戰(zhàn)性。近期的研究提出將學(xué)習(xí)率作為批大小的函數(shù)進(jìn)行縮放,但我們發(fā)現(xiàn)在這個(gè)問題中僅將學(xué)習(xí)率作為批大小的函數(shù)縮放會(huì)導(dǎo)致更差的收斂行為或立刻發(fā)散。我們提供了一個(gè)學(xué)習(xí)率方案,允許我們的模型能在 32k 的批大小下收斂。由于我們的模型可以在數(shù)小時(shí)內(nèi)在亞馬遜數(shù)據(jù)集上收斂,并且盡管我們的計(jì)算需求是 128 塊 Tesla V100 GPU,這個(gè)硬件規(guī)模很大,但在商業(yè)上是可行的,這項(xiàng)工作打開了在大多數(shù)商業(yè)應(yīng)用以及深度學(xué)習(xí)研究中實(shí)現(xiàn)大規(guī)模無監(jiān)督 NLP 訓(xùn)練的大門。一個(gè)模型可以一夜之間就在大多數(shù)公開或私人文本數(shù)據(jù)集訓(xùn)練好。

3. 大批量訓(xùn)練

鑒于亞馬遜語料庫的規(guī)模,預(yù)訓(xùn)練大型當(dāng)前最優(yōu)神經(jīng)語言模型是一個(gè)非常耗時(shí)的過程。在單個(gè) GPU 上運(yùn)行這么大的工作負(fù)載不切實(shí)際,因?yàn)楫?dāng)前最優(yōu)模型一般會(huì)比較大,且每個(gè) GPU 能夠承擔(dān)的訓(xùn)練批量大小有限。為了保證有效的訓(xùn)練和遷移大型語言模型,我們使用多 GPU 并行化訓(xùn)練。我們專注于多 GPU 數(shù)據(jù)并行化,這意味著我們?cè)谟?xùn)練過程中將批次分割并分配給多個(gè) GPU。我們沒有使用模型并行化(這種方法把神經(jīng)網(wǎng)絡(luò)分割成多個(gè)處理器),因?yàn)樵摲椒`活性較差,且對(duì)軟件限制較多,不過它仍然是進(jìn)一步并行化的有趣選擇。

我們使用同步數(shù)據(jù)并行化,其中大批量數(shù)據(jù)被均勻分布給所有參與其中的工作進(jìn)程,工作進(jìn)程處理前向和反向傳播、相互通信產(chǎn)生的梯度,以及在獲取新的數(shù)據(jù)批量之前更新模型。鑒于模型大小和通信延遲,數(shù)據(jù)并行化通過可用 GPU 的數(shù)量與批量大小的線性擴(kuò)展來實(shí)現(xiàn)近似線性加速。

為保證任意語言模型的大批量預(yù)訓(xùn)練,明確分析使用基于 RNN 的語言模型進(jìn)行大批量預(yù)訓(xùn)練的效果非常重要。循環(huán)神經(jīng)網(wǎng)絡(luò)的連續(xù)性使得訓(xùn)練過程很難優(yōu)化,因?yàn)?RNN 計(jì)算過程中存在鞍點(diǎn)、局部極小值和數(shù)值不穩(wěn)定性 [35]–[37]。這些復(fù)雜性使得使用 RNN 進(jìn)行大批量訓(xùn)練的分析非常有必要。

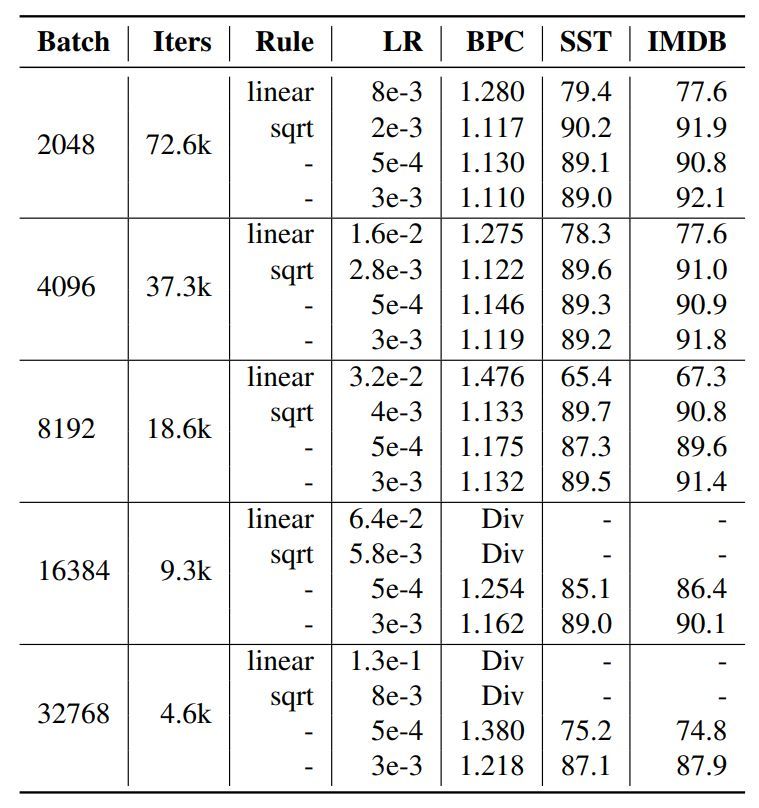

為了保證 RNN 語言模型的大批量訓(xùn)練,我們探索了線性縮放規(guī)則和 Hoffer 等人 [40] 提出的平方根縮放規(guī)則 ?的影響。

4. 混合精度訓(xùn)練

FP16 不僅能減少通信成本,還對(duì)直接加速處理器上的訓(xùn)練起到關(guān)鍵作用,如支持較高吞吐量混合精度運(yùn)算的 V100。V100 的單精度浮點(diǎn)運(yùn)算性能可達(dá) 15.6 TFlops,而混合精度運(yùn)算(FP16 存儲(chǔ)和相乘,F(xiàn)P32 累加)的浮點(diǎn)運(yùn)算性能達(dá)到 125 TFlops。

5. 實(shí)驗(yàn)

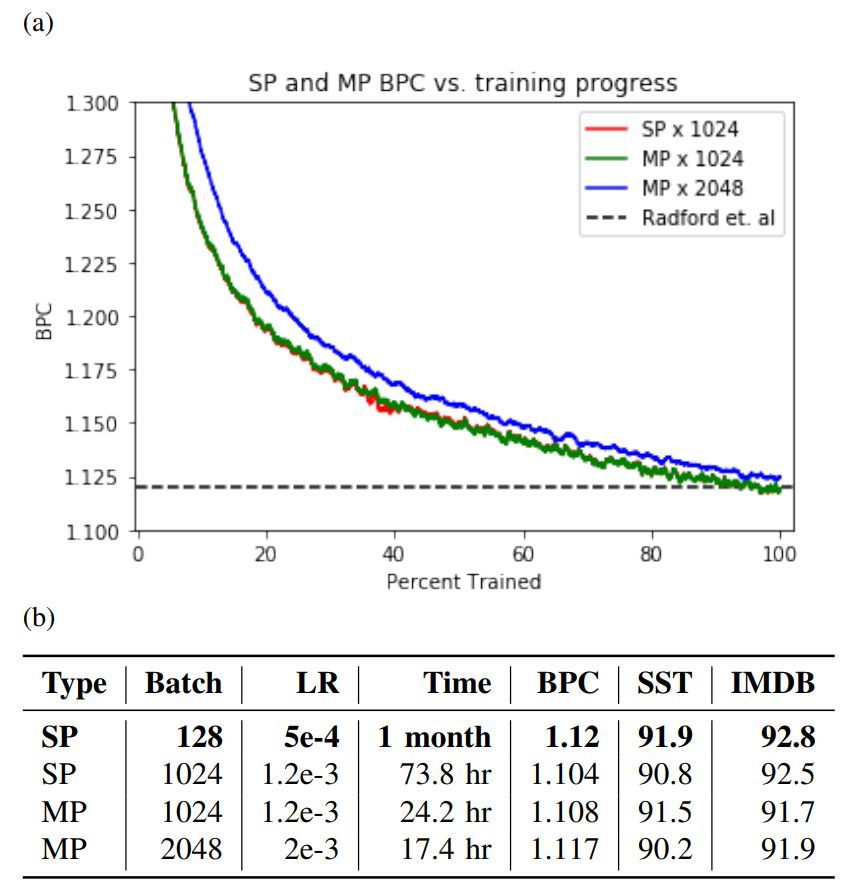

圖 2:a 為混合精度(MP)和單精度(SP)的訓(xùn)練曲線,b 為單精度和混合精度的測(cè)試集評(píng)估對(duì)比,其中評(píng)估指標(biāo)為亞馬遜 BPC 和 Radford 等人實(shí)現(xiàn)的二元情感分類準(zhǔn)確率基線集。

圖 3: a) 亞馬遜評(píng)論數(shù)據(jù)集一次 epoch 的訓(xùn)練時(shí)間與 GPU 數(shù)量具有線性關(guān)系。b) 有(無)無限帶寬的分布式數(shù)據(jù)并行訓(xùn)練的平均每個(gè)迭代次數(shù)和相對(duì)加速度。

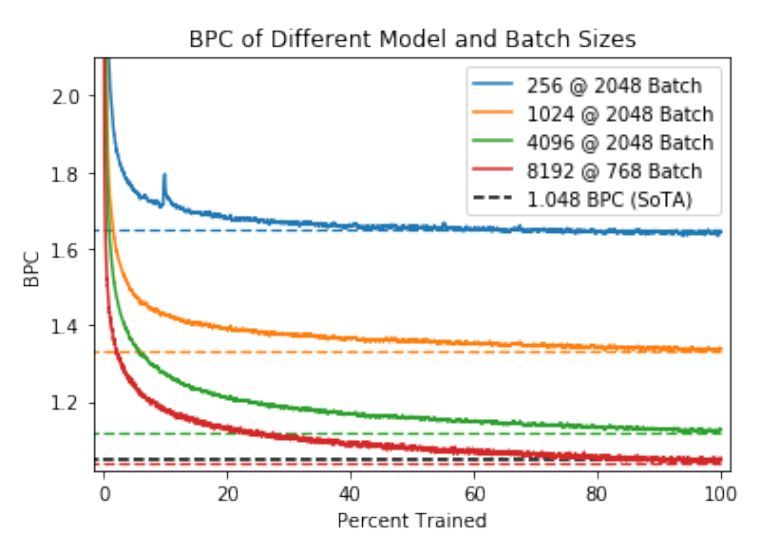

圖 4:在特定維度和批大小的亞馬遜評(píng)論數(shù)據(jù)集上,訓(xùn)練 mLSTM 模型完成一個(gè) epoch 的訓(xùn)練過程。虛線表示經(jīng)過一個(gè) epoch 的訓(xùn)練后的評(píng)估 BPC,以及由 Gray 等人 [34] 得到的當(dāng)前較佳評(píng)估結(jié)果(SoTA)。

圖 5:在多種初始學(xué)習(xí)率下使用 1 epoch 內(nèi)衰減到零的學(xué)習(xí)率方案的評(píng)估結(jié)果。某些初始學(xué)習(xí)率按照基于 128 批大小的 5e-4 衰減率的線性或平方根縮放規(guī)則進(jìn)行縮放。Div 表示訓(xùn)練出現(xiàn)發(fā)散。

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請(qǐng)聯(lián)系小編及時(shí)處理,謝謝!

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4803.html

Apache MXNet v0.12來了。今天凌晨,亞馬遜宣布了MXNet新版本,在這個(gè)版本中,MXNet添加了兩個(gè)重要新特性:支持英偉達(dá)Volta GPU,大幅減少用戶訓(xùn)練和推理神經(jīng)網(wǎng)絡(luò)模型的時(shí)間。在存儲(chǔ)和計(jì)算效率方面支持稀疏張量(Sparse Tensor),讓用戶通過稀疏矩陣訓(xùn)練模型。下面,量子位將分別詳述這兩個(gè)新特性。Tesla V100 加速卡內(nèi)含 Volta GV100 GPU支持英偉...

摘要:深度學(xué)習(xí)是一個(gè)對(duì)算力要求很高的領(lǐng)域。這一早期優(yōu)勢(shì)與英偉達(dá)強(qiáng)大的社區(qū)支持相結(jié)合,迅速增加了社區(qū)的規(guī)模。對(duì)他們的深度學(xué)習(xí)軟件投入很少,因此不能指望英偉達(dá)和之間的軟件差距將在未來縮小。 深度學(xué)習(xí)是一個(gè)對(duì)算力要求很高的領(lǐng)域。GPU的選擇將從根本上決定你的深度學(xué)習(xí)體驗(yàn)。一個(gè)好的GPU可以讓你快速獲得實(shí)踐經(jīng)驗(yàn),而這些經(jīng)驗(yàn)是正是建立專業(yè)知識(shí)的關(guān)鍵。如果沒有這種快速的反饋,你會(huì)花費(fèi)過多時(shí)間,從錯(cuò)誤中吸取教訓(xùn)...

摘要:在經(jīng)歷五年多的落后之后,如今美國(guó)終于在超級(jí)計(jì)算機(jī)領(lǐng)域再度超越中國(guó),重奪頭名桂冠。這一消息在本周于德國(guó)法蘭克福舉行的年度國(guó)際超級(jí)計(jì)算機(jī)大會(huì)上正式公布。在經(jīng)歷五年多的落后之后,如今美國(guó)終于在超級(jí)計(jì)算機(jī)領(lǐng)域再度超越中國(guó),重奪頭名桂冠。這臺(tái)由IBM公司為田納西州橡樹嶺國(guó)家實(shí)驗(yàn)室建造的Summit超級(jí)計(jì)算機(jī)(如上圖所示)在本周一發(fā)布的全球超算五百?gòu)?qiáng)中位列第一(這份榜單每年發(fā)布兩輪,列舉世界上五百臺(tái)最為...

摘要:年月,騰訊機(jī)智機(jī)器學(xué)習(xí)平臺(tái)團(tuán)隊(duì)在數(shù)據(jù)集上僅用分鐘就訓(xùn)練好,創(chuàng)造了訓(xùn)練世界紀(jì)錄。訓(xùn)練期間采用預(yù)定的批量變化方案。如此,我們也不難理解騰訊之后提出的層級(jí)的思想了。你可能覺得這對(duì)于索尼大法而言不算什么,但考慮到維護(hù)成本和占地,這就很不經(jīng)濟(jì)了。 隨著技術(shù)、算力的發(fā)展,在 ImageNet 上訓(xùn)練 ResNet-50 的速度被不斷刷新。2018 年 7 月,騰訊機(jī)智機(jī)器學(xué)習(xí)平臺(tái)團(tuán)隊(duì)在 ImageNet...

摘要:最近,等人對(duì)于英偉達(dá)的四種在四種不同深度學(xué)習(xí)框架下的性能進(jìn)行了評(píng)測(cè)。本次評(píng)測(cè)共使用了種用于圖像識(shí)別的深度學(xué)習(xí)模型。深度學(xué)習(xí)框架和不同網(wǎng)絡(luò)之間的對(duì)比我們使用七種不同框架對(duì)四種不同進(jìn)行,包括推理正向和訓(xùn)練正向和反向。一直是深度學(xué)習(xí)方面最暢銷的。 最近,Pedro Gusm?o 等人對(duì)于英偉達(dá)的四種 GPU 在四種不同深度學(xué)習(xí)框架下的性能進(jìn)行了評(píng)測(cè)。本次評(píng)測(cè)共使用了 7 種用于圖像識(shí)別的深度學(xué)習(xí)模...

閱讀 2101·2021-11-19 09:58

閱讀 1700·2021-11-15 11:36

閱讀 2867·2019-08-30 15:54

閱讀 3382·2019-08-29 15:07

閱讀 2759·2019-08-26 11:47

閱讀 2804·2019-08-26 10:11

閱讀 2495·2019-08-23 18:22

閱讀 2743·2019-08-23 17:58