資訊專欄INFORMATION COLUMN

摘要:康納爾大學(xué)數(shù)學(xué)博士博士后則認(rèn)為,圖神經(jīng)網(wǎng)絡(luò)可能解決圖靈獎(jiǎng)得主指出的深度學(xué)習(xí)無法做因果推理的核心問題。圖靈獎(jiǎng)得主深度學(xué)習(xí)的因果推理之殤年初,承接有關(guān)深度學(xué)習(xí)煉金術(shù)的辯論,深度學(xué)習(xí)又迎來了一位重要的批評(píng)者。

作為行業(yè)的標(biāo)桿,DeepMind的動(dòng)向一直是AI業(yè)界關(guān)注的熱點(diǎn)。最近,這家世界最較高級(jí)的AI實(shí)驗(yàn)室似乎是把他們的重點(diǎn)放在了探索“關(guān)系”上面,6月份以來,接連發(fā)布了好幾篇“帶關(guān)系”的論文,比如:

關(guān)系歸納偏置(Relational inductive bias for physical construction in humans and machines)

關(guān)系深度強(qiáng)化學(xué)習(xí)(Relational Deep Reinforcement Learning)

關(guān)系RNN(Relational Recurrent Neural Networks)

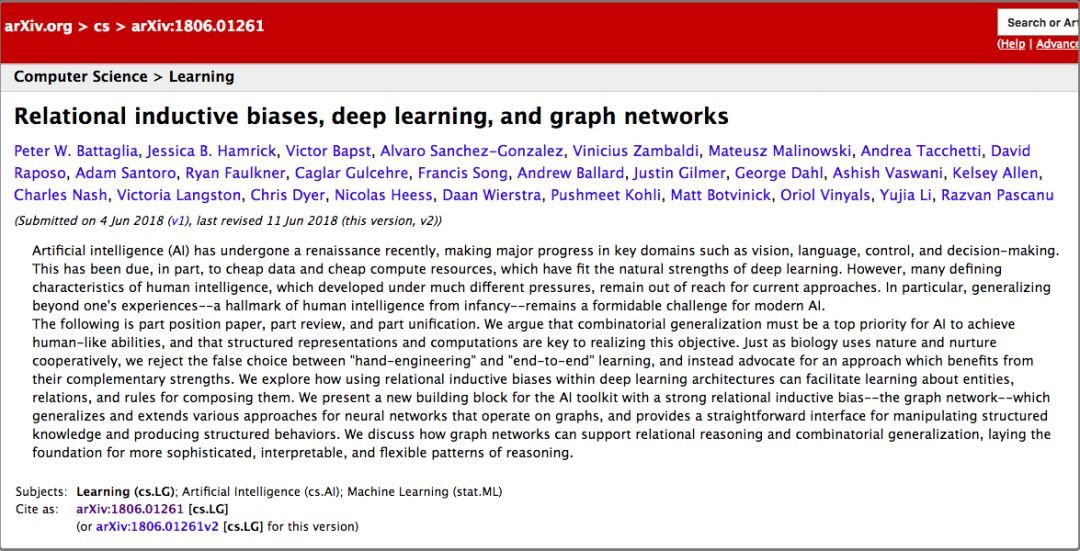

論文比較多,但如果說有哪篇論文最值得看,那么一定選這篇——《關(guān)系歸納偏置、深度學(xué)習(xí)和圖網(wǎng)絡(luò)》。

這篇文章聯(lián)合了DeepMind、谷歌大腦、MIT和愛丁堡大學(xué)的27名作者(其中22人來自DeepMind),用37頁的篇幅,對(duì)關(guān)系歸納偏置和圖網(wǎng)絡(luò)(Graph network)進(jìn)行了全面闡述。

DeepMind的研究科學(xué)家、大牛Oriol Vinyals頗為罕見的在Twitter上宣傳了這項(xiàng)工作(他自己也是其中一位作者),并表示這份綜述“pretty comprehensive”。

有很不少知名的AI學(xué)者也對(duì)這篇文章做了點(diǎn)評(píng)。

曾經(jīng)在谷歌大腦實(shí)習(xí),從事深度強(qiáng)化學(xué)習(xí)研究的Denny Britz說,他很高興看到有人將圖(Graph)的一階邏輯和概率推理結(jié)合到一起,這個(gè)領(lǐng)域或許會(huì)迎來復(fù)興。

芯片公司Graphcore的創(chuàng)始人Chris Gray評(píng)論說,如果這個(gè)方向繼續(xù)下去并真的取得成果,那么將為AI開創(chuàng)一個(gè)比現(xiàn)如今的深度學(xué)習(xí)更加富有前景的基礎(chǔ)。

康納爾大學(xué)數(shù)學(xué)博士/MIT博士后Seth Stafford則認(rèn)為,圖神經(jīng)網(wǎng)絡(luò)(Graph NNs)可能解決圖靈獎(jiǎng)得主Judea Pearl指出的深度學(xué)習(xí)無法做因果推理的核心問題。

開辟一個(gè)比多帶帶的深度學(xué)習(xí)更富有前景的方向

那么,這篇論文是關(guān)于什么的呢?DeepMind的觀點(diǎn)和要點(diǎn)在這一段話里說得非常清楚:

這既是一篇意見書,也是一篇綜述,還是一種統(tǒng)一。我們認(rèn)為,如果AI要實(shí)現(xiàn)人類一樣的能力,必須將組合泛化(combinatorial generalization)作為重中之重,而結(jié)構(gòu)化的表示和計(jì)算是實(shí)現(xiàn)這一目標(biāo)的關(guān)鍵。

正如生物學(xué)里先天因素和后天因素是共同發(fā)揮作用的,我們認(rèn)為“人工構(gòu)造”(hand-engineering)和“端到端”學(xué)習(xí)也不是只能從中選擇其一,我們主張結(jié)合兩者的優(yōu)點(diǎn),從它們的互補(bǔ)優(yōu)勢(shì)中受益。

在論文里,作者探討了如何在深度學(xué)習(xí)結(jié)構(gòu)(比如全連接層、卷積層和遞歸層)中,使用關(guān)系歸納偏置(relational inductive biases),促進(jìn)對(duì)實(shí)體、對(duì)關(guān)系,以及對(duì)組成它們的規(guī)則進(jìn)行學(xué)習(xí)。

他們提出了一個(gè)新的AI模塊——圖網(wǎng)絡(luò)(graph network),是對(duì)以前各種對(duì)圖進(jìn)行操作的神經(jīng)網(wǎng)絡(luò)方法的推廣和擴(kuò)展。圖網(wǎng)絡(luò)具有強(qiáng)大的關(guān)系歸納偏置,為操縱結(jié)構(gòu)化知識(shí)和生成結(jié)構(gòu)化行為提供了一個(gè)直接的界面。

作者還討論了圖網(wǎng)絡(luò)如何支持關(guān)系推理和組合泛化,為更復(fù)雜、可解釋和靈活的推理模式打下基礎(chǔ)。

圖靈獎(jiǎng)得主Judea Pearl:深度學(xué)習(xí)的因果推理之殤

2018年初,承接NIPS 2017有關(guān)“深度學(xué)習(xí)煉金術(shù)”的辯論,深度學(xué)習(xí)又迎來了一位重要的批評(píng)者。

圖靈獎(jiǎng)得主、貝葉斯網(wǎng)絡(luò)之父Judea Pearl,在ArXiv發(fā)布了他的論文《機(jī)器學(xué)習(xí)理論障礙與因果革命七大火花》,論述當(dāng)前機(jī)器學(xué)習(xí)理論局限,并給出來自因果推理的7大啟發(fā)。Pearl指出,當(dāng)前的機(jī)器學(xué)習(xí)系統(tǒng)幾乎完全以統(tǒng)計(jì)學(xué)或盲模型的方式運(yùn)行,不能作為強(qiáng)AI的基礎(chǔ)。他認(rèn)為突破口在于“因果革命”,借鑒結(jié)構(gòu)性的因果推理模型,能對(duì)自動(dòng)化推理做出獨(dú)特貢獻(xiàn)。

在最近的一篇訪談中,Pearl更是直言,當(dāng)前的深度學(xué)習(xí)不過只是“曲線擬合”(curve fitting)。“這聽起來像是褻瀆……但從數(shù)學(xué)的角度,無論你操縱數(shù)據(jù)的手段有多高明,從中讀出來多少信息,你做的仍舊只是擬合一條曲線罷了。”?

DeepMind的提議:把傳統(tǒng)的貝葉斯因果網(wǎng)絡(luò)和知識(shí)圖譜,與深度強(qiáng)化學(xué)習(xí)融合

如何解決這個(gè)問題?DeepMind認(rèn)為,要從“圖網(wǎng)絡(luò)”入手。

大數(shù)醫(yī)達(dá)創(chuàng)始人、CMU博士鄧侃為我們解釋了DeepMind這篇論文的研究背景。

鄧侃博士介紹,機(jī)器學(xué)習(xí)界有三個(gè)主要學(xué)派,符號(hào)主義(Symbolicism)、連接主義(Connectionism)、行為主義(Actionism)。

符號(hào)主義的起源,注重研究知識(shí)表達(dá)和邏輯推理。經(jīng)過幾十年的研究,目前這一學(xué)派的主要成果,一個(gè)是貝葉斯因果網(wǎng)絡(luò),另一個(gè)是知識(shí)圖譜。

貝葉斯因果網(wǎng)絡(luò)的旗手是 Judea Pearl 教授,2011年的圖靈獎(jiǎng)獲得者。但是據(jù)說 2017年 NIPS 學(xué)術(shù)會(huì)議上,老爺子演講時(shí),聽眾寥寥。2018年,老爺子出版了一本新書,“The Book of Why”,為因果網(wǎng)絡(luò)辯護(hù),同時(shí)批判深度學(xué)習(xí)缺乏嚴(yán)謹(jǐn)?shù)倪壿嬐评磉^程。而知識(shí)圖譜主要由搜索引擎公司,包括谷歌、微軟、百度推動(dòng),目標(biāo)是把搜索引擎,由關(guān)鍵詞匹配,推進(jìn)到語義匹配。

連接主義的起源是仿生學(xué),用數(shù)學(xué)模型來模仿神經(jīng)元。Marvin Minsky 教授因?yàn)閷?duì)神經(jīng)元研究的推動(dòng),獲得了1969年圖靈獎(jiǎng)。把大量神經(jīng)元拼裝在一起,就形成了深度學(xué)習(xí)模型,深度學(xué)習(xí)的旗手是 Geoffrey Hinton 教授。深度學(xué)習(xí)模型最遭人詬病的缺陷,是不可解釋。

行為主義把控制論引入機(jī)器學(xué)習(xí),最著名的成果是強(qiáng)化學(xué)習(xí)。強(qiáng)化學(xué)習(xí)的旗手是 Richard Sutton 教授。近年來Google DeepMind 研究員,把傳統(tǒng)強(qiáng)化學(xué)習(xí),與深度學(xué)習(xí)融合,實(shí)現(xiàn)了 AlphaGo,戰(zhàn)勝當(dāng)今世界所有人類圍棋高手。

DeepMind 前天發(fā)表的這篇論文,提議把傳統(tǒng)的貝葉斯因果網(wǎng)絡(luò)和知識(shí)圖譜,與深度強(qiáng)化學(xué)習(xí)融合,并梳理了與這個(gè)主題相關(guān)的研究進(jìn)展。

DeepMind提出的“圖網(wǎng)絡(luò)”究竟是什么

在這里,有必要對(duì)說了這么多的“圖網(wǎng)絡(luò)”做一個(gè)比較詳細(xì)的介紹。當(dāng)然,你也可以跳過這一節(jié),直接看后面的解讀。

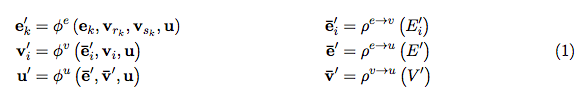

在《關(guān)系歸納偏置、深度學(xué)習(xí)和圖網(wǎng)絡(luò)》這篇論文里,作者詳細(xì)解釋了他們的“圖網(wǎng)絡(luò)”。圖網(wǎng)絡(luò)(GN)的框架定義了一類用于圖形結(jié)構(gòu)表示的關(guān)系推理的函數(shù)。GN 框架概括并擴(kuò)展了各種的圖神經(jīng)網(wǎng)絡(luò)、MPNN、以及 NLNN 方法,并支持從簡(jiǎn)單的構(gòu)建塊(building blocks)來構(gòu)建復(fù)雜的結(jié)構(gòu)。

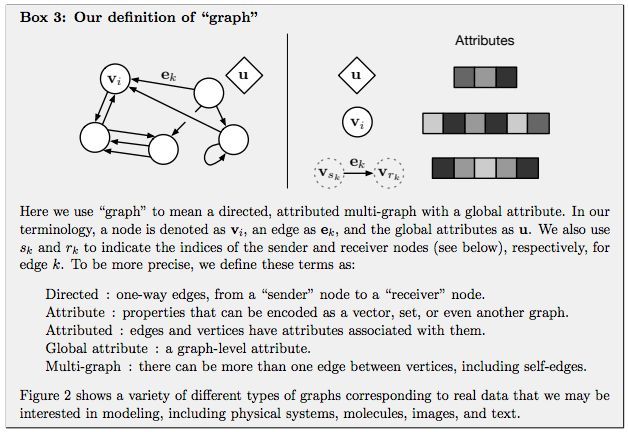

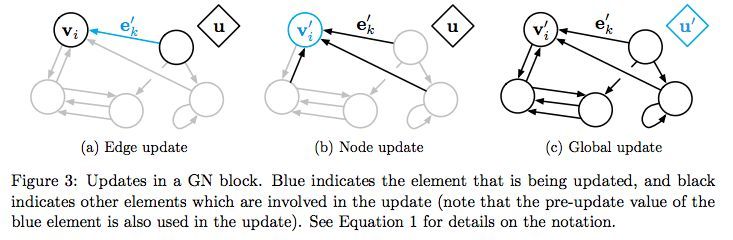

GN 框架的主要計(jì)算單元是 GN block,即 “graph-to-graph” 模塊,它將 graph 作為輸入,對(duì)結(jié)構(gòu)執(zhí)行計(jì)算,并返回 graph 作為輸出。如下面的 Box 3 所描述的,entity 由 graph 的節(jié)點(diǎn)(nodes),邊的關(guān)系(relations)以及全局屬性(global attributes)表示。

論文作者用 “graph” 表示具有全局屬性的有向(directed)、有屬性(attributed)的 multi-graph。一個(gè)節(jié)點(diǎn)(node)表示為,一條邊(edge)表示為,全局屬性(global attributes)表示為u。和表示發(fā)送方(sender)和接收方(receiver)節(jié)點(diǎn)的指標(biāo)(indices)。具體如下:

Directed:?jiǎn)蜗颍瑥?“sender” 節(jié)點(diǎn)指向 “receiver” 節(jié)點(diǎn)。

Attribute:屬性,可以編碼為矢量(vector),集合(set),甚至另一個(gè)圖(graph)

Attributed:邊和頂點(diǎn)具有與它們相關(guān)的屬性

Global attribute:graph-level 的屬性

Multi-graph:頂點(diǎn)之間有多個(gè)邊

GN 框架的 block 的組織強(qiáng)調(diào)可定制性,并綜合表示所需關(guān)系歸納偏置(inductive biases)的新架構(gòu)。

用一個(gè)例子來更具體地解釋 GN。考慮在任意引力場(chǎng)中預(yù)測(cè)一組橡膠球的運(yùn)動(dòng),它們不是相互碰撞,而是有一個(gè)或多個(gè)彈簧將它們與其他球(或全部球)連接起來。我們將在下文的定義中引用這個(gè)運(yùn)行示例,以說明圖形表示和對(duì)其進(jìn)行的計(jì)算。

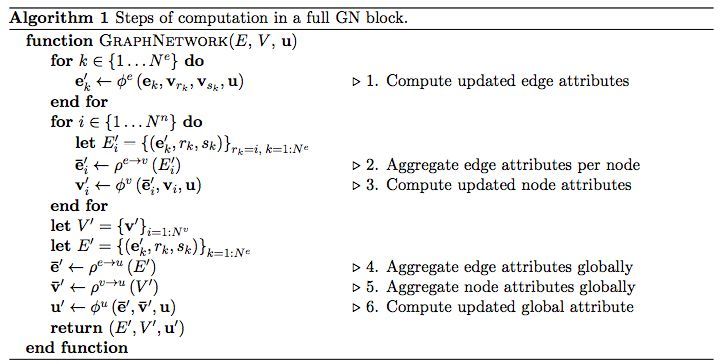

算法 1:一個(gè)完整的 GN block 的計(jì)算步驟

其中:

圖:GN block 中的 Updates。藍(lán)色表示正在 update 的元素,黑色表示 update 中涉及的其他元素

把知識(shí)圖譜和深度學(xué)習(xí)相結(jié)合的難點(diǎn)

要把知識(shí)圖譜和深度學(xué)習(xí)相結(jié)合,鄧侃博士認(rèn)為有幾大難點(diǎn)。

1. 點(diǎn)向量:

?知識(shí)圖譜由點(diǎn)和邊構(gòu)成,點(diǎn)(node)用來表征實(shí)體(entity),實(shí)體又包含屬性(attribute)和屬性的值(value)。傳統(tǒng)知識(shí)圖譜中的實(shí)體,通常由概念符號(hào)構(gòu)成,譬如自然語言的詞匯。

?

傳統(tǒng)知識(shí)圖譜中的邊,連接兩個(gè)單點(diǎn),也就是兩個(gè)實(shí)體,邊表達(dá)的是關(guān)系,關(guān)系的強(qiáng)弱,由權(quán)重表達(dá),傳統(tǒng)知識(shí)圖譜的邊的權(quán)重,通常是常數(shù)。

?

如果想把傳統(tǒng)知識(shí)圖譜與深度學(xué)習(xí)相融合,首先要做的是實(shí)現(xiàn)點(diǎn)的可微分化。用數(shù)值化的詞向量來替代自然語言的詞匯,是實(shí)現(xiàn)點(diǎn)的可微分化的有效方法,通常的做法是用語言模型來分析大量的文本,給每個(gè)詞匯找到最貼合上下文語義的詞向量。但在圖譜中,傳統(tǒng)的詞向量的生成算法,不十分奏效,需要改造。

?

2. 超點(diǎn):

前文說到,傳統(tǒng)知識(shí)圖譜中的邊,連接兩個(gè)單點(diǎn),表達(dá)兩個(gè)單點(diǎn)之間的關(guān)系。這個(gè)假定制約了圖譜的表達(dá)能力,因?yàn)樵诤芏鄨?chǎng)景下,多個(gè)單點(diǎn)組合在一起,才與其它單點(diǎn)或者單點(diǎn)組合,存在關(guān)系。我們把單點(diǎn)組合,稱之為超點(diǎn)(hyper-node)。

?

問題是哪些單點(diǎn)組合在一起構(gòu)成超點(diǎn)?人為的先驗(yàn)指定,當(dāng)然是一個(gè)辦法。從大量訓(xùn)練數(shù)據(jù)中,通過 dropout 或者 regulation 算法,自動(dòng)學(xué)習(xí)出超點(diǎn)的構(gòu)成,也是一個(gè)思路。

?

3. 超邊:

傳統(tǒng)的知識(shí)圖譜中的邊,表達(dá)了點(diǎn)與點(diǎn)之間的關(guān)系,關(guān)系的強(qiáng)弱由權(quán)重表達(dá),通常權(quán)重是個(gè)常數(shù)。但在很多場(chǎng)景下,權(quán)重并非是常數(shù)。隨著點(diǎn)的取值不同,邊的權(quán)重也發(fā)生變化,而且很可能是非線性變化。

?

用非線性函數(shù)來表達(dá)圖譜的邊,稱為超邊(hyper-edge)。

深度學(xué)習(xí)模型可以用于模擬非線性函數(shù)。所以,知識(shí)圖譜中每條邊都是一個(gè)深度學(xué)習(xí)模型。模型的輸入是若干個(gè)單點(diǎn)組成的超點(diǎn),模型的輸出是另一個(gè)超點(diǎn)。如果把每個(gè)深度學(xué)習(xí)模型,視為一棵樹,根是輸入,葉子是輸出。那么鳥瞰整個(gè)知識(shí)圖譜,實(shí)際上是深度學(xué)習(xí)模型的森林。

?

4. 路徑:?

訓(xùn)練知識(shí)圖譜,包括訓(xùn)練點(diǎn)向量,超點(diǎn)、和超邊的時(shí)候,一條訓(xùn)練數(shù)據(jù)往往是在圖譜中行走的一條路徑,通過擬合海量的路徑,獲得最貼切的點(diǎn)向量、超點(diǎn)和超邊。

?

用擬合路徑來訓(xùn)練圖譜,存在的一個(gè)問題是,訓(xùn)練過程與過程結(jié)束后的評(píng)價(jià),兩者的脫節(jié)。打個(gè)比方,給你若干篇文章的提綱,以及相應(yīng)的范文,讓你學(xué)習(xí)如何寫作文。擬合的過程,強(qiáng)調(diào)逐字逐句的模仿。但是評(píng)價(jià)文章的好壞,重點(diǎn)并不在于字句的亦步亦趨,而在于通篇文章的順暢。

?

如何解決訓(xùn)練過程與最終評(píng)價(jià)的脫節(jié)?很有潛力的辦法,是用強(qiáng)化學(xué)習(xí)。強(qiáng)化學(xué)習(xí)的精髓,在于把最終的評(píng)價(jià),通過回溯和折現(xiàn)的方法,給路徑過程中每一個(gè)中間狀態(tài),評(píng)估它的潛力。

?

但是強(qiáng)化學(xué)習(xí)面臨的困難,在于中間狀態(tài)的數(shù)量不可太多。當(dāng)狀態(tài)數(shù)量太多時(shí),強(qiáng)化學(xué)習(xí)的訓(xùn)練過程,無法收斂。解決收斂問題的辦法,是用一個(gè)深度學(xué)習(xí)模型,來估算所有狀態(tài)的潛力值。換句話說,不需要估算所有狀態(tài)的潛力值,而只需要訓(xùn)練一個(gè)模型的有限參數(shù)。

?

DeepMind 前天發(fā)表的這篇文章,提議把深度強(qiáng)化學(xué)習(xí)與知識(shí)圖譜等相融合,并梳理了大量的相關(guān)研究。但是,論文并沒有明確說明 DeepMind 偏向于哪一種具體方案。

?

或許,針對(duì)不同應(yīng)用場(chǎng)景會(huì)有不同方案,并沒有通用的較佳方案。

圖譜深度學(xué)習(xí)是下一個(gè)AI算法的熱點(diǎn)?

許多重要的現(xiàn)實(shí)世界數(shù)據(jù)集都是以圖或網(wǎng)絡(luò)的形式出現(xiàn),比如社交網(wǎng)絡(luò)、知識(shí)圖譜,萬維網(wǎng)等等。 目前,已有越來越多的研究者開始關(guān)注神經(jīng)網(wǎng)絡(luò)模型對(duì)這種結(jié)構(gòu)化數(shù)據(jù)集的處理。

結(jié)合DeepMind、谷歌大腦等發(fā)表的一系列的關(guān)于圖深度學(xué)習(xí)的論文,是否預(yù)示“圖深度學(xué)習(xí)”是下一個(gè)AI算法熱點(diǎn)?

總之,先從這篇論文看起吧。

地址:https://arxiv.org/pdf/1806.01261.pdf

參考資料

Judea Pearl采訪:https://www.quantamagazine.org/to-build-truly-intelligent-machines-teach-them-cause-and-effect-20180515/

圖卷積網(wǎng)絡(luò):http://tkipf.github.io/graph-convolutional-networks/

關(guān)系RNN:https://arxiv.org/pdf/1806.01822v1.pdf

關(guān)系深度強(qiáng)化學(xué)習(xí):https://arxiv.org/abs/1806.01830

關(guān)系歸納偏置https://arxiv.org/pdf/1806.01203.pdf

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4770.html

摘要:是一名來自牛津大學(xué)的擁有高聲望和優(yōu)良業(yè)界口碑的機(jī)器學(xué)習(xí)教授。在年拿到的博士學(xué)位后,至年他在擔(dān)任博后,至年在擔(dān)任教授,他還是加拿大高級(jí)科研學(xué)會(huì)的一員,并拿到了許多學(xué)術(shù)類的獎(jiǎng)項(xiàng)。年月日,加入了由管理的平臺(tái)。 Nando de FreitasNando de Freitas是一名來自牛津大學(xué)的擁有高聲望和優(yōu)良業(yè)界口碑的機(jī)器學(xué)習(xí)教授。在2000年拿到Trinity College的博士學(xué)位后,199...

摘要:我的核心觀點(diǎn)是盡管我提出了這么多問題,但我不認(rèn)為我們需要放棄深度學(xué)習(xí)。對(duì)于層級(jí)特征,深度學(xué)習(xí)是非常好,也許是有史以來效果較好的。認(rèn)為有問題的是監(jiān)督學(xué)習(xí),并非深度學(xué)習(xí)。但是,其他監(jiān)督學(xué)習(xí)技術(shù)同病相連,無法真正幫助深度學(xué)習(xí)。 所有真理必經(jīng)過三個(gè)階段:第一,被嘲笑;第二,被激烈反對(duì);第三,被不證自明地接受。——叔本華(德國(guó)哲學(xué)家,1788-1860)在上篇文章中(參見:打響新年第一炮,Gary M...

摘要:我仍然用了一些時(shí)間才從神經(jīng)科學(xué)轉(zhuǎn)向機(jī)器學(xué)習(xí)。當(dāng)我到了該讀博的時(shí)候,我很難在的神經(jīng)科學(xué)和的機(jī)器學(xué)習(xí)之間做出選擇。 1.你學(xué)習(xí)機(jī)器學(xué)習(xí)的歷程是什么?在學(xué)習(xí)機(jī)器學(xué)習(xí)時(shí)你最喜歡的書是什么?你遇到過什么死胡同嗎?我學(xué)習(xí)機(jī)器學(xué)習(xí)的道路是漫長(zhǎng)而曲折的。讀高中時(shí),我興趣廣泛,大部分和數(shù)學(xué)或科學(xué)沒有太多關(guān)系。我用語音字母表編造了我自己的語言,我參加了很多創(chuàng)意寫作和文學(xué)課程。高中畢業(yè)后,我進(jìn)了大學(xué),盡管我不想去...

摘要:文本谷歌神經(jīng)機(jī)器翻譯去年,谷歌宣布上線的新模型,并詳細(xì)介紹了所使用的網(wǎng)絡(luò)架構(gòu)循環(huán)神經(jīng)網(wǎng)絡(luò)。目前唇讀的準(zhǔn)確度已經(jīng)超過了人類。在該技術(shù)的發(fā)展過程中,谷歌還給出了新的,它包含了大量的復(fù)雜案例。谷歌收集該數(shù)據(jù)集的目的是教神經(jīng)網(wǎng)絡(luò)畫畫。 1. 文本1.1 谷歌神經(jīng)機(jī)器翻譯去年,谷歌宣布上線 Google Translate 的新模型,并詳細(xì)介紹了所使用的網(wǎng)絡(luò)架構(gòu)——循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)。關(guān)鍵結(jié)果:與...

閱讀 3023·2021-09-22 15:52

閱讀 2902·2019-08-30 15:55

閱讀 2699·2019-08-30 15:53

閱讀 2453·2019-08-30 13:21

閱讀 1620·2019-08-30 13:10

閱讀 2481·2019-08-26 12:09

閱讀 2563·2019-08-26 10:33

閱讀 1801·2019-08-23 18:06