資訊專欄INFORMATION COLUMN

摘要:讓我們簡要介紹一下不同類型的卷積以及它們的優(yōu)點。反卷積,一些別的文章中把這個操作稱為解卷積,但這是不恰當?shù)模驗檫@不是一個解卷積過程。反卷積有點類似,因為它產生了假想的解卷積所能達到的相同的空間分辨率。反卷積執(zhí)行卷積,但恢復其空間變換。

讓我們簡要介紹一下不同類型的卷積以及它們的優(yōu)點。為了簡單起見,我們只關注二維卷積。

卷積首先我們需要定義一些卷積層的參數(shù)。

卷積核大小(Kernel Size):卷積核定義了卷積的大小范圍,二維卷積核最常見的就是 3*3 的卷積核。

步長(Stride):步長定義了當卷積核在圖像上面進行卷積操作的時候,每次卷積跨越的長度。在默認情況下,步長通常為 1,但我們也可以采用步長是 2 的下采樣過程,類似于 MaxPooling 操作。

填充(Padding):填充定義了如何處理樣本的邊界。(半)填充卷積將保持輸入空間和輸出空間相等,如果卷積核的維度大于 1,那么如果不進行填充,最后輸出圖的尺寸會比輸入圖的小。

輸入和輸出管道(Input & Output Channels):卷積層采用一定數(shù)量的輸入通道(I),并且設計特定數(shù)量的輸出通道(O)。每一層所需的參數(shù)可以通過 I*O*K 來進行計算,其中 K 等于卷積核的數(shù)量。

擴張卷積(空洞卷積,Dilated Convolution,atrous convolutions)

擴張卷積是在卷積層中加入了另一個參數(shù) —— 擴張率。這定義了卷積核中值與值之間的間距。擴張率為 2 的 33 的卷積核與 55 的卷積核具有相同的事業(yè),而僅使用了 9 個參數(shù)。你可以想象一下,使用 5*5 的卷積核并且刪除第二行,第四行,第二列和第四列的數(shù)據(jù),那么就是我們所介紹的卷積核了。

這以相同的計算成本,但是提供了更廣泛的視野。擴張卷積在實時分割領域是特別受歡迎的。如果你需要更大的視野,但是無法承受多個卷積核所帶來的計算成本,那么你可以考慮使用這個。

反卷積(Transposed Convolutions,deconvolutions or fractionally strided convolutions)

一些別的文章中把這個操作稱為解卷積(deconvolution),但這是不恰當?shù)模驗檫@不是一個解卷積過程。更糟糕的是,解卷積過程卻是真的。但是他們在深度學習領域并不常見。實際的解卷積將恢復卷積過程。想象一下,將圖像輸入到單個卷積圖中。現(xiàn)在把輸出結果拿出來,然后把它丟入一個黑盒子中,然后再次出來的圖像就是原始圖。這個黑盒子就是一個解卷積過程。這是卷積層所做的數(shù)學逆運算。

反卷積有點類似,因為它產生了假想的解卷積所能達到的相同的空間分辨率。但是,對這些值執(zhí)行的實際數(shù)學運算是不同的。反卷積執(zhí)行卷積,但恢復其空間變換。

此時,你可能有點困惑,所以我們來看一個具體的例子。我們把 55 的圖像進行卷積,所采用的卷積核是 33,步長是 2,無填充。那么,最后我們將得到的結果是一個 2*2 的圖像。

如果,我們想要逆轉這個過程,我們需要反向進行數(shù)學運算,以便從我們輸入的每個像素生成 9 個像素值。之后,我們用 2 的步長遍歷這個輸出圖像。這就是一個解卷積過程。

反卷積不會這樣做。共同的是它最后得到的是一個 5*5 的圖像。為了是吸納這個目的,我們需要再輸入上執(zhí)行一些奇怪的填充。

正如你現(xiàn)在想象的那樣,這一步不會實現(xiàn)上面我們說的解卷積過程,至少不會涉及到數(shù)學計算。

它只是重建從前的空間并執(zhí)行卷積,這可能不是數(shù)學上的逆轉,但對于編碼器 - 解碼器架構,它仍然非常有用的。通過這種方式,我們可以將圖像的放大和卷積相結合,而不是執(zhí)行兩個多帶帶的過程。

可分離卷積(Separable Convolutions)

在一個可分離的卷積中,我們可以將卷積核分成多個步驟。我們將卷積表示為 y = conv(x, k) ,其中 y 是輸出圖像,x 是輸入圖像,k 是卷積核。簡單的說,接下來,我們假設 k 可以通過這樣來進行計算:k = k1.dot(k2)。這將使它成為了一個可以分離的卷積操作,因為不是用 k 進行的二維卷積,而是通過用 k1 和 k2 進行 2 次卷積得到相同的結果。

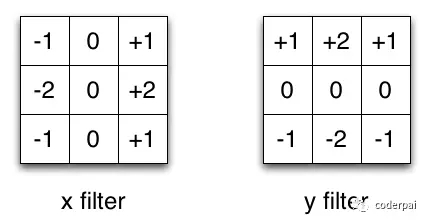

以 Sobel 內核為例,這在圖像處理中經常使用。你可以通過乘以矢量 [1, 0, -1] 和 [1, 2, 1].T 得到相同的內核。在做同樣的操作時,這將需要 6 個而不是 9 個參數(shù)。這個例子展示了我所知道的一種控件可分離卷積,它不用于深度學習。

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報表系統(tǒng)等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4747.html

摘要:近幾年,深度學習高速發(fā)展,出現(xiàn)了大量的新模型與架構,以至于我們無法理清網絡類型之間的關系。是由深度學習先驅等人提出的新一代神經網絡形式,旨在修正反向傳播機制。當多個預測一致時本論文使用動態(tài)路由使預測一致,更高級別的將變得活躍。 近幾年,深度學習高速發(fā)展,出現(xiàn)了大量的新模型與架構,以至于我們無法理清網絡類型之間的關系。在這篇文章中,香港科技大學(HKUST)助理教授金成勳總結了深度網絡類型之間...

摘要:在嵌入式系統(tǒng)上的深度學習隨著人工智能幾乎延伸至我們生活的方方面面,主要挑戰(zhàn)之一是將這種智能應用到小型低功耗設備上。領先的深度學習框架我們來詳細了解下和這兩個領先的框架。適用性用于圖像分類,但并非針對其他深度學習的應用,例如文本或聲音。 在嵌入式系統(tǒng)上的深度學習隨著人工智能 (AI) 幾乎延伸至我們生活的方方面面,主要挑戰(zhàn)之一是將這種智能應用到小型、低功耗設備上。這需要嵌入式平臺,能夠處理高性...

摘要:以下為譯文年夏天,我在網絡音樂平臺紐約實習,致力于使用卷積神經網絡做基于內容的音樂推薦。深度學習預測聽眾喜好基于音頻信號的音樂推薦。深度學習預測聽眾喜好去年十二月,我和同事在上發(fā)表了一篇關于這個主題的論文,題目是基于內容的深度音樂推薦。 本文是比利時根特大學(Ghent University)的Reservoir Lab實驗室博士研究生Sander Dieleman所撰寫的博客文章,他的研究...

閱讀 1270·2021-11-15 18:14

閱讀 3127·2021-08-25 09:38

閱讀 2663·2019-08-30 10:55

閱讀 2673·2019-08-29 16:39

閱讀 1305·2019-08-29 15:07

閱讀 2446·2019-08-29 14:14

閱讀 810·2019-08-29 12:36

閱讀 909·2019-08-29 11:21