資訊專欄INFORMATION COLUMN

摘要:膠囊網(wǎng)絡(luò)是一種熱門的新型神經(jīng)網(wǎng)絡(luò)架構(gòu),它可能會(huì)對(duì)深度學(xué)習(xí)特別是計(jì)算機(jī)視覺領(lǐng)域產(chǎn)生深遠(yuǎn)的影響。下幾層膠囊也嘗試檢測對(duì)象及其姿態(tài),但工作方式非常不同,即使用按協(xié)議路由算法。

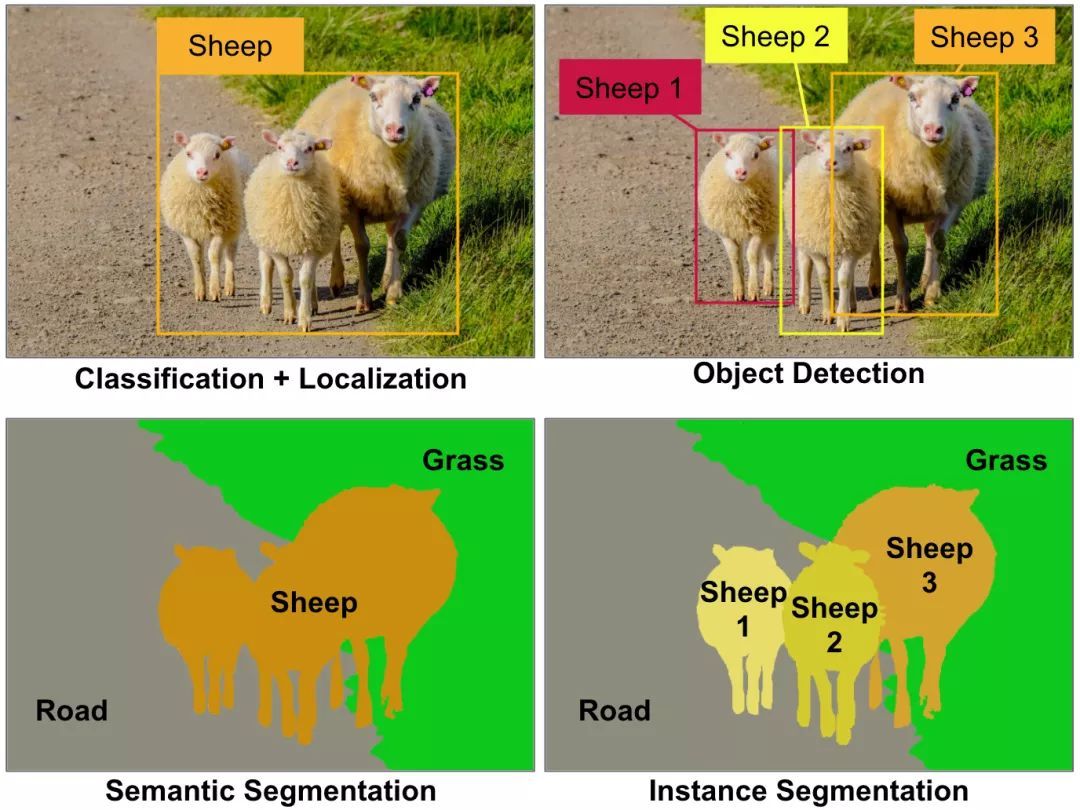

膠囊網(wǎng)絡(luò)(Capsule networks, CapsNets)是一種熱門的新型神經(jīng)網(wǎng)絡(luò)架構(gòu),它可能會(huì)對(duì)深度學(xué)習(xí)特別是計(jì)算機(jī)視覺領(lǐng)域產(chǎn)生深遠(yuǎn)的影響。等一下,難道計(jì)算機(jī)視覺問題還沒有被很好地解決嗎?卷積神經(jīng)網(wǎng)絡(luò)(Convolutional neural networks, CNNs)已在分類、定位、物體檢測、語義分割或?qū)嵗指畹雀鞣N計(jì)算機(jī)視覺任務(wù)中達(dá)到了超人類水平,難道我們所有人沒有注意到這些難以置信的例子嗎?(見圖1)

圖1 一些主要的計(jì)算機(jī)視覺任務(wù)。現(xiàn)今,這些計(jì)算機(jī)視覺任務(wù)都需要不同的卷積神經(jīng)網(wǎng)絡(luò)架構(gòu),如用于分類的ResNet架構(gòu),用于目標(biāo)檢測的YOLO架構(gòu),用于語義分析的掩模R-CNN架構(gòu),等等。圖像由AurélienGéron提供。

是的,我們已經(jīng)看到了令人難以置信的CNNs,但是:

這些CNNs都接受了數(shù)量巨大圖像的訓(xùn)練(或重復(fù)使用了部分已訓(xùn)練過的神經(jīng)網(wǎng)絡(luò))。CapsNets能通過少得多的訓(xùn)練數(shù)據(jù)就可很好地完成網(wǎng)絡(luò)訓(xùn)練。

CNNs不能很好地處理圖像多義性表達(dá)。而膠囊網(wǎng)絡(luò)可以很好處理這一問題,即使在擁擠的場景下也表現(xiàn)出色(盡管CapsNets現(xiàn)在仍與背景糾纏在一起)。

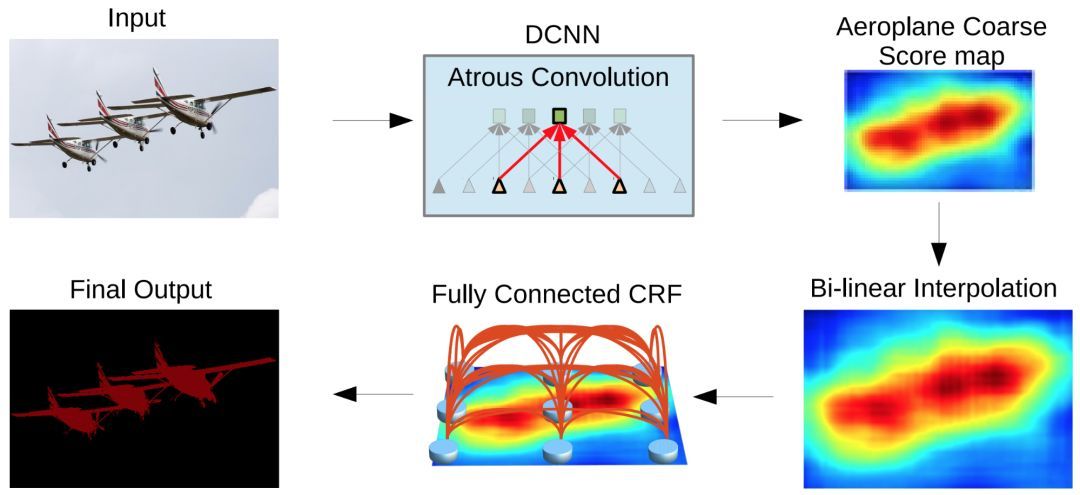

CNNs在池化層丟失大量信息。這些池化層降低了圖像空間分辨率(見圖2),為此,它們的輸出對(duì)輸入端的微小變化是保持不變的。當(dāng)整個(gè)網(wǎng)絡(luò)中細(xì)節(jié)信息必須被保留時(shí),這就是一個(gè)問題,如在語義分割中。目前,解決這個(gè)問題主要是通過在CNNs周圍構(gòu)建復(fù)雜結(jié)構(gòu)來恢復(fù)一些丟失的信息。運(yùn)用CapsNets,詳細(xì)的姿態(tài)信息(如較精確的目標(biāo)位置、旋轉(zhuǎn)、厚度、歪斜、大小等等)在整個(gè)網(wǎng)絡(luò)中都被保留,而不是丟失而后被恢復(fù)過來。輸入的微小變化會(huì)導(dǎo)致輸出的細(xì)微變化——信息卻被保留。這就是所謂的“同變性(equivariance)”。所以,CapsNets對(duì)于不同的視覺任務(wù)可以使用相同的簡單且一致的架構(gòu)。

最后,CNNs需要額外的組件來實(shí)現(xiàn)自動(dòng)識(shí)別一個(gè)部件歸屬于哪一個(gè)對(duì)象(如,這條腿屬于這只羊)。而CapsNets則免費(fèi)提供部件的層次結(jié)構(gòu)。

圖2 DeepLab2圖像分割流程,由Liang-Chieh Chen等提供:可以看到,CNN(右上)的輸出結(jié)果是十分粗糙的,這使得通過增加額外步驟來恢復(fù)丟失的細(xì)節(jié)很有必要。該圖來自Deeplab論文《Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution,and Fully Connected CRFs》,引用得到作者許可。想了解語義分割體系結(jié)構(gòu)的多樣性和復(fù)雜性可以看S. Chilamkurthy所做的這篇好文章。

CapsNets是由Geoffrey Hinton等人于2011年在一篇名為“轉(zhuǎn)換自動(dòng)編碼器(Transforming Autoencoders)”論文中首次提出的。但僅在幾個(gè)月前,也就是2017年11月,Sara Sabour, Nicholas Frosst和Geoffrey Hinton發(fā)表了一篇名為“膠囊間動(dòng)態(tài)路由(Dynamic Routing between Capsules)”的論文,介紹了一個(gè)CapsNets結(jié)構(gòu),在MNIST(手寫數(shù)字圖像的著名數(shù)據(jù)集)上達(dá)到了較好性能,并在MultiMNIST(不同數(shù)字對(duì)重疊形成的變形手寫數(shù)字圖像數(shù)據(jù)集)上獲得了比CNNs好得多的結(jié)果,見圖3。?

圖3 MultiMNIST 圖像(白色) 和CapsNets重構(gòu)圖像 (紅色+綠色)。“R”代表重構(gòu) ,“L”代表標(biāo)簽. 如:這一個(gè)例子預(yù)測(左上)是正確的,重構(gòu)圖像也是正確的。但第5個(gè)例子預(yù)測是錯(cuò)的,(5,0)預(yù)測成了(5,7)。因此,5被正確重構(gòu),而0卻沒有。圖形來自論文《Dynamic routing between capsules》, 引用得到作者許可。

盡管CapsNets具有很多有點(diǎn),但它仍遠(yuǎn)不夠完美。首先,現(xiàn)在CapsNets在如CIFAR10或ImageNet大規(guī)模圖像測試集上的表現(xiàn)不如CNNs好。而且,CapsNets需要大量計(jì)算,不能檢測出相互靠近的同類型的兩個(gè)對(duì)象(這被稱為“擁擠問題”,且已被證明人類也存在這個(gè)問題)。但CapsNets的主要思想還是非常有前途的,似乎只需要一些調(diào)整就可以發(fā)揮全部潛力。畢竟,現(xiàn)在的CNNs是在1998年發(fā)明的,經(jīng)過一些調(diào)整后,就在2012年在ImageNet數(shù)據(jù)集上戰(zhàn)勝了技術(shù)。

那么,CapsNets到底是什么?

簡而言之,CapsNet由膠囊而不是神經(jīng)元組成。膠囊是用于學(xué)習(xí)檢測給定圖像區(qū)域內(nèi)特定對(duì)象(如矩形)的一小組神經(jīng)元,它輸出一個(gè)向量(如一個(gè)8維矢量),該向量的長度表示被檢測對(duì)象存在的估計(jì)概率,而方向(如在8維空間中)對(duì)被檢測對(duì)象的姿態(tài)參數(shù)(如較精確的位置,旋轉(zhuǎn)等)進(jìn)行編碼。如果被檢測對(duì)象發(fā)生稍微改變(如移動(dòng)、旋轉(zhuǎn)、調(diào)整大小等),則膠囊將輸出相同長度的矢量,但方向稍有不同。這樣,膠囊是等變的。

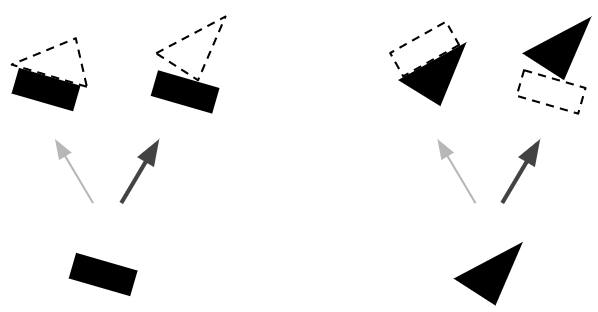

就像常規(guī)的神經(jīng)網(wǎng)絡(luò)一樣,一個(gè)CapsNet也是按多個(gè)層組織的(見圖4)。最下層的膠囊被稱為主膠囊:每個(gè)膠囊都接收?qǐng)D像的一個(gè)小區(qū)域作為輸入(稱其為接受場),嘗試檢測一個(gè)特定模式的存在和姿態(tài),如矩形。更高層的膠囊稱為路由膠囊,檢測更大更復(fù)雜的對(duì)象,如船只。

圖4 兩層膠囊網(wǎng)絡(luò)。這個(gè)例子中,初始膠囊層有兩個(gè)5×5映射,而第二個(gè)膠囊層有兩個(gè)3×3映射。每個(gè)膠囊輸出一個(gè)向量,每個(gè)箭頭符號(hào)表示一個(gè)不同膠囊的輸出,藍(lán)色箭頭符號(hào)表示一個(gè)嘗試檢測三角形的膠囊的輸出,黑色箭頭符號(hào)表示一個(gè)嘗試檢測矩形的膠囊的輸出。圖像由AurélienGéron提供。

主膠囊層采用幾個(gè)常規(guī)的卷基層來實(shí)現(xiàn)。如本文使用兩個(gè)卷基層輸出256個(gè)包含標(biāo)量的6×6特征映射,并將這個(gè)輸出轉(zhuǎn)變成32個(gè)包含8維矢量的6×6映射。最后,使用一個(gè)新穎的壓縮函數(shù)來確保這些向量的長度在0到1之間(表示一個(gè)概率)。這樣就給出了主膠囊的輸出。

下幾層膠囊也嘗試檢測對(duì)象及其姿態(tài),但工作方式非常不同,即使用按協(xié)議路由算法。這就是膠囊網(wǎng)絡(luò)的較大魔力所在。我們來看一個(gè)例子。

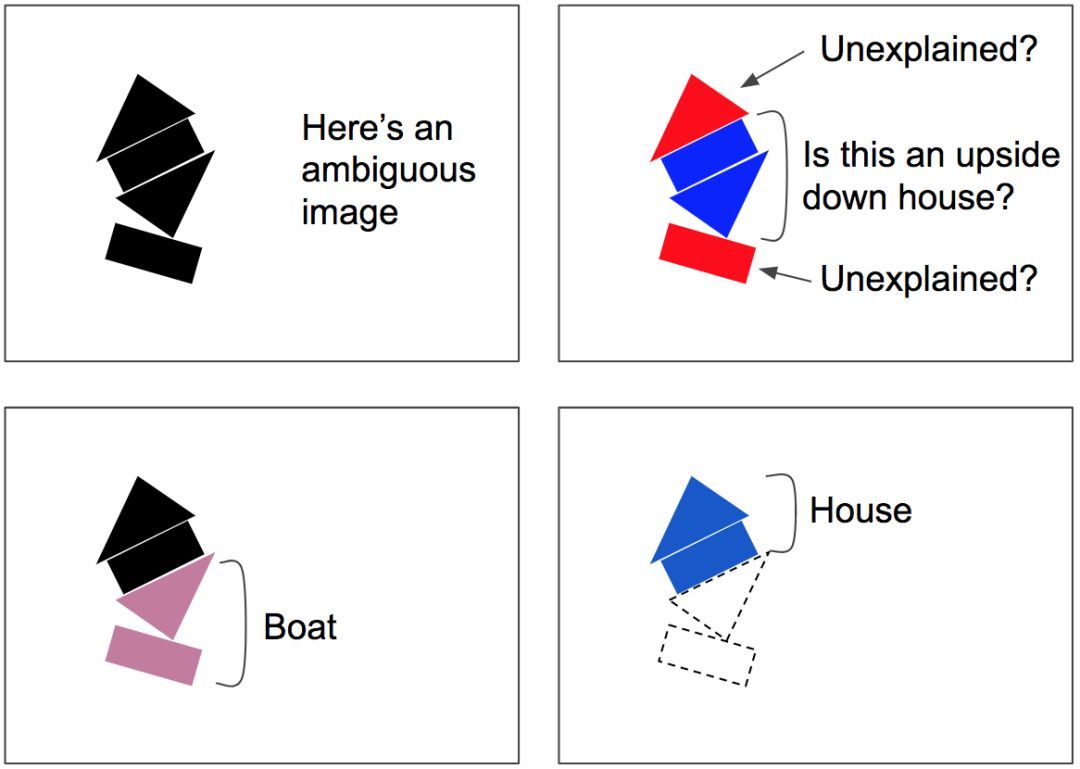

假設(shè)只有兩個(gè)主膠囊:一個(gè)長方形膠囊和一個(gè)三角膠囊,假設(shè)它們都檢測到正在尋找的東西。矩形和三角形都可能是房子或船的一部分(見圖5)。由于長方形的姿態(tài)是略微向右旋轉(zhuǎn)的,房子和船也得是稍微向右旋轉(zhuǎn)。考慮到三角形的姿態(tài),房子就得幾乎是顛倒的,而船會(huì)稍微向右旋轉(zhuǎn)。注意,形狀和整體/部分關(guān)系都是在訓(xùn)練期間學(xué)習(xí)的。現(xiàn)在注意長方形和三角形對(duì)船的姿態(tài)達(dá)成一致,而對(duì)房子的姿態(tài)強(qiáng)烈不一致。所以,矩形和三角形很可能是同一條船的一部分,并沒有房子的存在。

圖5 按協(xié)議路由,第1步—基于存在的部分對(duì)象及其姿態(tài)去預(yù)測對(duì)象及其姿態(tài),而后在預(yù)測結(jié)果之間尋求一致性。圖像由AurélienGéron提供。

既然現(xiàn)在確信長方形和三角形是船的一部分,那么將長方形和三角形膠囊的輸出結(jié)果更多地發(fā)送給船膠囊,而更少發(fā)送給房子膠囊,將更有意義:這樣,船膠囊將接收更有用的輸入信號(hào),而房子膠囊將會(huì)收到較少的噪聲。對(duì)于每個(gè)連接而言,按協(xié)議路由算法包含一個(gè)路由權(quán)重(見圖6):達(dá)成一致時(shí),增大路由權(quán)重;出現(xiàn)分歧時(shí),減少路由權(quán)重。

圖6 按協(xié)議路由,第2步—更新路由權(quán)重。圖像由AurélienGéron提供。

按協(xié)議路由算法包括協(xié)議檢測+路由更新的一些迭代(注意,每次預(yù)測這都會(huì)發(fā)生,不只是一次且也不僅是在訓(xùn)練時(shí)間)。這在擁擠的場景中特別有用:如圖7中,場景是存在歧義的,因?yàn)槟銖闹虚g看到的可能是倒置的房子,但是這會(huì)使底部的矩形和頂部的三角形無法解釋。協(xié)議算法很可能會(huì)給出更好的解釋:底部是一只船,頂部是一個(gè)房子。這種模棱兩可的說法被認(rèn)為是“可解釋過去的”:下面的矩形較好用船的存在來解釋,這也解釋了下面的三角形,一旦這兩個(gè)部分被解釋清楚,剩下的部分就很容易被解釋為一個(gè)房子。

圖7按協(xié)議路由能解析擁擠場景,如可被誤解為顛倒的房子而其他部分無法解釋的存在歧義的圖像。但底部矩形路由給船,同時(shí)底部三角形將也路由給船。一旦船被解釋清楚,那么很容易將頂部解釋為房子。圖像由AurélienGéron提供。

原文鏈接

https://www.oreilly.com/ideas/introducing-capsule-networks?utm_source=feedburner&utm_medium=feed&utm_campaign=Feed%3A+oreilly%2Fradar%2Fatom+%28O%27Reilly+Radar%29

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4731.html

摘要:而加快推動(dòng)這一趨勢的,正是卷積神經(jīng)網(wǎng)絡(luò)得以雄起的大功臣。卷積神經(jīng)網(wǎng)絡(luò)面臨的挑戰(zhàn)對(duì)的深深的質(zhì)疑是有原因的。據(jù)此,也斷言卷積神經(jīng)網(wǎng)絡(luò)注定是沒有前途的神經(jīng)膠囊的提出在批判不足的同時(shí),已然備好了解決方案,這就是我們即將討論的膠囊神經(jīng)網(wǎng)絡(luò),簡稱。 本文作者 張玉宏2012年于電子科技大學(xué)獲計(jì)算機(jī)專業(yè)博士學(xué)位,2009~2011年美國西北大學(xué)聯(lián)合培養(yǎng)博士,現(xiàn)執(zhí)教于河南工業(yè)大學(xué),電子科技大學(xué)博士后。中國計(jì)...

摘要:本文從可視化的角度出發(fā)詳解釋了的原理的計(jì)算過程,非常有利于直觀理解它的結(jié)構(gòu)。具體來說,是那些水平方向的邊緣。訓(xùn)練過程可以自動(dòng)完成這一工作。更進(jìn)一步地說,這意味著每個(gè)膠囊含有一個(gè)擁有個(gè)值的數(shù)組,而一般我們稱之為向量。 CapsNet 將神經(jīng)元的標(biāo)量輸出轉(zhuǎn)換為向量輸出提高了表征能力,我們不僅能用它表示圖像是否有某個(gè)特征,同時(shí)還能表示這個(gè)特征的旋轉(zhuǎn)和位置等物理特征。本文從可視化的角度出發(fā)詳解釋了 ...

摘要:等人最近關(guān)于膠囊網(wǎng)絡(luò)的論文在機(jī)器學(xué)習(xí)領(lǐng)域造成相當(dāng)震撼的影響。它提出了理論上能更好地替代卷積神經(jīng)網(wǎng)絡(luò)的方案,是當(dāng)前計(jì)算機(jī)視覺領(lǐng)域的技術(shù)。而這就是這些膠囊網(wǎng)絡(luò)運(yùn)行方式的本質(zhì)。為了簡化,我們將假設(shè)一個(gè)兩層的膠囊網(wǎng)絡(luò)。產(chǎn)生的結(jié)果值將被稱為。 Geoff Hinton等人最近關(guān)于膠囊網(wǎng)絡(luò)(Capsule networks)的論文在機(jī)器學(xué)習(xí)領(lǐng)域造成相當(dāng)震撼的影響。它提出了理論上能更好地替代卷積神經(jīng)網(wǎng)絡(luò)的...

摘要:鏈接是他們在數(shù)據(jù)集上達(dá)到了較先進(jìn)的性能,并且在高度重疊的數(shù)字上表現(xiàn)出比卷積神經(jīng)網(wǎng)絡(luò)好得多的結(jié)果。在常規(guī)的卷積神經(jīng)網(wǎng)絡(luò)中,通常會(huì)有多個(gè)匯聚層,不幸的是,這些匯聚層的操作往往會(huì)丟失很多信息,比如目標(biāo)對(duì)象的準(zhǔn)確位置和姿態(tài)。 PPT由于筆者能力有限,本篇所有備注皆為專知內(nèi)容組成員根據(jù)講者視頻和PPT內(nèi)容自行補(bǔ)全,不代表講者本人的立場與觀點(diǎn)。膠囊網(wǎng)絡(luò)Capsule Networks你好!我是Aurél...

摘要:在底層的膠囊之后連接了層和層。膠囊效果的討論在論文最后,作者們對(duì)膠囊的表現(xiàn)進(jìn)行了討論。他們認(rèn)為,由于膠囊具有分別處理不同屬性的能力,相比于可以提高對(duì)圖像變換的健壯性,在圖像分割中也會(huì)有出色的表現(xiàn)。 背景目前的神經(jīng)網(wǎng)絡(luò)中,每一層的神經(jīng)元都做的是類似的事情,比如一個(gè)卷積層內(nèi)的每個(gè)神經(jīng)元都做的是一樣的卷積操作。而Hinton堅(jiān)信,不同的神經(jīng)元完全可以關(guān)注不同的實(shí)體或者屬性,比如在一開始就有不同的神...

閱讀 2528·2021-10-12 10:12

閱讀 1707·2019-08-30 15:52

閱讀 2443·2019-08-30 13:04

閱讀 1734·2019-08-29 18:33

閱讀 961·2019-08-29 16:28

閱讀 451·2019-08-29 12:33

閱讀 2057·2019-08-26 13:33

閱讀 2361·2019-08-26 11:36