資訊專欄INFORMATION COLUMN

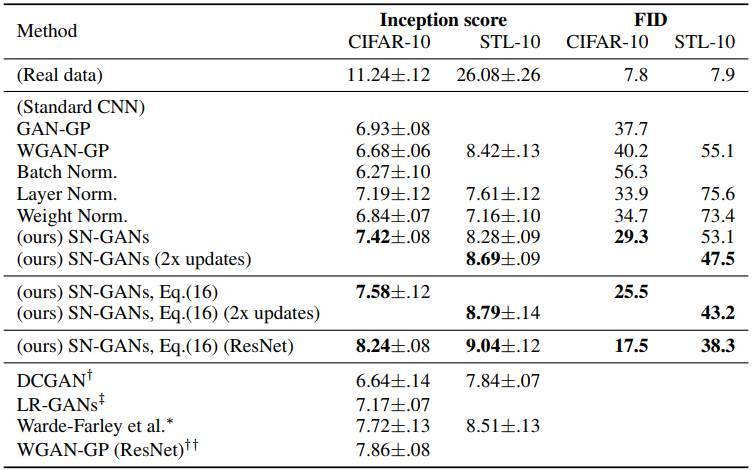

摘要:作者在論文中將這種新的譜歸一化方法與其他歸一化技術(shù),比如權(quán)重歸一化,權(quán)重削減等,和梯度懲罰等,做了比較,并通過實驗表明,在沒有批量歸一化權(quán)重衰減和判別器特征匹配的情況下,譜歸一化改善生成的圖像質(zhì)量,效果比權(quán)重歸一化和梯度懲罰更好。

就在幾小時前,生成對抗網(wǎng)絡(luò)(GAN)的發(fā)明人Ian Goodfellow在Twitter上發(fā)文,激動地推薦了一篇論文:

Goodfellow表示,雖然GAN十分擅長于生成逼真的圖像,但僅僅限于單一類型,比如一種專門生成人臉的GAN,或者一種專門生成建筑物的GAN,要用一個GAN生成ImageNet全部1000種類的圖像是不可能的。但是,這篇ICLR論文做到了。

是什么論文這么厲害?

點開鏈接,可以看到Ian Goodfellow更加熱情的贊美:

這是一篇很棒的論文!

這是一篇很棒的論文!我認為這篇論文沒有充分說明它結(jié)論的重要性,我擔心僅僅瀏覽摘要會讓人錯過這項突破。

“我們在CIFAR10,STL-10和ILSVRC2012數(shù)據(jù)集上測試了譜歸一化的功效,通過實驗證實了相對于那些使用此前提出的訓(xùn)練穩(wěn)定技術(shù)訓(xùn)練的GAN,譜歸一化GAN(SN-GAN)能夠生成質(zhì)量相同乃至更好的圖像。”這個描述太低調(diào)了,這篇論文展現(xiàn)了在ILSVRC2012數(shù)據(jù)集上的一個超大的飛躍。

在這篇論文之前,僅有一種GAN在ILSVR2012數(shù)據(jù)集上表現(xiàn)很好,那就是AC-GAN。但AC-GAN實際上有點作弊,因為它把ImageNet分成了100個更小的數(shù)據(jù)集,每個數(shù)據(jù)集僅含10個種類的數(shù)據(jù)。新的SN-GAN是第一個用一種GAN就覆蓋ImageNet全部1000種類數(shù)據(jù)的GAN變體。

將GAN擴展到更大的種類上面去一直以來都沒有得到很好解決,現(xiàn)在這篇論文為我們帶來了10倍的飛躍。

生成對抗網(wǎng)絡(luò)的譜歸一化,穩(wěn)定判別器訓(xùn)練

看上去真的很厲害的樣子。雖然Goodfellow說僅僅瀏覽摘要無法充分體會這篇論文的好,但是我們還是從摘要開始看起:

題目:生成對抗網(wǎng)絡(luò)的譜歸一化

摘要:生成對抗網(wǎng)絡(luò)的研究面臨的挑戰(zhàn)之一是其訓(xùn)練的不穩(wěn)定性。在本文中,我們提出了一種叫做“譜歸一化”(spectral normalization)的新的權(quán)重歸一化(weight normalization)技術(shù),來穩(wěn)定判別器的訓(xùn)練。這種新歸一化技術(shù)計算輕巧,易于并入現(xiàn)有的部署當中。我們在CIFAR10,STL-10和ILSVRC2012數(shù)據(jù)集上測試了譜歸一化的功效,通過實驗證實了相對于那些使用此前提出的訓(xùn)練穩(wěn)定技術(shù)訓(xùn)練的GAN,譜歸一化GAN(SN-GAN)能夠生成質(zhì)量相同乃至更好的圖像。

簡單說,論文提出了一種新的權(quán)重歸一化方法,用于穩(wěn)定判別器的訓(xùn)練。作者在論文中寫道,他們的歸一化方法需要調(diào)整的超參數(shù)只要一個,就是Lipschitz常數(shù),而且即使不調(diào)整這個超參數(shù),也能獲得滿意的性能。此外,算法實現(xiàn)簡單,額外的計算成本很小。

作者在論文中將這種新的“譜歸一化”方法與其他歸一化技術(shù),比如權(quán)重歸一化(Salimans&Kingma,2016)、權(quán)重削減clipping(Arjovsky等,2017)和梯度懲罰gradient penalty(Gulrajani等,2017)做了比較,并通過實驗表明,在沒有批量歸一化、權(quán)重衰減和判別器特征匹配的情況下,譜歸一化改善生成的圖像質(zhì)量,效果比權(quán)重歸一化和梯度懲罰更好。

第一個成功應(yīng)用于ImageNet全部1000個類別的GAN變體

最后,來看讓Ian Goodfellow覺得沒有充分強調(diào)的部分。

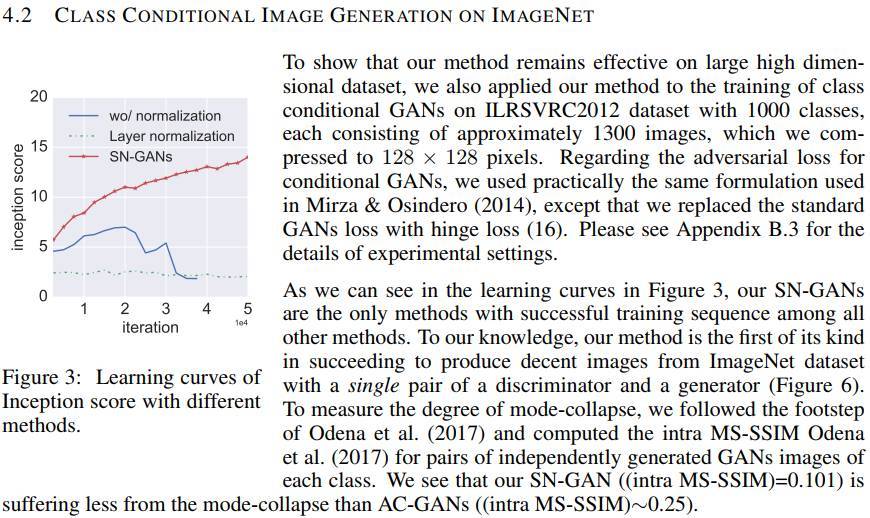

在論文的4.2這節(jié),作者簡單描述了他們的方法在ImageNet訓(xùn)練的情況,如作者所寫,“我們將我們的方法應(yīng)用于ILRSVRC2012數(shù)據(jù)集,訓(xùn)練類別conditional GANs……我們的SN-GAN是所有方法中訓(xùn)練成功了的,據(jù)我們所知,這也是首次用單對判別器和生成器從ImageNet數(shù)據(jù)集生成不錯圖像的嘗試”。

論文地址:https://openreview.net/pdf?id=B1QRgziT-

OpenReview:https://openreview.net/forum?id=B1QRgziT-

P.S. 希望Ian Goodfellow的推薦不要讓這篇論文“過火”才好……

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價值的辦法,實際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://specialneedsforspecialkids.com/yun/4666.html

摘要:文本谷歌神經(jīng)機器翻譯去年,谷歌宣布上線的新模型,并詳細介紹了所使用的網(wǎng)絡(luò)架構(gòu)循環(huán)神經(jīng)網(wǎng)絡(luò)。目前唇讀的準確度已經(jīng)超過了人類。在該技術(shù)的發(fā)展過程中,谷歌還給出了新的,它包含了大量的復(fù)雜案例。谷歌收集該數(shù)據(jù)集的目的是教神經(jīng)網(wǎng)絡(luò)畫畫。 1. 文本1.1 谷歌神經(jīng)機器翻譯去年,谷歌宣布上線 Google Translate 的新模型,并詳細介紹了所使用的網(wǎng)絡(luò)架構(gòu)——循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)。關(guān)鍵結(jié)果:與...

摘要:然而,對于廣大工程人員而言,應(yīng)用新技術(shù)仍存在挑戰(zhàn),谷歌最近開源的庫解決了這個問題。為使開發(fā)者更輕松地使用進行實驗,谷歌最近開源了,一個實現(xiàn)輕松訓(xùn)練和評估的輕量級庫。 生成對抗網(wǎng)絡(luò)(GAN)自被 Ian Goodfellow 等人提出以來,以其優(yōu)異的性能獲得人們的廣泛關(guān)注,并應(yīng)用于一系列任務(wù)中。然而,對于廣大工程人員而言,應(yīng)用新技術(shù)仍存在挑戰(zhàn),谷歌最近開源的 TFGAN 庫解決了這個問題。項目...

摘要:我仍然用了一些時間才從神經(jīng)科學(xué)轉(zhuǎn)向機器學(xué)習(xí)。當我到了該讀博的時候,我很難在的神經(jīng)科學(xué)和的機器學(xué)習(xí)之間做出選擇。 1.你學(xué)習(xí)機器學(xué)習(xí)的歷程是什么?在學(xué)習(xí)機器學(xué)習(xí)時你最喜歡的書是什么?你遇到過什么死胡同嗎?我學(xué)習(xí)機器學(xué)習(xí)的道路是漫長而曲折的。讀高中時,我興趣廣泛,大部分和數(shù)學(xué)或科學(xué)沒有太多關(guān)系。我用語音字母表編造了我自己的語言,我參加了很多創(chuàng)意寫作和文學(xué)課程。高中畢業(yè)后,我進了大學(xué),盡管我不想去...

摘要:在這項工作中,我們提出了自注意力生成對抗網(wǎng)絡(luò),它將自注意力機制引入到卷積中。越高,表示圖像質(zhì)量越好。表將所提出的與較先進模型進行比較,任務(wù)是上的類別條件圖像生成。 圖像合成(Image synthesis)是計算機視覺中的一個重要問題。隨著生成對抗網(wǎng)絡(luò)(GAN)的出現(xiàn),這個方向取得了顯著進展。基于深度卷積網(wǎng)絡(luò)的GAN尤其成功。但是,通過仔細檢查這些模型生成的樣本,可以觀察到,在ImageNe...

摘要:就在最近,這項技術(shù)在流行地無監(jiān)督學(xué)習(xí)數(shù)據(jù)集上實現(xiàn)了非常好的結(jié)果。雖然這項工作并不針對無監(jiān)督學(xué)習(xí),但是它可以用作無監(jiān)督學(xué)習(xí)。利用替代類別的無監(jiān)督學(xué)習(xí)視覺表征使用圖像不行來創(chuàng)建非常大的替代類。 如今深度學(xué)習(xí)模型都需要在大規(guī)模的監(jiān)督數(shù)據(jù)集上訓(xùn)練。這意味著對于每一個數(shù)據(jù),都會有一個與之對應(yīng)的標簽。在很流行的 ImageNet 數(shù)據(jù)集中,其共有一百萬張帶人工標注的圖片,即 1000 類中的每一類都有 ...

閱讀 1015·2021-09-26 09:55

閱讀 3555·2021-09-24 10:30

閱讀 1363·2021-09-08 09:36

閱讀 2552·2021-09-07 09:58

閱讀 602·2019-08-30 15:56

閱讀 764·2019-08-29 18:32

閱讀 3592·2019-08-29 15:13

閱讀 1840·2019-08-29 13:49