資訊專(zhuān)欄INFORMATION COLUMN

摘要:本報(bào)告面向的讀者是想要進(jìn)入機(jī)器學(xué)習(xí)領(lǐng)域的學(xué)生和正在尋找新框架的專(zhuān)家。其輸入需要重塑為包含個(gè)元素的一維向量以滿(mǎn)足神經(jīng)網(wǎng)絡(luò)。卷積神經(jīng)網(wǎng)絡(luò)目前代表著用于圖像分類(lèi)任務(wù)的較先進(jìn)算法,并構(gòu)成了深度學(xué)習(xí)中的主要架構(gòu)。

初學(xué)者在學(xué)習(xí)神經(jīng)網(wǎng)絡(luò)的時(shí)候往往會(huì)有不知道從何處入手的困難,甚至可能不知道選擇什么工具入手才合適。近日,來(lái)自意大利的四位研究者發(fā)布了一篇題為《神經(jīng)網(wǎng)絡(luò)初學(xué)者:在 MATLAB、Torch 和 TensorFlow 中的快速實(shí)現(xiàn)(Neural Networks for Beginners A fast implementation in Matlab, Torch, TensorFlow)》的論文,對(duì) MATLAB、Torch 和 TensorFlow 這三種神經(jīng)網(wǎng)絡(luò)工具進(jìn)行了介紹和比較。機(jī)器之心對(duì)其中部分內(nèi)容進(jìn)行了編譯介紹(其中第 6 節(jié)比較結(jié)論部分進(jìn)行了全部介紹)。

本報(bào)告的目的

本報(bào)告提供了最常見(jiàn)的開(kāi)發(fā)環(huán)境內(nèi)一些機(jī)器學(xué)習(xí)工具的介紹。本報(bào)告主要關(guān)注實(shí)際問(wèn)題,跳過(guò)了任何理論介紹。本報(bào)告面向的讀者是想要進(jìn)入機(jī)器學(xué)習(xí)領(lǐng)域的學(xué)生和正在尋找新框架的專(zhuān)家。

這篇論文是關(guān)于人工神經(jīng)網(wǎng)絡(luò)(ANN,[1,2])的,因?yàn)檫@是目前最熱門(mén)的主題,并且在許多人工智能任務(wù)上都達(dá)到了當(dāng)前較佳的水平。在多帶帶介紹了每一種框架之后,我們同時(shí)也給出實(shí)現(xiàn)一些一般常見(jiàn)問(wèn)題的設(shè)置方法,從而使它們的比較更簡(jiǎn)單。

因?yàn)檫@個(gè)主題已經(jīng)得到了廣泛的研究,而且還在持續(xù)快速地增長(zhǎng),所以我們將這個(gè)文檔和一個(gè) GitHub 庫(kù)進(jìn)行了配對(duì),這個(gè)庫(kù)中的文檔是動(dòng)態(tài)更新的,而且以后可能還會(huì)擴(kuò)大規(guī)模。

GitHub 地址:https://github.com/AILabUSiena/NeuralNetworksForBeginners

目錄

1 MATLAB:一個(gè)統(tǒng)一友好的環(huán)境

1.1 介紹

1.2 設(shè)置異或?qū)嶒?yàn)

1.3 停止準(zhǔn)則和正則化

1.4 繪制分離面

2 Torch 和 Lua 環(huán)境

2.1 介紹

2.2 起步

? 2.2.1 Lua

? 2.2.2 Torch 環(huán)境

2.3 設(shè)置異或?qū)嶒?yàn)

2.4 停止準(zhǔn)則和正則化

2.5 繪制分離面

3 TensorFlow

3.1 介紹

3.2 起步

? 3.2.1 Python

? 3.2.2 TensorFlow 環(huán)境

? 3.2.3 安裝

3.3 設(shè)置異或?qū)嶒?yàn)

4 MNIST 手寫(xiě)字符識(shí)別

4.1 MATLAB 上的 MNIST

4.2 Torch 上的 MNIST

4.3 TensorFlow 上的 MNIST

5 卷積神經(jīng)網(wǎng)絡(luò)

5.1 MATLAB

5.2 Torch

5.3 TensorFlow

6 關(guān)鍵比較

6.1 MATLAB

6.2 Torch

6.3 TensorFlow

6.4 比較總體概覽

6.5 計(jì)算問(wèn)題

1、Matlab:一個(gè)統(tǒng)一的友好環(huán)境

1.1 介紹

Matlab 是一個(gè)強(qiáng)大的工具,能夠?qū)Υ蟛糠诸?lèi)型的數(shù)值運(yùn)算、算法、編程和測(cè)試進(jìn)行簡(jiǎn)單又快速的處理。其直觀且友好的交互式接口使得它能簡(jiǎn)單地對(duì)數(shù)據(jù)進(jìn)行處理、可視化與分析。針對(duì)各種類(lèi)型的任務(wù),該軟件提供了大量的內(nèi)置數(shù)學(xué)函數(shù),以及豐富的、易于獲取的文檔。其主要設(shè)計(jì)是處理矩陣的,因此,幾乎所有的函數(shù)和運(yùn)算都向量化了,也就是說(shuō)它們可以管理標(biāo)量以及向量、矩陣和張量(往往會(huì)有)。因此,其能更高效地避免循環(huán)(可能的時(shí)候),以及建立利用矩陣乘法的運(yùn)算。

在此文檔中,我們只展現(xiàn)了一些簡(jiǎn)單的用于上手人工神經(jīng)網(wǎng)絡(luò)(ANN)的機(jī)器學(xué)習(xí)相關(guān)的工具。我們假設(shè)讀者有基礎(chǔ)知識(shí),并把重點(diǎn)放在了進(jìn)一步信息的官方文檔上。例如,你可以從 Matlab 的官網(wǎng)發(fā)現(xiàn)如何掌握該軟件的相關(guān)信息。確實(shí),其許可證并非免費(fèi)的,雖然大部分大學(xué)會(huì)為學(xué)生提供教學(xué)用許可證,但可能也無(wú)法獲取目前所有的程序包。特別是 Statistic and Machine Learning Toolbox 和 Neural Network Toolbox 提供了大量?jī)?nèi)置函數(shù)和模型,可用于實(shí)現(xiàn)適用于各類(lèi)任務(wù)的不同 ANN 架構(gòu)。

即使我們參考一些簡(jiǎn)多帶帶立的案例,這兩個(gè)工具也是基本所需的。最容易理解的是 nnstart 函數(shù),其能激活一個(gè)簡(jiǎn)單的 GUI 并通過(guò)簡(jiǎn)單的 2 層架構(gòu)來(lái)引導(dǎo)用戶(hù)。它能允許加載可用的數(shù)據(jù)樣本或使用用戶(hù)自定義數(shù)據(jù)(即輸入數(shù)據(jù)和對(duì)應(yīng)目標(biāo)的兩個(gè)矩陣),還能訓(xùn)練網(wǎng)絡(luò)并分析結(jié)果(誤差趨勢(shì)、混淆矩陣、ROC 曲線等)。

然而,還有更多可用于特定任務(wù)的函數(shù)。比如說(shuō),patternnet 函數(shù)是專(zhuān)為模式識(shí)別問(wèn)題而設(shè)計(jì)的、newfit 函數(shù)適用于回歸問(wèn)題,而 feedforwardnet 函數(shù)是最靈活的,其允許構(gòu)建自定義的和復(fù)雜的網(wǎng)絡(luò)。所有的版本都以類(lèi)似方式實(shí)現(xiàn),主要的選項(xiàng)和方法適用于所有函數(shù)。在下一章節(jié)中,我們展示了如何管理可定制架構(gòu),并開(kāi)始解決非常基礎(chǔ)的問(wèn)題。相關(guān)詳細(xì)信息可以在官方網(wǎng)站找到:http://ch.mathworks.com/help/nnet/getting-started-with-neural-network-toolbox.html

2、Torch 和 Lua 環(huán)境

2.1 介紹

Torch7 是一個(gè)易于使用并十分高效的科學(xué)計(jì)算框架,本質(zhì)上是面向機(jī)器學(xué)習(xí)算法的。Torch7 以 C 語(yǔ)言寫(xiě)成,這就保證了高效性。然而,通過(guò) LuaJIT 接口(其提供了一種快速和直觀的腳本語(yǔ)言),我們可以進(jìn)行完全地交互(通常很方便)。此外,它還集成了支持 GPU 計(jì)算的 CUDA 環(huán)境的必要庫(kù)。截至目前,Torch7 是構(gòu)建任何種類(lèi)拓?fù)浣Y(jié)構(gòu)的 ANN 原型上最常用的工具之一。事實(shí)上,Torch7 現(xiàn)在有很多軟件包,有很大的社區(qū)和不斷的更新和改進(jìn),這些都讓我們可以非常簡(jiǎn)單地開(kāi)發(fā)幾乎任何種類(lèi)的架構(gòu)。

有關(guān)安裝信息可以在官方網(wǎng)站入門(mén)部分找到:http://torch.ch/docs/getting-started.html。對(duì)基于 UNIX 的操作系統(tǒng),這一過(guò)程非常簡(jiǎn)單直接,而 Windows 系統(tǒng)即使有替代方法(https://github.com/torch/torch7/wiki/Windows),但還沒(méi)有官方支持。如果已經(jīng)安裝了 CUDA,那么就會(huì)自動(dòng)添加 cutorch 和 cunn 包,其中包含了處理 Nvidia GPU 的所有必要工具。

3、TensorFlow

3.1 簡(jiǎn)介

TensorFlow [5] 是一個(gè)用于數(shù)值計(jì)算的開(kāi)源軟件庫(kù),其相比于其它機(jī)器學(xué)習(xí)框架是最年輕的。TensorFlow 最初由谷歌大腦團(tuán)隊(duì)的研究員和工程師開(kāi)發(fā),其目的是鼓勵(lì)對(duì)深度架構(gòu)的研究。然而,該環(huán)境對(duì)一些數(shù)值編程領(lǐng)域提供了大量的合適的工具。其計(jì)算方式是在數(shù)據(jù)流圖(Data Flow Graphs)概念下構(gòu)想的。圖的結(jié)點(diǎn)表示數(shù)學(xué)運(yùn)算,圖的邊表示張量(多維數(shù)據(jù)數(shù)組)。該機(jī)器學(xué)習(xí)包的核心是用 C++寫(xiě)的,但其提供了一個(gè)優(yōu)良的 Python API,而且有很好的文檔支持。TensorFlow 主要的特征是其符號(hào)方法,該方法允許對(duì)前向模型做出一般性定義,而將對(duì)應(yīng)的衍生計(jì)算留給該環(huán)境本身執(zhí)行。

4、MNIST 手寫(xiě)字符識(shí)別

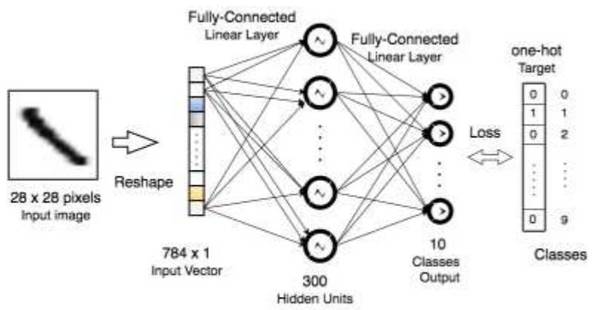

在本章節(jié)中,我們將討論如何建立一個(gè) 2 層 ANN 以解決 MNIST [6] 分類(lèi)問(wèn)題,MNIST 是一個(gè)著名的手寫(xiě)字體識(shí)別數(shù)據(jù)集。其廣泛用于測(cè)試和比較一般機(jī)器學(xué)習(xí)算法和計(jì)算視覺(jué)方法。該數(shù)據(jù)集提供 28×28 像素(灰度)的手寫(xiě)數(shù)字圖像。訓(xùn)練和測(cè)試集分別包含 6 萬(wàn)與 1 萬(wàn)條樣本。壓縮文件可以在官網(wǎng)獲得:http://yann.lecun.com/exdb/mnist/,同時(shí)還有大多數(shù)常見(jiàn)算法的性能測(cè)評(píng)列表。

我們展示了構(gòu)建的標(biāo)準(zhǔn) 2 層 ANN,其每一個(gè)隱藏層包含 300 個(gè)神經(jīng)元。如圖 4 所示,因?yàn)樵摼W(wǎng)絡(luò)是在官方網(wǎng)站上測(cè)評(píng)報(bào)告的架構(gòu)之一,我們可以輕松地比較所得到的結(jié)果。其輸入需要重塑為包含 28 · 28 = 784 個(gè)元素的一維向量以滿(mǎn)足神經(jīng)網(wǎng)絡(luò)。每個(gè)圖像最初由包含灰度像素值 [0, 255] 的矩陣所表征,并將歸一化為 [0, 1] 之內(nèi)。輸出將是包含 10 個(gè)元素的預(yù)測(cè)向量,因?yàn)槊總€(gè)元素的標(biāo)簽將由 one-hot 編碼的 10 空位二元向量組成。激活和懲罰函數(shù)在不同的環(huán)境中并不相同,這樣以提供一個(gè)不同方法的概覽。

圖 4:面向 MNIST 數(shù)據(jù)的 2 層網(wǎng)絡(luò)模型的一般架構(gòu)

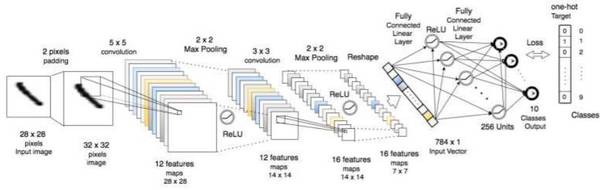

5、卷積神經(jīng)網(wǎng)絡(luò)

在本章節(jié)中,我們將介紹卷積神經(jīng)網(wǎng)絡(luò)(CNN [7, 6, 8]),該神經(jīng)網(wǎng)絡(luò)是一種重要和強(qiáng)大的學(xué)習(xí)架構(gòu),其廣泛用于計(jì)算機(jī)視覺(jué)應(yīng)用。卷積神經(jīng)網(wǎng)絡(luò)目前代表著用于圖像分類(lèi)任務(wù)的較先進(jìn)算法,并構(gòu)成了深度學(xué)習(xí)中的主要架構(gòu)。我們展示了在所有提到的框架內(nèi)如何構(gòu)建和訓(xùn)練這樣一個(gè)神經(jīng)網(wǎng)絡(luò),并且還探索了其最常用的功能和在 MNIST 上進(jìn)行一些試驗(yàn)以指出一些重要的特征。

圖 8:面向 MNIST 數(shù)據(jù)的 CNN 模型的一般架構(gòu)

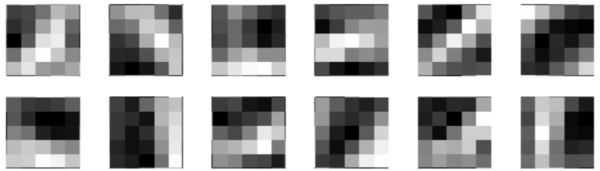

圖 9:在 MNIST 圖像上用 Matlab 訓(xùn)練后的第一個(gè)卷積層的 5 × 5 濾波器。

圖 11:在 2 × 2 較大池化的 MNIST 圖像上用 Torch 訓(xùn)練的第一個(gè)卷積層的 5 × 5 濾波器。

圖 12:在 MNIST 圖像上用 TensorFlow 和所述的架構(gòu)訓(xùn)練的第一個(gè)卷積層的 5 × 5 濾波器。

6、關(guān)鍵比較

在這一節(jié),我們將提供對(duì)這些環(huán)境的整體概覽。即使我們?cè)诒?1 中提供了基于一些我們認(rèn)為和機(jī)器學(xué)習(xí)軟件開(kāi)發(fā)主要相關(guān)的特征的分?jǐn)?shù)比較,但本研究的目的并不是通過(guò)這樣簡(jiǎn)單的評(píng)估來(lái)完成分析。相反,我們希望提出一個(gè)有用的引導(dǎo),可幫助人們進(jìn)入廣義上的 ANN 和機(jī)器學(xué)習(xí)領(lǐng)域,從而根據(jù)個(gè)人背景和要求來(lái)在環(huán)境中自我定位。更完整的和統(tǒng)計(jì)相關(guān)的比較可參閱:http://hammerprinciple.com/therighttool,這里我們進(jìn)行了總結(jié),以幫助人們加速單個(gè)和全局的任務(wù)開(kāi)發(fā)。

我們首先給出了每個(gè)環(huán)境的一般描述,然后我們嘗試在一些具體要求上比較了它們的優(yōu)缺點(diǎn)。最后,我們?cè)诓煌娜蝿?wù)上進(jìn)行了計(jì)算性能的指示性數(shù)值分析,這也可以作為一個(gè)比較和討論的主題。

6.1 MATLAB

該編程語(yǔ)言是直觀的,并且該軟件也提供了完整的軟件包——讓用戶(hù)可以無(wú)需編寫(xiě)任何特定的代碼就能定義和訓(xùn)練幾乎所有類(lèi)型的人工神經(jīng)網(wǎng)絡(luò)架構(gòu)。其代碼并行化(code parallelization)是自動(dòng)完成的,而且與 CUDA 的集成也很直接。其可用的內(nèi)置函數(shù)是高度可自定義和可優(yōu)化的,從而提供了快速的和可擴(kuò)展的實(shí)驗(yàn)設(shè)置方式,讓你可以輕松獲取網(wǎng)絡(luò)的變量以進(jìn)行深度分析。但是,擴(kuò)展和集成 Matlab 工具需要對(duì)于該環(huán)境的高階知識(shí)。這可能會(huì)驅(qū)使用戶(hù)開(kāi)始從頭編寫(xiě)其代碼,導(dǎo)致計(jì)算表現(xiàn)的普遍衰減。這些功能讓其成為了一個(gè)完美的統(tǒng)計(jì)和分析工具箱,但是作為開(kāi)發(fā)環(huán)境來(lái)說(shuō)還是慢了一點(diǎn)。其 GUI 需要一些重量級(jí)的計(jì)算,但另一方面,這對(duì)用戶(hù)很友好,而且還提供了較好的圖形數(shù)據(jù)可視化。MATLAB 的文檔很完整,在官網(wǎng)上也組織得非常好。

6.2 Torch

Torch 的編程語(yǔ)言(Lua)有時(shí)候有一點(diǎn)難,但它應(yīng)該比這些語(yǔ)言中其它一些要快一點(diǎn)。其提供了所有所需的 CUDA 集成和 CPU 并行自動(dòng)化。其基于模塊的結(jié)構(gòu)允許靈活的 ANN 架構(gòu),而且擴(kuò)展其提供的軟件包也相對(duì)容易。而且其還有其它強(qiáng)大的軟件包,但一般而言它們需要一定的專(zhuān)業(yè)知識(shí)才能實(shí)現(xiàn)有意識(shí)的操作。Torch 可被輕松用于特定和一般算法測(cè)試的原型設(shè)計(jì)環(huán)境。其文檔遍布于整個(gè) Torch 的 GitHub 庫(kù),有時(shí)候不能立即解決一些特定的問(wèn)題。

6.3 Tensor Flow

其使用了非常動(dòng)態(tài)的語(yǔ)言 Python,讓用戶(hù)可以輕松地編寫(xiě)腳本。其 CPU 并行化是自動(dòng)的,而且其使用了計(jì)算圖結(jié)構(gòu),可以輕松利用 GPU 計(jì)算。其提供了很好的數(shù)據(jù)可視化,并且讓初學(xué)者也可以輕松地獲取已經(jīng)準(zhǔn)備好的軟件包,盡管本文并沒(méi)有涉及到這方面。其符號(hào)計(jì)算(symbolic computation)的力量?jī)H在前向步驟中涉及到用戶(hù),而其反向步驟完全是由 TensorFlow 環(huán)境導(dǎo)出的。這樣的靈活性讓任何知識(shí)水平的用戶(hù)都可以非常快速地進(jìn)行開(kāi)發(fā)。

6.4 整體比較情況概覽

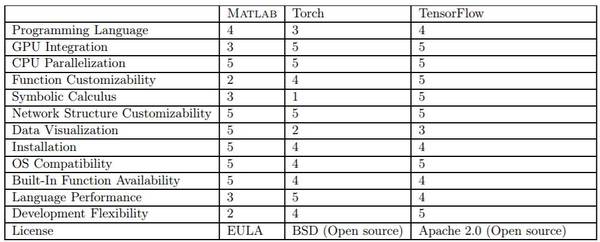

就像之前說(shuō)過(guò)的,我們嘗試在表 1 中總結(jié)出全局對(duì)比,根據(jù)不同的視角進(jìn)行 1-5 的評(píng)分。下面介紹了主要的對(duì)比指標(biāo):

編程語(yǔ)言:它們所有的基本語(yǔ)言都非常直觀

GPU 集成:Matlab 因?yàn)樾枰~外的工具包而得分較低

CPU 并行化:所有的環(huán)境都可利用盡可能多的核(core)

函數(shù)可定制性:Matlab 得分較低,因?yàn)橐獙⒘己脙?yōu)化的函數(shù)與已有的函數(shù)整合起來(lái)很困難

符號(hào)運(yùn)算:Lua 不支持

網(wǎng)絡(luò)結(jié)構(gòu)可定制性:每種網(wǎng)絡(luò)都是可能的

數(shù)據(jù)可視化:交互式的 Matlab 優(yōu)于其它

安裝:所有都相當(dāng)簡(jiǎn)單,但 Matlab 的交互式 GUI 是個(gè)加分項(xiàng)

操作系統(tǒng)兼容性:Torch 在 Windows 上不容易安裝

語(yǔ)言性能:Matlab 接口有時(shí)候很沉重

開(kāi)發(fā)靈活性:同樣,Matlab 得分低,因?yàn)槠鋾?huì)迫使中等用戶(hù)精通其語(yǔ)言,才能有能力整合已有的工具或編寫(xiě)出合適的代碼,一般來(lái)說(shuō),這會(huì)拖慢軟件開(kāi)發(fā)速度。

表 1:三種環(huán)境的各項(xiàng)得分

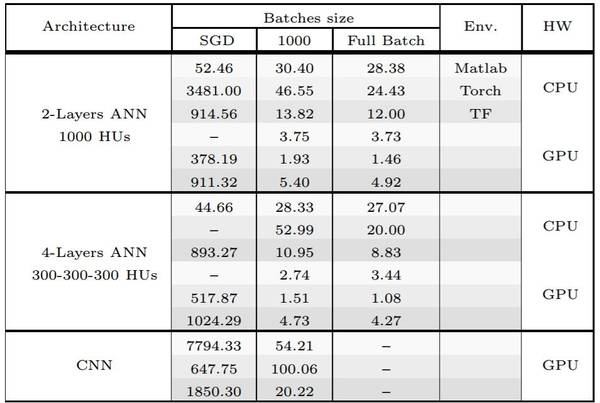

6.5 計(jì)算問(wèn)題

在表 2 中,我們比較了不同任務(wù)的運(yùn)行時(shí)間,分析了 CPU 和 GPU 計(jì)算的優(yōu)點(diǎn)和不同之處。結(jié)果是 5 次實(shí)驗(yàn)的平均得分,而且實(shí)驗(yàn)都是在同一臺(tái)計(jì)算機(jī)上完成的,該計(jì)算機(jī)的配置是:32 核的英特爾 Xeon CPU E5-2650 v2 @ 2.60GHz、66 GB RAM、4 GB 內(nèi)存的 Geforce GTX 960。操作系統(tǒng)是 Debian GNU/Linux 8 (jessie)。我們?cè)诓煌木W(wǎng)絡(luò)框架、批大小(包括隨機(jī)梯度下降(SGD)、1000 樣本批和完全批(Full Bacth))和硬件(在 HW 列說(shuō)明)上測(cè)試了標(biāo)準(zhǔn)的梯度下降流程。這里用到的 CNN 架構(gòu)和圖 8 中給出的一樣。結(jié)果是通過(guò)嘗試使用盡可能相似的優(yōu)化流程而得到的。在實(shí)際中,我們很難在 Matlab 內(nèi)置的工具箱中應(yīng)用特定的優(yōu)化技術(shù)。我們?yōu)?Torch 的第二個(gè)架構(gòu)(第 8 行)跳過(guò)了 SGD 的案例,因?yàn)槠涞谝粋€(gè)架構(gòu)獲得了大量的計(jì)算時(shí)間。我們也跳過(guò)了使用 GPU 的 Matlab 在 ANN 上的 SGD,因?yàn)槠溆?xùn)練函數(shù)不支持 GPU 計(jì)算(第 4 和 10 行)。實(shí)際上,這可能是一個(gè)不常見(jiàn)的研究案例,但為了較好的完整性,我們還是報(bào)告其結(jié)果。我們跳過(guò)了在 GPU 上的 CNN Full Batch 的實(shí)驗(yàn),因?yàn)槠鋬?nèi)存需求實(shí)在太高了。

表 2:給定環(huán)境在 MNIST 數(shù)據(jù)上用不同架構(gòu)訓(xùn)練 10 epoch 5 次后的平均時(shí)間(秒)。所有架構(gòu)都使用了 ReLU 作為激活函數(shù),softmax 作為輸出函數(shù),交叉熵作為懲罰。

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4528.html

摘要:簡(jiǎn)稱(chēng),是基于聚焦行業(yè)應(yīng)用且提供商業(yè)支持的分布式深度學(xué)習(xí)框架,其宗旨是在合理的時(shí)間內(nèi)解決各類(lèi)涉及大量數(shù)據(jù)的問(wèn)題。是負(fù)責(zé)開(kāi)發(fā)的用編寫(xiě),通過(guò)引擎加速的深度學(xué)習(xí)框架,是目前受關(guān)注最多的深度學(xué)習(xí)框架。 作者簡(jiǎn)介魏秀參,曠視科技 Face++ 南京研究院負(fù)責(zé)人。南京大學(xué) LAMDA 研究所博士,主要研究領(lǐng)域?yàn)橛?jì)算機(jī)視覺(jué)和機(jī)器學(xué)習(xí)。在相關(guān)領(lǐng)域較高級(jí)國(guó)際期刊如 IEEE TIP、IEEE TNNLS、Mac...

摘要:首先是最頂層的抽象,這個(gè)里面最基礎(chǔ)的就是和,記憶中和的抽象是類(lèi)似的,將計(jì)算結(jié)果和偏導(dǎo)結(jié)果用一個(gè)抽象類(lèi)來(lái)表示了。不過(guò),本身并沒(méi)有像其它兩個(gè)庫(kù)一樣提供,等模型的抽象類(lèi),因此往往不會(huì)直接使用去寫(xiě)模型。 本文將從deep learning 相關(guān)工具庫(kù)的使用者角度來(lái)介紹下github上stars數(shù)排在前面的幾個(gè)庫(kù)(tensorflow, keras, torch, theano, skflow, la...

摘要:下圖總結(jié)了絕大多數(shù)上的開(kāi)源深度學(xué)習(xí)框架項(xiàng)目,根據(jù)項(xiàng)目在的數(shù)量來(lái)評(píng)級(jí),數(shù)據(jù)采集于年月初。然而,近期宣布將轉(zhuǎn)向作為其推薦深度學(xué)習(xí)框架因?yàn)樗С忠苿?dòng)設(shè)備開(kāi)發(fā)。該框架可以出色完成圖像識(shí)別,欺詐檢測(cè)和自然語(yǔ)言處理任務(wù)。 很多神經(jīng)網(wǎng)絡(luò)框架已開(kāi)源多年,支持機(jī)器學(xué)習(xí)和人工智能的專(zhuān)有解決方案也有很多。多年以來(lái),開(kāi)發(fā)人員在Github上發(fā)布了一系列的可以支持圖像、手寫(xiě)字、視頻、語(yǔ)音識(shí)別、自然語(yǔ)言處理、物體檢測(cè)的...

摘要:第一個(gè)深度學(xué)習(xí)框架該怎么選對(duì)于初學(xué)者而言一直是個(gè)頭疼的問(wèn)題。簡(jiǎn)介和是頗受數(shù)據(jù)科學(xué)家歡迎的深度學(xué)習(xí)開(kāi)源框架。就訓(xùn)練速度而言,勝過(guò)對(duì)比總結(jié)和都是深度學(xué)習(xí)框架初學(xué)者非常棒的選擇。 「第一個(gè)深度學(xué)習(xí)框架該怎么選」對(duì)于初學(xué)者而言一直是個(gè)頭疼的問(wèn)題。本文中,來(lái)自 deepsense.ai 的研究員給出了他們?cè)诟呒?jí)框架上的答案。在 Keras 與 PyTorch 的對(duì)比中,作者還給出了相同神經(jīng)網(wǎng)絡(luò)在不同框...

摘要:第一個(gè)主流產(chǎn)品級(jí)深度學(xué)習(xí)庫(kù),于年由啟動(dòng)。在年月日宣布,的開(kāi)發(fā)將終止。張量中最基本的單位是常量變量和占位符。占位符并沒(méi)有初始值,它只會(huì)分配必要的內(nèi)存。是一個(gè)字典,在字典中需要給出每一個(gè)用到的占位符的取值。 為什么選擇 TensorFlow?在本文中,我們將對(duì)比當(dāng)前最流行的深度學(xué)習(xí)框架(包括 Caffe、Theano、PyTorch、TensorFlow 和 Keras),幫助你為應(yīng)用選擇最合適...

閱讀 2823·2021-10-13 09:48

閱讀 3785·2021-10-13 09:39

閱讀 3597·2021-09-22 16:04

閱讀 1829·2021-09-03 10:48

閱讀 844·2021-08-03 14:04

閱讀 2363·2019-08-29 15:18

閱讀 3406·2019-08-26 12:19

閱讀 2873·2019-08-26 12:08

极致性价比!云服务器续费无忧!

Tesla A100/A800、Tesla V100S等多种GPU云主机特惠2折起,不限台数,续费同价。

NVIDIA RTX 40系,高性价比推理显卡,满足AI应用场景需要。

乌兰察布+上海青浦,满足东推西训AI场景需要