資訊專欄INFORMATION COLUMN

摘要:在與李世石比賽期間,谷歌天才工程師在漢城校區(qū)做了一次關(guān)于智能計算機(jī)系統(tǒng)的大規(guī)模深度學(xué)習(xí)的演講。而這些任務(wù)完成后,谷歌已經(jīng)開始進(jìn)行下一項(xiàng)挑戰(zhàn)了。谷歌深度神經(jīng)網(wǎng)絡(luò)小歷史谷歌大腦計劃于年啟動,聚焦于真正推動神經(jīng)網(wǎng)絡(luò)科學(xué)能達(dá)到的較先進(jìn)的技術(shù)。

在AlphaGo與李世石比賽期間,谷歌天才工程師Jeff Dean在Google Campus漢城校區(qū)做了一次關(guān)于智能計算機(jī)系統(tǒng)的大規(guī)模深度學(xué)習(xí)(Large-Scale Deep Learning for Intelligent Computer Systems)的演講。本文是對他這次演講的總結(jié)。

如果你無法理解信息里包含的內(nèi)容,那么就會很難將其組織起來。

自從AlphaGo與李世石的比賽——這是約翰·亨利對戰(zhàn)蒸汽錘的現(xiàn)代版本——吸引了全世界,再次滋生了對「人工智能毀滅世界」的恐懼感,似乎此時一睹Jeff的演講是絕佳時刻。如果你認(rèn)為AlphaGo現(xiàn)在很好,就等待它的beta版本吧。

Jeff當(dāng)然提到了谷歌的著名語錄:組織這個世界的信息,使信息唾手可得并變得有用。

過去,我們可能會將「組織」和收集、清除、存儲、索引、報告和搜索數(shù)據(jù)聯(lián)系起來。所有這些都是谷歌早期精通的業(yè)務(wù)。而這些任務(wù)完成后,谷歌已經(jīng)開始進(jìn)行下一項(xiàng)挑戰(zhàn)了。

現(xiàn)在,組織意味著理解。

此次演講的一些重點(diǎn):

真正的神經(jīng)網(wǎng)絡(luò)由幾億個參數(shù)組成。谷歌現(xiàn)在所擁有的技能在于如何建造并快速訓(xùn)練這些大型模型來處理大量數(shù)據(jù)集,并用它們?nèi)ソ鉀Q實(shí)際問題,之后快速將這些模型部署到不同平臺上的大量產(chǎn)品中(手機(jī)、傳感器、云等等)。

神經(jīng)網(wǎng)絡(luò)在90年代沒有得到快速發(fā)展是由于缺乏足夠的計算能力和大型的數(shù)據(jù)集。你能看到谷歌對算法的天然熱愛是如何與他們的大量基礎(chǔ)設(shè)施結(jié)合到一起的,也能看到不斷擴(kuò)大的數(shù)據(jù)集如何為谷歌的人工智能創(chuàng)造了完美的推動。

?谷歌和其他公司的一個關(guān)鍵區(qū)別就在于,當(dāng)他們在2011年啟動谷歌大腦計劃時,他們并沒有將他們的研究獨(dú)立成該公司一個多帶帶的研究部門,成為象牙塔一般的存在。而是項(xiàng)目團(tuán)隊(duì)和其他團(tuán)隊(duì)緊密合作,比如安卓、Gmail 和photo等部門,以確實(shí)改進(jìn)它們的特性,解決困難的問題。這對每一家公司來說都是非常珍貴的一刻。通過和你的人一起工作將研究進(jìn)行實(shí)際應(yīng)用。

這一想法十分強(qiáng)大:他們知道他們能夠獲取完整的子系統(tǒng),有些可能是機(jī)器學(xué)習(xí)到的,用更加通用的端對端的機(jī)器學(xué)習(xí)塊進(jìn)行替換。通常當(dāng)你有很多復(fù)雜的子系統(tǒng)時,總會有很多復(fù)雜的代碼將這些系統(tǒng)拼接起來。如果能夠用數(shù)據(jù)和非常簡單的算法將這一切進(jìn)行替換的話就再好不過了。

機(jī)器學(xué)習(xí)很快將會變得更好。引用Jeff的話說:機(jī)器學(xué)習(xí)領(lǐng)域的發(fā)展非常快。一篇論文發(fā)布出來,一周內(nèi)全球眾多研究團(tuán)體會下載這篇論文,閱讀、解析論文,驗(yàn)證論文的內(nèi)容,然后把自己對論文的延展發(fā)布到arXiv.org上。這與計算機(jī)學(xué)的其他領(lǐng)域不同,他們首先需要提交文件,而后六個月會議討論決定是否接收,再過三個月會議上才會有結(jié)果。這就耗費(fèi)了一年時間。電子論文能把這個時間壓縮到一周是非常驚人的。

技術(shù)能夠非常神奇的結(jié)合起來。谷歌翻譯團(tuán)隊(duì)寫了一個APP,能夠使用計算機(jī)視覺在取景器上識別文本。在翻譯完文本后,可以把翻譯后的內(nèi)容自動添加到圖片上。另外一個例子是寫圖片字幕。把圖片識別和一序列一序列的神經(jīng)網(wǎng)絡(luò)結(jié)合起來。可以想象,這些模塊化的內(nèi)容在未來將何等緊密的結(jié)合起來。

有強(qiáng)大功能的模型要小到足以在智能手機(jī)上運(yùn)行。科技想要想取代智力必須走到這一步。它不能依靠網(wǎng)絡(luò)連接外部的「云大腦」。既然TensorFlow模型能夠在手機(jī)上運(yùn)行,那這一點(diǎn)是有可能實(shí)現(xiàn)的。

如果你還沒有思考深度神經(jīng)網(wǎng)絡(luò)如何解決數(shù)據(jù)理解問題,那你就要開始思考了。這條起始線從現(xiàn)在開始,但它的實(shí)現(xiàn)是非常明了的,我們看到了很多難題在深度學(xué)習(xí)網(wǎng)絡(luò)面前都迎刃而解。

Jeff 發(fā)表的講話都非常的棒,這次毫不例外。內(nèi)容非常直接有趣,有深度,還非常容易理解。如果你想了解深度學(xué)習(xí)或了解Googel打算做什么,這些內(nèi)容就值得一看了。

理解意味著什么?

當(dāng)一個人看到街道景象時,他能輕而易舉地挑選出圖片上的文本,了解到有的商店賣紀(jì)念品,有家店價格特別低等信息。但直到現(xiàn)在,計算機(jī)依然不能從圖片中提取出這些信息。

如果計算機(jī)想要從圖片中了解現(xiàn)實(shí)世界,它需要能夠從中挑選出有趣的信息點(diǎn),閱讀文本并理解它。

?在未來,小型移動設(shè)備將主宰著計算機(jī)交互。這些設(shè)備都需要不同類型的界面。需要真的能夠理解并生成對話。

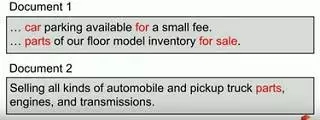

我們在搜索引擎中輸入:[汽車零部件]。舊的谷歌版本會因?yàn)殛P(guān)鍵詞匹配給你第一條結(jié)果,但更好的結(jié)果其實(shí)是第二個結(jié)果。真正的理解是這個問題深層次的意義是什么,并非字眼的表面意義。這才是構(gòu)建好的搜索與語言理解產(chǎn)品所需要的。

谷歌深度神經(jīng)網(wǎng)絡(luò)小歷史

谷歌大腦計劃于2011年啟動,聚焦于真正推動神經(jīng)網(wǎng)絡(luò)科學(xué)能達(dá)到的較先進(jìn)的技術(shù)。

神經(jīng)網(wǎng)絡(luò)已經(jīng)存在很多年了,出現(xiàn)于19世紀(jì)60年代至70年代之間,在80年代晚期和90年代早期紅極一時,然后逐漸暗淡。主要因?yàn)閮蓚€問題:1)缺乏必備的計算能力去訓(xùn)練大量的模型,這意味著神經(jīng)網(wǎng)絡(luò)不能應(yīng)用于包含大量有趣的數(shù)據(jù)集的大型問題。2)缺乏大量的有趣的數(shù)據(jù)集。

谷歌開始只有幾個產(chǎn)品團(tuán)隊(duì)工作。隨著這些團(tuán)隊(duì)發(fā)布一些很好的、能解決以前不能解決的問題的產(chǎn)品。名聲漸起,很快,更多的團(tuán)隊(duì)加入其中幫助解決問題。

谷歌需要利用深度學(xué)習(xí)技術(shù)的產(chǎn)品/領(lǐng)域:安卓,Apps,藥物發(fā)現(xiàn),谷歌郵箱,圖像理解,地圖,自然語言,圖片,機(jī)器人,語音翻譯,等等。

深度學(xué)習(xí)能應(yīng)用于如此完全不同的項(xiàng)目的原因是他們涉及相同的基石,這些基石可用于不同的領(lǐng)域:語音、文本、搜索查詢、圖像、視頻、標(biāo)簽、實(shí)體(一種特定的軟件模塊)、文字、音頻特性。你可以輸入一種類型的信息,決定你想要輸出信息類型,收集訓(xùn)練數(shù)據(jù)集指示出你想要計算的功能。然后,你可以放手不管了。

這些模型十分奏效,因?yàn)槟爿斎氲氖欠浅T嫉臄?shù)據(jù)。你不必給出數(shù)據(jù)大量的有趣特點(diǎn),模型的力量足以讓它自動地通過觀察許多許多例子決定數(shù)據(jù)集的有趣之處。

你可以學(xué)習(xí)常見的表征,這種學(xué)習(xí)很可能是跨領(lǐng)域的。例如,一輛『汽車』可以指圖像中與真實(shí)相同的汽車。

?他們已經(jīng)學(xué)到他們可以聚集一大堆的子系統(tǒng),其中一些可能是由機(jī)器學(xué)習(xí)的,然后用更通用的端對端的機(jī)器學(xué)習(xí)塊代替它。通常當(dāng)你有很多復(fù)雜的子系統(tǒng)時,往往有大量復(fù)雜的代碼將這些子系統(tǒng)縫結(jié)在一起。如果你能用數(shù)據(jù)和簡單的算法代替所有復(fù)雜代碼,那就太好了。

什么是單個深度神經(jīng)網(wǎng)絡(luò)?

神經(jīng)網(wǎng)絡(luò)從數(shù)據(jù)中學(xué)習(xí)真正復(fù)雜的函數(shù)。從一端輸入內(nèi)容轉(zhuǎn)換成另一端的輸出內(nèi)容。

這一函數(shù)不像計算x2,而是真正復(fù)雜的函數(shù)。當(dāng)你輸入原始像素,比如一只貓是,輸出結(jié)果就會是事物的類別。

深度學(xué)習(xí)中的「深度」是指神經(jīng)網(wǎng)絡(luò)的層的數(shù)量。

對于深度,一個好的屬性是系統(tǒng)是由簡單的可訓(xùn)練的數(shù)學(xué)函數(shù)的集合構(gòu)成的。

深度神經(jīng)網(wǎng)絡(luò)與大量機(jī)器學(xué)習(xí)方式是兼容的。

例如,你輸入貓的圖片,輸出的是一張人為標(biāo)注為貓的圖像,這叫作監(jiān)督式學(xué)習(xí)。你可以給系統(tǒng)列舉大量的監(jiān)督式樣例,并且將學(xué)習(xí)結(jié)合一個函數(shù),這個函數(shù)與在監(jiān)督式例子所描述的是相似的。

你也可以進(jìn)行非監(jiān)督式訓(xùn)練,你只得到圖像而不知道圖像里面的什么。然后系統(tǒng)可以依靠在眾多圖片中出現(xiàn)的模式學(xué)會挑選。所以,即使不知道圖像叫作什么,它也可以在所有這些有貓的圖形辨別出共同的事物來。

這也和更多像強(qiáng)化學(xué)習(xí)這樣的外來技術(shù)是兼容的。強(qiáng)化學(xué)習(xí)是非常重要的技術(shù),它正在被AlphaGo使用。

什么是深度學(xué)習(xí)?

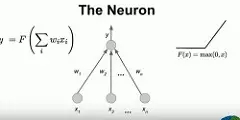

神經(jīng)網(wǎng)絡(luò)模型可以說是基于我們所認(rèn)識的大腦運(yùn)作的方式,它并不是對神經(jīng)元真正工作的詳細(xì)模擬,而是一個簡單抽象的神經(jīng)元版本。

一個神經(jīng)元能夠接收許多輸入信息,真實(shí)的神經(jīng)元會將不同的優(yōu)勢(strengths)與不同的輸入相聯(lián)系。人工智能網(wǎng)絡(luò)試著學(xué)習(xí)為所有那些邊緣,亦即與這些不同輸入關(guān)聯(lián)的優(yōu)勢進(jìn)行加權(quán)。

真實(shí)的神經(jīng)元吸收一些輸入與優(yōu)勢的組合,并決定是否發(fā)出一個脈沖。人工神經(jīng)元不僅僅會發(fā)出脈沖,還會發(fā)出一個實(shí)數(shù)值。這些神經(jīng)元計算的函數(shù)是輸入的加權(quán)求和乘以非線性函數(shù)的權(quán)重。

現(xiàn)今通常所用的非線性函數(shù)是ReLU(max(0,x))。在上世紀(jì)九十年代,大部分非線性函數(shù)都是更加平滑 (https://www.quora.com/What-is-special-about-rectifier-neural-units-used-in-NN-learning)的 sigmoid或tanh函數(shù)。當(dāng)神經(jīng)元不放電的時候會取真正的零值,而不是非常接近零的數(shù)值的優(yōu)秀特性,從而幫助優(yōu)化系統(tǒng)。

例如,如果神經(jīng)元有著三個輸入X1,X2,X3,分別有著0.21,0.3,0.7的權(quán)重,那么計算函數(shù)將為:y = max(0, -.0.21*x1 + 0.3*x2 + 0.7*x3)。

在識別圖片里是一只貓還是一只狗的過程中,圖像會經(jīng)過多層級處理,基于它們的輸入神經(jīng)元可以決定是否發(fā)射脈沖。

最底層的神經(jīng)元只處理一小部分像素,更高層的神經(jīng)元則會處理下層神經(jīng)元的輸出并決定是否發(fā)射脈沖。

模型會如此向上直至最后一層處理完畢,舉個例子,這是一只貓。在這種情況下它錯了,這是一只狗(盡管我也認(rèn)為那是一只貓,那是一只在籃子里的狗嗎?)。

輸出錯誤的信號會反饋回系統(tǒng)中,接著其余模型會做出調(diào)整以讓它在下一次處理圖片時更有可能給出正確的答案。

調(diào)整整個模型所有的邊緣權(quán)重以增大獲得正確結(jié)果的可能性,這就是神經(jīng)網(wǎng)絡(luò)的目標(biāo)。人們在所有的樣本都如此處理,這樣在大部分的樣本中都會得到正確的輸出。

學(xué)習(xí)算法非常簡單。循環(huán)計算步驟如下:

隨機(jī)選擇一個訓(xùn)練樣本「(輸入,標(biāo)簽)」。例如,一張貓的圖片,以及預(yù)期輸出「貓」。

用「輸入」運(yùn)行神經(jīng)網(wǎng)絡(luò),并觀察它的結(jié)果。

調(diào)整邊緣權(quán)重,讓輸出更接近與標(biāo)簽」。

該如何調(diào)整邊緣權(quán)重以讓輸出接近標(biāo)簽?zāi)兀?/p>

反向傳播法:這里是一篇針對此的推薦文章:Calculus on Computational Graphs: Backpropagation (http://colah.github.io/posts/2015-08-Backprop/)。

當(dāng)神經(jīng)網(wǎng)頂層選擇的是貓而不是狗的時候,通過微積分鏈?zhǔn)椒▌t來調(diào)整權(quán)重參數(shù)使得網(wǎng)絡(luò)可以做更準(zhǔn)確的預(yù)測。

你需要和權(quán)重的箭頭保持同一方向,讓它更有可能認(rèn)為這是一只狗。不要跳一大步,因?yàn)檫@可是一個復(fù)雜坎坷的表面。小步前進(jìn)會讓結(jié)果在下一次更有可能變成狗。通過大量迭代以及對樣本的觀察,結(jié)果就越有可能變成狗。

通過鏈?zhǔn)椒▌t你可以理解底層的參數(shù)變化會如何影響輸出。這意味著神經(jīng)網(wǎng)絡(luò)網(wǎng)絡(luò)的變化如同漣漪般波及至輸入,調(diào)整整個模型,并增大它說出狗的可能性。

真的神經(jīng)網(wǎng)絡(luò)由數(shù)以億計參數(shù)組成,因此你正在一個億維空間內(nèi)做調(diào)整,并試著理解那是怎樣影響網(wǎng)絡(luò)輸出結(jié)果的。

神經(jīng)網(wǎng)絡(luò)的很多優(yōu)秀特性

神經(jīng)網(wǎng)絡(luò)可以運(yùn)用到多個不同領(lǐng)域,用來解決不同的問題:

文本:英語和其他語言包含數(shù)萬億的單詞。現(xiàn)有很多對應(yīng)的文字資料,包含句與句對應(yīng)的一種源語言文字與其翻譯版的另一種語言文字。

視覺數(shù)據(jù):數(shù)十億的圖像和視頻。

聲音:每天會產(chǎn)生幾萬小時的音頻數(shù)據(jù);

用戶行為:不同的應(yīng)用程序都在產(chǎn)生數(shù)據(jù),無論你在搜索引擎敲下的字符還是在郵箱里標(biāo)記的垃圾郵件,這些用戶行為里可以不斷被學(xué)習(xí),并用來給你「定制」智能系統(tǒng)。

知識圖譜:數(shù)十億打標(biāo)簽的RDF triple數(shù)據(jù)。

你給的數(shù)據(jù)越多,其反饋的結(jié)果越好,你也會讓這個模型更大。

? ??

如果你投入更多的數(shù)據(jù)卻不去擴(kuò)大你的模型,會進(jìn)入一個模型能力的飽和狀態(tài),此時,模型學(xué)習(xí)到的只是關(guān)于你的數(shù)據(jù)集最顯而易見的事實(shí)。

通過增加模型的規(guī)模,模型不僅可以記住一些明顯的特征,還會記住一些只是偶然在數(shù)據(jù)集中出現(xiàn)的細(xì)微特征。

打造更大的模型需要更多數(shù)據(jù)和更強(qiáng)大的計算能力。谷歌一直在做的就是如何規(guī)模化計算量并投入到這些問題的解決中,從而訓(xùn)練更大的模型。

深度學(xué)習(xí)給谷歌帶來哪些影響?

語音識別

語音識別團(tuán)隊(duì)第一個和谷歌大腦團(tuán)隊(duì)合作部署神經(jīng)網(wǎng)絡(luò)。在谷歌大腦團(tuán)隊(duì)幫助下,部署上線了一個新的、基于神經(jīng)網(wǎng)絡(luò)的語音模型,不再使用之前的隱馬爾科夫模型。

聲學(xué)模型的問題是從150毫秒的語音里預(yù)測其中10毫秒的聲音是什么。類似與「ba」還是「ka」。接著你有了這些預(yù)測的完整序列,然后將它們和語言模型對接起來,以理解用戶在說什么。

這個模型將識別錯誤率降低了30%,意義非常重大。此后語音團(tuán)隊(duì)繼續(xù)在構(gòu)建更加復(fù)雜的模型,并結(jié)合更好的神經(jīng)網(wǎng)絡(luò)降低錯誤率。現(xiàn)在你在手機(jī)上說話,語音識別已經(jīng)比三到五年前好太多了。

Image 挑戰(zhàn)賽

大約六年前, ImageNet的數(shù)據(jù)庫公開,大約有100萬圖像數(shù)據(jù),這個巨大的圖像數(shù)據(jù)庫對于推進(jìn)計算機(jī)視覺的發(fā)展意義重大。

圖像被分為1000個不同種類,每個種類大約1000張照片;

大約有1000張不同的豹子照片、1000張不同的汽車、滑板車照片等等;

其中有個復(fù)雜的因素:并非所有的標(biāo)簽都是正確的;

比賽的目標(biāo)是概括出照片的新的類型。對于一張新照片,你能判斷出來上面是獵豹還是櫻桃嗎?

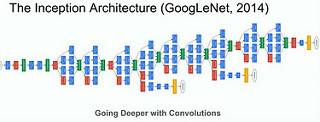

在神經(jīng)網(wǎng)絡(luò)運(yùn)用到比賽之前,這項(xiàng)比賽的錯誤率為26℅。2014年,谷歌贏得比賽時的錯誤率為6.66%。2015年的時候,獲勝團(tuán)隊(duì)的錯誤率降低到3.46%。

這是一個巨大而且有深度的模型。每個盒子都布滿了完整層級的神經(jīng)元,它們正在進(jìn)行卷積運(yùn)算,關(guān)于這方面的詳細(xì)情況,可以查看這篇論文《Going Deeper with Convolutions》

一個名叫 Andrej Karpathy 的人也參與了比賽,他的錯誤率是5.1%,他后來還寫了篇文章《What I learned from competing against a ConvNet on ImageNet.》

神經(jīng)網(wǎng)絡(luò)模型擅長什么?

神經(jīng)網(wǎng)絡(luò)模型非常擅長識別精細(xì)程度的差別。比如,計算機(jī)擅長辨別人類不善于分辨的犬種。人類可能看到一朵花就只知道那是一朵花,計算機(jī)可以分辨那是一朵「芙蓉」或是一朵「大麗花」。

神經(jīng)網(wǎng)絡(luò)模型擅長歸納。比如不同種類的飯菜,盡管看起來不一樣,但都會被標(biāo)記為「飯菜」。

?當(dāng)計算機(jī)出錯時,錯誤的原因是合理的。比如一只蛞蝓看起來很像一條蛇。

谷歌照片搜索

檢查照片的像素并理解圖像中的內(nèi)容,這是個很強(qiáng)大的能力。

Google Photos 團(tuán)隊(duì)在沒有標(biāo)記它們的情況下部署了這一能力。你可以在沒有標(biāo)記圖片的情況下搜索到雕像、尤達(dá)、圖畫、水等圖片。

街景影像

在街景影像中,你希望可以閱讀到所有的文本。這是更為精細(xì)更為具體的視覺任務(wù)。

首先需要能夠找到圖像中的文本。模型基本上都是被訓(xùn)練用來預(yù)測像素?zé)釄D的:哪些像素包含文本,哪些不包含。訓(xùn)練數(shù)據(jù)是繪制于文本像素周圍的多邊形。

因?yàn)橛?xùn)練數(shù)據(jù)包含不同的字符集,它可以找到多種不同語言的文本。它可以識別大字體和小字體,離鏡頭近的和離得很遠(yuǎn)的文字,以及不同顏色的文本。

這是一個訓(xùn)練相對簡單的模型。這是一個試圖預(yù)測每個像素是否包含文本的傳統(tǒng)的網(wǎng)絡(luò)。

谷歌搜索排名的RankBrain

RankBrain于2015年推出,是谷歌第三重要的搜索排名因素。了解更多:谷歌將其利潤豐厚的網(wǎng)絡(luò)搜索交給人工智能機(jī)器。

搜索排名是不同的,因?yàn)槟阆胍軌蚶斫庠撃P停阆肜斫鉃槭裁此鼤龀鎏囟ǖ臎Q策。

這是搜索排名團(tuán)隊(duì)猶豫在搜索排名中使用神經(jīng)網(wǎng)絡(luò)的一個原因。當(dāng)系統(tǒng)出錯時,他們希望了解什么會這樣。

調(diào)試工具已被制造出來,而且模型也能被充分地理解,以克服這種異議。

一般來說你不想手動調(diào)整參數(shù)。你嘗試?yán)斫鉃槭裁茨P蜁龀瞿菢拥念A(yù)測并搞清楚是否與訓(xùn)練數(shù)據(jù)相關(guān),是與問題不匹配嗎?你可能在一個分布式數(shù)據(jù)上進(jìn)行訓(xùn)練,然后將其應(yīng)用于另一個。通過搜索查詢的分布,模型每天都能獲得一點(diǎn)改變。因?yàn)槭录诟淖儯P鸵惨恢痹诟淖儭D惚仨毩私饽愕姆植际欠袷欠€(wěn)定的,比如在語音識別中,人們的聲音并不會發(fā)生太大改變。查詢和文檔內(nèi)容經(jīng)常在改變,所以你必須確保你的模型是新鮮的。更一般地,我們需要打造更好的用于理解這些神經(jīng)網(wǎng)絡(luò)內(nèi)部狀況的工具,搞清楚是什么得出了預(yù)測。

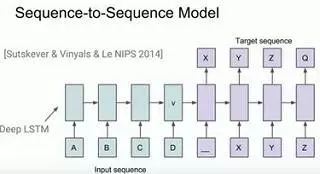

序列至序列(Sequence-to-Sequence)映射模型

世界上許多問題都可歸入到一個序列映射到另一個序列的框架中。谷歌的Sutskever、Vinyals 和 Le 在這個主題上寫了一篇開關(guān)性的論文:使用神經(jīng)網(wǎng)絡(luò)的序列到序列學(xué)習(xí) (http://papers.nips.cc/paper/5346-sequence-to-sequence-learning-with-neural-networks.pdf)。

特別地,他們研究了語言翻譯,將英語翻譯成法語中的問題。翻譯事實(shí)上只是將英語句子序列映射到法語句子序列。

神經(jīng)網(wǎng)絡(luò)非常擅長學(xué)習(xí)非常復(fù)雜的功能,所以這個模型學(xué)習(xí)了映射英語句子到法語句子的功能。

一種語言的一個句子通過EOS(end of sentence)信號一次輸入一個詞。當(dāng)模型看到EOS 開始產(chǎn)出其它語言對應(yīng)的句子時,模型就得到了訓(xùn)練。訓(xùn)練數(shù)據(jù)是具有同樣含義的不同語言中的配對句子。它只是試圖該函數(shù)建模。

模型會在每一步發(fā)出你的詞匯中所有詞條輸入的概率分布。在推理而不是訓(xùn)練時間,你需要做一點(diǎn)搜索。如果你必須較大化每個詞的概率,你并不一定會得到最可能的句子。直到找到較大可能的句子,聯(lián)合概率的搜索才完成。

該系統(tǒng)是現(xiàn)在公共翻譯服務(wù)中較先進(jìn)的。其它翻譯系統(tǒng)是一堆手寫的代碼或這個翻譯問題的子塊的機(jī)器學(xué)習(xí)模型,而非完全的端到端學(xué)習(xí)系統(tǒng)。

人們對這一模型的興趣在暴增,因?yàn)楹芏鄦栴}都可被映射到序列到序列的方法。

智能回復(fù)(Smart Reply)

Smart Reply是序列到序列在產(chǎn)品中的一個應(yīng)用案例。在手機(jī)上,你希望快速回復(fù)郵件,而打字又讓人痛苦。

和 Gmail 團(tuán)隊(duì)合作,他們開發(fā)了一個能預(yù)測一條信息可能的回復(fù)的系統(tǒng)。

第一步是訓(xùn)練一個小模型以預(yù)測一條信息是否是可以快速回復(fù)的信息。如果是,就會激活一個更大的計算上更昂貴的模型;該模型將該信息作為一個序列,并嘗試預(yù)測回復(fù)的單詞序列。

比如,對于一封詢問感恩節(jié)邀請的電子郵件,可預(yù)測到的回復(fù)有三個:把我們算上;我們會去;抱歉我們?nèi)ゲ涣恕?/p>

Inbox 應(yīng)用中驚人數(shù)量的回復(fù)都是通過 Smart Reply 生成的。

圖片說明

生成一張圖片說明時,你會試著讓機(jī)器盡可能寫出類似人類基于圖片會做出的說明。

采用已經(jīng)開發(fā)出來的圖片模型,以及已經(jīng)研發(fā)出來的Sequence-to-Sequence模型,把它們插在一起。圖片模型被用作輸入。

它被訓(xùn)練用來生成說明。訓(xùn)練數(shù)據(jù)集擁有五種不同的人給出的五種不同說明的圖片。10萬到20萬的圖片需要寫70萬句的說明。

一張嬰兒懷抱泰迪熊的圖片,電腦這么寫的:一個抱著填充玩具動物孩子的特寫;一個嬰兒在泰迪熊旁邊睡著了。

?還沒有達(dá)到人類理解水平,但機(jī)器出錯時,結(jié)果可能會有趣。

綜合視覺+翻譯

技術(shù)能夠綜合起來。翻譯團(tuán)隊(duì)編寫了使用了在取景器中識別文本的計算機(jī)視覺APP。翻譯文本,然后給圖片疊加翻譯文本(讓人印象非常深刻,約37;29)。

模型足夠小,整個計算都在設(shè)備上運(yùn)行。

迭代(turnaround)時間和對研究的影響

?在一天內(nèi)完成單個CPU花費(fèi)6周才能完成的訓(xùn)練

?谷歌真的關(guān)心能夠快速迭代研究。它的想法是快速的訓(xùn)練模型。理解什么運(yùn)行良好,什么運(yùn)行欠佳,找出下一組要運(yùn)行的實(shí)驗(yàn)。

?一個模型應(yīng)該在在幾分鐘幾小時內(nèi)就能可訓(xùn)練,而不是幾天甚至幾個禮拜。讓每個做這類研究的人更加富有生產(chǎn)力。

如何快速訓(xùn)練模型?

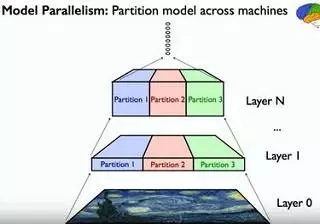

模型的并行性

一個神經(jīng)網(wǎng)絡(luò)有許多內(nèi)在的并行性。

所有不同的個體神經(jīng)元幾乎都是彼此獨(dú)立的,當(dāng)你計算它們時,特別是,加入你有Local Receptive Fields,這是一個神經(jīng)元從其下方少量神經(jīng)元那里接受輸入的地方。

能夠跨越不同GPU卡上的不同機(jī)器對工作進(jìn)行劃分,只有跨越邊界的數(shù)據(jù)才需要交流。

數(shù)據(jù)的并行性

當(dāng)你對模型的參數(shù)集進(jìn)行優(yōu)化時,不應(yīng)該在中央服務(wù)的一臺機(jī)器上進(jìn)行,這樣你就有不同的模型副本,通過它們之間的合作來進(jìn)行參數(shù)優(yōu)化。

在訓(xùn)練中理解不同的隨機(jī)數(shù)據(jù)片段。每一個副本都會獲得模型中當(dāng)前的參數(shù)集,通過對相當(dāng)規(guī)模數(shù)據(jù)的理解來判斷出梯度,找出需要對參數(shù)所作的調(diào)整,并且將調(diào)整值發(fā)回至中央?yún)?shù)集服務(wù)器。參數(shù)服務(wù)器會對參數(shù)進(jìn)行調(diào)整。不斷重復(fù)這個過程。

這會在多個副本之間完成。有時他們會使用500臺機(jī)器來生成500個模型副本,以便迅速實(shí)現(xiàn)參數(shù)的優(yōu)化和處理數(shù)據(jù)。

這個過程可以異步進(jìn)行,每個數(shù)據(jù)分任務(wù)在各自獨(dú)自的循環(huán)運(yùn)算中,獲取參數(shù),計算梯度并將它們傳回,不會受到其他彼此的控制和同步。結(jié)果是,按照50-100的副本規(guī)模進(jìn)行練習(xí),對許多模型來說是可行的。

Q&A

如果不是諸如谷歌這樣的大公司,無法獲取海量數(shù)據(jù)集,你會怎么做?從一個運(yùn)行良好的模型開始,用公共數(shù)據(jù)集進(jìn)行訓(xùn)練。公共數(shù)據(jù)集普遍可以獲取。然后用更加適合你問題的數(shù)據(jù)進(jìn)行訓(xùn)練。當(dāng)你從一個類似并且公開可獲取的數(shù)據(jù)組開始時,針對你的特殊問題,可能只需要1,000或者10,000標(biāo)簽實(shí)例。ImageNet就是這種處理可行的好例子。

身為一個工程師,你所犯過的較大錯誤是什么?沒有在BigTable里放入分布式事務(wù)處理能力。如果你想要更新多條數(shù)據(jù),你不得不運(yùn)作你自己的事務(wù)處理流程。沒有放入事務(wù)處理能力是因?yàn)闀黾酉到y(tǒng)設(shè)計的復(fù)雜度。回想起來,很對團(tuán)隊(duì)想要有那種能力,他們各自獨(dú)立(在上層)去添加這個能力,也獲得了不同程度成功。我們應(yīng)該在核心系統(tǒng)實(shí)現(xiàn)事務(wù)處理能力。它在內(nèi)部應(yīng)用場景也會很有用。Spanner系統(tǒng)增加了事務(wù)處理搞定了這個問題。

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://specialneedsforspecialkids.com/yun/4341.html

摘要:谷歌也不例外,在大會中介紹了人工智能近期的發(fā)展及其對計算機(jī)系統(tǒng)設(shè)計的影響,同時他也對進(jìn)行了詳細(xì)介紹。表示,在谷歌產(chǎn)品中的應(yīng)用已經(jīng)超過了個月,用于搜索神經(jīng)機(jī)器翻譯的系統(tǒng)等。此外,學(xué)習(xí)優(yōu)化更新規(guī)則也是自動機(jī)器學(xué)習(xí)趨勢中的一個信號。 在剛剛結(jié)束的 2017 年國際高性能微處理器研討會(Hot Chips 2017)上,微軟、百度、英特爾等公司都發(fā)布了一系列硬件方面的新信息,比如微軟的 Projec...

摘要:深度學(xué)習(xí)現(xiàn)在被視為能夠超越那些更加直接的機(jī)器學(xué)習(xí)的關(guān)鍵一步。的加入只是谷歌那一季一系列重大聘任之一。當(dāng)下谷歌醉心于深度學(xué)習(xí),顯然是認(rèn)為這將引發(fā)下一代搜索的重大突破。移動計算的出現(xiàn)已經(jīng)迫使谷歌改變搜索引擎的本質(zhì)特征。 Geoffrey Hiton說:我需要了解一下你的背景,你有理科學(xué)位嗎?Hiton站在位于加利福尼亞山景城谷歌園區(qū)辦公室的一塊白板前,2013年他以杰出研究者身份加入這家公司。H...

摘要:今年月,谷歌發(fā)布了。在谷歌內(nèi)部被稱為的方法中,一個控制器神經(jīng)網(wǎng)絡(luò)可以提出一個子模型架構(gòu),然后可以在特定任務(wù)中對其進(jìn)行訓(xùn)練和評估質(zhì)量。對于整個領(lǐng)域來說,一定是下一個時代發(fā)展重點(diǎn),并且極有可能是機(jī)器學(xué)習(xí)的大殺器。 為什么我們需要 AutoML?在談?wù)撨@個問題之前,我們需要先弄清楚機(jī)器學(xué)習(xí)的一般步驟。其實(shí),不論是圖像識別、語音識別還是其他的機(jī)器學(xué)習(xí)項(xiàng)目,其結(jié)構(gòu)差別是很小的,一個效果好的模型需要大量...

摘要:根據(jù)百度的說法,這是全球首次將深度學(xué)習(xí)領(lǐng)域技術(shù)應(yīng)用在客戶端,獨(dú)創(chuàng)了深度神經(jīng)網(wǎng)絡(luò)查殺技術(shù)。在過去,吳恩達(dá)說,百度用神經(jīng)網(wǎng)絡(luò)來幫助偵測廣告。 吳恩達(dá)拿起他的手機(jī),打開了臉優(yōu) app。他現(xiàn)在正位于硅谷公司的研究室。在辦公桌邊吃飯,談話內(nèi)容很自然地也涉及到人工智能。他是百度的首席科學(xué)家,同時也是斯坦福大學(xué)計算機(jī)系的教授。在其他搜索引擎仍在發(fā)展時,他就曾幫助谷歌啟動了腦計劃,現(xiàn)在他在百度從事相似的人工...

摘要:我的核心觀點(diǎn)是盡管我提出了這么多問題,但我不認(rèn)為我們需要放棄深度學(xué)習(xí)。對于層級特征,深度學(xué)習(xí)是非常好,也許是有史以來效果較好的。認(rèn)為有問題的是監(jiān)督學(xué)習(xí),并非深度學(xué)習(xí)。但是,其他監(jiān)督學(xué)習(xí)技術(shù)同病相連,無法真正幫助深度學(xué)習(xí)。 所有真理必經(jīng)過三個階段:第一,被嘲笑;第二,被激烈反對;第三,被不證自明地接受。——叔本華(德國哲學(xué)家,1788-1860)在上篇文章中(參見:打響新年第一炮,Gary M...

閱讀 4361·2021-11-22 09:34

閱讀 2689·2021-11-12 10:36

閱讀 742·2021-08-18 10:23

閱讀 2636·2019-08-30 15:55

閱讀 3110·2019-08-30 15:53

閱讀 2081·2019-08-30 15:44

閱讀 1361·2019-08-29 15:37

閱讀 1401·2019-08-29 13:04