資訊專欄INFORMATION COLUMN

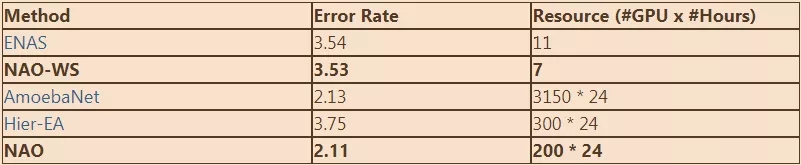

摘要:有了我們的新方法,叫做神經(jīng)架構(gòu)優(yōu)化,我們利用基于梯度的方法在更緊密的空間中做優(yōu)化。表如下展示了不同卷積神經(jīng)網(wǎng)絡(luò)架構(gòu)在圖片分類數(shù)據(jù)集上的表現(xiàn),這些架構(gòu)由不同算法生成。

如果你是一名深度學(xué)習(xí)實(shí)踐者,你可能發(fā)現(xiàn)自己經(jīng)常會(huì)遇到同一個(gè)關(guān)鍵問(wèn)題:我應(yīng)該為現(xiàn)在的任務(wù)選擇哪種神經(jīng)網(wǎng)絡(luò)架構(gòu)?這個(gè)決定取決于多種因素以及很多其他問(wèn)題的答案。我應(yīng)該給這一層選擇什么操作----卷積,深度可分卷積,或者較大池化?卷積層應(yīng)該選多大的核?3*3 還是 1*1 ? 還有哪個(gè)節(jié)點(diǎn)該拿來(lái)作為循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)節(jié)點(diǎn)的輸入?這些決定對(duì)架構(gòu)的成功至關(guān)重要。如果你既是神經(jīng)網(wǎng)絡(luò)建模也是手頭特定任務(wù)的專家,你可能很容易找到答案。但如果你在某一方面的經(jīng)驗(yàn)有限呢?

這種情況下,你可能會(huì)嘗試神經(jīng)架構(gòu)搜索(NAS),這是一種自動(dòng)的過(guò)程,另一個(gè)機(jī)器學(xué)習(xí)算法根據(jù)以往觀察到的架構(gòu)和他們的表現(xiàn),來(lái)指導(dǎo)創(chuàng)建更好的架構(gòu)。多虧了NAS,我們可以發(fā)現(xiàn)在被廣泛使用的公開(kāi)數(shù)據(jù)集,比如 ImageNet, 上表現(xiàn)較好的神經(jīng)網(wǎng)絡(luò)架構(gòu),且不需要人工干預(yù)。

然而現(xiàn)存的自動(dòng)設(shè)計(jì)神經(jīng)網(wǎng)絡(luò)架構(gòu)的方法 -- 通常基于增強(qiáng)學(xué)習(xí)或者進(jìn)化算法 -- 需要在指數(shù)級(jí)增長(zhǎng)的離散空間中做搜索,我的同伴和我在微軟亞洲研究院機(jī)器學(xué)習(xí)組 設(shè)計(jì)了一種簡(jiǎn)化的,更有效的方法,基于連續(xù)空間內(nèi)的優(yōu)化。有了我們的新方法,叫做 神經(jīng)架構(gòu)優(yōu)化 (NAO),我們利用基于梯度的方法在更緊密的空間中做優(yōu)化。這項(xiàng)工作參加了今年的 神經(jīng)信息處理系統(tǒng)會(huì)議 (NeurIPS)

NAO的關(guān)鍵組件

驅(qū)動(dòng)NAO進(jìn)行在連續(xù)空間中基于梯度的優(yōu)化,是靠以下三個(gè)組件:

一個(gè)把離散的神經(jīng)網(wǎng)絡(luò)架構(gòu)轉(zhuǎn)化為連續(xù)值向量的編碼器,也叫嵌入模型

一個(gè)結(jié)果預(yù)估函數(shù),它把向量作為輸入,并產(chǎn)生一個(gè)數(shù)值作為架構(gòu)的表現(xiàn) (比如,準(zhǔn)確率)

一個(gè)把連續(xù)值向量恢復(fù)成網(wǎng)絡(luò)架構(gòu)的解碼器

這三個(gè)組件是一起訓(xùn)練的。我們完成訓(xùn)練后,從一個(gè)架構(gòu)x 開(kāi)始,我們用編碼器E把x 轉(zhuǎn)化為向量表示 ex , 再通過(guò)結(jié)果預(yù)估函數(shù)f給的梯度方向,把ex 轉(zhuǎn)化為新的嵌入 ex` (如綠線表示)。既然我們?cè)谧鎏荻壬仙灰介L(zhǎng)夠小,我們就能保證 f(ex`) >= f(ex)。最后,我們用decoder D把ex`轉(zhuǎn)化為離散的架構(gòu) x`。這樣,我們得到了一個(gè)可能更好的架構(gòu) x`.通過(guò)不斷這樣更新架構(gòu)。我們得到了最終的架構(gòu),它應(yīng)該有較好的表現(xiàn)。

?圖1: NAO的流程

有有限的資源達(dá)到好的結(jié)果

我們做了后續(xù)的實(shí)驗(yàn)來(lái)驗(yàn)證NAO自動(dòng)發(fā)現(xiàn)較好神經(jīng)架構(gòu)的有效性。表1(如下)展示了不同卷積神經(jīng)網(wǎng)絡(luò)(CNN)架構(gòu)在CIFAR-10圖片分類數(shù)據(jù)集上的表現(xiàn),這些架構(gòu)由不同 NAS 算法生成。從表中我們可以看出,用NAO發(fā)現(xiàn)的網(wǎng)絡(luò)得到了較低的錯(cuò)誤率。另外,將NAO和權(quán)重共享機(jī)制結(jié)合起來(lái)(叫做 NAO-WS),我們得到了顯著的搜索速度提升。權(quán)重共享可以降低網(wǎng)絡(luò)架構(gòu)搜索的計(jì)算成本,它通過(guò)讓多種網(wǎng)絡(luò)結(jié)構(gòu)共用同一份參數(shù)來(lái)做到。在我們的實(shí)驗(yàn)中,我們用一塊圖像處理器(GPU),在7個(gè)小時(shí)內(nèi)得到了一個(gè)CNN架構(gòu),達(dá)到了3.53的錯(cuò)誤率。通過(guò)權(quán)重共享,我們不必從頭訓(xùn)練其它不同的神經(jīng)網(wǎng)絡(luò)。

表2(如下)總結(jié)了PTB語(yǔ)言模型的結(jié)果。越低的Perplexity表示更好的表現(xiàn)。又一次,我們用NAO來(lái)找到的RNN架構(gòu)取得了好結(jié)果,而且只用有限的計(jì)算資源。

通過(guò)在連續(xù)空間上的優(yōu)化,NAO得到了更好的結(jié)果,相比于現(xiàn)有的NAS方法,他們直接在離散架構(gòu)空間中搜索。至于未來(lái)的應(yīng)用,我們計(jì)劃用NAO來(lái)為其它重要的AI任務(wù)搜索架構(gòu),比如神經(jīng)機(jī)器翻譯。同樣重要的,更簡(jiǎn)單高效的自動(dòng)神經(jīng)架構(gòu)設(shè)計(jì),可以使機(jī)器學(xué)習(xí)技術(shù)為各階段的人所用。

表1:CIFAR-10分類結(jié)果

表2:PTB語(yǔ)言模型結(jié)果

聲明:文章收集于網(wǎng)絡(luò),如有侵權(quán),請(qǐng)聯(lián)系小編及時(shí)處理,謝謝!

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4836.html

摘要:是第一個(gè)提出體積小,計(jì)算量少,適用于移動(dòng)設(shè)備的卷積神經(jīng)網(wǎng)絡(luò)。圖卷積運(yùn)算匯總參考圖與神經(jīng)網(wǎng)絡(luò)架構(gòu)搜索卷積神經(jīng)網(wǎng)絡(luò)已被廣泛用于圖像分類人臉識(shí)別目標(biāo)檢測(cè)和其他領(lǐng)域。 1、基本卷積運(yùn)算手工設(shè)計(jì)輕量化模型主要思想在于設(shè)計(jì)更高效的網(wǎng)絡(luò)計(jì)算方式(主要針對(duì)卷積方式),從而使網(wǎng)絡(luò)參數(shù)減少,并且不損失網(wǎng)絡(luò)性能。本節(jié)概述了CNN模型(如MobileNet及其變體)中使用的基本卷積運(yùn)算單元,并基于空間維度和通道維度...

摘要:通過(guò)在中結(jié)合進(jìn)化算法執(zhí)行架構(gòu)搜索,谷歌開(kāi)發(fā)出了當(dāng)前較佳的圖像分類模型。本文是谷歌對(duì)該神經(jīng)網(wǎng)絡(luò)架構(gòu)搜索算法的技術(shù)解讀,其中涉及兩篇論文,分別是和。此外,谷歌還使用其新型芯片來(lái)擴(kuò)大計(jì)算規(guī)模。 通過(guò)在 AutoML 中結(jié)合進(jìn)化算法執(zhí)行架構(gòu)搜索,谷歌開(kāi)發(fā)出了當(dāng)前較佳的圖像分類模型 AmoebaNet。本文是谷歌對(duì)該神經(jīng)網(wǎng)絡(luò)架構(gòu)搜索算法的技術(shù)解讀,其中涉及兩篇論文,分別是《Large-Scale Ev...

閱讀 2725·2023-04-25 19:13

閱讀 4082·2021-09-22 15:34

閱讀 3074·2019-08-30 14:23

閱讀 1489·2019-08-29 17:17

閱讀 1632·2019-08-29 16:05

閱讀 1561·2019-08-29 13:26

閱讀 1237·2019-08-29 13:19

閱讀 576·2019-08-29 13:16