資訊專欄INFORMATION COLUMN

摘要:是商湯科技發表于的一篇目標檢測的論文,對架構的目標坐標回歸部分進行了替換,取得了更加較精確的定位精度,是最近非常值得一讀的論文。一作者信息該文所有作者均來自商湯科技該文直取網格修飾,意即將目標檢測中位置定位轉化為目標區域網格點的定位。

Grid R-CNN是商湯科技發表于arXiv的一篇目標檢測的論文,對Faster R-CNN架構的目標坐標回歸部分進行了替換,取得了更加較精確的定位精度,是最近非常值得一讀的論文。

今天就跟大家一起來細品此文妙處。

一、作者信息

該文所有作者均來自商湯科技:

該文直取Grid(網格)修飾R-CNN,意即將目標檢測中位置定位轉化為目標區域網格點的定位。

二、算法思想

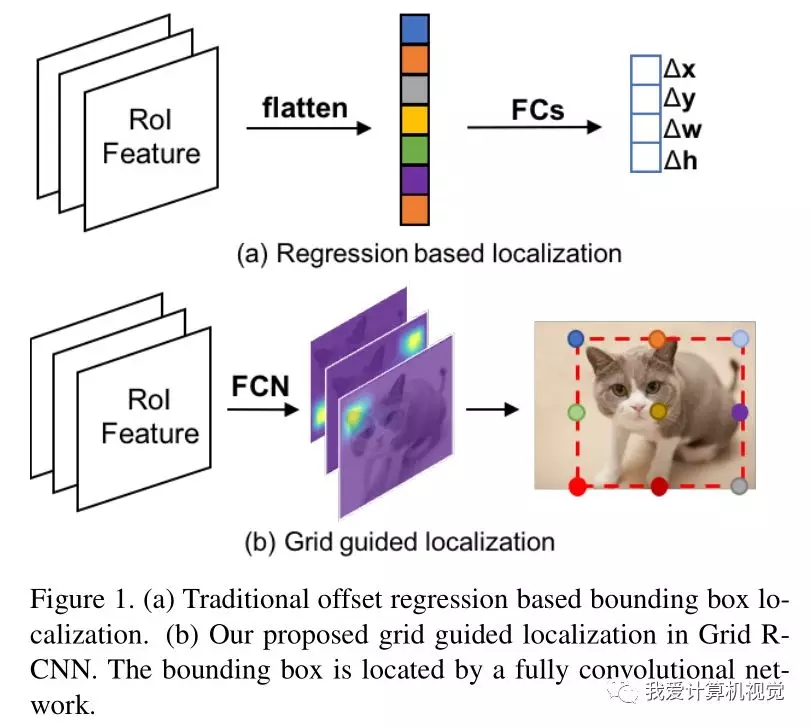

如下圖所示:

在目前的R-CNN目標檢測算法中,目標的2個點(比如左上和右下)就能表征其位置,將目標的定位看為回歸問題,即將ROI特征flatten成向量,后接幾個全連接層回歸目標的坐標偏移量和寬高。

作者認為,這種處理方式沒能很好的利用特征的空間信息。

作者希望利用全卷積網絡的較精確定位能力計算目標位置,將2個目標點的回歸問題,轉化為目標區域網格點(Grid Points)的定位問題。目標區域的網格點位置是全卷積網絡的監督信息,因為是直接將目標區域等分,是可以直接計算的。網絡推斷時,計算heatmap的極值,即為求得的網格點(Grid Points)。

上圖展示了使用3*3網格點的情況。

三、算法流程

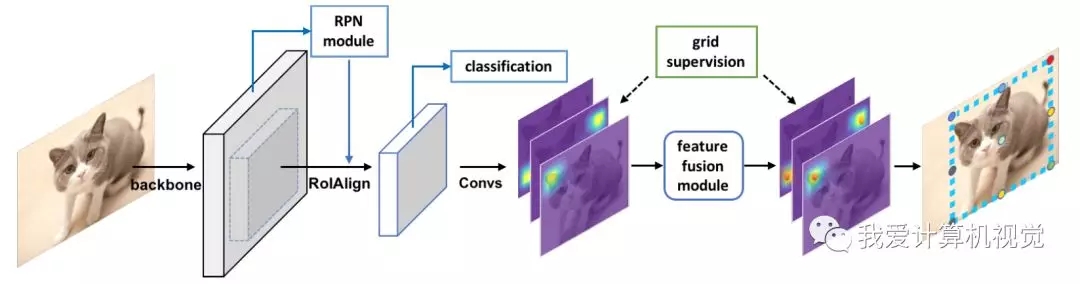

作者改造的是Faster R-CNN的目標定位部分,其算法流程如下:

前半部分與Faster R-CNN相同,在得到目標候選區域和ROI特征后,分類部分進行目標分類,而定位部分接全卷積網絡,其監督信息來自根據目標位置計算得到的網格監督信息。

流程圖中作者特別標出了特征融合模塊(feature fusion module),其意在使用網格中相鄰網格點的位置相關性,融合特征使得定位更加較精確。

以下針對其中關鍵步驟進行詳細說明。

3.1 網格引導定位

將目標區域劃為網格,目標的定位即轉化為網格點的定位。

訓練時,ROI特征(14*14大小)通過8個3*3空洞卷積,再通過兩個反卷積把尺寸擴大(56*56),再通過一個卷積生成與網格點相關的 heatmaps(9 個點就是 9 張圖,后文實驗也使用了4個點的情況)。監督信息是每一個點所處位置的交叉十字形狀的5個點的位置。最后再接sigmoid函數,在heapmaps上得到概率圖。

推斷時,將heapmaps極值的位置映射回原圖,即得到了網格點的位置。

讀到這里,讀者可能會有一個疑問,即計算得到的網格點組成的形狀是方方正正的,而Heapmaps極值得到的網格點未必組合在一起是方方正正的,不好確定目標區域。

作者的方法是對原本應該具有相同x或者y坐標的網格點的坐標進行平均。

到此,即得到了目標位置。

3.2 網格點特征融合

很顯然,網格點之間具有內在的聯系,相鄰網格點之間可以相互校正位置提高定位精度。

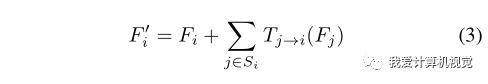

為此,作者設計了網格點特征融合的機制。

首先,在計算網格點heapmaps時,每個網格點使用不同的濾波器組,防止它們之間共用特征以至相互影響。

然后在每個網格點的Heapmap出來后,將相鄰網格點的Heapmaps經過卷積濾波與其相加,形成新的heapmap。

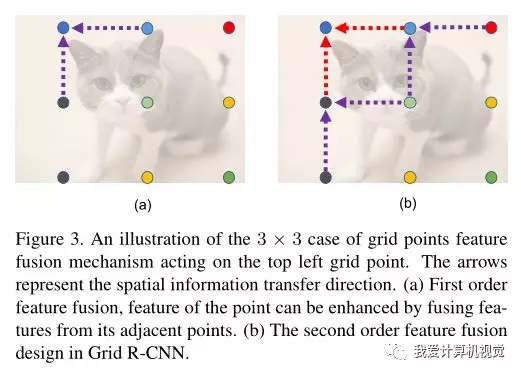

作者將距離特定網格點最近的相鄰網格點(1個單位網格長度)組成的網格點集合的特征融合稱為一階特征融合,次近的相鄰網格點(2個單位網格長度)組成的網格點集合的特征融合稱為二階特征融合。下圖中(a)(b)分別展示了此融合過程。

3.3 擴展區域映射

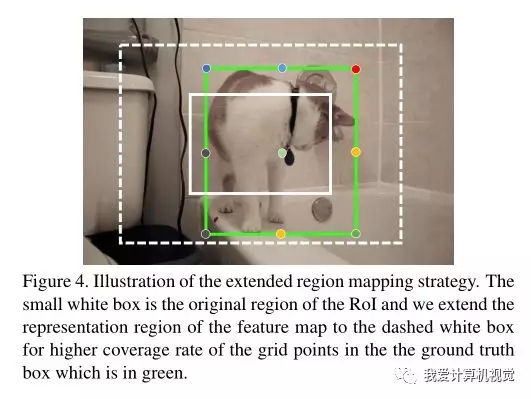

這一步主要是為了應對在實際使用中,RPN 給出的 proposal并不總是將完整物體包含在內。如下圖:

圖中白色的實線框表示 RPN 給出的候選框,它沒有完全包含所有的網格點。

而作者指出,簡單的擴大候選框的大小,不會帶來提升,甚至降低對小物體檢測的精度(后面有實驗驗證)。

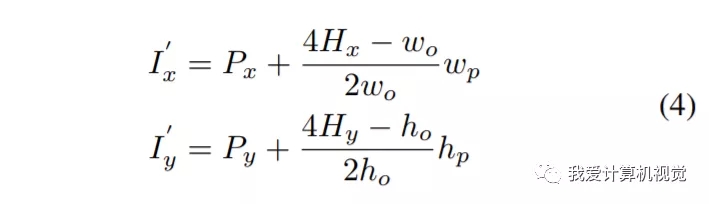

作者認為heatmap的感受野其實是很大的,并不限于候選框內,所以就干脆直接將heatmap對應的區域看成候選框覆蓋的區域兩倍大(如圖中虛線圍起來的區域)。

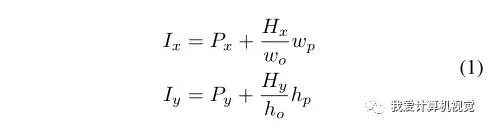

這么做的好處是,只需簡單修改網格引導定位中的位置映射公式。即

四、實驗結果

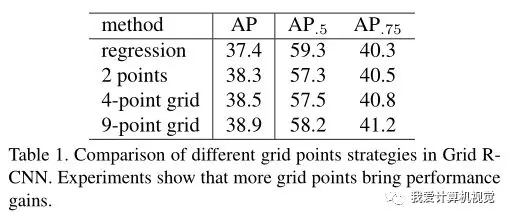

作者首先研究了算法中網格點數對精度的影響。如下圖:

相比回歸的方法,Grid R-CNN精度更高,而且隨著點數增加精度也在提高。

比較AP0.5和AP0.75發現,精度提升主要來自高IoU閾值的情況。

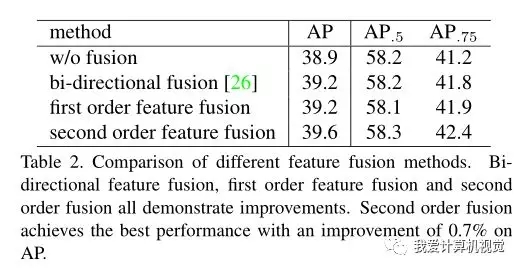

其次,作者實驗了網格點特征融合策略對性能的影響。如下圖:

可見該文提出的特征融合策略是有效的,而且二階特征融合更加有效。

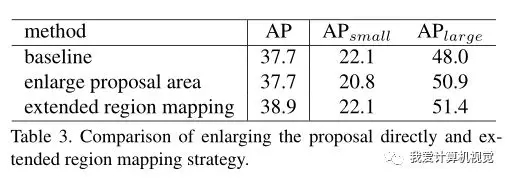

然后,作者實驗了擴展區域映射對精度的影響。如下圖:

可見,直接擴大候選框區域的方法傷害了精度,而本文提出的擴展區域映射(extended region mapping)的方法則使精度有較大的提高(1.2個AP)。

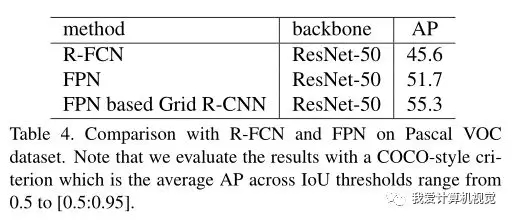

作者又在主流的目標檢測數據庫上與state-of-the-art進行了比較。

下圖展示了在Pascal VOC數據集上,相比R-FCN、FPN,使用相同骨干網的情況下,精度取得了極大的提升!

在COCO minival數據集上的實驗,同樣取得了較大幅度精度提升。

在COCO test-dev數據集上也實現了一騎絕塵!如下圖:

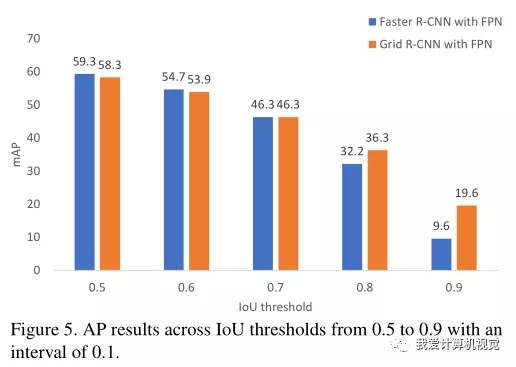

與Faster R-CNN相比,發現精度提升主要來自高IoU閾值的部分,如下圖所示。

所以作者猜測,Grid定位分支也許輕微影響了分類的分支。

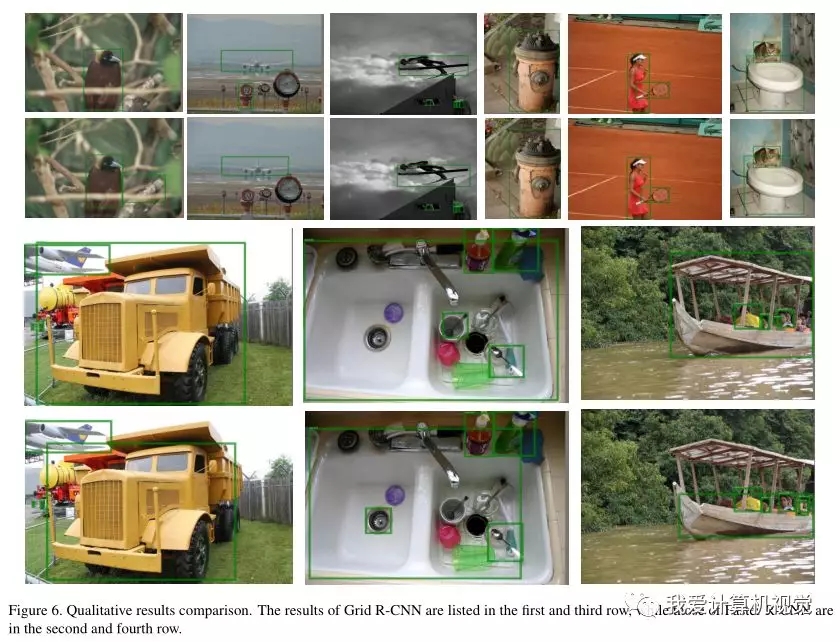

下圖是一些目標的定位示例:

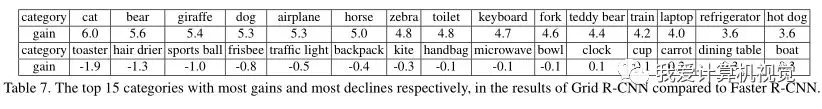

作者最后列出了Grid R-CNN對各目標類別的精度增益,發現那些矩形和長方形目標(例如鍵盤,筆記本電腦,叉子,火車和冰箱)往往獲得更大的精度增益,而具有圓形性質的物體(例如運動球,飛盤,碗,鐘和杯子)則性能下降或獲得較小的增益。

五、總結

該文反思了目標檢測中的定位問題,提出以覆蓋目標的網格點作為監督信息使用全卷積網絡定位網格點的方法,大幅提高了目標定位精度。值得研究目標檢測的朋友學習~

文中沒有提及推斷速度、代碼是否會開源,希望有進一步的消息出來。

目標定位的方法還有什么可挖掘的嗎?

你認為Grid R-CNN會成為Faster R-CNN那樣的傳世經典嗎?

論文網址:

https://arxiv.org/abs/1811.12030

聲明:文章收集于網絡,如有侵權,請聯系小編及時處理,謝謝!

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4831.html

摘要:近日,開源了和的實現基準。是商湯和港中文近日聯合開源的基于的開源目標檢測工具包。你也可以配置你自己的到數據集的路徑。 近日,Facebook AI Research 開源了 Faster R-CNN 和 Mask R-CNN 的 PyTorch 1.0 實現基準:MaskRCNN-Benchmark。相比 Detectron 和 mmdetection,MaskRCNN-Benchmark ...

摘要:目前目標檢測領域的深度學習方法主要分為兩類的目標檢測算法的目標檢測算法。原來多數的目標檢測算法都是只采用深層特征做預測,低層的特征語義信息比較少,但是目標位置準確高層的特征語義信息比較豐富,但是目標位置比較粗略。 目前目標檢測領域的深度學習方法主要分為兩類:two stage的目標檢測算法;one stage的目標檢測算法。前者是先由算法生成一系列作為樣本的候選框,再通過卷積神經網絡進行樣本...

閱讀 2679·2023-04-25 20:28

閱讀 1849·2021-11-22 09:34

閱讀 3687·2021-09-26 10:20

閱讀 1834·2021-09-22 16:05

閱讀 3085·2021-09-09 09:32

閱讀 2502·2021-08-31 09:40

閱讀 2099·2019-08-30 13:56

閱讀 3320·2019-08-29 17:01