資訊專欄INFORMATION COLUMN

摘要:表示類別為,坐標是的預測熱點圖,表示相應位置的,論文提出變體表示檢測目標的損失函數由于下采樣,模型生成的熱點圖相比輸入圖像分辨率低。模型訓練損失函數使同一目標的頂點進行分組,損失函數用于分離不同目標的頂點。

好久沒有將較好的“干貨”分享給大家,那今天我給大家帶來ECCV-2018年最優paper之一,也是目標檢測里的佼佼者,值得我們去深挖,去學習!

目標檢測算法概述

CornerNet可以說是今年ECCV一大亮點,其主要是由密歇根大學Hei Law等人創作,并在ECCV2018上發表,主要實現了更加精準的目標檢測算法。但是,今天在開始介紹接下來主角“CornerNet”之前,我帶大家先簡單回憶下object detection領域的主流算法,如果有興趣的您,可以瀏覽如下的文章:

超級干貨 | 從神經元到CNN、RNN、GAN…神經網絡看本文夠了

深度學習近期總結分析

接下來主要回顧之前流行算法的原因,是因為CornerNet的主要算法和現在的主流算法框架很很多不一樣。

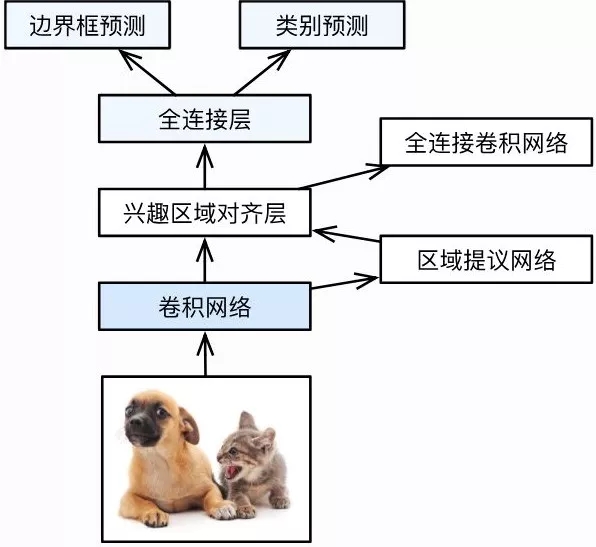

在深度學習領域的目標檢測算法中,現在主要分為One-stage(如:SSD, YOLO,YOLO后期還出了更多的較精確度和速度極高的版本)和Two-stage(如經典的RCNN系列)兩種。

One-stage是直接在輸入的圖片上經過各種卷積池化類的計算,從其意思也可以理解,就是一個階段,一般為end-to-end框架,經過復雜的計算后,最終生成detections。但是,Two-stage則與其與眾不同,其主要是先去提取候選區域, 再基于提取的候選區域進行第二次修正。

通過實驗和框架的計算復雜度明顯可以看得出,One-stage的網絡框架速度快, 但是最終的檢測精度會較低點,而Two-stage精度高, 但由于框架復雜度提高,檢測速度會隨之變慢,最終的選擇取決使用的實際應用。

自從AlexNet在ImageNet大賽上取得第一的成績,而且遠遠超越第二名,因此深度學習有一次出名,掀起了深度學習新的一次浪潮。之后,Ross Girshick又將卷積神經網絡(CNN)取代了傳統的HOG、HOF和DPM等特征提取方法。

具體的一些之前流行算法,您可以點擊如下鏈接進行閱讀。

深度學習近期總結分析

圖 1 Faster RCNN算法框架

Motivation

CornerNet認為Two-stage目標檢測最明顯的缺點是區域候選階段需要提取的anchor boxes。

提取的anchor boxes數量較多,比如DSSD使用40k,RetinaNet使用100k,anchor boxes眾多造成anchor boxes征服樣本均衡;

Anchor boxes需要調整很多超參數,比如anchor boxes數量、尺寸、比率,影響模型的訓練和推斷速率。

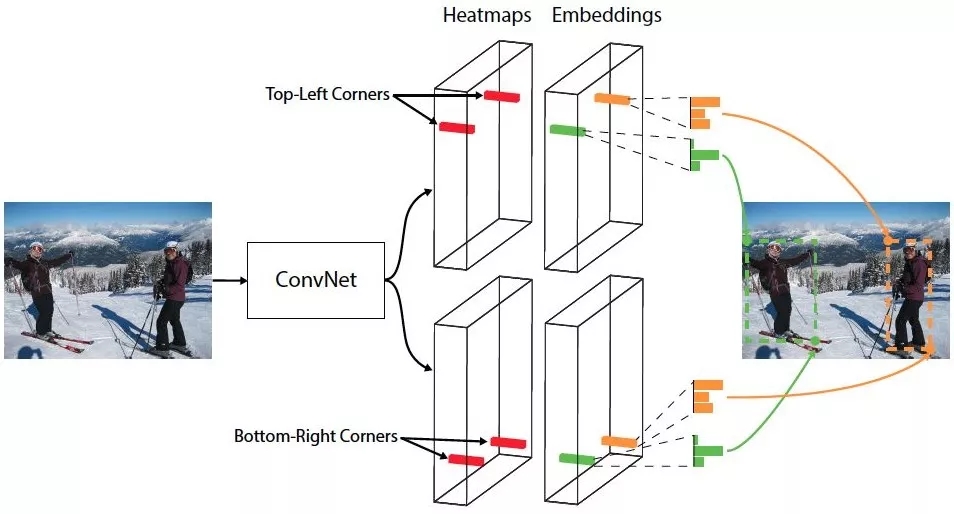

本次提出的One-stage的檢測方法,舍棄傳統的 anchor boxes思路,提出CornerNet模型預測目標邊界框的左上角和右下角一對頂點,即,使用單一卷積模型生成熱點圖和連接矢量:所有目標的左上角和所有目標的右下角熱點圖,每個頂點的連接矢量(embedding vector)。

圖 2 CornerNet框架

主要思路其實來源于一篇多人姿態估計的論文。

基于CNN的2D多人姿態估計方法,通常有2個思路(Bottom-Up Approaches和Top-Down Approaches):

Top-Down framework:就是先進行行人檢測,得到邊界框,然后在每一個邊界框中檢測人體關鍵點,連接成每個人的姿態,缺點是受人體檢測框影響較大,代表算法有RMPE;

Bottom-Up framework:就是先對整個圖片進行每個人體關鍵點部件的檢測,再將檢測到的人體部位拼接成每個人的姿態,代表方法就是openpose。

本次的第一個創新是講目標檢測上升到方法論,基于多人姿態估計的Bottom-Up思想,首先同時預測定位框的頂點對(左上角和右下角)熱點圖和embedding vector,根據embedding vector對頂點進行分組。

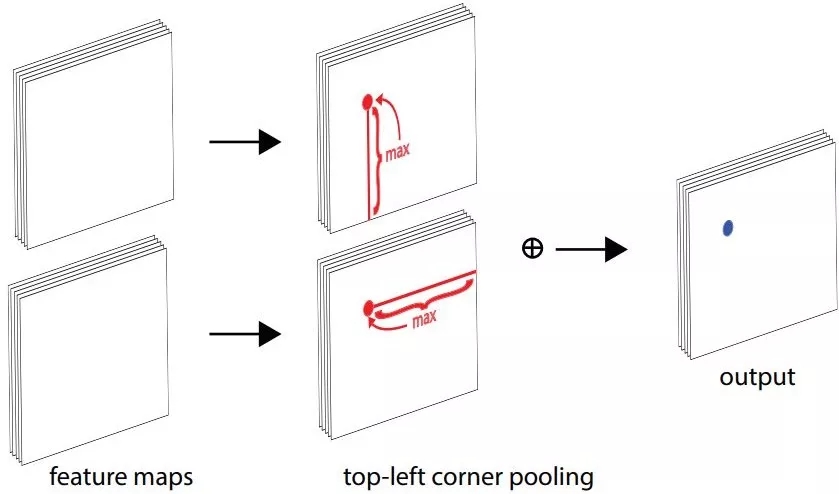

第二個創新是提出了corner pooling用于定位頂點。自然界的大部分目標是沒有邊界框也不會有矩形的頂點,依top-left corner pooling 為例,對每個channel,分別提取特征圖的水平和垂直方向的較大值,然后求和。

圖 3 corner pooling計算方式

本次paper認為corner pooling之所以有效,是因為:

目標定位框的中心難以確定,和邊界框的4條邊相關,但是每個頂點只與邊界框的兩條邊相關,所以corner 更容易提取;

頂點更有效提供離散的邊界空間,實用O(wh)頂點可以表示O(w2h2) anchor boxes。

Paper的第三個創新是模型基于hourglass架構,使用focal loss的變體訓練神經網絡。

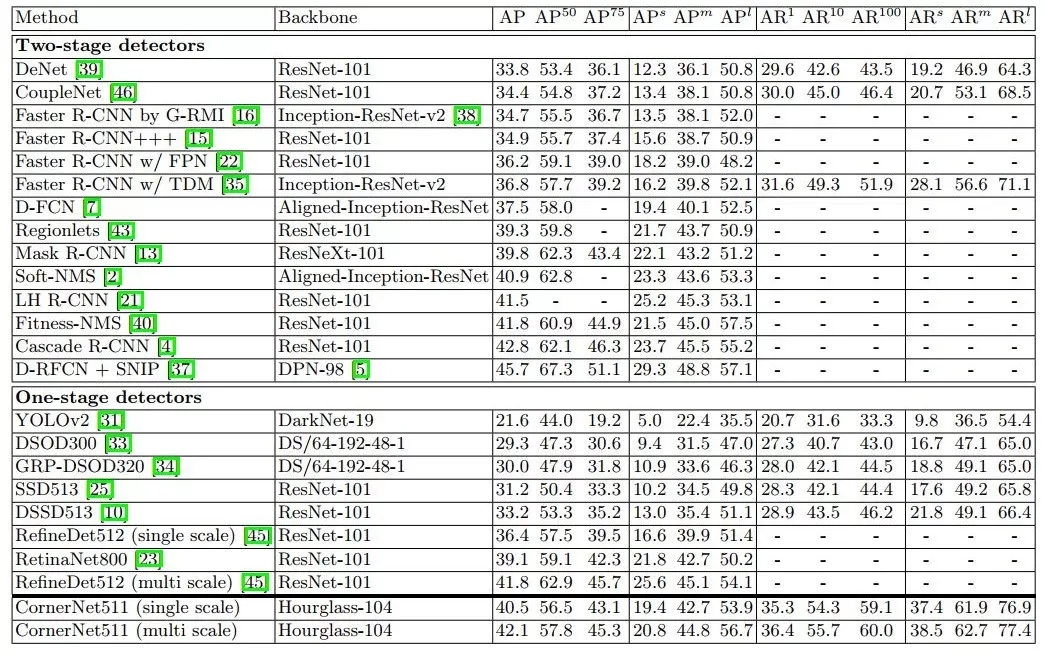

論文提出的CornerNet在MS COCO測試驗證,達到42.1% AP,完勝所有的One-stage目標檢測方法,基于PyTorch源碼請在公眾號回復CornerNet。

Architecture

Overview

圖 4 CornerNet模型架構

如圖 4所示,CornerNet模型架構包含三部分,Hourglass Network,Bottom-right corners&Top-left Corners Heatmaps和Prediction Module。

Hourglass Network是人體姿態估計的典型架構,論文堆疊兩個Hourglass Network生成Top-left和Bottom-right corners,每一個corners都包括corners Pooling,以及對應的Heatmaps, Embeddings vector和offsets。embedding vector使相同目標的兩個頂點(左上角和右下角)距離最短, offsets用于調整生成更加緊密的邊界定位框。

Detecting Corners

Paper模型生成的heatmaps包含C channels(C是目標的類別,沒有background channel),每個channel是二進制掩膜,表示相應類別的頂點位置。

對于每個頂點,只有一個ground-truth,其他位置都是負樣本。在訓練過程,模型減少負樣本,在每個ground-truth頂點設定半徑r區域內都是正樣本,這是因為落在半徑r區域內的頂點依然可以生成有效的邊界定位框,論文中設置IoU=0.7。

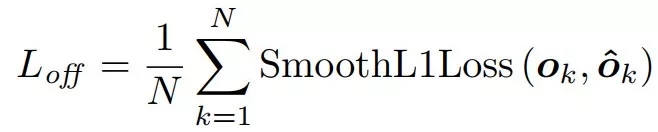

pcij表示類別為c,坐標是(i,j)的預測熱點圖,ycij表示相應位置的ground-truth,論文提出變體Focal loss表示檢測目標的損失函數:

由于下采樣,模型生成的熱點圖相比輸入圖像分辨率低。論文提出偏移的損失函數,用于微調corner和ground-truth偏移。

Grouping Corners

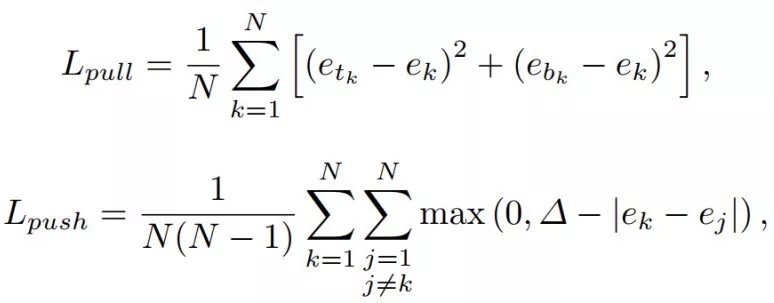

輸入圖像會有多個目標,相應生成多個目標的左上角和右下角頂點。對頂點進行分組,論文引入Associative Embedding的思想,模型在訓練階段為每個corner預測相應的embedding vector,通過embedding vector使同一目標的頂點對距離最短,既模型可以通過embedding vector為每個頂點分組。

模型訓練Lpull損失函數使同一目標的頂點進行分組, Lpush損失函數用于分離不同目標的頂點。

Hourglass Network

Hourglass Network同時包含了bottom-up(from high resolutions to low resolutions)和top-down (from low resolutions to high resolutions)。而且,整個網絡有多個bottom-up和top-down過程。這樣設計的目的是在各個尺度下抓取信息。針對目標檢測任務,論文調整了Hourglass一些策略。

Experiments

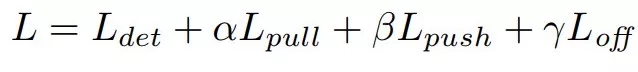

論文的訓練損失函數包含了第三部分介紹的4個損失函數,α, β 和γ用于調整相應損失函數的權重:

模型訓練過程中使用10個Titan X (PASCAL) GPUs,詳細的訓練參數可參考原論文。模型的推斷時間是244ms/ image (Titan XPASCAL GPU)。

CornerNet相比其它one-stage目標檢測算法,MS COCO數據集測試AP有明顯提高,雖然性能接近于Two-stage檢測算法,但是推斷時間無明顯優勢。

Table 4MS COCO test-dev數據集性能對比

Discussion

個人觀點:CornerNet創新來自于多人姿態估計的Bottom-Up思路,預測corner的heatmps,根據Embeddings vector對corner進行分組,其主干網絡也來自于姿態估計的Hourglass Network。模型的源碼請在公眾號回復:CornerNet獲取,可以放心研究測試。

CV的很多任務之間是相通的,CVPR2018 best paper也印證這一觀點,在不同的子領域尋找相似性,遷移不同領域的算法,是CV行業一個趨勢。

多人姿態估計的Hourglass Network算法也不斷改進中,其實論文模型的推斷速率受限于Hourglass Network的特征提取,有志青年也可以沿著這個思路取得更好的性能。

Newell, A., Huang, Z., Deng, J.: Associative embedding: End-to-end learning for joint detection and grouping. In: Advances in Neural Information Processing Systems. pp. 2274{2284 (2017)

Hei Law, Jia Deng :CornerNet: Detecting Objects as Paired Keypoints.ECCV2018

Girshick, R.: Fast r-cnn. arXiv preprint arXiv:1504.08083 (2015)

Girshick, R., Donahue, J., Darrell, T., Malik, J.: Rich feature hierarchies for accurate object detection and semantic segmentation. In: Proceedings of the IEEE conference on computer vision and pattern recognition. pp. 580{587 (2014)

Lin, T.Y., Goyal, P., Girshick, R., He, K., Doll′ar, P.: Focal loss for dense object detection. arXiv preprint arXiv:1708.02002 (2017)

Liu, W., Anguelov, D., Erhan, D., Szegedy, C., Reed, S., Fu, C.Y., Berg, A.C.:SSD: Single shot multibox detector. In: European conference on computer vision.pp. 21{37. Springer (2016)

Newell, A., Yang, K., Deng, J.: Stacked hourglass networks for human pose estimation. In: European Conference on Computer Vision. pp. 483{499. Springer (2016)

Amir R. Zamir , Alexander Sax Taskonomy: Disentangling Task Transfer Learning.CVPR2018

文章地址

https://arxiv.org/abs/1808.01244

聲明:文章收集于網絡,如有侵權,請聯系小編及時處理,謝謝!

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4829.html

摘要:表示類別為,坐標是的預測熱點圖,表示相應位置的,論文提出變體表示檢測目標的損失函數由于下采樣,模型生成的熱點圖相比輸入圖像分辨率低。模型訓練損失函數使同一目標的頂點進行分組,損失函數用于分離不同目標的頂點。 本文由極市博客原創,作者陳泰紅。 1.目標檢測算法概述 CornerNet(https://arxiv.org/abs/1808.01244)是密歇根大學Hei Law等人在發表E...

摘要:所以,我們美團外賣技術團隊嘗試結合技術,來協助設計師避免這種低收益高重復的任務,同時低成本高效率高質量地完成海報圖片的生成。圖封面配色布局設計在設計領域的一些子問題上,可以用算法來挖掘出數據背后的規律如圖所示。 背景 在視覺設計領域中,設計師們往往會因為一些簡單需求付出相當多的時間,比如修改文案內容,設計簡單的海報版式,針對不同機型、展位的多尺寸拓展等。這些工作需要耗費大量的時間、人力...

摘要:為了探索多種訓練方案,何愷明等人嘗試了在不同的迭代周期降低學習率。實驗中,何愷明等人還用預訓練了同樣的模型,再進行微調,成績沒有任何提升。何愷明在論文中用來形容這個結果。 何愷明,RBG,Piotr Dollár。三位從Mask R-CNN就開始合作的大神搭檔,剛剛再次聯手,一文終結了ImageNet預訓練時代。他們所針對的是當前計算機視覺研究中的一種常規操作:管它什么任務,拿來ImageN...

摘要:是你學習從入門到專家必備的學習路線和優質學習資源。的數學基礎最主要是高等數學線性代數概率論與數理統計三門課程,這三門課程是本科必修的。其作為機器學習的入門和進階資料非常適合。書籍介紹深度學習通常又被稱為花書,深度學習領域最經典的暢銷書。 showImg(https://segmentfault.com/img/remote/1460000019011569); 【導讀】本文由知名開源平...

閱讀 1458·2021-11-24 09:39

閱讀 1775·2021-11-22 15:25

閱讀 3728·2021-11-19 09:40

閱讀 3283·2021-09-22 15:31

閱讀 1288·2021-07-29 13:49

閱讀 1192·2019-08-26 11:59

閱讀 1308·2019-08-26 11:39

閱讀 919·2019-08-26 11:00