資訊專欄INFORMATION COLUMN

摘要:目前,這些選擇又稱為超參數是通過經驗,隨機搜索或計算密集型搜索過程來選擇的。該技術是超參數優化最常用的兩種方法隨機搜索和手動調試的結合。隨機搜索中會并行訓練神經網絡的群體,并在訓練結束時選擇較高性能的模型。

在圍棋和Atari游戲、圖像識別與語言翻譯等領域,神經網絡都取得了巨大的成功。但經常被忽視的一點是,神經網絡在這些特定應用中的成功往往取決于研究開始時做出的一系列選擇,包括:使用何種類型的網絡、用于訓練的數據和方法等。目前,這些選擇(又稱為超參數)是通過經驗,隨機搜索或計算密集型搜索過程來選擇的。如何選擇參數和調參往往成為訓練神經網絡的關鍵問題。

AI科技評論發現,在DeepMind最近一篇名為《Population Based Training of Neural Network》的論文中,DeepMind提出了一種名為PBT(Population Based Training)訓練神經網絡的新方法,使得實驗者能夠快速地選擇較佳的超參數集和模型。這一技術可同時訓練和優化一系列網絡,從而可以快速找到較佳的設置。更重要的是,這不會增加額外的計算開銷,可以像傳統技術一樣快速地完成,并且易于集成到現有的機器學習管道中。

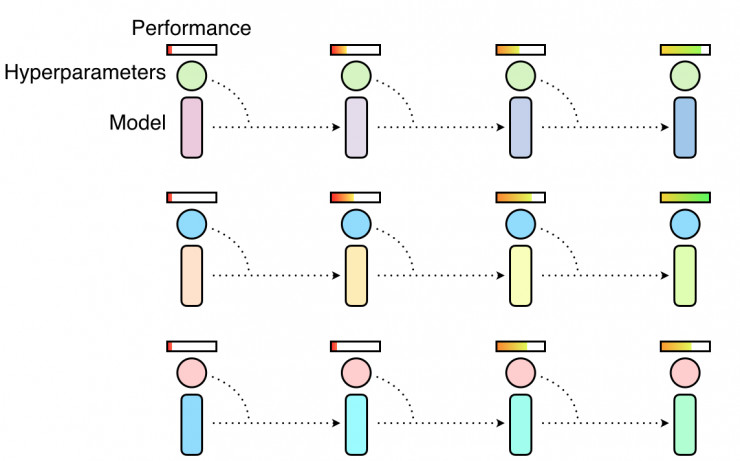

該技術是超參數優化最常用的兩種方法隨機搜索和手動調試的結合。隨機搜索中會并行訓練神經網絡的群體,并在訓練結束時選擇較高性能的模型。通常情況下,這意味著只有一小部分群體會獲得良好的超參數訓練,但更多的群體培訓效果欠佳,浪費計算機資源。

隨機搜索超參數意味著同時并行獨立訓練多個超參數,某些超參數會讓模型表現良好,但大多數不會

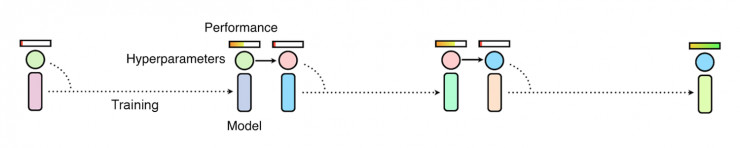

如果我們使用手動調整超參數,研究人員必須猜測較好的超參數,使用它們訓練模型和評估性能,這樣的過程將持續重復,直到研究人員對網絡的性能感到滿意為止。雖然手動調參可以帶來更好的性能,但是缺點是這需要很長時間,有時需要數周甚至數月才能找到完美的設置。雖然有諸如貝葉斯優化等一些自動化方法,但是仍然需要很長的時間,并且需要很多持續的訓練來找到較好的超參數。

手動調參及貝葉斯優化等方法通過一次觀察多個訓練過程來改變超參數,這通常較為緩慢

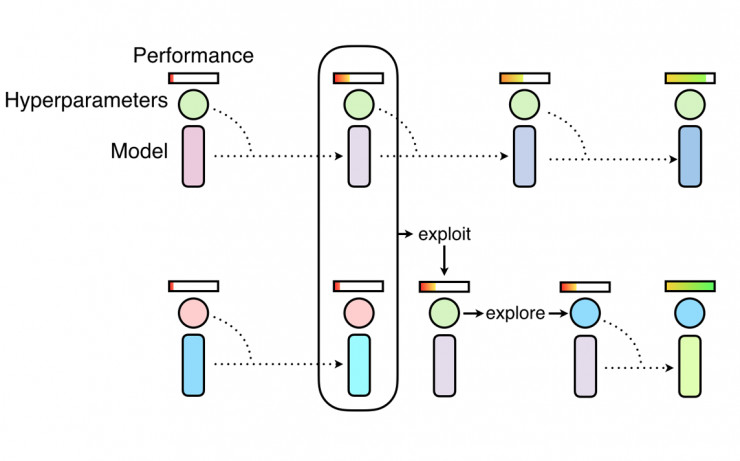

如同隨機搜索一樣,PBT首先也會并行訓練多個神經網絡與隨機超參,但是每一個網絡不是獨立訓練的,而是使用來自其他群體的信息來完善超參數,并將計算資源引導到更有優秀的模型。這以算法靈感來自于于遺傳算法,每個群體成員都被稱為“工人”,并可以利用其余群體成員的信息,如從另一個性能較好的“工人”中復制模型參數,此外,它還可以通過隨機更改當前值來探索新的超參數。

隨著對神經網絡群體訓練的不斷深入,這一開發和探索的過程會定期進行,以確保所有群體中的“工人”都有一個良好的基礎性能水平,并且在此基礎上在探索新的超參數。這意味著PBT可以快速利用好的超參數,可以為更有效的模型提供更多的訓練時間,而且可以在整個訓練過程中調整超參數值,從而自動學習較佳配置。

PBT從隨機搜索開始,但允許相互利用更有效的結果,并隨著訓練的進行探索新的超參數

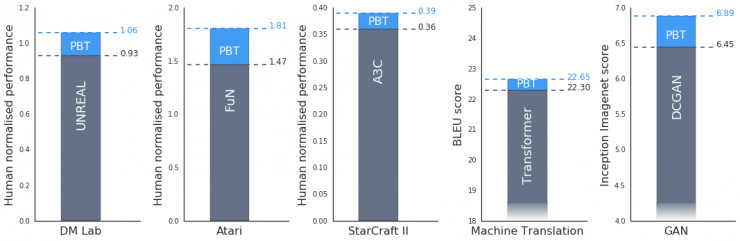

實驗表明,PBT在整個任務和領域都非常有效。DeepMind在DeepMind Lab,Atari和StarCraft II上使用較先進的方法嚴格測試了一套具有挑戰性的強化學習問題,在所有情況下,PBT穩定的訓練方式均能很快就找到了好的超參數,并得到了超出基線的結果。

此外,PBT對訓練生成對抗網絡(GAN)同樣有著一定的提升。在DeepMind使用PBT框架來較大化Inception Score(AI科技評論注:Inception Score是衡量視覺保真度的指標之一)的測試中,結果從6.45顯著提升到了6.9。

DeepMind也將PBT應用于Google較先進的機器翻譯神經網絡之一。這些神經網絡通常經過精心設計的超參數時間表進行培訓,這往往需要數月時間才能有改善。使用PBT可以自動找到超參數的時間表,這些時間表可以匹配甚至超過現有的表現,但不需要任何調整,同時通常只需要一次訓練。

圖為在CPSAR-10和封閉網絡(FuN)用GANs對“吃豆小姐”(Ms Pacman)游戲訓練過程中群體的演化過程。粉紅色的點代表最初的智能體,藍色為最終的智能體。

DeepMind認為,這項技術仍然存在很大的擴展空間。PBT對訓練引入新超參數的新算法和神經網絡體系結構尤其有效,隨著不斷細化這個過程,PBT有望更好地應用于尋找和開發更復雜和更強大的神經網絡模型。

完整論文下載鏈接:https://deepmind.com/documents/135/population_based_training.pdf

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4691.html

摘要:近日,發表了一篇文章,詳細討論了為深度學習模型尋找較佳超參數集的有效策略。要知道,與機器學習模型不同,深度學習模型里面充滿了各種超參數。此外,在半自動全自動深度學習過程中,超參數搜索也是的一個非常重要的階段。 在文章開始之前,我想問你一個問題:你已經厭倦了小心翼翼地照看你的深度學習模型嗎?如果是的話,那你就來對地方了。近日,FloydHub Blog發表了一篇文章,詳細討論了為深度學習模型尋...

摘要:例如,即插即用生成網絡通過優化結合了自動編碼器損失,損失,和通過與訓練的分類器定于的分類損失的目標函數,得到了較高水平的樣本。該論文中,作者提出了結合的原則性方法。 在機器學習研究領域,生成式對抗網絡(GAN)在學習生成模型方面占據著統治性的地位,在使用圖像數據進行訓練的時候,GAN能夠生成視覺上以假亂真的圖像樣本。但是這種靈活的算法也伴隨著優化的不穩定性,導致模式崩潰(mode colla...

摘要:文本谷歌神經機器翻譯去年,谷歌宣布上線的新模型,并詳細介紹了所使用的網絡架構循環神經網絡。目前唇讀的準確度已經超過了人類。在該技術的發展過程中,谷歌還給出了新的,它包含了大量的復雜案例。谷歌收集該數據集的目的是教神經網絡畫畫。 1. 文本1.1 谷歌神經機器翻譯去年,谷歌宣布上線 Google Translate 的新模型,并詳細介紹了所使用的網絡架構——循環神經網絡(RNN)。關鍵結果:與...

摘要:康納爾大學數學博士博士后則認為,圖神經網絡可能解決圖靈獎得主指出的深度學習無法做因果推理的核心問題。圖靈獎得主深度學習的因果推理之殤年初,承接有關深度學習煉金術的辯論,深度學習又迎來了一位重要的批評者。 作為行業的標桿,DeepMind的動向一直是AI業界關注的熱點。最近,這家世界最較高級的AI實驗室似乎是把他們的重點放在了探索關系上面,6月份以來,接連發布了好幾篇帶關系的論文,比如:關系歸...

閱讀 652·2021-11-23 09:51

閱讀 3599·2021-11-15 11:38

閱讀 926·2021-10-14 09:42

閱讀 3162·2021-09-29 09:35

閱讀 2104·2021-09-03 10:33

閱讀 769·2021-07-30 16:33

閱讀 1558·2019-08-30 15:55

閱讀 1840·2019-08-30 14:04