資訊專欄INFORMATION COLUMN

摘要:人工智能的主流算法深度學習的歷史,堪稱也是深度學習三劍客和共同走過的年艱難而輝煌的不悔人生。之后使用一種稱為監督學習的方法來訓練感知器,以正確區分不同形狀。表示,多層次神經網絡的結構并不會使感知器強大到有實用價值。

人工智能的主流算法Deep Learning深度學習的歷史,堪稱Deep History, 也是深度學習三劍客Geoff Hinton, Yann LeCun 和Yoshua Bengio共同走過的30年艱難而輝煌的不悔人生。他們如何從當年的地下小團體成為今天引領人工智能的風云人物,我們來看看其中的精彩故事。

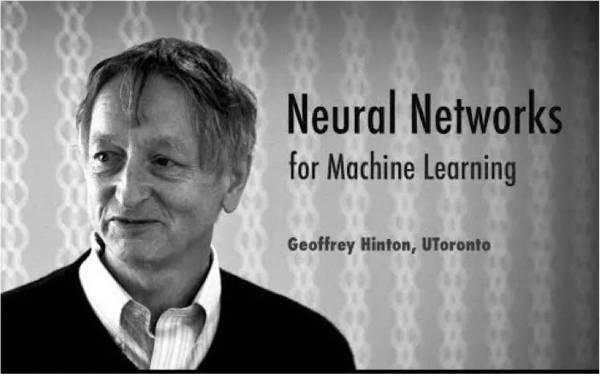

Geoff Hinton,谷歌大腦研究小組的負責人,出生在英國,1977年在愛丁堡大學獲得博士學位,開始對模擬神經網絡著迷。之后在加拿大多倫多大學任教,2013年他的公司DNNresearch被Google收購。他被稱為深度學習教父。

Yann LeCun, Facebook人工智能研究小組FAIR的主任,出生在巴黎,在 Université Pierre et Marie Curie獲得博士學位。曾在AT&T Bell Labs工作多年,2003年起在紐約大學NYU任教,2013年獲小扎邀請加盟Facebook。

Yoshua Bengio – ?Université de Montréal大學教授。出生在法國,在McGill University獲得博士學位,曾在MIT跟隨Michael Jordan教授做博士后研究,后任職 AT&T Bell Labs,1993年起在Université de Montréal任教。

Geoff Hinton, Godfather of Deep Learning

Geoff Hinton 和Yann LeCun已成為深度學習的領袖人物,人們津津樂道于他們提出的后傳播算法Backpropagation。其實在人工智能的研究中,他們只是復活了一個早已被遺忘的理論。?

當人工智能領域在20世紀50年代起步的時候,生物學家開始提出簡單的數學理論,來解釋智力和學習的能力如何產生于大腦神經元之間的信號傳遞。當時的核心思想一直保留到現在 - 如果這些細胞之間頻繁通信,神經元之間的聯系將得到加強。由新的體驗引發的神經活動的融合會調整大腦神經元間的連接,以便在它下次出現時,更容易理解。

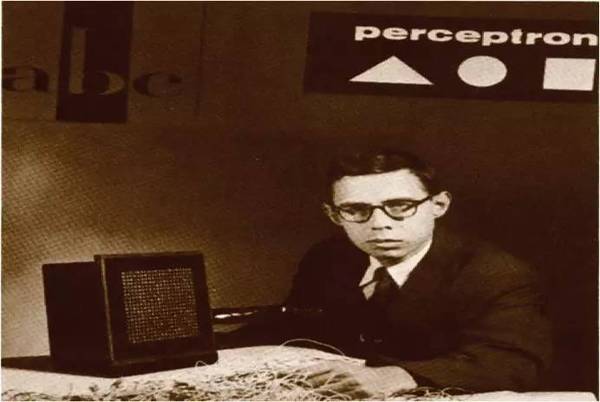

Frank Rosenblatt invented Perceptron?

這個故事要追溯到1956年,美國認知心理學家弗蘭克·羅森布拉特(Frank Rosenblatt)基于神經元的理論發明了一種模擬神經元的方法。紐約時報稱之為與"E-brain teaches itself." ?這個被Rosenblatt稱為感知器Perceptron的發明,可以學習如何將簡單的圖像分類為三角形和正方形。當時是在巨大的機器上實施模擬,纏繞著厚重的電線,但這為神經網絡創立了理論和實驗基礎。

Rosenblatts發明的電腦有八個模擬神經元,由電機和撥號盤連接到400個光檢測器。每個神經元都接收到來自光檢測器的信號的一部分,將它們組合起來,并且根據它們添加到哪里,輸出1或0。這些數字組成對感知器所看到的事物的描述。當然,最初的結果完全無效。之后Rosenblatt使用一種稱為監督學習的方法來訓練感知器,以正確區分不同形狀。他向感知器顯示一個圖像以及正確的答案,然后,機器將調整每個神經元對其輸入信號的關注度,將這些“權重”轉移到將產生正確答案的設置。

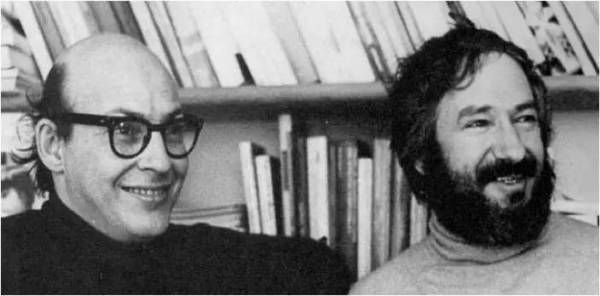

Marvin Minsky and Seymour Papert at MIT?

在試過多次之后,這些調整使計算機具有足夠的智能,可正確地對之前從未見過的圖像進行分類。今天的深度學習網絡使用復雜的算法,并擁有數百萬個模擬神經元,它們之間有數十億個連接,也是以同樣的方式訓練的。 ??

Rosenblatt預測,感知器很快就能夠學會向人打招呼。他的想法成為人工智能新生領域的基石。當時研究工作的重點是使感知器具有更復雜的網絡,排列成多個學習層的結構,在圖層中連續傳遞圖像或其他數據,使感知器能夠解決更復雜的問題。 ?

不幸的是,Rosenblatt的學習算法當時對于多層結構的神經網絡不起作用。在1969年,曾與他一起上過高中的人工智能先驅,MIT的權威人士Marvin Minsky,和知名專家Seymour Papert一起,寫了一本批評感知器學派的書Perceptrons,扼殺了當時對神經網絡的研究興趣。Minsky表示,多層次神經網絡的結構并不會使感知器強大到有實用價值。人工智能學者們也因此放棄了學習式軟件的想法。他們轉而使用邏輯來產生智能 - 比如下棋的能力。神經網絡則被推到了計算機科學的邊緣。

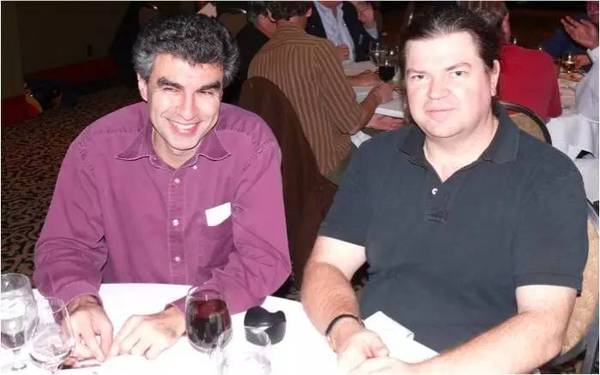

Geoff Hinton and Yann Lecun

盡管如此,20世紀80年代初,LeCun在巴黎讀博士時,第一次讀到感知器perceptrons還是被迷住了。 “我很驚訝,這種算法很有價值,不知道為什么人們會放棄它。“ ?他在圖書館度過了幾天,瘋狂尋找感知器消失之前發表的論文。然后他發現,在美國有一小群研究人員正在秘密地繼續神經網絡的工作。 “這是一個非常地下的運動,” 他說。在文章中仔細避開“神經”和“學習”這樣的詞,以避免論文審稿人的拒絕,他們正在研究一些非常像羅森布拉特碰到的老問題,嘗試如何采用多層結構來訓練神經網絡。?

1985年,LeCun遇到了這個地下組織的核心人物Geoff Hinton,他很快加入了這個小團隊。LeCun和Hinton很快成為好朋友,相互崇拜,他們一起成為恢復神經網絡思想的小團體的核心。他們認為模擬自然智力中看到的核心機制是構建人工智能的途徑。 “智能產生于人腦,所以從長遠來看,人工智能應該像大腦系統一樣工作,”Hinton說。

之后Lecun在貝爾實驗室取得成功,他和Hinton等人完善了一個具有多層神經網絡的學習算法,稱為反向傳播算法Backpropagation,引起了心理學家和計算機科學家的興趣。但是,在LeCun的支票識別項目結束之后,反向傳播似乎很難適用于其他問題。而這時一個新的數據排序的方法是由貝爾實驗室的研究員發明,它不涉及模擬神經元,被視為數學上更為優雅的方法。很快,這個方法成為很多互聯網公司的基石,如谷歌,亞馬遜和LinkedIn,它被用來訓練過濾垃圾郵件的系統,或為您推薦要購買的東西。

Yoshua Bengio and Yann Lecun

但Lecun并未放棄多層神經網絡的研究。2003年,他到紐約大學之后,就和Hinton, 及第三個合作者 -蒙特利爾大學教授Yoshua Bengio,一起組成了所謂的“深度學習的陰謀 Deep Learning Conspiracy”。為了證明神經網絡是有用的,他們悄悄地開發了更多層的神經網絡,用更大的數據集來訓練,并在更強大的計算機上運行。 LeCun的手寫識別系統已經有五層神經元,但這時他們已經開發了10層或更多的神經元網絡。

?到了2010年,深度學習算法在很多實際應用上開始超越其他技術,例如圖像排序。 Microsoft,Google和IBM均將深度學習的算法添加到語音識別系統中。但神經網絡對大多數研究人員來說仍然很陌生,并未被廣泛接受。 2012年初,當一篇取得視覺識別新紀錄的論文被一個領先的會議拒絕之后,LeCun甚至寫了一封措辭激烈的信,最初是匿名公布的,他指責論文評審人員“無知”和“有偏見”。 ?

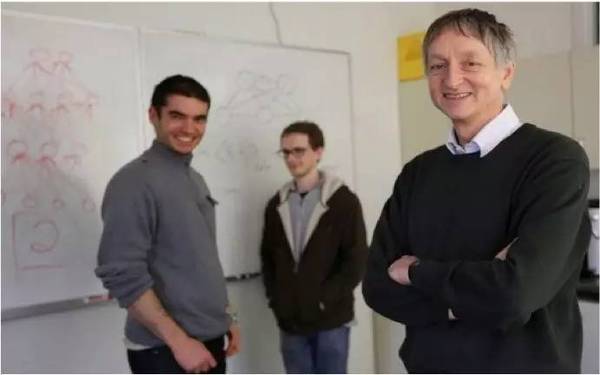

Geoff Hinton and his team won ImageNet Challenge

六個月后,一切都變了。 Hinton和兩位研究生采用深度學習算法,參加了ImageNet競賽并獲得第一名。ImageNet大型視覺識別挑戰賽,要求軟件識別1,000種不同物體,從蚊帳到清真寺。Hinton帶領的多倫多大學團隊在五次嘗試之內,以85%的準確度成功地識別出圖像中的物體,比第二名超出10個百分點。深度學習軟件的初始層的神經元在優化后可找出簡單的特征,例如邊緣和角落,更深層的神經元可找出更復雜的功能,如形狀,直至識別出狗或人。 ?

LeCun回憶說,當獲獎者介紹了他們的比賽結果之后,AI行業中長期對神經網絡不屑一顧的專家們蜂擁而至,來到他們的房間里 。“好吧,現在我們認同你,你贏了。”

此后,從事計算機視覺的學者們很快就放棄了之前的方法,深度學習算法從此成為人工智能研究的主流。鑒于Hinton團隊在ImageNet大賽的成績,谷歌在2013年收購了Hinton創立的公司DNNresearch。從此Hinton開始同時參于Google Brain的研究。

Mark Zuckerberg and Yann LeCun

2013年12月,Facebook首席執行官Mark Zuckerberg突然出現在較大的神經網絡研究會議上,并主持了一個派對,宣布LeCun加盟他們的人工智能研究中心FAIR,每周仍在紐約大學工作一天。?

LeCun至今仍然對Hinton 2012年在ImageNet大賽上的突破頗有感慨,這一年世界終于接受了他最早提出的觀點。 “在某種程度上,這應該是從我的實驗室出來的,” Hinton也表示贊同。“對于Yann來說,很可惜,這個突破不是他完成的。” 其實,對于贏得ImageNet挑戰背后的技術,LeCun的研究團隊作出的貢獻較大。很可惜Lecun的學生們畢業的時間不湊巧,忙于其他事情,讓他們錯過了參加ImageNet大賽。” 目前LeCun正在尋求深度學習的下一個突破,希望能和Hinton打個平手。

2015年5月,他們三人聯名在美國《Nature自然》雜志上發表了一篇論文-Deep Learning深度學習。經過30多年的不悔堅持,深度學習的三劍客終于從最初的秘密小團隊,成為AI主流研究的領袖人物,笑到了最后。

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4573.html

摘要:我強烈推薦這本書給初學者,因為本書側重于統計建模和機器學習的基本概念,并提供詳細而直觀的解釋。關于完善簡歷,我推薦以下網站和文章怎樣的作品集能幫助我們找到第一數據科學或機器學習方面的工作簡歷是不夠的,你還需要作品集的支撐。 showImg(https://segmentfault.com/img/bVblJ0R?w=800&h=533); 作者 | Admond Lee翻譯 | Mik...

摘要:年第一個產品與群雄逐鹿在發布了的產品,則標志著虛擬化的成熟并逐漸開啟了異構計算虛擬化的快速發展歷程。而其中的便是基于的分片虛擬化方案。圖形渲染虛擬化高性價比只此一款。各種新興行業也開始應用虛擬化技術。 摘要: GPU深度好文系列,阿里云技術專家分享 第一章 GPU虛擬化發展史 GPU的虛擬化發展歷程事實上與公有云市場和云計算應用場景的普及息息相關。如果在10年前談起云計算,大部分人的...

摘要:年第一個產品與群雄逐鹿在發布了的產品,則標志著虛擬化的成熟并逐漸開啟了異構計算虛擬化的快速發展歷程。而其中的便是基于的分片虛擬化方案。圖形渲染虛擬化高性價比只此一款。各種新興行業也開始應用虛擬化技術。 摘要: GPU深度好文系列,阿里云技術專家分享 第一章 GPU虛擬化發展史 GPU的虛擬化發展歷程事實上與公有云市場和云計算應用場景的普及息息相關。如果在10年前談起云計算,大部分人的...

摘要:隨后深度學習的研究大放異彩,廣泛應用在了圖像處理和語音識別領域。比如的學生就用深度學習算法贏得年的。深度學習和人工智能的春天離人工智能最近的互聯網公司敏銳嗅到了這一機遇。 多倫多大學計算機系教授Geoffrey Hinton是Deep Learning的開山鼻祖,我們來講講他的故事。他有個傳奇的姑姑不過先來說說他姑姑吧,他姑姑Joan Hinton是一個與中國有關的具有傳奇經歷的人物,中文名...

摘要:為什么我又要重新開始寫機器學習相關的文章了最主要的原因是現在的機器學習和五年前十年前區別很大。深度學習帶來了什么深度學習最重要的東西就是自帶了特征學習,有時候也被翻譯為表征學習,簡單來說就是,不需要進行特別的特征抽取。 1.為什么我開始寫這個系列博客說五年前我還在某A云公司的時候,身在一個機器學習算法組,對機器學習懷有濃厚的興趣。花了好多的時間來試圖搞清楚各種流行的機器學習算法,經常周末也跟...

閱讀 818·2023-04-25 22:13

閱讀 2335·2019-08-30 15:56

閱讀 2217·2019-08-30 11:21

閱讀 650·2019-08-30 11:13

閱讀 2014·2019-08-26 14:06

閱讀 1950·2019-08-26 12:11

閱讀 2282·2019-08-23 16:55

閱讀 530·2019-08-23 15:30