資訊專欄INFORMATION COLUMN

摘要:在本任務中為,即歷史對話決策為,即下一步的對話。則是一個使得訓練穩定的平衡項。判別器只告訴機器對或錯,卻不告知哪部分對和哪部分錯,這對訓練帶來了很大隱患。實驗實驗的結果以及部分可以一定程度上體現對抗訓練的模型起到了預期的效果。

1、導讀

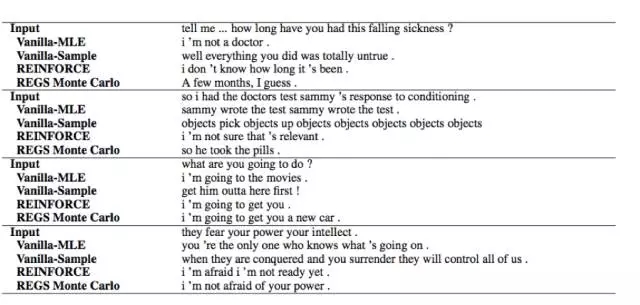

這篇文章的主要工作在于應用了對抗訓練(adversarial training)的思路來解決開放式對話生成(open-domain dialogue generation)這樣一個無監督的問題。其主體思想就是將整體任務劃分到兩個子系統上,一個是生成器(generative model),利用seq2seq式的模型以上文的句子作為輸入,輸出對應的對話語句;另一個則是一個判別器(discriminator),用以區分在前文條件下當前的問答是否是和人類行為接近,這里可以近似地看作是一個二分類分類器。兩者結合的工作機理也很直觀,生成器不斷根據前文生成答句,判別器則不斷用生成器的生成作為負例,原文的標準回答作為正例來強化分類。在兩者訓練的過程中,生成器需要不斷改良答案來欺騙生成器,判別器則需要不斷提高自身的判別能力從而區分機造和人造答案直至最后兩者收斂達到某種均衡。以往的模型受限于訓練目標以及訓練方式,其生成的結果往往是遲鈍籠統的甚至都很簡短(如果可以的話,所有的對話我都可以回答“呵呵”,很明顯這樣的回答是不符合常識的)。所以這樣一種博弈式的訓練方式來取代以往相對簡單固定的概率似然來優化這樣一種無監督的開放任務顯然是很有意義的想法。不過這樣的方法遇到困難也很明顯,GAN和NLP一直八字不合,很難很好的融合。和之前的工作SeqGAN類似,這篇工作也采取了增強學習來規避GAN在NLP中使用的難點,并作出了更多的嘗試。

2、模型

Generative model & Discriminativemodel:

生成器G就是一個seq2seq模型,輸入是歷史對話x,通過RNN來對語義進行向量表示再逐一生成回答的每個詞,從而形成回答y,由于該種模型已經有很大的人群認知,就不過多贅述。判別器D是一個輸入為歷史對話x和回答y二元組的一個二分類器,使用了hierarchicalencoder,其中機造回答組合為負例Q?({x,y}),人造回答組合為正例Q+({x, y})。

Policy Gradient Training:

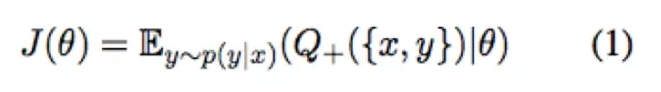

文中模型采用了policy gradient的方法(增強學習的方式之一)來進行增強學習的訓練,其優化目標為:

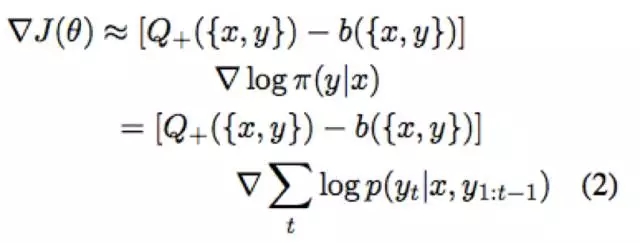

優化目標的導數可化為:

Q是判別器D的結果,換句話說判別器的鑒定結果可以看作是增強學習中的reward,policy gradient整體的優化目標其實就是希望回報高的決策其概率越高。在本任務中state為x,即歷史對話;決策為y,即下一步的對話。x生成y的概率等于逐詞生成的概率,如(2)所示,這里也可以很好的和seq2seq的工作機理對應上。b({x,y})則是一個使得訓練穩定的平衡項。

Reward for EveryGeneration Step (REGS) :

在本任務中增強學習的一個很大的問題在于我們的估價都是針對一整個回答的,判別器只會給出一個近似于對或者不對的反饋。這樣的模式存在一個很大的問題是,即使是很多被判斷為有問題的句子,其中有很大一部分語言成分是有效的,如文中的例子“what’s yourname”,人類回答“I am John”,機器回答“I don’t know”。判別器會給出“I don’t know”是有問題的,但無法給出I是對的而后面的don’t know是錯的,事實上機器沒有回答he/she/you/they而是I本質上是需要一個肯定的正反饋的。判別器只告訴機器對或錯,卻不告知哪部分對和哪部分錯,這對訓練帶來了很大隱患。所以文中采用了兩種方式,第一種是Monte Carlo,第二種則是使用局部序列來評估。第一種和之前的一些增強學習引入的工作類似就不做贅述,我們主要關注第二種方法。

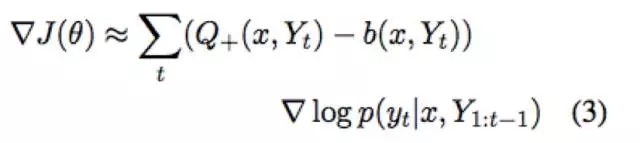

主要思想就是將二式變為三式,通俗點講就是把序列評分拆開來算,這樣就能算到前綴的評分,做到局部評價的反饋。為了防止訓練過擬合,每次只是從正例和負例的子序列中隨機選取一個來訓練。不過有一絲遺憾的是,這個方法快速也符合常識但會使得判別器變弱,實際效果不如Monte Carlo準確。

Teacher Forcing :

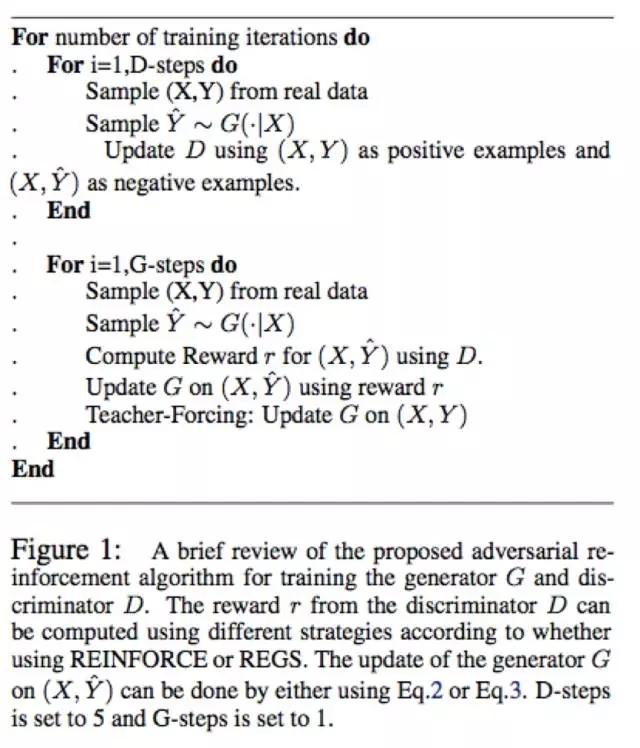

在以往的工作中,D效果非常好而G的效果非常糟糕會帶來訓練效果的下降。試想一下一個G所有產生的答案都被D駁回了,在這段時間內G的所有反饋都是負反饋,G就會迷失從而不知道向什么方向優化會得到正反饋,所以理想的情況下G和D是交替訓練上升的。在控制D和G訓練節奏的同時,這篇工作中又采用了一種類似強制學習的方式來嘗試解決這個問題。每次在正常的增加學習后會讓生成器強行生成正確答案并從D得到正向的反饋,從而每次都能有一個正向優化方向的指示。這樣的行為類似于學校老師強行灌輸知識,也很類似于之前的professor-forcing算法。所以到此整體的模型結構為:

訓練頻率的設定在圖中的解釋中有提到。無論是GAN還是RL都是出了名的難訓,Training Details大家還是看源碼和論文仔細體會吧,在此也就不鋪開了。

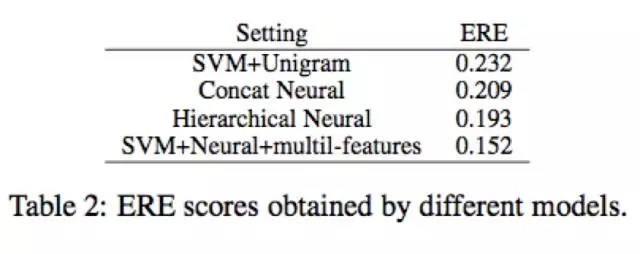

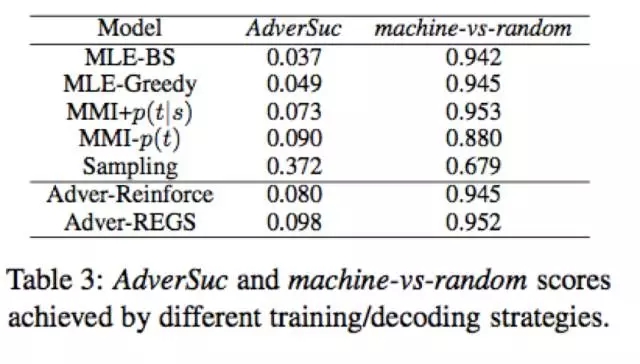

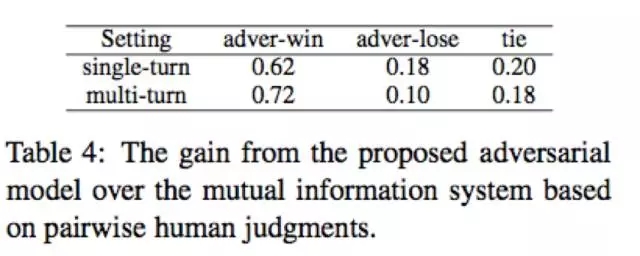

3、實驗

實驗的結果以及部分case study可以一定程度上體現對抗訓練的模型起到了預期的效果。

4、總結

雖然在手法上和之前的SeqGAN類似,采用了增強學習的方法來在NLP任務上進行對抗訓練,并且提出了一些新的針對于NLP本身特征的方法改進,盡管還存在很大問題需要解決,但也算是不錯的嘗試。引入對抗訓練這樣的方式可以解決以往模型,尤其是無監督生成式任務模型的許多問題,但受限于技術細節,現在的模型還處于探索階段,模型繁冗復雜,訓練過程需要摻入大量工程實現手法,方法無法在相似任務上靈活轉移。作者在這篇工作的結論里也提到了自己的模型在其他任務諸如machine translation和summarization效果并不是很好,并給出了自己認為可能的一些解釋。這些都需要我們進一步的去探索挖掘文本本身特有的性質來改造發展模型,并進一步嘗試。

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4495.html

摘要:直接把應用到領域主要是生成序列,有兩方面的問題最開始是設計用于生成連續數據,但是自然語言處理中我們要用來生成離散的序列。如圖,針對第一個問題,首先是將的輸出作為,然后用來訓練。 我來答一答自然語言處理方面GAN的應用。直接把GAN應用到NLP領域(主要是生成序列),有兩方面的問題:1. GAN最開始是設計用于生成連續數據,但是自然語言處理中我們要用來生成離散tokens的序列。因為生成器(G...

摘要:許多的頂尖研究人員都會積極的在現場回答問題。雖然有許多主題的常見問題頁面比如,這是一個機器學習的,但是這些都是非常不全面的,或者不夠精致。在這篇文章中,我試圖做一個更加全面的有關機器學習和問題的。 作者:chen_h微信號 & QQ:862251340微信公眾號:coderpai簡書地址:http://www.jianshu.com/p/ac18... showImg(https:/...

摘要:在這里匯總了一個現在和經常使用的論文,所有文章都鏈接到了上面。如果你對感興趣,可以訪問這個專題。作者微信號簡書地址是一個專注于算法實戰的平臺,從基礎的算法到人工智能算法都有設計。加入實戰微信群,實戰群,算法微信群,算法群。 作者:chen_h微信號 & QQ:862251340微信公眾號:coderpai簡書地址:https://www.jianshu.com/p/b7f... sh...

摘要:作者微信號微信公眾號簡書地址我把這篇文章分為四個部分機器學習,,和數學。在這篇文章中,我把每個主題的教程數量都是控制在五到六個,這些精選出來的教程都是非常重要的。每一個鏈接都會鏈接到別的鏈接,從而導致很多新的教程。 作者:chen_h微信號 & QQ:862251340微信公眾號:coderpai簡書地址:http://www.jianshu.com/p/2be3... showIm...

閱讀 1993·2021-11-24 10:45

閱讀 1849·2021-10-09 09:43

閱讀 1291·2021-09-22 15:38

閱讀 1219·2021-08-18 10:19

閱讀 2837·2019-08-30 15:55

閱讀 3056·2019-08-30 12:45

閱讀 2960·2019-08-30 11:25

閱讀 356·2019-08-29 11:30