資訊專(zhuān)欄INFORMATION COLUMN

摘要:深度學(xué)習(xí)已經(jīng)在圖像分類(lèi)檢測(cè)分割高分辨率圖像生成等諸多領(lǐng)域取得了突破性的成績(jī)。另一個(gè)問(wèn)題是深度學(xué)習(xí)的模型比如卷積神經(jīng)網(wǎng)絡(luò)有時(shí)候并不能很好地學(xué)到訓(xùn)練數(shù)據(jù)中的一些特征。本文通過(guò)最近的幾篇文章來(lái)介紹它在圖像分割和高分辨率圖像生成中的應(yīng)用。

深度學(xué)習(xí)已經(jīng)在圖像分類(lèi)、檢測(cè)、分割、高分辨率圖像生成等諸多領(lǐng)域取得了突破性的成績(jī)。但是它也存在一些問(wèn)題。首先,它與傳統(tǒng)的機(jī)器學(xué)習(xí)方法一樣,通常假設(shè)訓(xùn)練數(shù)據(jù)與測(cè)試數(shù)據(jù)服從同樣的分布,或者是在訓(xùn)練數(shù)據(jù)上的預(yù)測(cè)結(jié)果與在測(cè)試數(shù)據(jù)上的預(yù)測(cè)結(jié)果服從同樣的分布。而實(shí)際上這兩者存在一定的偏差,比如在測(cè)試數(shù)據(jù)上的預(yù)測(cè)準(zhǔn)確率就通常比在訓(xùn)練數(shù)據(jù)上的要低,這就是過(guò)度擬合的問(wèn)題。

另一個(gè)問(wèn)題是深度學(xué)習(xí)的模型(比如卷積神經(jīng)網(wǎng)絡(luò))有時(shí)候并不能很好地學(xué)到訓(xùn)練數(shù)據(jù)中的一些特征。比如,在圖像分割中,現(xiàn)有的模型通常對(duì)每個(gè)像素的類(lèi)別進(jìn)行預(yù)測(cè),像素級(jí)別的準(zhǔn)確率可能會(huì)很高,但是像素與像素之間的相互關(guān)系就容易被忽略,使得分割結(jié)果不夠連續(xù)或者明顯地使某一個(gè)物體在分割結(jié)果中的尺寸、形狀與在金標(biāo)準(zhǔn)中的尺寸、形狀差別較大。?

1.對(duì)抗學(xué)習(xí)?

對(duì)抗學(xué)習(xí)(adversarial learning)就是為了解決上述問(wèn)題而被提出的一種方法。學(xué)習(xí)的過(guò)程可以看做是我們要得到一個(gè)模型(例如CNN),使得它在一個(gè)輸入數(shù)據(jù)X上得到的輸出結(jié)果盡可能與真實(shí)的結(jié)果Y(金標(biāo)準(zhǔn))一致。在這個(gè)過(guò)程中使用一個(gè)鑒別器(discriminator),它可以識(shí)別出一個(gè)結(jié)果y到底是來(lái)自模型的預(yù)測(cè)值還是來(lái)自真實(shí)的結(jié)果。如果這個(gè)鑒別器的水平很高,而它又把和Y搞混了,無(wú)法分清它們之間的區(qū)別,那么就說(shuō)明我們需要的模型具有很好的表達(dá)或者預(yù)測(cè)能力。本文通過(guò)最近的幾篇文章來(lái)介紹它在圖像分割和高分辨率圖像生成中的應(yīng)用。

2. 用于圖像分割

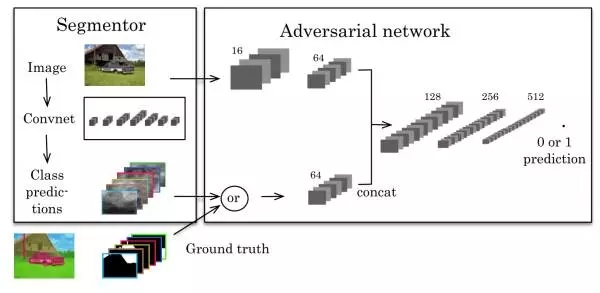

Semantic Segmentation using Adversarial Networks (https://arxiv.org/abs/1611.08408, 25Nov 2016),這篇文章第一個(gè)將對(duì)抗網(wǎng)絡(luò)(adversarial network)應(yīng)用到圖像分割中,該文章中的方法如下圖。

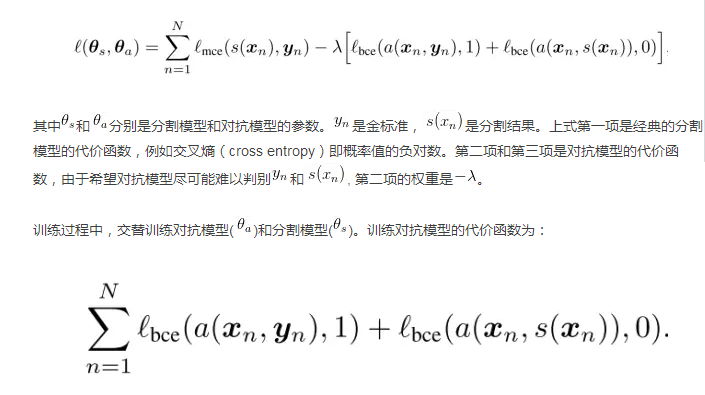

左邊是一個(gè)CNN的分割模型,右邊是一個(gè)對(duì)抗網(wǎng)絡(luò)。對(duì)抗網(wǎng)絡(luò)的輸入有兩種情況,一是原始圖像+金標(biāo)準(zhǔn),二是原始圖像+分割結(jié)果。它的輸出是一個(gè)分類(lèi)值(1代表它判斷輸入是第一種情況,0代表它判斷輸入是第二種情況)。代價(jià)函數(shù)定義為:

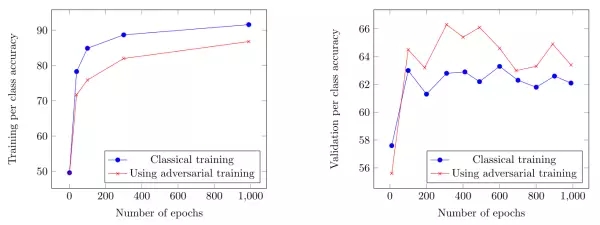

另外從訓(xùn)練過(guò)程中的性能上也可以看出,使用對(duì)抗訓(xùn)練,降低了過(guò)度擬合。

3.用于半監(jiān)督學(xué)習(xí)

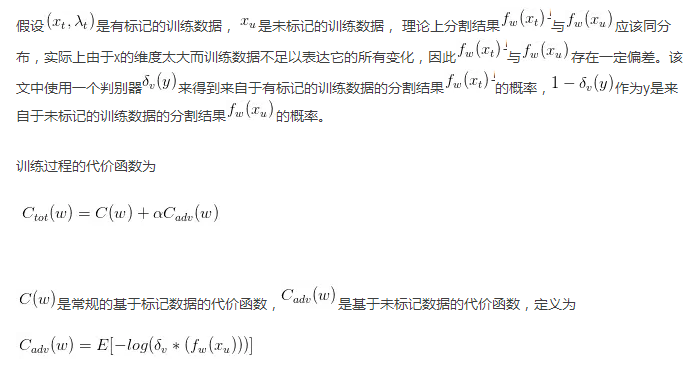

An Adversarial Regularisation for Semi-Supervised Training of Structured Output Neural Networks(https://arxiv.org/pdf/1702.02382.pdf, 8 Feb 2017),這篇文章中使用對(duì)抗網(wǎng)絡(luò)來(lái)做圖像分割的半監(jiān)督學(xué)習(xí)。半監(jiān)督學(xué)習(xí)中一部分?jǐn)?shù)據(jù)有標(biāo)記,而另一部分?jǐn)?shù)據(jù)無(wú)標(biāo)記,可以在準(zhǔn)備訓(xùn)練數(shù)據(jù)的過(guò)程中節(jié)省大量的人力物力。

該代價(jià)函數(shù)使分割算法在標(biāo)記數(shù)據(jù)和未標(biāo)記數(shù)據(jù)上得到盡可能一致的結(jié)果。整個(gè)算法可以理解成通過(guò)使用未標(biāo)記數(shù)據(jù),實(shí)現(xiàn)對(duì)分割網(wǎng)絡(luò)的參數(shù)的規(guī)則化。

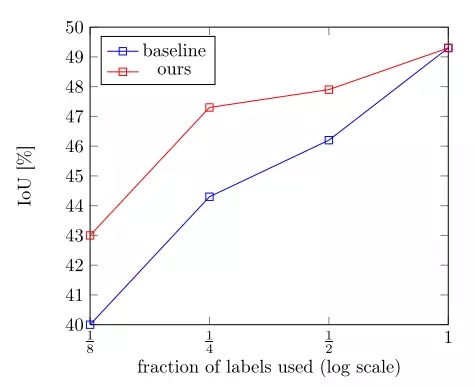

上圖是在CamVid數(shù)據(jù)集上分別使用1/8, 1/4, 1/2 和1/1的標(biāo)記數(shù)據(jù)進(jìn)行訓(xùn)練的結(jié)果。相比于藍(lán)線只使用標(biāo)記數(shù)據(jù)進(jìn)行訓(xùn)練,該方法得到了較大的性能提高,如紅線所示。

4.用于域適應(yīng)

FCNs in the Wild: Pixel-level Adversarial and Constraint-based Adaptation(https://arxiv.org/abs/1612.02649, 8 Dec 2016 ),這篇文章將對(duì)抗學(xué)習(xí)用到基于域適應(yīng)的分割中。

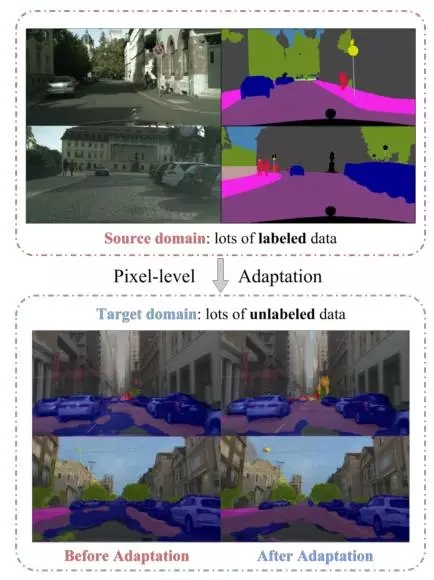

域適應(yīng)是指將在一個(gè)數(shù)據(jù)集上A訓(xùn)練得到的模型用到與之類(lèi)似的一個(gè)數(shù)據(jù)集B上,這兩個(gè)數(shù)據(jù)集的數(shù)據(jù)分布有一定的偏移(distribution shift),也叫做域偏移(domain shift)。A 被稱為源域 source domain,B被稱為目標(biāo)域 target domain。源域中的數(shù)據(jù)是有標(biāo)記的,而目標(biāo)域的數(shù)據(jù)沒(méi)有標(biāo)記,這種問(wèn)題就被稱為非監(jiān)督域適應(yīng)。該文章要解決的問(wèn)題如下圖所示:

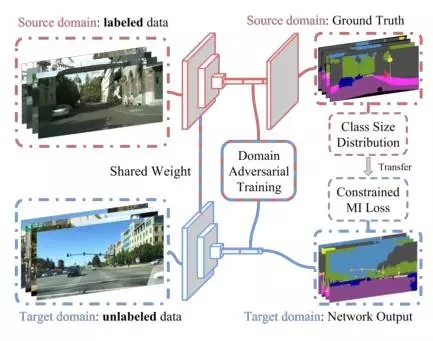

該文章中認(rèn)為一個(gè)好的分割算法應(yīng)該對(duì)圖像是來(lái)自于源域還是目標(biāo)域不敏感。具體而言就是從輸入圖像中提取的抽象特征不受域之間的差異影響,因此從源域中的圖像提取的抽象特征與從目標(biāo)域中的圖像提取的抽象特征很接近。那么如果用一個(gè)判別器來(lái)判斷這個(gè)抽象特征是來(lái)自于源域中的圖像還是來(lái)自于目標(biāo)域中的圖像,這個(gè)判別器應(yīng)該盡量無(wú)法判斷出來(lái)。方法的示意圖如下:

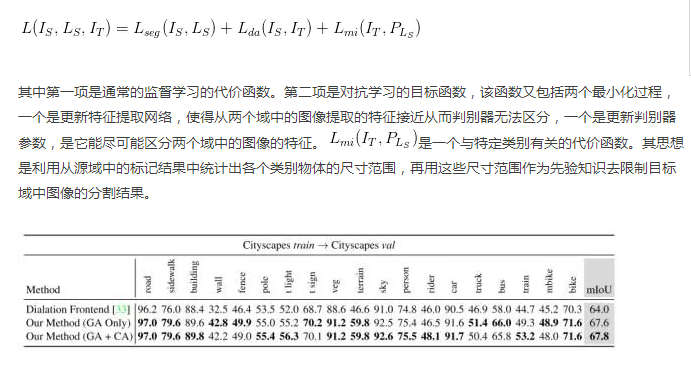

該文章認(rèn)為有兩個(gè)方面引起了域之間的偏移,一個(gè)是全局性的,比如不同天氣狀況下的街道場(chǎng)景,一個(gè)是與特定的類(lèi)別相關(guān)的 ,比如不同國(guó)家城市之間的交通標(biāo)志。 因此在代價(jià)函數(shù)中考慮了這兩種情況:

上圖是在Cityscapes數(shù)據(jù)集上的結(jié)果。實(shí)驗(yàn)中把訓(xùn)練集作為源域,驗(yàn)證集作為目標(biāo)域,分別展示了只使用全局性的域適應(yīng)(GA)和類(lèi)別特異性域適應(yīng)(CA)的結(jié)果。

5. 高分辨率圖像重建

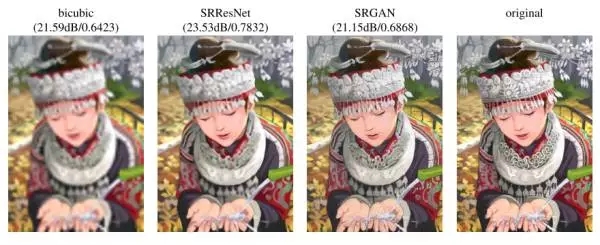

Photo-Realistic Single Image Super-Resolution Using a Generative Adversarial Network (https://arxiv.org/abs/1609.04802, 21 Nov, 2016)這篇文章將對(duì)抗學(xué)習(xí)用于基于單幅圖像的高分辨重建。基于深度學(xué)習(xí)的高分辨率圖像重建已經(jīng)取得了很好的效果,其方法是通過(guò)一系列低分辨率圖像和與之對(duì)應(yīng)的高分辨率圖像作為訓(xùn)練數(shù)據(jù),學(xué)習(xí)一個(gè)從低分辨率圖像到高分辨率圖像的映射函數(shù),這個(gè)函數(shù)通過(guò)卷積神經(jīng)網(wǎng)絡(luò)來(lái)表示。

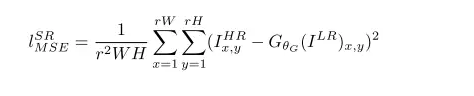

傳統(tǒng)的方法一般處理的是較小的放大倍數(shù),當(dāng)圖像的放大倍數(shù)在4以上時(shí),很容易使得到的結(jié)果顯得過(guò)于平滑,而缺少一些細(xì)節(jié)上的真實(shí)感。這是因?yàn)閭鹘y(tǒng)的方法使用的代價(jià)函數(shù)一般是最小均方差(MSE),即

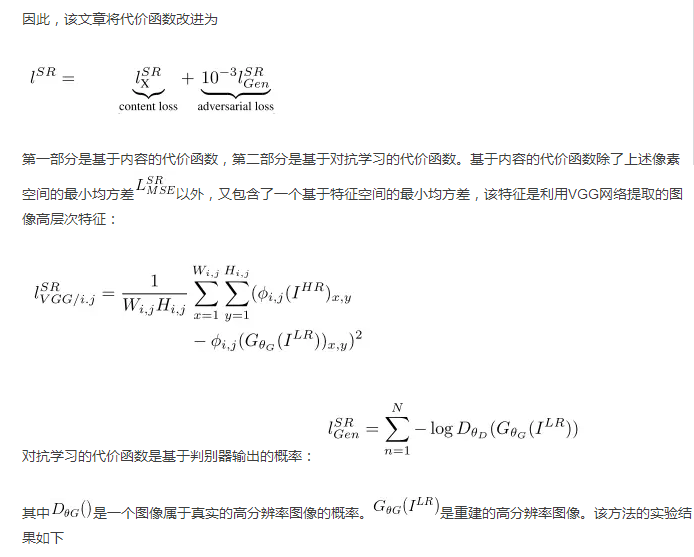

該代價(jià)函數(shù)使重建結(jié)果有較高的信噪比,但是缺少了高頻信息,出現(xiàn)過(guò)度平滑的紋理。該文章中的方法提出的方法稱為SRGAN, 它認(rèn)為,應(yīng)當(dāng)使重建的高分辨率圖像與真實(shí)的高分辨率圖像無(wú)論是低層次的像素值上,還是高層次的抽象特征上,和整體概念和風(fēng)格上,都應(yīng)當(dāng)接近。整體概念和風(fēng)格如何來(lái)評(píng)估呢?可以使用一個(gè)判別器,判斷一副高分辨率圖像是由算法生成的還是真實(shí)的。如果一個(gè)判別器無(wú)法區(qū)分出來(lái),那么由算法生成的圖像就達(dá)到了以假亂真的效果。

小結(jié)

對(duì)抗學(xué)習(xí)的概念就是引入一個(gè)判別器來(lái)解決不同數(shù)據(jù)域之間分布不一致的問(wèn)題,通過(guò)使判別器無(wú)法區(qū)分兩個(gè)不同域的數(shù)據(jù),間接使它們屬于同一個(gè)分布,從而作為一個(gè)規(guī)則化的方法去指導(dǎo)深度學(xué)習(xí)模型更新參數(shù),達(dá)到更好的效果。關(guān)于它的數(shù)學(xué)證明,可以參見(jiàn)[1]。

參考文獻(xiàn)

[1] ?Goodfellow, Ian, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, and Yoshua Bengio. "Generative adversarial nets." In Advances in neural information processing systems, pp. 2672-2680. 2014.

[2] ?Luc, Pauline, Camille Couprie, Soumith Chintala, and Jakob Verbeek. "Semantic Segmentation using Adversarial Networks." arXiv preprint arXiv:1611.08408 (2016).

[3] ?Mateusz Koziński, Lo?c Simon, Frédéric Jurie, "An Adversarial Regularisation for Semi-Supervised Training of Structured Output Neural Networks", arXiv preprint arXiv:1702.02382(2017).

[4] Hoffman, Judy, Dequan Wang, Fisher Yu, and Trevor Darrell. "FCNs in the Wild: Pixel-level Adversarial and Constraint-based Adaptation." arXiv preprint arXiv:1612.02649 (2016).

[5] Ledig, Christian, Lucas Theis, Ferenc Huszár, Jose Caballero, Andrew Cunningham, Alejandro Acosta, Andrew Aitken et al. "Photo-realistic single image super-resolution using a generative adversarial network." arXiv preprint arXiv:1609.04802 (2016).

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4466.html

摘要:基于深度學(xué)習(xí)的,主要是基于單張低分辨率的重建方法,即。而基于深度學(xué)習(xí)的通過(guò)神經(jīng)網(wǎng)絡(luò)直接學(xué)習(xí)分辨率圖像到高分辨率圖像的端到端的映射函數(shù)。 超分辨率技術(shù)(Super-Resolution)是指從觀測(cè)到的低分辨率圖像重建出相應(yīng)的高分辨率圖像,在監(jiān)控設(shè)備、衛(wèi)星圖像和醫(yī)學(xué)影像等領(lǐng)域都有重要的應(yīng)用價(jià)值。SR可分為兩類(lèi):從多張低分辨率圖像重建出高分辨率圖像和從單張低分辨率圖像重建出高分辨率圖像。基于深度學(xué)...

摘要:近幾年,深度學(xué)習(xí)高速發(fā)展,出現(xiàn)了大量的新模型與架構(gòu),以至于我們無(wú)法理清網(wǎng)絡(luò)類(lèi)型之間的關(guān)系。是由深度學(xué)習(xí)先驅(qū)等人提出的新一代神經(jīng)網(wǎng)絡(luò)形式,旨在修正反向傳播機(jī)制。當(dāng)多個(gè)預(yù)測(cè)一致時(shí)本論文使用動(dòng)態(tài)路由使預(yù)測(cè)一致,更高級(jí)別的將變得活躍。 近幾年,深度學(xué)習(xí)高速發(fā)展,出現(xiàn)了大量的新模型與架構(gòu),以至于我們無(wú)法理清網(wǎng)絡(luò)類(lèi)型之間的關(guān)系。在這篇文章中,香港科技大學(xué)(HKUST)助理教授金成勳總結(jié)了深度網(wǎng)絡(luò)類(lèi)型之間...

摘要:此前有工作將像素?fù)p失和生成對(duì)抗損失整合為一種新的聯(lián)合損失函數(shù),訓(xùn)練圖像轉(zhuǎn)換模型產(chǎn)生分辨率更清的結(jié)果。一般來(lái)說(shuō),結(jié)合使用多種損失函數(shù)的效果通常比單獨(dú)使用一種要好。結(jié)合感知對(duì)抗損失和生成對(duì)抗損失,提出了感知對(duì)抗網(wǎng)絡(luò)這一框架,處理圖像轉(zhuǎn)換任務(wù)。 近來(lái),卷積神經(jīng)網(wǎng)絡(luò)的發(fā)展,結(jié)合對(duì)抗生成網(wǎng)絡(luò)(GAN)等嶄新的方法,為圖像轉(zhuǎn)換任務(wù)帶來(lái)了很大的提升,包括圖像超分辨率、去噪、語(yǔ)義分割,還有自動(dòng)補(bǔ)全,都有亮眼...

閱讀 2115·2023-04-26 00:50

閱讀 2485·2021-10-13 09:39

閱讀 2217·2021-09-22 15:34

閱讀 1611·2021-09-04 16:41

閱讀 1340·2019-08-30 15:55

閱讀 2439·2019-08-30 15:53

閱讀 1712·2019-08-30 15:52

閱讀 752·2019-08-29 16:19