資訊專欄INFORMATION COLUMN

摘要:深度學(xué)習(xí)的核心問(wèn)題就是一個(gè)非常難的優(yōu)化問(wèn)題。所以在神經(jīng)網(wǎng)絡(luò)引入后的幾十年間,深度神經(jīng)網(wǎng)絡(luò)的優(yōu)化問(wèn)題的困難性是阻礙它們成為主流的一個(gè)重要因素。因此我們對(duì)機(jī)器學(xué)習(xí)研究人員嘗試找到可證明地解決深度神經(jīng)網(wǎng)絡(luò)優(yōu)化問(wèn)題的算法不抱有太大的希望。

深度學(xué)習(xí)的核心問(wèn)題就是一個(gè)非常難的優(yōu)化問(wèn)題。所以在神經(jīng)網(wǎng)絡(luò)引入后的幾十年間,深度神經(jīng)網(wǎng)絡(luò)的優(yōu)化問(wèn)題的困難性是阻礙它們成為主流的一個(gè)重要因素。并導(dǎo)致了它們?cè)?0世紀(jì)90年代到21世紀(jì)初期間的衰落。不過(guò)現(xiàn)在已經(jīng)基本解決了這個(gè)問(wèn)題。在本篇博文中,我會(huì)探討優(yōu)化神經(jīng)網(wǎng)絡(luò)的“困難性”,以及理論上是怎么解釋這個(gè)問(wèn)題的。簡(jiǎn)而言之:神經(jīng)網(wǎng)絡(luò)變得越深,優(yōu)化問(wèn)題就會(huì)變得越難。

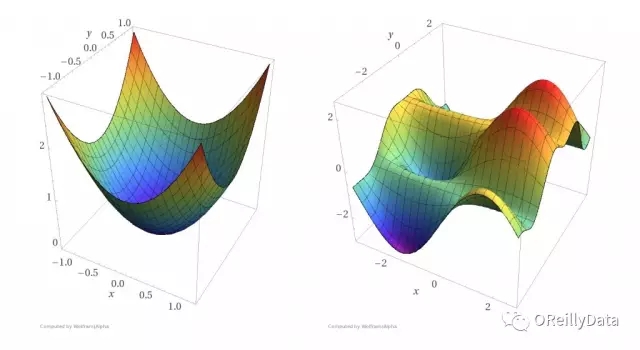

最簡(jiǎn)單的神經(jīng)網(wǎng)絡(luò)是單節(jié)點(diǎn)感知器,其優(yōu)化問(wèn)題是凸問(wèn)題。凸優(yōu)化問(wèn)題的好處是所有的局部最小值也是全局最小值。存在各種各樣的優(yōu)化算法來(lái)解決凸優(yōu)化問(wèn)題,并且每隔幾年就會(huì)發(fā)現(xiàn)更好的用于凸優(yōu)化的多項(xiàng)式時(shí)間的算法。使用凸優(yōu)化算法可以輕松地優(yōu)化單個(gè)神經(jīng)元的權(quán)重(參見(jiàn)下圖)。下面讓我們看看擴(kuò)展一個(gè)單神經(jīng)元后會(huì)發(fā)生什么。

圖1 左圖:一個(gè)凸函數(shù)。右圖:一個(gè)非凸函數(shù)。凸函數(shù)比非凸函數(shù)更容易找到函數(shù)曲面的底部(來(lái)源:Reza Zadeh)

下一步自然就是在保持單層神經(jīng)網(wǎng)絡(luò)的情況下添加更多的神經(jīng)元。對(duì)于單層n節(jié)點(diǎn)感知器的神經(jīng)網(wǎng)絡(luò),如果存在邊權(quán)重可以使得神經(jīng)網(wǎng)絡(luò)能正確地對(duì)訓(xùn)練集進(jìn)行分類,那么這樣的邊權(quán)重是可以通過(guò)線性規(guī)劃在多項(xiàng)式時(shí)間O(n)內(nèi)找到。線性規(guī)劃也是凸優(yōu)化的一種特殊情況。這時(shí)一個(gè)問(wèn)題應(yīng)運(yùn)而生:我們可以對(duì)更深的多層神經(jīng)網(wǎng)絡(luò)做出這種類似的保證么?不幸的是,不能。

為了可證明地解決兩層或多層的一般神經(jīng)網(wǎng)絡(luò)的優(yōu)化問(wèn)題,需要的算法將會(huì)遇到某些計(jì)算機(jī)科學(xué)中較大的未解問(wèn)題。因此我們對(duì)機(jī)器學(xué)習(xí)研究人員嘗試找到可證明地解決深度神經(jīng)網(wǎng)絡(luò)優(yōu)化問(wèn)題的算法不抱有太大的希望。因?yàn)檫@個(gè)優(yōu)化問(wèn)題是NP-hard問(wèn)題,這意味著如果在多項(xiàng)式時(shí)間內(nèi)可證明地解決這個(gè)問(wèn)題,那么也可以解決那些幾十年來(lái)尚未被解決的成千上萬(wàn)的問(wèn)題。事實(shí)上,J. Stephen Judd在1988年就發(fā)現(xiàn)下面這個(gè)問(wèn)題是NP-hard問(wèn)題:

給定一個(gè)一般的神經(jīng)網(wǎng)絡(luò)和一組訓(xùn)練樣本,是否存在一組網(wǎng)絡(luò)邊權(quán)重使得神經(jīng)網(wǎng)絡(luò)能為所有的訓(xùn)練樣本產(chǎn)生正確的輸出?

Judd的研究還表明:即使要求一個(gè)神經(jīng)網(wǎng)絡(luò)只為三分之二的訓(xùn)練樣本產(chǎn)生正確的輸出仍然是一個(gè)NP-hard問(wèn)題。這意味著即使在最壞的情況下,近似訓(xùn)練一個(gè)神經(jīng)網(wǎng)絡(luò)在本質(zhì)上還是困難的。1993年Blum和Rivest發(fā)現(xiàn)的事實(shí)更糟:即使一個(gè)只有兩層和三個(gè)節(jié)點(diǎn)的簡(jiǎn)單神經(jīng)網(wǎng)絡(luò)的訓(xùn)練優(yōu)化問(wèn)題仍然是NP-hard問(wèn)題。

理論上,深度學(xué)習(xí)與機(jī)器學(xué)習(xí)中的很多相對(duì)簡(jiǎn)單的模型(例如支持向量機(jī)和邏輯回歸模型)的區(qū)別在于,這些簡(jiǎn)單模型可以數(shù)學(xué)證明地在多項(xiàng)式時(shí)間內(nèi)完成模型優(yōu)化。對(duì)于這些相對(duì)簡(jiǎn)單的模型,我們可以保證即使用運(yùn)行時(shí)間比多項(xiàng)式時(shí)間更長(zhǎng)的優(yōu)化算法也都不能找到更好的模型。但是現(xiàn)有的深度神經(jīng)網(wǎng)絡(luò)的優(yōu)化算法并不能提供這樣的保證。在你訓(xùn)練完一個(gè)深度神經(jīng)網(wǎng)絡(luò)模型之后,你并不知道這個(gè)網(wǎng)絡(luò)模型是否是在你的當(dāng)前配置下能找到的最優(yōu)的一個(gè)模型。所以你會(huì)存有疑慮,如果繼續(xù)訓(xùn)練模型的話是否可以得到一個(gè)更好的模型。

幸運(yùn)的是我們?cè)趯?shí)踐中可以非常高效地接近這些最優(yōu)結(jié)果:通過(guò)運(yùn)行經(jīng)典的梯度下降優(yōu)化方法就可以得到足夠好的局部最小值,從而可以使我們?cè)谠S多常見(jiàn)問(wèn)題上取得巨大進(jìn)步,例如圖像識(shí)別、語(yǔ)音識(shí)別和機(jī)器翻譯。我們簡(jiǎn)單地忽略最優(yōu)結(jié)果,并在時(shí)間允許的情況下盡可能多地進(jìn)行梯度下降迭代。

似乎傳統(tǒng)的優(yōu)化理論結(jié)果是殘酷的,但我們可以通過(guò)工程方法和數(shù)學(xué)技巧來(lái)盡量規(guī)避這些問(wèn)題,例如啟發(fā)式方法、增加更多的機(jī)器和使用新的硬件(如GPU)。一些研究工作正在積極地探索為什么理論結(jié)果很殘酷,但這些經(jīng)典的優(yōu)化算法卻工作得這么好。

深度學(xué)習(xí)能成功的因素遠(yuǎn)遠(yuǎn)不只克服優(yōu)化問(wèn)題。神經(jīng)網(wǎng)絡(luò)的架構(gòu)、訓(xùn)練數(shù)據(jù)的數(shù)量、損失函數(shù)和正則化等都對(duì)于能在機(jī)器學(xué)習(xí)任務(wù)中獲得高質(zhì)量的結(jié)果起著關(guān)鍵作用。在后續(xù)的博文中,我將會(huì)討論涵蓋這些方面的的理論成果,來(lái)解釋為什么神經(jīng)網(wǎng)絡(luò)在各種任務(wù)上工作得如此好。

Reza Zadeh

Reza Zadeh是斯坦福大學(xué)的兼職教授、Matroid創(chuàng)始人和首席執(zhí)行官。他的工作主要關(guān)注于機(jī)器學(xué)習(xí)、分布式計(jì)算和離散應(yīng)用數(shù)學(xué)。他曾在Miscrosoft和Databricks的技術(shù)顧問(wèn)委員會(huì)任職。

歡迎加入本站公開(kāi)興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4455.html

摘要:本文詳細(xì)討論了自然語(yǔ)言理解的難點(diǎn),并進(jìn)一步針對(duì)自然語(yǔ)言理解的兩個(gè)核心問(wèn)題,詳細(xì)介紹了規(guī)則方法和深度學(xué)習(xí)的應(yīng)用。引言自然語(yǔ)言理解是人工智能的核心難題之一,也是目前智能語(yǔ)音交互和人機(jī)對(duì)話的核心難題。 摘要:自然語(yǔ)言理解是人工智能的核心難題之一,也是目前智能語(yǔ)音交互和人機(jī)對(duì)話的核心難題。之前寫過(guò)一篇文章自然語(yǔ)言理解,介紹了當(dāng)時(shí)NLU的系統(tǒng)方案,感興趣的可以再翻一番,里面介紹過(guò)的一些內(nèi)容不再贅...

摘要:上周,在舊金山召開(kāi)的人工智能國(guó)際較高級(jí)會(huì)議上,來(lái)自微軟亞洲研究院的鄭宇博士及其團(tuán)隊(duì)的論文首創(chuàng)性的將時(shí)空數(shù)據(jù)與深度學(xué)習(xí)結(jié)合起來(lái),利用時(shí)空深度殘差網(wǎng)絡(luò)用于預(yù)測(cè)城市人流問(wèn)題。 上周,在舊金山召開(kāi)的人工智能國(guó)際較高級(jí)會(huì)議AAAI 2017上,來(lái)自微軟亞洲研究院的鄭宇博士及其團(tuán)隊(duì)的論文Deep Spatio-Temporal Residual Networks for Citywide Crowd F...

摘要:動(dòng)態(tài)數(shù)據(jù)綁定的三個(gè)難點(diǎn)對(duì)象深度問(wèn)題設(shè)置新對(duì)象是否能夠繼續(xù)響應(yīng)和考慮傳遞回調(diào)函數(shù)本文的目的在實(shí)踐中使用遞歸思想了解設(shè)計(jì)模式中的發(fā)布訂閱模式三大難點(diǎn)如果傳入?yún)?shù)對(duì)象是一個(gè)比較深的對(duì)象也就是其屬性值也可能是對(duì)象,那該怎么辦呢舉個(gè)例子。 動(dòng)態(tài)數(shù)據(jù)綁定的三個(gè)難點(diǎn): 對(duì)象深度問(wèn)題 設(shè)置新對(duì)象是否能夠繼續(xù)響應(yīng)getter 和 setter 考慮傳遞回調(diào)函數(shù) 本文的目的 在實(shí)踐中使用遞歸思...

摘要:華為云,從到開(kāi)發(fā)訓(xùn)練模型,通過(guò)極快和極簡(jiǎn)實(shí)現(xiàn)普惠現(xiàn)如今技術(shù)概念火爆落地應(yīng)用更是繁多,但開(kāi)發(fā)呢是否困難到底有多痛據(jù)了解,大部分開(kāi)發(fā)者的工作時(shí)間并不長(zhǎng),并且十有八九可能不是科班出身。 華為云EI ModelArts,從0到1開(kāi)發(fā)訓(xùn)練AI模型,通過(guò)極快和極簡(jiǎn)實(shí)現(xiàn)普惠AI現(xiàn)如今 AI 技術(shù)、概念火爆、落地應(yīng)用更是繁多,但開(kāi)發(fā)呢?是否困難?到底有多痛?據(jù)了解,大部分 AI 開(kāi)發(fā)者的工作時(shí)間并不長(zhǎng)...

摘要:忍者級(jí)別的函數(shù)操作對(duì)于什么是匿名函數(shù),這里就不做過(guò)多介紹了。我們需要知道的是,對(duì)于而言,匿名函數(shù)是一個(gè)很重要且具有邏輯性的特性。通常,匿名函數(shù)的使用情況是創(chuàng)建一個(gè)供以后使用的函數(shù)。 JS 中的遞歸 遞歸, 遞歸基礎(chǔ), 斐波那契數(shù)列, 使用遞歸方式深拷貝, 自定義事件添加 這一次,徹底弄懂 JavaScript 執(zhí)行機(jī)制 本文的目的就是要保證你徹底弄懂javascript的執(zhí)行機(jī)制,如果...

閱讀 3251·2021-10-13 09:39

閱讀 2013·2021-09-27 13:36

閱讀 3074·2021-09-22 16:02

閱讀 2596·2021-09-10 10:51

閱讀 1578·2019-08-29 17:15

閱讀 1532·2019-08-29 16:14

閱讀 3504·2019-08-26 11:55

閱讀 2549·2019-08-26 11:50