資訊專欄INFORMATION COLUMN

摘要:而自然語言處理被視為深度學習即將攻陷的下一個技術領域,在今年全球較高級的學術會議上,我們也看到大量的在深度學習引入方面的探索研究。

深度學習的出現讓很多人工智能相關技術取得了大幅度的進展,比如語音識別已經逼近臨界點,即將達到Game Changer水平;機器視覺也已經在安防、機器人、自動駕駛等多個領域得到應用。 而自然語言處理(NLP)被視為深度學習即將攻陷的下一個技術領域,在今年全球較高級的NLP學術會議ACL上,我們也看到大量的在深度學習引入NLP方面的探索研究。讓我們跟隨阿里的科學家們一起去探求深度學習給NLP帶來些改變。

上篇介紹了機器翻譯、機器閱讀與理解、語言與視覺等方面的科學探索,下篇將介紹對話系統、信息抽取與情感分析、句法分析、詞向量和句向量等相關方向的優秀研究成果。

《下篇》

4、對話系統

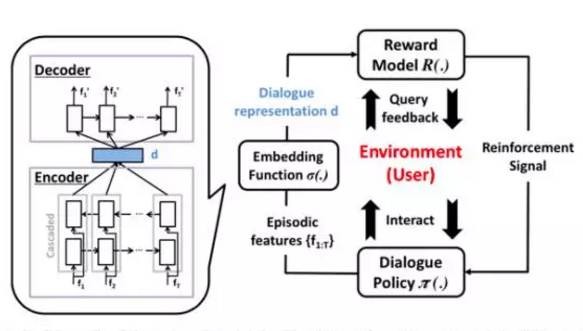

《On-line Active Reward Learning for Policy Optimization in SpokenDialogue Systems》,用于口語對話系統策略優化的在線自動獎勵學習,來自于劍橋大學工作的Paper,也榮獲了本次ACL2016學生Best Paper。此Paper提出了一種在面向任務的對話系統中,通過增強學習來優化對話管理策略,構建了一個在線學習框架:對話策略,對話鑲嵌函數和基于用戶反饋的主動獎勵機制三部分組成,如圖所示。

圖8、在線學習框架

?

通過Gaussian過程分類法與一種基于神經網絡的無監管式對話嵌入方法,提出了一種主動的獎賞函數學習模型。通過Reinforcement Learning的方式,主動詢問客戶收集更多的信息來得到較精確的獎賞函數,實現在線學習策略。相比人工語聊標注以及離線模型的方式上有很大的創新。

?

Paper下載地址:http://aclweb.org/anthology/P16-1230

?

《DocChat: An Information Retrieval Approach for Chatbot Engines UsingUnstructured Documents》,此篇長文是由微軟亞洲研究院(MSRA)周明老師團隊的工作。本文適合場景是聊天場景,不適用于強邏輯和知識業務匹配場景。

?

通常我們在做聊天對話的時候,我們有兩種方式:一種是基于檢索的方式(Retrieval-Based),還有一種就是基于sequence tosequence的Deep Learning生成方式,比如基于LSTM的方式。但是兩種方式基于都是大量的基于QA Pair對的數據展開的工作。本文的第一個創新的點是直接依賴于非結構化RawData作為數據源輸入,而不依賴標準的QA Pair對數據,通過非結構化數據中直接計算獲得合適的Response。

?

框架技術思路設計路徑還是傳統的檢索方式:非結構化文本按照句子進行分割,先從已有的非結構化數據集中進行召回,然后進行Ranking排序,最后進行置信度計算。其中較為核心的部分就是回復Ranking的特征選擇及模型選擇了,本文提出了多level特征的選擇,包括:word-level, phrase-level,sentence- level, document-level, relation-level, type-level 和 topic-level。整體評測方案上其實是有提升空間的,語聊類的通過“0”和“1”的方式判斷其實不是特別合適,可以修改成為對、錯和相關等更為復雜的評測方案。

?

Paper下載地址:http://aclweb.org/anthology/P16-1049

?

5、信息抽取與情感分析

IE的論文今年集中在slot filling, NER,entityResolution 和coreference.Slot filling在2009 KBP 提出以來,一直以來效果不好很好,F-score大約只有30%。跟relation extraction比較而言,有跨篇章,同義詞,多種關系等問題。季?團隊一直保持著比較好的實驗效果。此次,他們提出了一種基于圖挖掘的方案,取得了明顯的提升。NER也是IE比較傳統的任務,今年論文的創新仍舊多基于深度學習。Coreference和 entity resolution保持了近幾年colletive和知識表示兩個方向上發力。

?

Sentiment由于學術界數據的缺乏,domain adaptation仍舊十分熱,近幾年domain adaptation也在使用deep learning模型。

?

綜合來看,今年這兩個課題中規中矩,有不錯的創新點,但沒有大的突破。

?

6、句法分析

句法分析可以稱作是自然語言處理領域的核心任務之一,每年ACL會議上都有較大數量的相關論文和sessions。然而與過去二十年所取得的進展相比,現在的句法分析研究越來越給人一種“做無可做”的感覺(甚至一部分熟悉的研究人員已經離開這個領域)。也許賓州大學構建的標準樹庫所帶來的紅利已經消失了?

?

現在人們相當程度上把希望寄托在深度學習上。從某種意義上講,這也是大勢所趨:搞深度學習的希望在搞定語音和圖像之后能夠進一步挑戰自然語言處理/理解,而做語言處理的研究者則需要深度學習來擴展自己的研究手段。句法分析同樣不能例外,過去兩三年,句法分析領域出現大量基于深度學習的研究工作,通過構建不同的(通常比較復雜的)網絡結構。在2016年ACL工作中,我們看到研究重點回歸到如何將深度學習用作更有效的工具,譬如說研究如何利用深度學習模型的非線性特點減小分析算法的計算代價,或者研究如何利用深度學習與經典方法(例如reranking)進行結合。下面會有相關論文的介紹。

?

句法分析領域另一個值得關注的點是實驗數據的多樣化。前面提到了賓州樹庫(英文的PTB、中文的CTB、朝鮮語的KTB)。做句法分析研究的同學都知道,這幾個數據集是句法分析研究的標準數據集,從1992年開始,我們大部分句法分析實驗都是在這些數據集上進行。但是近幾年這幾個標準數據集逐漸暴露出不足之處。因此開始出現了一些幫助研究繼續往前發展的新數據集。Google在2012年推出WebTreebank,除了覆蓋賓州樹庫原有數據以外,Web Treebank中還包含一個問句測試集和一個超大規模的無標注數據。[1]這個數據集通常用于領域適應性研究。在依存分析領域,近幾年出現了Universal Dependencies,其目標是通過一套規范對多種語言進行統一的標注。[2]在成分句法分析領域,出現了覆蓋八種語言的SPMRL (Morphologically rich language) 數據。[3]在新數據集上的工作開始增多。這些數據的基礎性工作在某種程度上講要比深度學習更值得研究。

依存句法分析的效率優化

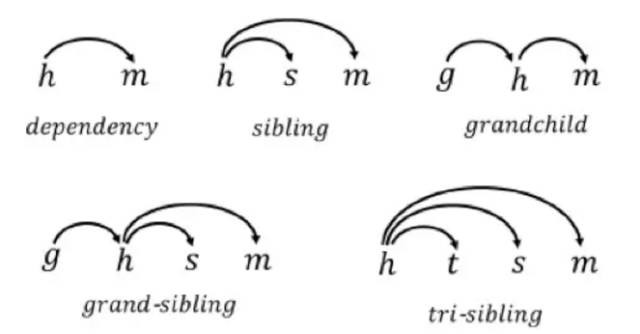

依存句法分析的方法基本上可以分為兩大流派:基于圖的方法和基于狀態轉移的方法。與狀態轉移方法相比,基于圖的方法建模能力更強,但是解碼的時候需要依賴動態規劃算法,難以避免具有較高的時間復雜度(狀態轉移方法具有線性時間復雜度);而且它的時間復雜度與采用的子圖大小正相關:子圖越大,復雜度越高。下圖展示了從一階到三階的不同依存子圖。為了使基于圖的句法分析方法在實際應用中更加可用,有必要去研究如何使基于圖的依存句法分析器跑得更快。

圖9、一階到三階的不同依存子圖

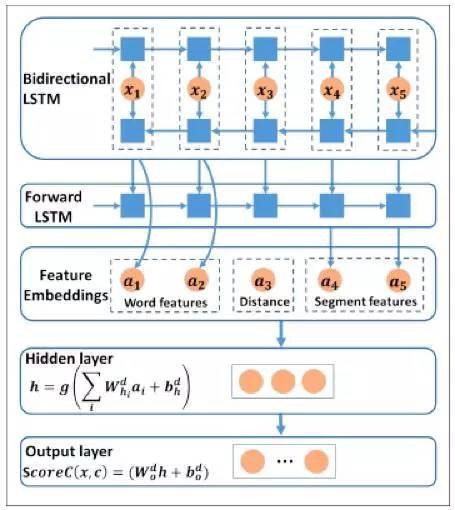

今年有兩篇工作與這個主題相關。來自北京大學的Wang and Chang 始終采用較低階(一階)的依存子圖進行建模,但是考慮到一階子圖的上下文信息不足,他們采用雙向的LSTM對子圖進行打分,以此彌補上下文信息缺失的問題。經典的基于圖的模型(例如MST parser)采用MIRA模型對子圖進行打分。因此這篇工作其本質是始終采用一階子圖對句法樹進行拆分,但是底層的打分函數換成了雙向LSTM,因此其時間復雜度仍然為O(n^3)(通過有效

剪枝可以使復雜度減小到O(n^2))。雙向LSTM的網絡結構如圖10所示。

?

Wang and Chang利用了圖方法的一個特性,即解碼的時間復雜度與子圖大小正相關。基于圖的句法分析方法另一個重要特性是:解碼過程實際上是在有向無環圖中尋找較大生成樹。如果能把有向圖換成無向圖,那么尋找較大生成樹的算法就會簡單很多。來自以色列和印度的一篇聯合工作就解了這個問題。給定一個句子,首先生成無向圖,基于該無向圖生成(無向的)較大生成樹,最終的依存樹將由無向的較大生成樹推導得到。

?

圖10、雙向LSTM的網絡結構

?

基于神經網絡的成分句法分析

在EMNLP2014上有一篇來自StanfordNLP組的開創性的工作(Chen and Manning, 2014),提出基于Feed-forwardNeural Network的狀態轉移依存分析器,它通過減少特征抽取的時間成本,造就了目前為止單機速度最快的依存句法分析器。在這項工作的基礎上有一系列的后續工作(包括Google開源的SyntaxNet)都是基于該模型改進完成。很自然的產生一個想法:能否利用該網絡結構進行成分句法分析的工作。來自法國的Coavoux and Crabbe今年就做了這樣一篇工作。他們除了采用Chen and Manning 2014的網絡結構以外,還采用了dynamic oracle技術。Dynamic oracle技術最開始也是在依存分析上首先提出的,其基本思路是:基于訓練數據的標準答案(gold oracle)進行模型訓練不一定是較佳的,因為在解碼的時候很容易產生錯誤,導致無論如何也得不到gold oracle,dynamic oracle的思想就是根據當前的狀態(可能是錯誤狀態)學習一個最有利于模型優化的oracle.這項dynamic oracle技術在成分句法分析中同樣有效。

7、詞向量和句向量

Word Vectors和Sentence Vectors總共被安排了三場,并且被組委會安排在了較大的兩個會議室(Audimax和Kinosaal),多少可以代表當前自然語言處理領域的熱點話題和方向,包括在其它的一些專場(比如Semantics等)也或多或少使用到了類似的深度學習和詞嵌入的技術。因為涉及到的內容比較多,以兩篇文章為例:

?

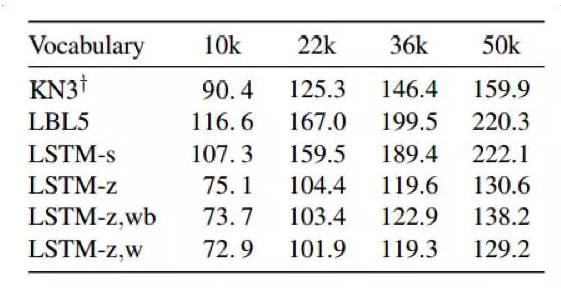

《Compressing Neural Language Models by Sparse Word Representations》一文主要針對現在神經網絡模型過大帶來的時間開銷以及內存占用的問題,提出了一種壓縮算法使得模型的參數伴隨著詞典的膨脹緩慢增加,并且在Perplexity上的評估性能也有所改善。該文方法的主要優點在于:一、放松了對硬件特別是內存消耗的限制,使得模型在移動端部署大為方便;二、特別提升了對罕見詞的表示效果,因為常見的神經網絡語言模型無法很好地調優梯度。解決上述問題的思路在于將罕見詞表示為常見詞的稀疏線性組合,這一思路來源于日常生活中我們往往用幾個常見詞來解釋一個不熟悉的詞。因此將我們的目標轉化為求解罕見詞的最優稀疏編碼(每個詞4-8個)。因此最終用來壓縮模型的方法定義為,對于常見詞采用傳統的稠密詞向量的求解方式,對于罕見詞采用常見詞的稀疏組合來作為其向量,使用LSTM與RNN作為模型的隱藏層,而其它權重值的求解方式與傳統的類似,從而達到了網絡的參數數目基本與詞典大小無關(或者說關系很小)。最終的實驗結果從性能(Perplexity)與內存開銷減少兩方面來說明價值,如圖11、12所示。

圖11、壓縮模型與基線在Perplexity上的性能比較

圖12、模型在內存消耗上的減少(%)

?

另一篇很有意思的文章是來自于墨爾本大學和劍橋大學合作的《Take and Took, Gaggle and Goose, Book and Read: Evaluating theUtility of Vector Differences for Lexical Relation Learning》。從標題可以看出這是一篇探索詞匯間關系的論文,這是一項非常基礎并且非常重要的工作,我們日常都會用到word2vec這種非常實用的工具,但對詞之間的關系并未做過多的探索,比如經典的king ? man + woman = queen或者paris ? france + poland = warsaw,作者認為兩個詞向量之間的差值代表了某種含義(更確切的說法是代表了兩個詞匯的某種關系),比如前者可能是性別關系,而后者可能是代表了首都的關系。為了證明此種關系是否可靠并且不依賴于特定的語料,作者選擇了十多種典型的關系,比如整體與部分(airplane and cockpit)、行動與目標(hunt and deer)、名詞與群體名詞(antand army)以及單復數( dog and dogs)、過去時態(knowand knew)和第三人稱形態(accept and accepts)等等大量數據,并且通過聚類得到結果,如圖13;作者發現這種“通過詞向量的差值來刻畫詞匯間關系”的方式是可靠并且具備普遍通用性的。除此之外,作者還探索了使用有監督數據集做分類的方法和應用。

圖13、典型關系的聚類結果,部分離群點可能是由于多義詞的影響

?

這方面的研究對于機器翻譯和人機交互具有很強的應用價值,對這一領域的探索毫無疑問Google走在了前面,包括之前開源的word2vec,以及他們的機器翻譯團隊發現在英語中的這種詞匯關系同樣適用于西班牙語和德語等等。

?

除此之外,還有一個專場專門介紹Sentence Vectors,主要介紹了其在Attention Mode、Negation Scope Detection以及Summarization方面的應用。

?

四、總結

1、今年的ACL上,深度學習不出意外地依然成為會議的主角,并在自然語言處理的幾乎所有領域的重要問題上得到大規模應用,包括:語義表示、機器翻譯、信息提取、情感分析、自動問答、對話等。繼深度神經網絡在圖像、語音等研究領域取得突破性進展后,機器翻譯領域的研究者們從2013年后也開始嘗試在翻譯模型中引入多層神經網絡模型。從最初的把神經網絡語言模型作為傳統SMT解碼器的特征之一,到后來完全取代SMT解碼器的Encoder-Decoder框架,應該說NMT在短短兩年多時間里快速推進,無論是研究上還是應用上都已經隱然要取代傳統SMT框架。

2、雖然端到端的神經機器翻譯系統取得了很大進步,在一些公共測試集上已經追趕或超越傳統的統計機器翻譯系統,但它之前也存在一些難以解決的問題,比如:由于詞表大小限制導致的OOV翻譯問題、已翻譯的詞過翻或欠翻問題等,這些問題在今年的ACL論文中已經出現了部分解決方案,雖然還不能說非常完美,但至少已經看到了改進的希望。這些也是我們后續值得重點關注的工作。

3、整體的“自動化”及挖掘和利用知識還是主要的旋律,技術上Deep Learning持續火熱。對比工業界目前如火如荼的大量chatbot產品,在平臺化技術上要解決的其實也是這兩個問題,使得chatbot更加智能。當然對比工業界目前開始逐步開始在大規模場景結合深度學習的技術,這個需要一個發展和落地的過程。本次會議中一些知識利用及對話構建機制上的思路在工業界是可以借鑒的,還有一個較為需要關注的亮點或者說工業界可以參考和需要關注的是,ReinforcementLearning的應用和發展是一個新的發聲點和亮點。

4、句法分析的研究仍然不少,但是可能確實是到了一個瓶頸。目前一個思路是去研究引入深度學習,建立新的模型之后,一些“老”技術如何遷移過來。譬如說reranking技術,原來在n-best list和forest基礎上取得的效果非常好,現在在neural network-based的系統上如何引入reranking,是一個值得研究的問題。今年南京大學的Hao Zhou等人就做了這樣的一篇有趣的工作。另外一個就是數據,現在universal dependencies和SPMRL還不夠,新數據的構建和研究還有較多的工作要做。

5、學術界是比較少研究應用的,不過也會看到一些比較有趣的可以直接應用起來的技術。譬如今年Anders Bjokelund等人做了一個句子切分和句法分析的聯合模型。這個工作與之前MSRADongdong Zhang等人做的一個標點預測與句法分析聯合模型相類似。假設需要對語音識別的結果進行分析理解,那么這樣的一個模型應該會有比較大的作用。類似的思路,由于句法分析處于很多應用的核心位置,我們其實可以考慮把應用中的其它任務與它進行聯合建模。

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4423.html

摘要:而自然語言處理被視為深度學習即將攻陷的下一個技術領域,在今年全球較高級的學術會議上,我們也看到大量的在深度學習引入方面的探索研究。和也是近幾年暫露頭角的青年學者,尤其是在將深度學習應用于領域做了不少創新的研究。 深度學習的出現讓很多人工智能相關技術取得了大幅度的進展,比如語音識別已經逼近臨界點,即將達到Game Changer水平;機器視覺也已經在安防、機器人、自動駕駛等多個領域得到應用。 ...

摘要:于月日至日在意大利比薩舉行,主會于日開始。自然語言理解領域的較高級科學家受邀在發表主旨演講。深度學習的方法在這兩方面都能起到作用。下一個突破,將是信息檢索。深度學習在崛起,在衰退的主席在卸任的告別信中這樣寫到我們的大會正在衰退。 SIGIR全稱ACM SIGIR ,是國際計算機協會信息檢索大會的縮寫,這是一個展示信息檢索領域中各種新技術和新成果的重要國際論壇。SIGIR 2016于 7月17...

摘要:深度學習浪潮這些年來,深度學習浪潮一直沖擊著計算語言學,而看起來年是這波浪潮全力沖擊自然語言處理會議的一年。深度學習的成功過去幾年,深度學習無疑開辟了驚人的技術進展。 機器翻譯、聊天機器人等自然語言處理應用正隨著深度學習技術的進展而得到更廣泛和更實際的應用,甚至會讓人認為深度學習可能就是自然語言處理的終極解決方案,但斯坦福大學計算機科學和語言學教授 Christopher D. Mannin...

閱讀 3258·2021-09-09 11:39

閱讀 1232·2021-09-09 09:33

閱讀 1134·2019-08-30 15:43

閱讀 554·2019-08-29 14:08

閱讀 1739·2019-08-26 13:49

閱讀 2382·2019-08-26 10:09

閱讀 1550·2019-08-23 17:13

閱讀 2288·2019-08-23 12:57