資訊專欄INFORMATION COLUMN

摘要:網絡所有的神經元都與另外的神經元相連每個節點功能都一樣。訓練的方法是將每個神經元的值設定為理想的模式,然后計算權重。輸入神經元在網絡整體更新后會成為輸入神經元。的訓練和運行過程與十分相似將輸入神經元設定為固定值,然后任網絡自己變化。

新的神經網絡架構隨時隨地都在出現,要時刻保持還有點難度。要把所有這些縮略語指代的網絡(DCIGN,IiLSTM,DCGAN,知道嗎?)都弄清,一開始估計還無從下手。

因此,我決定弄一個“作弊表”。這些圖里面話的大多數都是神經網絡,可也有一些是完全不同的物種。盡管所有這些架構都是新奇獨特的,但當我開始把它們畫下來的時候,每種架構的底層關系逐漸清晰。

一個問題是要把它們畫成節點圖:實際上這并沒有展示出它們是如何被使用的。比如說,VAE 看起來跟 AE 差不都,但這兩種網絡的訓練過程其實大不一樣。訓練好的網絡的使用方法就更不同了,因為 VAE 是生成器,在新樣本中插入噪音的,而 AE 則僅僅是將它們得到的輸入映射到它們“記憶”中最近的訓練樣本!需要說明的是,這個圖譜并沒有清晰呈現不同節點內在工作原理(那個留做后話)。

要編一份完全的名單尤其困難,因為新的架構隨時都在出現。即使是發表過的架構,有意識地去把它們都找全也有很大麻煩,要不就是有時候會落下一些。因此,雖說這幅圖會為你提供一些見解,但可千萬別認為這幅圖里的內容就是全部了。

圖中所描繪的每種架構,我都配上了非常非常簡短的說明,希望有用。

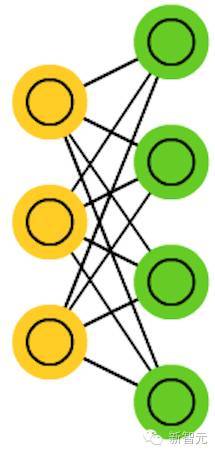

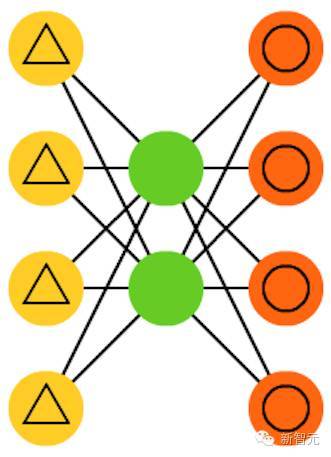

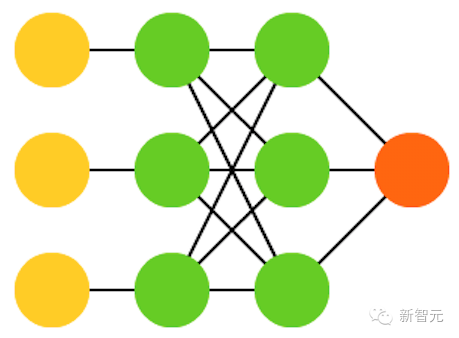

1. 前向傳播網絡(FF 或 FFNN)

非常直接,它們從前往后傳輸信息(分別是輸入和輸出)。神經網絡通常都有很多層,包括輸入層、隱藏層、輸出層。多帶帶一層不會有連接,一般相鄰的兩層是全部相連的(每一層的每個神經元都與另一層的每個神經元相連)。最簡單,從某種意義上說也是實用的網絡結構,有兩個輸入單元,一個輸出單元,可以用來為邏輯關口建模。FFNN 通常用反向傳播算法訓練,因為網絡會將“進來的”和“我們希望出來的”兩個數據集配對。這也被稱為監督學習,相對的是無監督學習,在無監督學習的情況下,我們只負責輸入,由網絡自己負責輸出。由反向傳播算法得出的誤差通常是在輸入和輸出之間差別的變化(比如 MSE 或線性差)。由于網絡有足夠多的隱藏層,從理論上說對輸入和輸出建模總是可能的。實際上,它們的使用范圍非常有限,但正向傳播網絡與其他網絡結合在一起會形成十分強大的網絡。

2. 徑向基函數(RBF)網絡

是以徑向基函數作為激活函數的 FFNN。RBF 就是這樣簡單。但是,這并不說它們沒有用,只是用其他函數作為激活函數的 FFNN 一般沒有自己多帶帶的名字。要有自己的名字,得遇上好時機才行。

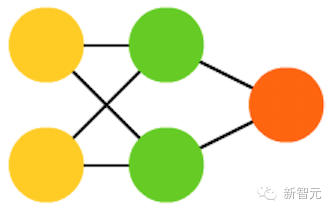

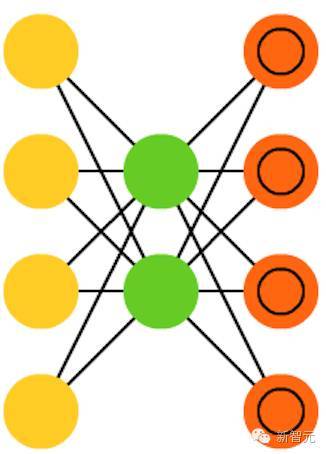

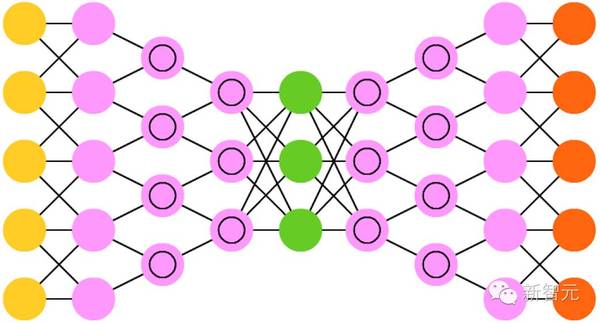

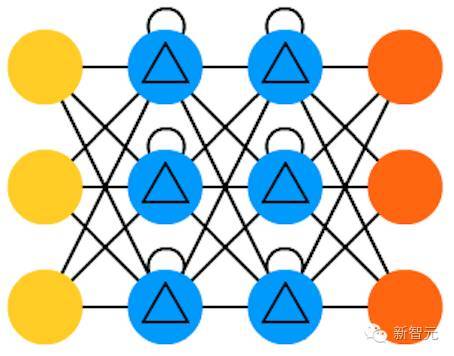

3. Hopfied 網絡(HN)

所有的神經元都與另外的神經元相連;每個節點功能都一樣。在訓練前,每個節點都是輸入;在訓練時,每個節點都隱藏;在訓練后,每個節點都是輸出。訓練 HN 的方法是將每個神經元的值設定為理想的模式,然后計算權重。這之后權重不會發生改變。一旦接收了訓練,網絡總會變成之前被訓練成的模式,因為整個網絡只有在這些狀態下才能達到穩定。需要注意的是,HN 不會總是與理想的狀態保持一致。網絡穩定的部分原因在于總的“能量”或“溫度”在訓練過程中逐漸縮小。每個神經元都有一個被激活的閾值,隨溫度發生變化,一旦超過輸入的總合,就會導致神經元變成兩個狀態中的一個(通常是 -1 或 1,有時候是 0 或 1)。更新網絡可以同步進行,也可以依次輪流進行,后者更為常見。當輪流更新網絡時,一個公平的隨機序列會被生成,每個單元會按照規定的次序進行更新。因此,當每個單元都經過更新而且不再發生變化時,你就能判斷出網絡是穩定的(不再收斂)。這些網絡也被稱為聯存儲器,因為它們會收斂到與輸入最相似的狀態;當人類看到半張桌子的時候,我們會想象出桌子的另一半,如果輸入一半噪音、一半桌子,HN 將收斂成一張桌子。

4. 馬爾科夫鏈(MC 或離散時間馬爾科夫鏈,DTMC)

是 BM 和 HN 的前身。可以這樣理解 DTMC:從我現在這個節點出發,達到相鄰節點的幾率有多大?它們是沒有記憶的,也即你的每一個狀態都完全取決于之前的狀態。雖然 DTMC 不是一個真正的神經網絡,他們卻有與神經網絡相似的性質,也構成了 BM 和 HN 的理論基礎。

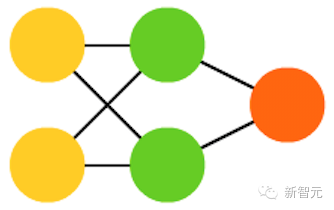

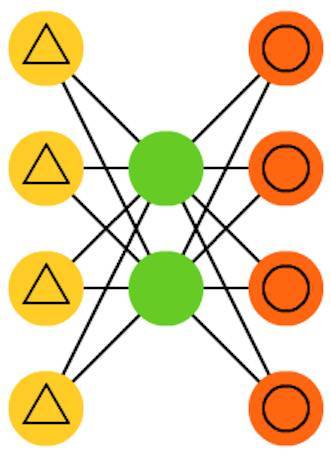

5. 玻爾茲曼機(BM)

和 HN 十分相似,但有些神經元被標記為輸入神經元,其他的神經元繼續保持“隱藏”。輸入神經元在網絡整體更新后會成為輸入神經元。一開始權重是隨機的,通過反向傳播算法,或者通過最近出現的對比散度(用馬爾科夫鏈決定兩個獲得信息之間的梯度)。相較于 HN,BM 的神經元有時候會呈現二元激活模式,但另一些時候則是隨機的。BM 的訓練和運行過程與 HN 十分相似:將輸入神經元設定為固定值,然后任網絡自己變化。反復在輸入神經元和隱藏神經元之間來回走動,最終網絡會在溫度恰當時達到平衡。

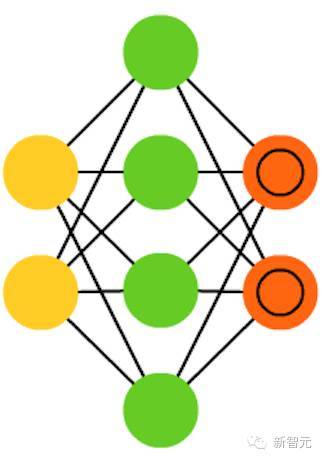

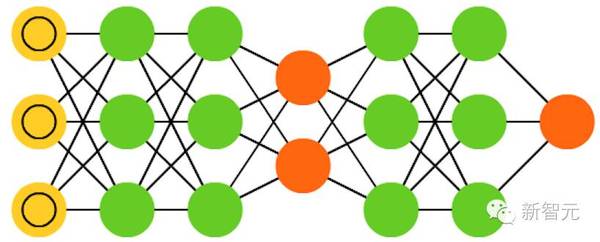

6. 受限玻爾茲曼機(RBM)

與 BM 十分相似(意外吧),因此也與 HN 十分相似。BM 與 RBM 較大的不同在于 RBM 因為受限所以實用性更大。RBM 的輸入神經元不與其他輸入神經元直接相連,隱藏神經元之間也不存在直接的連接。RBM 可以像 FFNN 一樣訓練:不采用將信息往前傳輸然后反向傳播的方法,你將信息往前傳,然后將輸出作為輸入(回到第一層)。這之后就可以用雙向傳播算法訓練網絡了。

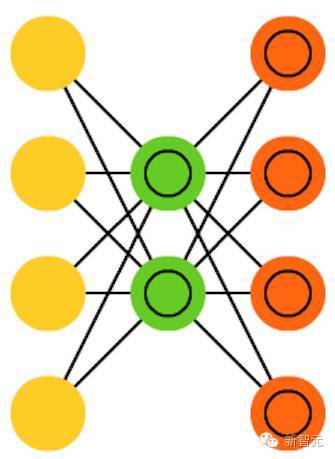

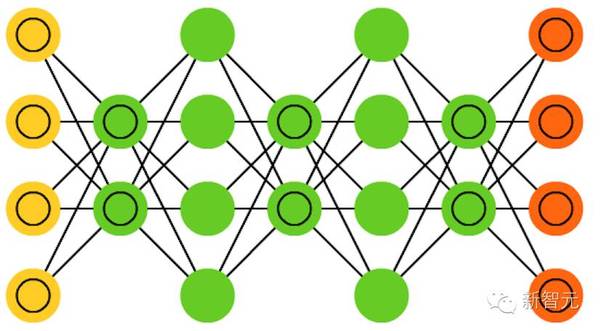

7. 自編碼器(AE)

跟 FFNN 有些類似,它只是 FFNN 的一種不同的用法,稱不上是從本質上與 FFNN 不同的另一種網絡。AE 的外觀看起來像沙漏,輸入和輸出比隱藏層大。AE 也沿中間層兩邊對稱。最小的層總是在中間,這里也是信息壓縮得最密集的地方。從開始到中間被稱為編碼部分,中間到最后被稱為解碼部分,中間(意外吧)被稱為代碼。你可以使用反向傳播算法訓練 AE。AE 兩邊是對稱的,因此編碼權重和解碼權重也是相等的。

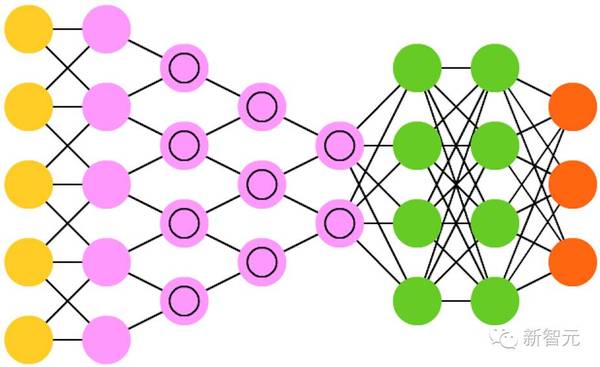

8. 稀疏自編碼器(SAE)

在某種程度上與 AE 相反。我們沒有讓網絡在更少的“空間”或節點上表征一堆信息,而是將信息編碼在更多的空間中。因此,網絡不是在中間收斂,而是在中間膨脹。這種類型的網絡可以被用來從一個數據集中提取很多小的特征。如果你使用訓練 AE 的方法訓練 SAE,最終你將會無一例外得到一個沒有用的、跟輸入一模一樣的網絡。因此,在反饋輸入時要增加一個稀疏驅動器(sparsity driver),這樣只有一定的誤差才會被輸送回去得到訓練,其他的誤差都“無關”,重新歸零。在某種意義上,這就像脈沖神經網絡一樣,不是所有的神經元都在同一時間發射。

9. 變分自編碼器(VAE)

和 AE 擁有同樣的架構,但“被教授”的東西卻不同:輸入樣本的近似概率分布。這有點回到本源的感覺,因為它們和 BM 及 RBM 的聯系更緊密一點。但它們確實依賴于貝葉斯數學來處理概率推理和獨立(probabilistic inference and independence),以及依靠重新參數化(re-parametrisation)來實現這種不同的表征。這種推理和獨立部件理解起來很直觀,但它們或多或少依賴于復雜的數學。其基礎可以歸結為:將影響考慮在內。如果某種事物在一個位置發生,而其它地方則發生其它事物,那么它們不一定是相關的。如果它們不相關,那么誤差傳播應該考慮一下這一點。這是一種有用的方法,因為神經網絡是大型的圖(graph,從某種角度來看),所以在深入到更深的層時如果排除掉一些節點對其它節點的影響,就會帶來幫助。

10. 去噪自編碼器(DAE)

是一種輸入中不僅包含數據,也包含噪聲(比如使圖像更有顆粒感)的自動編碼器。但我們以同樣的方式計算誤差,所以該網絡的輸出是與不帶噪聲的原始輸入進行比較。這能讓網絡不會學習細節,而是學習更廣泛的特征,因為學習更小的特征往往會被證明是「錯誤的」,因為更小的特征會不斷隨噪聲變化。

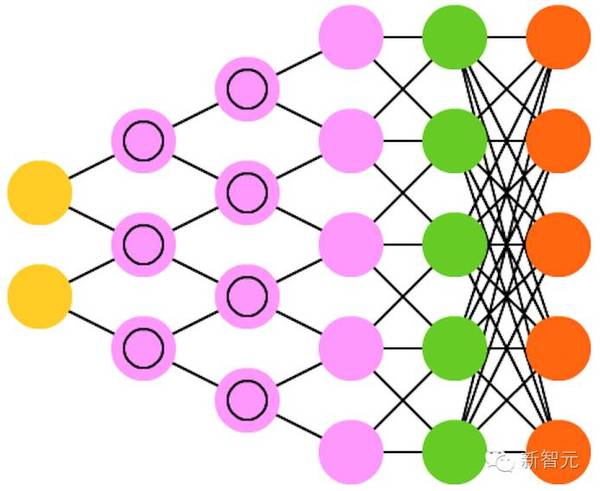

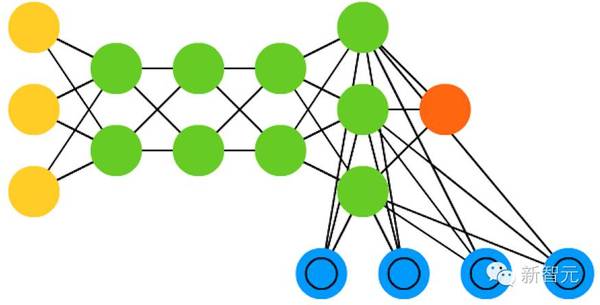

11. 深度信念網絡(DBN)

基本上是 RBM 或 VAE 堆疊起來的架構。事實已經證明這些網絡可以堆疊起來高效地訓練,其中的每一個 AE 或 REM 只必須編碼編碼之前的網絡即可。這種技術也被稱為貪婪訓練(greedy training),其中貪婪是指得到局部最優的解決方案,從而得到一個合理的但可能并非最優的答案。DBN 可通過對比發散(contrastive divergence)或反向傳播進行訓練,以及學習將數據表征為概率模型,就像普通的 RBM 或 VAE 一樣。一旦通過無監督學習訓練或收斂成了一個(更)穩定的狀態,該模型就可被用于生成新數據。如果采用對比發散進行訓練,它甚至可以對已有的數據進行分類,因為其神經元已經學會了尋找不同的特征。

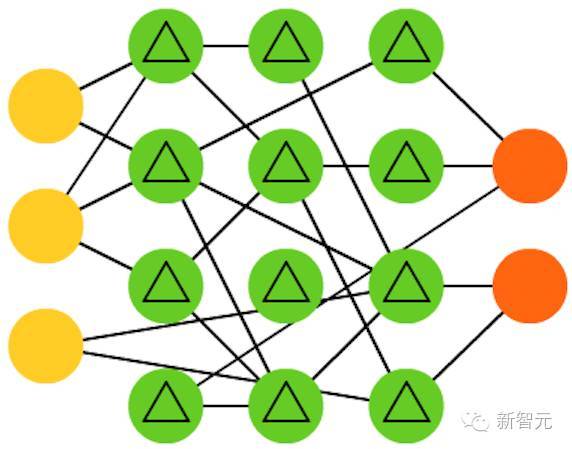

12. 卷積神經網絡(CNN)或深度卷積神經網絡(DCNN)

和其它大多數網絡非常不同。它們主要被用于圖像處理,但也可應用于音頻等其它類型的輸入。CNN 的一種典型的用例是讓網絡對輸入的圖像進行分類,CNN 往往開始帶有一個輸入“scanner”,其目的是不一次性解析所有的訓練數據。CNN 的真實世界實現往往會在末端連接一個 FFNN 以便進一步處理數據,這可以實現高度非線性的抽象。這樣的網絡被稱為 DCNN,但這兩者的名字和縮寫往往可以混用。

13. 解卷積神經網絡(DNN)

是反向的卷積神經網絡。比如給網絡輸入一個詞「cat」,然后訓練它生成一張類似貓的圖像(通過將其與真實的貓圖片進行比較)。和普通的 CNN 一樣,DNN 也能和 FFNN 結合使用,但我們就不給這種網絡縮寫了。我們也許可以將其稱之為深度解卷積神經網絡,但你也可以認為當你在 DNN 的前端和后端都接上 FFNN 時,你得到的架構應該有一個新名字。請注意在大多數應用中,人們實際上并不會為該網絡送入類似文本的輸入,而更多的是一個二元的分類輸入向量。比如設 <0, 1> 是貓,<1, 0> 是狗,<1, 1> 是貓和狗。CNN 中常見的池化層往往會被相似的逆向運算替代,主要使用偏差假設(biased assumptions)做插值和外推(interpolation and extrapolation )(如果一個池化層使用的是較大池化,你可以通過其逆向過程產生特定度更低的新數據)。

14. 深度卷積反向圖形網絡(DCIGN)

從某種程度上說,這個神經網絡的名字有一點欺騙性,它們實際上是VAE,但是在編碼和解碼中分別有CNN 和 DNN。這些網絡嘗試在編碼的過程中對“特征”作為概率建模,這樣一來,它只需要分別“看”貓和狗的獨照,就能學會生成一張既有貓又有狗的合照。類似的,你也可以讓它把貓狗合照中的狗去掉,如果你很討厭那只狗的話。Demo顯示,這些模型可以學習為圖像中復雜的轉換進行建模,比如源文件中3D物體光線的改變。這種網絡傾向于使用反向傳播進行訓練。

15. 生成對抗網絡(GAN)

GAN由不同的網絡組成,這些網絡是成對的:每兩個網絡配對工作。任何一對網站都可以組成 GAN(雖然通常由FFs 和 CNN 配對),一個網絡的任務是生成內容,另一個負責對內容進行評價。進行鑒別的網絡從訓練數據或者生成式的網絡中獲得內容。鑒別網絡能正確地預測數據源,隨后將會被當成誤差生成網絡中的一部分。這形成了一種對抗:鑒別器在對生成數據和真實數據進行區分時做得越來越好,生成器也在學習如何不被鑒別器預測到。這種網絡能取得良好的效果,部分原因是,即便非常復雜的嘈雜模型最終也都是可預測的,但是它只生成與特征類似的內容,所以很難學會鑒別。GAN 很難訓練,因為你不僅需要訓練兩個網絡(況且其中的每一個都有自己的問題),而且二者的動態也需要被平衡。?

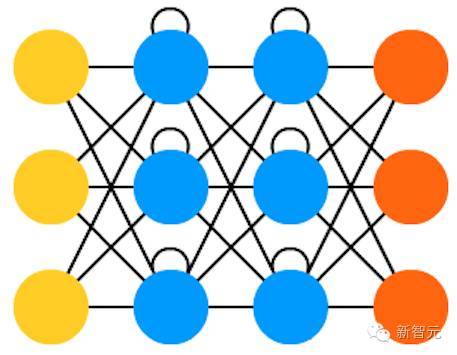

16.循環神經網絡(RNN)

RNN 是一種包含時間糾纏的 FFNN: 他們不是無主的stateless;他們在通道間是有聯系的,通過時間進行連接。神經元不僅從上一層神經網絡獲得信息,而且可以從自身、從上一個通道中獲得信息。也就是說,輸入和訓練網絡的順序會變得很重要。RNN 有一個很大的問題是梯度消失或爆炸,這取決于所使用的激活函數,在這一過程中,信息會不斷地迅速消失,正如極深的FFNN 網絡在的信息丟失一樣。直觀地說,這并不是一個大問題,因為他們只是權重而不是神經元狀態,但是,經過多次加權后,權重已經成為了舊信息的存儲地,如果權重達到0或者100萬,那么此前的狀態就沒有什么信息意義了。RNN 可以在許多領域得到應用,因為絕大多數形式的數據并不真的擁有可以用序列表示的時間線(比如,聲音或者視頻)。總的來說,循環網絡對于完整的信息來說是一個很好的選擇。

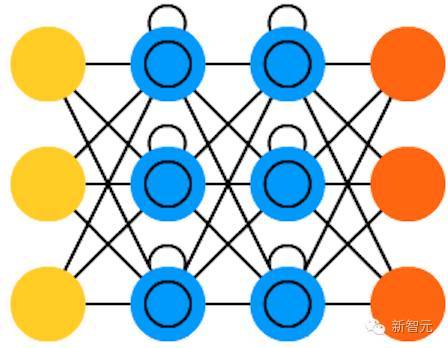

17.長/短時記憶網絡 (LSTM)

LSTM 通過引入關口(gate)和一個較精確定義的記憶單元,嘗試解決梯度消失或者爆炸的問題。這一概念大部分是從電路學獲得的啟發,而不是從生物學。每一個神經元都有一個存儲單元和三個關口:輸入、輸出和忽略(forget)。這些關口的功能是通過運行或者禁止流動來保證信息的安全。輸入關口決定有多少上一層的信息可以存儲到單元中。輸出層承擔了另一端的工作,決定下一層可以了解到多少這一層的信息。忽略關口初看是一個很奇怪的設計,但是,有時候忽略也是很重要的:如果網絡正在學習一本書,并開始新的一章,那么忘掉前幾章的一些內容也是很有必要的。LSTM已經被證明可以學習復雜的序列,包括像莎士比亞一樣寫作,或者創作音樂。需要注意的是,這些關口中的每一個都對前一個神經元中的存儲單元賦有權重,所以他們一般會需要更多想資源來運行。

18 . 關口循環單元(GRU)

是 LSTM 的一種輕量級變體。它們有一個關口,連線方式也稍微不同:沒有輸入、輸出、遺忘關口,它們有一個更新關口(update gate)。該更新關口既決定來自上個狀態的信息保留多少,也決定允許進入多少來自上個層的信息。重置的關口函數很像 LSTM 中遺忘關口函數,但位置稍有不同。GRU 的關口函數總是發出全部狀態,它們沒有一個輸出關口。在大多案例中,它們的職能與 LSTM 很相似。較大的不同就是 GRU 更快、更容易運行(但表達力也更弱)。在實踐中,可能彼此之間要做出平衡,當你需要具有更大表達力的大型網絡時,你可能要考慮性能收益。在一些案例中,r如果額外的表達力不再需要,GRU 就要比 LSTM 好。

19. 神經圖靈機(NTM)

可被理解為 LSTM 的抽象化,并試圖將神經網絡去黑箱化( un-black-box,讓我們洞見里面到底發生了什么。)NTM 中并非直接編碼記憶單元到神經元中,里面的記憶是分離的。這種網絡試圖想將常規數字存儲的功效與永久性和神經網絡的效率與表達力結合起來。這種網絡的思路是有一個可內容尋址的記憶庫,神經網絡可以直接從中讀取并編寫。NTM 中的「Turing」來自于圖靈完備(Turing complete):基于它所讀取的內容讀取、編寫和改變狀態的能力,意味著它能表達一個通用圖靈機可表達的一切事情。

20. 雙向循環神經網絡(BiRNN)、雙向長短期記憶網絡(BiLSTM)和雙向關口控循環單元(BiGRU)

在詞表中并未展現,因為它們看起來和各自單向的結構一樣。不同的是這些網絡不僅連接過去,也連接未來。舉個例子,通過一個接一個的輸入 fish 這個詞訓練單向 LSTM 預測 fish,在這里面循環連接隨時間記住最后的值。而一個 BiLSTM 在后向通路(backward pass)的序列中就被輸入下一個詞,給它通向未來的信息。這訓練該網絡填補空白而非預報信息,也就是在圖像中它并非擴展圖像的邊界,而是可以填補一張圖片中的缺失。

21.深度殘差網絡(DRN)

是非常深度的 FFNN 網絡,有著額外的連接將輸入從一層傳到后面幾層(通常是 2 到 5 層)。DRN 并非是要發現將一些輸入(比如一個 5 層網絡)映射到輸出的解決方案,而是學習將一些輸入映射到一些輸出 + 輸入上。大體上,它在解決方案中增加了一個恒等函數,攜帶舊的輸入作為后面層的新輸入。有結果顯示,在超過 150 層后,這些網絡非常擅長學習模式,這要比常規的 2 到 5 層多得多。然而,有結果證明這些網絡本質上只是沒有基于具體時間建造的 RNN ,它們總是與沒有 關口的 LSTM 相對比。

22. 回聲狀態網絡(ESN)

是另一種不同類型的網絡。它不同于其他網絡的原因在于它在不同神經元之間有隨機連接(即,不是在層之間整齊連接。),而且它們訓練方式也不同。在這種網絡中,我們先給予輸入,向前推送并對神經元更新一段時間,然后隨時間觀察輸出,而不是像其他網絡那樣輸入信息然后反向傳播誤差。ESN 的輸入和輸出層有一些輕微的卷積,因為輸入層被用于準備網絡,輸出層作為隨時間展開的激活模式的觀測器。在訓練過程中,只有觀測器和隱藏單元之間連接會被改變。

23. 液態機(LSM)

看起來與 ESN 非常類似。不同的是,LSM 是脈沖神經網絡(spiking neural networks)這一類型的:用閾值函數取代 sigmoid 激活函數,每個神經元也是一個累加記憶細胞。所以當更新神經元的時候,里面的值并不是被設為臨近值的總和,也不是增加到它自身上。一旦達到閾值,它將能量釋放到其他神經元。這就創造出了一種類似 spiking 的模式——在突然達到閾值的之前什么也不會發生。

24. 支持向量機(SVM)

能發現分類問題的較佳解決方案。傳統上只能夠分類線性可分的數據,比如說發現哪個圖像是加菲貓,哪張圖片是史努比,不可能有其他輸出。在訓練過程中,SVM 可被視為在一張圖上(2D)標繪所有數據(加菲貓和史努比),并搞清楚如何在這些數據點間畫條線。這條線將分割數據,以使得加菲貓在一邊,史努比在一邊。調整這條線到較佳的方式是邊緣位于數據點之間,這條線較大化到兩端。分類新數據可通過在這張圖上標繪一個點來完成,然后就簡單看到這個點位于線的哪邊。使用核(kernel)方法,它們可被教授進行 n 維數據的分類。這要在 3D 圖上標繪數據點,從而讓其可分類史努比、加菲貓、Simon’s cat,甚至分類更多的卡通形象。

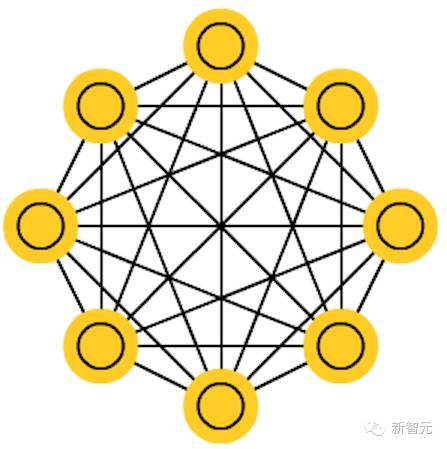

25.Kohonen 網絡(KN)

KN 利用競爭學習在無監督情況下分類數據。向網絡輸入信息,然后網絡評估哪個神經元最匹配該輸入信息。進而調整這些神經元以更好地匹配輸入,在這個過程中附帶著相鄰神經元。相鄰神經元能移動多少取決于它們與較好的匹配單元之間的距離。

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4399.html

摘要:多種學科為神經科學做出貢獻。對正常的心智功能如學習和記憶,以及異常功能如抑郁精神分裂和阿爾茨海默病,遺傳學鑒定了與之相關的基因。 大腦的未來,在作者的描述之下,真是一個令人興奮又令人擔憂的未來。——蒲慕明我是一個神經科學家,也就是說,我在研究腦如何工作。就像其他許多神經科學家一樣,我做這門學問,是因為我相信在分子、細胞和系統層次探索腦如何工作,我們可以對思維如何運作有些理解。對我來說,這是一...

摘要:作為生命科學的神經科學,依然以和蛋白質為基礎,橫跨分子,細胞,組織,動物行為等各個尺度,描繪神經系統的形態和行為。你埋頭在蛋白質的研究中,不代表你對神經網絡有任何有效的理解。平衡狀態的神經網絡具有較大的對外界信號較大的響應能力。 承接上文,計算神經科學是一門超級跨學科的新興學科,幾乎綜合信息科學,物理學, 數學,生物學,認知心理學等眾多領域的成果。大腦像一臺超級計算機,同時它又迥異于計算機,...

摘要:淺層結構化預測方法有損失的條件隨機域,有的較大邊緣馬爾可夫網絡和隱支持向量機,有感知損失的結構化感知深層結構化預測圖變換網絡圖變換網絡深度學習上的結構化預測該圖例展示了結構化感知損失實際上,使用了負對數似然函數損失于年配置在支票閱讀器上。 卷積網絡和深度學習的動機:端到端的學習一些老方法:步長內核,非共享的本地連接,度量學習,全卷積訓練深度學習缺少什么?基礎理論推理、結構化預測記憶有效的監督...

摘要:有幾次,人工智能死在人工神經網絡上。在過去十年中,他一直在舉辦為期一周的有關神經網絡的暑期學校,我曾經拜訪過。神經網絡壓縮信息之后,這些信息無法復原。 魔法已經進入這個世界。如今,許多美國人口袋里裝著薄薄的黑色平板,這些機器接入遙遠的數字云和衛星,它們解碼語言、通過攝像頭觀察并標記現實,挖掘個人數據,它們以某種方式理解、預測著我們的心愿。傾聽、幫助著人類。因為與多倫多大學有個約會,這個夏天,...

摘要:多加了這兩層卷積層和匯集層是卷積神經網絡和普通舊神經網絡的主要區別。卷積神經網絡的操作過程那時,卷積的思想被稱作權值共享,也在年和關于反向傳播的延伸分析中得到了切實討論。 導讀:這是《神經網絡和深度學習簡史》第二部分,這一部分我們會了解BP算法發展之后一些取得迅猛發展的研究,稍后我們會看到深度學習的關鍵性基礎。神經網絡獲得視覺隨著訓練多層神經網絡的謎題被揭開,這個話題再一次變得空前熱門,羅森...

閱讀 3826·2021-11-25 09:43

閱讀 2169·2021-11-23 10:11

閱讀 1396·2021-09-29 09:35

閱讀 1309·2021-09-24 10:31

閱讀 2034·2019-08-30 15:48

閱讀 2352·2019-08-29 15:28

閱讀 424·2019-08-29 12:36

閱讀 3489·2019-08-28 18:12