資訊專欄INFORMATION COLUMN

摘要:所以卷積神經(jīng)網(wǎng)絡(luò)卷積池化假設(shè)矩陣為的矩陣,池化窗口為,則按照池化窗口大小將矩陣分割成塊不相交的小矩陣,對對每個塊中的所有元素做求和平均操作,稱為平均池化,取較大值則稱為較大池化。卷積神經(jīng)網(wǎng)絡(luò)卷積神經(jīng)網(wǎng)絡(luò)是權(quán)值共享,非全連接的神經(jīng)網(wǎng)絡(luò)。

卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network, CNN)是一種前饋神經(jīng)網(wǎng)絡(luò),每個神經(jīng)元都只影響鄰層的一部分神經(jīng)元,具有局部感受野,因此,網(wǎng)絡(luò)具有極強(qiáng)的捕捉局部特征的能力;另一方面,通過權(quán)值共享和池化,顯著地降低了網(wǎng)絡(luò)的計算復(fù)雜度,使得CNN得到廣泛應(yīng)用。CNN是圖像分類和語音識別領(lǐng)域的杰出算法,也是目前大部分計算機(jī)視覺系統(tǒng)的核心技術(shù),從facebook的圖像自動標(biāo)簽到自動駕駛汽車,乃至AlphaGo都在使用。與此同時,近兩年CNN逐漸被應(yīng)用于NLP任務(wù),在sentence classification中,基于CNN的模型取得了非常顯著的效果。

本文假設(shè)讀者比較熟悉神經(jīng)網(wǎng)絡(luò)的相關(guān)知識,特別是反向傳播算法的過程,從數(shù)學(xué)推導(dǎo)的角度來理解CNN的內(nèi)部原理。

1 神經(jīng)網(wǎng)絡(luò)

神經(jīng)網(wǎng)絡(luò)是由多個感知器(神經(jīng)元)構(gòu)成的全連接的網(wǎng)絡(luò),本質(zhì)上來說,這樣的連接只是簡單的線性加權(quán)和而已,所以每個神經(jīng)元加上同一個非線性函數(shù)(如sigmoid,tanh等),使得網(wǎng)絡(luò)能擬合非線性。通常,稱這個非線性函數(shù)為激活函數(shù)。一個典型的全連接神經(jīng)網(wǎng)絡(luò)如下所示:?

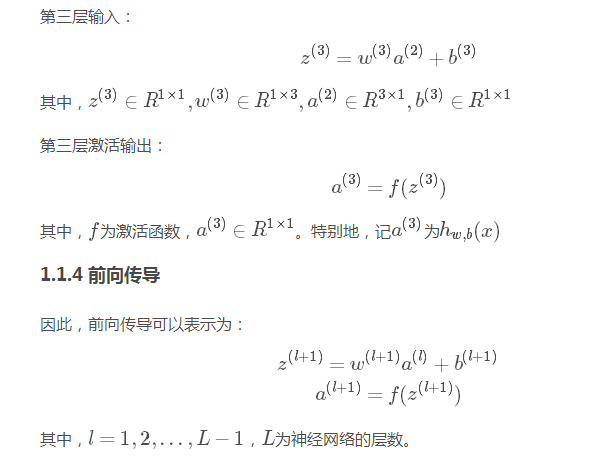

1.1 前向傳導(dǎo)

上圖中,每個圓圈代表一個神經(jīng)元(標(biāo)上“+1”的是偏置節(jié)點,不算入神經(jīng)元),從神經(jīng)元引出的連接是參數(shù)矩陣w,從偏置節(jié)點引出的是參數(shù)向量b。w和b是整個網(wǎng)絡(luò)最重要的參數(shù)。

1.1.3 輸出層

1.2 反向傳播

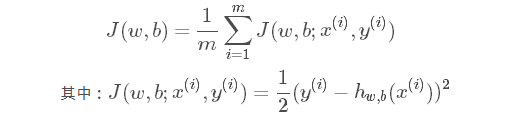

假設(shè)神經(jīng)網(wǎng)絡(luò)的代價函數(shù)為:

即,網(wǎng)絡(luò)的整體代價為所有訓(xùn)練樣例的平均代價。

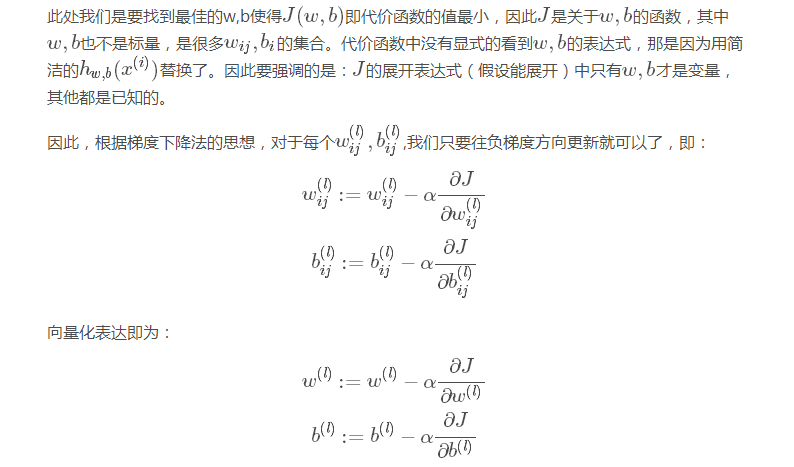

其中,αα是學(xué)習(xí)率。

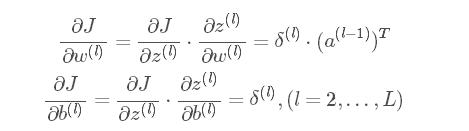

因此,只要能求出w,bw,b的偏導(dǎo)數(shù)就能迭代更新,從而完成整個算法。看似簡單,但卻困難。因為J(w,b)J(w,b)是很難寫出顯式表達(dá)式的,從而很難對每個wij,bijwij,bij都求出偏導(dǎo),主要原因是網(wǎng)絡(luò)是分層的進(jìn)而w,bw,b也是分層,這才導(dǎo)致了偏導(dǎo)的難求,從而才有了反向傳播。

所以:

2 卷積神經(jīng)網(wǎng)絡(luò)

2.1 卷積

2.2 池化

假設(shè)矩陣C為6×46×4的矩陣,池化窗口為2×22×2,則按照池化窗口大小將矩陣C分割成6塊不相交的2×22×2小矩陣,對對每個塊中的所有元素做求和平均操作,稱為平均池化,取較大 值則稱為較大池化。得到的矩陣S稱為pool map。如:

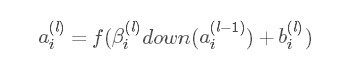

由于池化也稱為下采樣,用S=down(C)S=down(C)表示,為了使得池化層具有可學(xué)習(xí)性,一般令:

其中,ββ和bb為標(biāo)量參數(shù)。

2.3 卷積神經(jīng)網(wǎng)絡(luò)

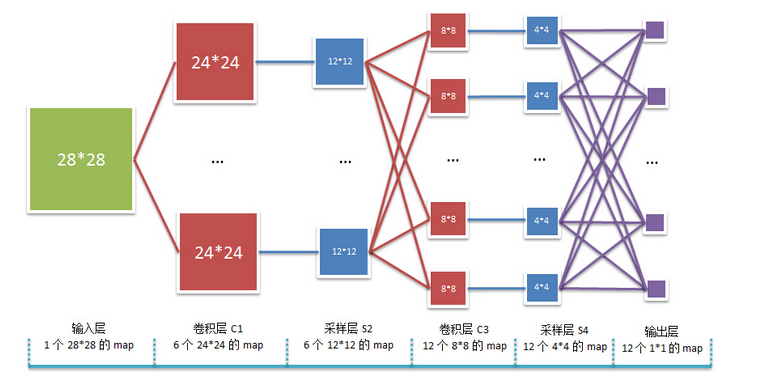

卷積神經(jīng)網(wǎng)絡(luò)是權(quán)值共享,非全連接的神經(jīng)網(wǎng)絡(luò)。以2個卷積層和2個池化層的卷積神經(jīng)網(wǎng)絡(luò)為例,其結(jié)構(gòu)圖如下:?

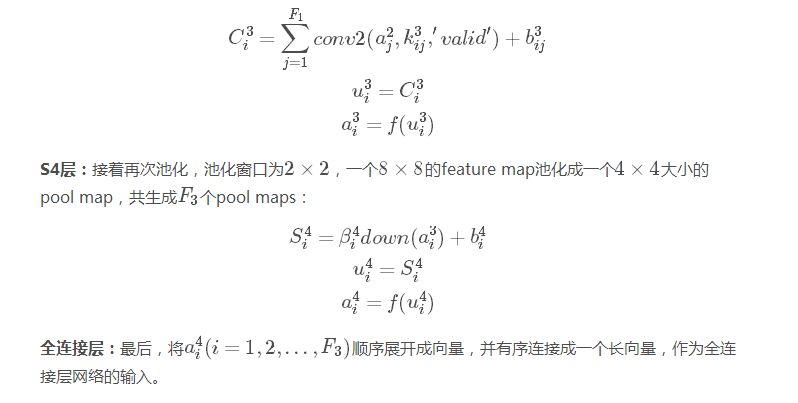

2.3.1 前向傳導(dǎo)

2.3.2 反向傳播

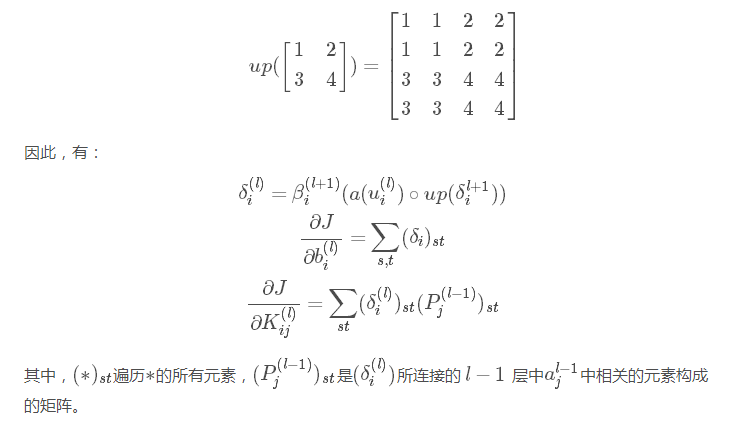

卷積神經(jīng)網(wǎng)絡(luò)的反向傳播本質(zhì)上是和BP神經(jīng)網(wǎng)絡(luò)是一致的,區(qū)別在于全連接和非全連接:在反向求導(dǎo)時,卷積神經(jīng)網(wǎng)絡(luò)要明確參數(shù)連接了哪些神經(jīng)元;而全連接的普通神經(jīng)網(wǎng)絡(luò)中的相鄰兩層的神經(jīng)元都是與另一層的所有神經(jīng)元相連的,因此反向求導(dǎo)時非常簡單。

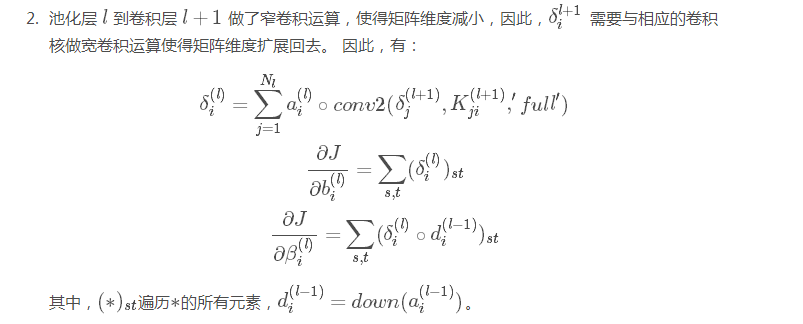

池化層 假設(shè)當(dāng)前池化層為 ll,下一層為全連接層,那么當(dāng)前池化層就是全連接層的輸入,可以根據(jù)全連接層的 BP 求導(dǎo)公式遞推算出。因此只需討論下一層 l+1l+1 為卷積層的情形,上一層 lㄢ氀ㄢ開為卷積層,該情形下有:

同樣地,為了求得池化層 ll 的各個神經(jīng)元的δδ,關(guān)鍵是要必須弄清楚該神經(jīng)元與 l+1l+1層中的哪些神經(jīng)元連接,因為求該神經(jīng)元的δδ時,只與這些神經(jīng)元相關(guān)。遞推的方式與全 連接的神經(jīng)網(wǎng)絡(luò)的不同之處在于:

池化層 ll 的各個神經(jīng)元的δδ只和 l+1l+1 層的相關(guān)神經(jīng)元有關(guān)

池化層 ll 到卷積層 l+1l+1 做了窄卷積運算,使得矩陣維度減小,因此,δl+1iδil+1 需要與相應(yīng)的卷積核做寬卷積運算使得矩陣維度擴(kuò)展回去。 因此,有:

參考資料

UFLDL Tutorial

GradientBased Learning Applied to Document Recognition

Notes on Convolutional Neural Networks

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價值的辦法,實際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉庫,數(shù)據(jù)挖掘工具,報表系統(tǒng)等全方位知識

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://specialneedsforspecialkids.com/yun/4378.html

摘要:本論文將嘗試概述卷積網(wǎng)絡(luò)的架構(gòu),并解釋包含激活函數(shù)損失函數(shù)前向傳播和反向傳播的數(shù)學(xué)推導(dǎo)。本文試圖只考慮帶有梯度下降優(yōu)化的典型卷積神經(jīng)網(wǎng)絡(luò)架構(gòu)的制定。 近日南洋理工大學(xué)研究者發(fā)布了一篇描述卷積網(wǎng)絡(luò)數(shù)學(xué)原理的論文,該論文從數(shù)學(xué)的角度闡述整個卷積網(wǎng)絡(luò)的運算與傳播過程。該論文對理解卷積網(wǎng)絡(luò)的數(shù)學(xué)本質(zhì)非常有幫助,有助于讀者「徒手」(不使用卷積API)實現(xiàn)卷積網(wǎng)絡(luò)。論文地址:https://arxiv....

摘要:百度網(wǎng)盤提取碼最近一直關(guān)注貪心學(xué)院的機(jī)器學(xué)習(xí)訓(xùn)練營,發(fā)現(xiàn)這門課講的很有深度,不僅適合職場也適合科研人員,加入行業(yè)拿到高薪僅僅是職業(yè)生涯的開始。 ??百度網(wǎng)盤??提取碼:u6C4最近一直關(guān)注貪心學(xué)院的機(jī)器學(xué)習(xí)訓(xùn)練營,發(fā)現(xiàn)這門課講的很有深度,不僅適合職場也適合科研人員,加入AI行業(yè)拿到高薪僅僅是職業(yè)生涯的開始。現(xiàn)階段AI人才結(jié)...

摘要:卷積神經(jīng)網(wǎng)絡(luò)除了為機(jī)器人和自動駕駛汽車的視覺助力之外,還可以成功識別人臉,物體和交通標(biāo)志。卷積卷積神經(jīng)網(wǎng)絡(luò)的名字來源于卷積運算。在卷積神經(jīng)網(wǎng)絡(luò)中,卷積的主要目的是從輸入圖像中提取特征。 什么是卷積神經(jīng)網(wǎng)絡(luò),它為何重要?卷積神經(jīng)網(wǎng)絡(luò)(也稱作 ConvNets 或 CNN)是神經(jīng)網(wǎng)絡(luò)的一種,它在圖像識別和分類等領(lǐng)域已被證明非常有效。 卷積神經(jīng)網(wǎng)絡(luò)除了為機(jī)器人和自動駕駛汽車的視覺助力之外,還可以成...

摘要:但實際上機(jī)器學(xué)習(xí)算法落地程序并不難寫,下面是行代碼實現(xiàn)的反向多層神經(jīng)網(wǎng)絡(luò)算法,也就是深度學(xué)習(xí)。神經(jīng)網(wǎng)絡(luò)的算法程序?qū)崿F(xiàn)神經(jīng)網(wǎng)絡(luò)的算法程序?qū)崿F(xiàn)分為初始化向前計算結(jié)果,反向修改權(quán)重三個過程。 對于現(xiàn)在流行的深度學(xué)習(xí),保持學(xué)習(xí)精神是必要的——程序員尤其是架構(gòu)師永遠(yuǎn)都要對核心技術(shù)和關(guān)鍵算法保持關(guān)注和敏感,必要時要動手寫一寫掌握下來,先不用關(guān)心什么時候用到——用不用是政治問題,會不會寫是技術(shù)問題,就像軍...

摘要:在圖像分析中,卷積神經(jīng)網(wǎng)絡(luò)在時間和內(nèi)存方面優(yōu)于全連接網(wǎng)絡(luò)。這是為什么呢卷積神經(jīng)網(wǎng)絡(luò)優(yōu)于全連接網(wǎng)絡(luò)的優(yōu)勢是什么呢卷積神經(jīng)網(wǎng)絡(luò)是如何從全連接網(wǎng)絡(luò)中派生出來的呢卷積神經(jīng)網(wǎng)絡(luò)這個術(shù)語又是從哪里而來這些問題在本文中一一為大家解答。 在圖像分析中,卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks, CNN)在時間和內(nèi)存方面優(yōu)于全連接網(wǎng)絡(luò)(Full Connected, FC)。這...

閱讀 3267·2023-04-25 14:35

閱讀 3417·2021-11-15 18:00

閱讀 2537·2021-11-12 10:34

閱讀 2481·2021-11-11 16:54

閱讀 3464·2021-10-08 10:12

閱讀 2762·2021-09-06 15:02

閱讀 3318·2021-09-04 16:48

閱讀 2799·2019-08-29 14:02