資訊專欄INFORMATION COLUMN

本文梳理了OpenAI團(tuán)隊(duì)最新的GPT-4.o(“o”代表“omni 全方位”)模型發(fā)布內(nèi)容,以O(shè)penAI團(tuán)隊(duì)發(fā)布會(huì)口吻整理。

我們很高興地宣布,推出了全新的旗艦?zāi)P?GPT-4o,能夠在音頻、視覺(jué)和文本之間實(shí)時(shí)進(jìn)行推理。

GPT-4o(“o”代表“omni 全方位”)能夠?qū)崟r(shí)處理音頻、視覺(jué)和文本信息,使人機(jī)交互更加自然流暢。這款模型支持多種輸入(文本、音頻、圖像)和輸出(文本、音頻、圖像)模式,其響應(yīng)音頻的速度極快,最快可達(dá) 232 毫秒,平均響應(yīng)時(shí)間為 320 毫秒,與人類在對(duì)話中的反應(yīng)速度相當(dāng)。無(wú)論是處理英語(yǔ)文本還是代碼,GPT-4o 的表現(xiàn)堪比 GPT-4 Turbo,而在處理非英語(yǔ)文本方面則有了顯著提升,同時(shí)運(yùn)行速度更快,API 成本也減少了 50%。特別是在視覺(jué)和音頻理解方面,GPT-4o 表現(xiàn)遠(yuǎn)超以往模型。

模型能力

在引入 GPT-4o 之前,通過(guò)語(yǔ)音模式與 ChatGPT 對(duì)話的平均延遲時(shí)間分別為 2.8 秒(GPT-3.5 版)和 5.4 秒(GPT-4 版)。之前的語(yǔ)音模式通過(guò)三個(gè)模型串聯(lián)實(shí)現(xiàn),首先將音頻轉(zhuǎn)為文本,然后由 GPT-3.5 或 GPT-4 處理文本并回復(fù),最后一個(gè)模型將文本轉(zhuǎn)回音頻。這種方式的缺點(diǎn)是 GPT-4 無(wú)法直接處理音調(diào)、多人對(duì)話或背景噪聲,也無(wú)法生成笑聲、歌聲或表達(dá)情感等。

GPT-4o 是通過(guò)一個(gè)全新的端到端模型訓(xùn)練而成,能夠統(tǒng)一處理文本、視覺(jué)和音頻輸入與輸出。作為我們首次嘗試整合這些多種模態(tài)的模型,GPT-4o 開啟了對(duì)這些功能和可能的限制更深入探索的大門。

模型評(píng)估

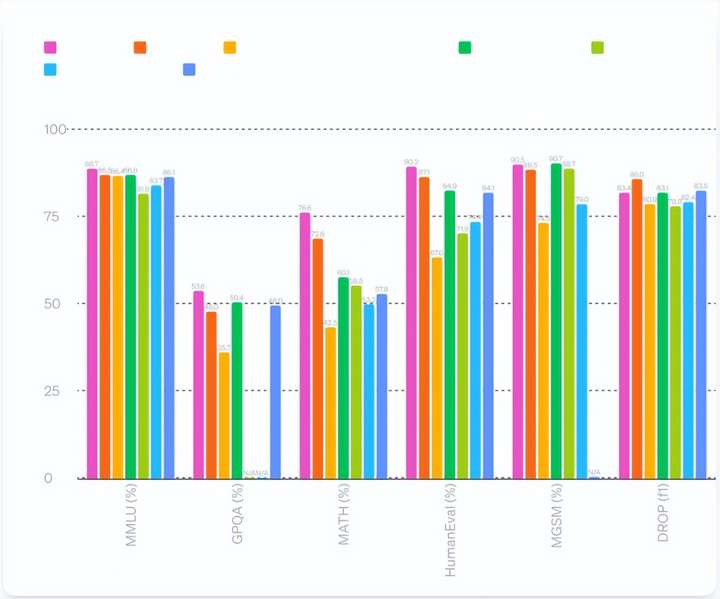

根據(jù)傳統(tǒng)的基準(zhǔn)測(cè)試,GPT-4o 在文本處理、邏輯推理和編程能力方面與 GPT-4 Turbo 相當(dāng),而在多語(yǔ)言處理、音頻和視覺(jué)技術(shù)方面則設(shè)立了新的最高標(biāo)準(zhǔn)。

文本能力評(píng)估

文本能力評(píng)估中,GPT-4o 在沒(méi)有任何預(yù)設(shè)條件下對(duì)通用知識(shí)問(wèn)題的處理能力達(dá)到了新高分 88.7%。這些評(píng)分均通過(guò)我們新開發(fā)的簡(jiǎn)單評(píng)估工具庫(kù)獲得。此外,在傳統(tǒng)的少量信息輸入條件下,GPT-4o 的得分也達(dá)到了 87.2% 的新高。(注:目前 Llama3 400b 還在訓(xùn)練過(guò)程中)

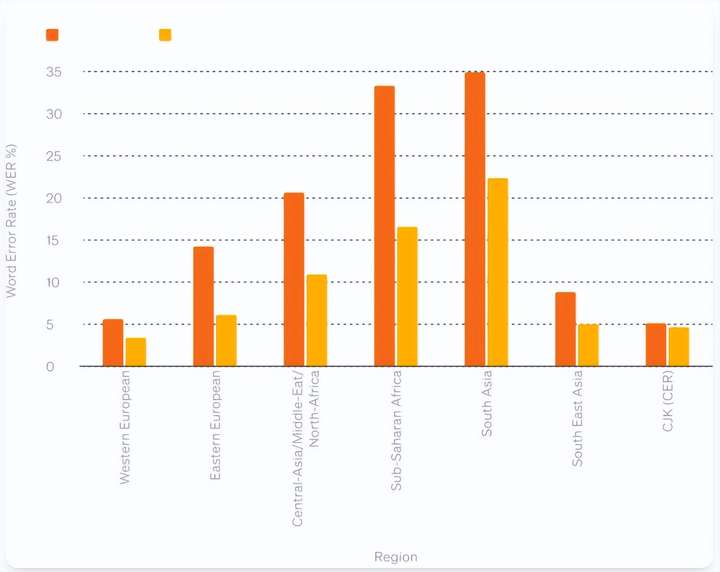

音頻識(shí)別性能

在音頻識(shí)別性能方面,GPT-4o 對(duì)所有語(yǔ)言的語(yǔ)音識(shí)別能

力都有顯著提升,尤其是在資源較少的語(yǔ)言上,其表現(xiàn)遠(yuǎn)超 Whisper-v3。

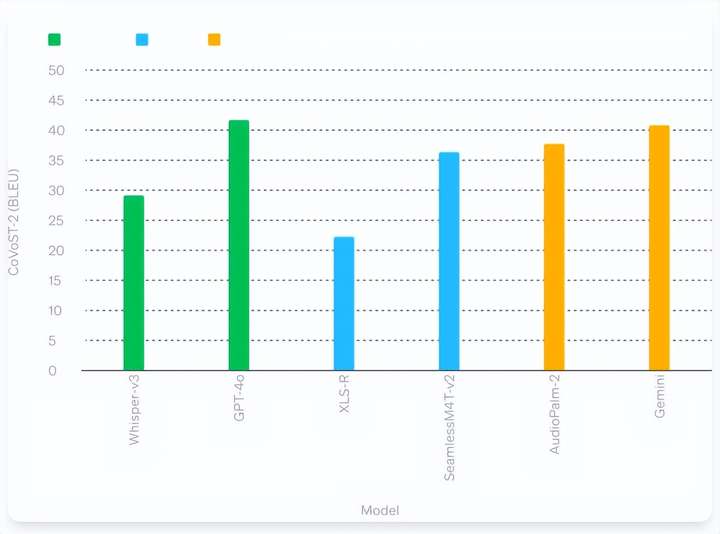

音頻翻譯性能

在音頻翻譯領(lǐng)域,GPT-4o 創(chuàng)下了新的行業(yè)標(biāo)準(zhǔn),其在 MLS 基準(zhǔn)測(cè)試中的表現(xiàn)優(yōu)于 Whisper-v3。

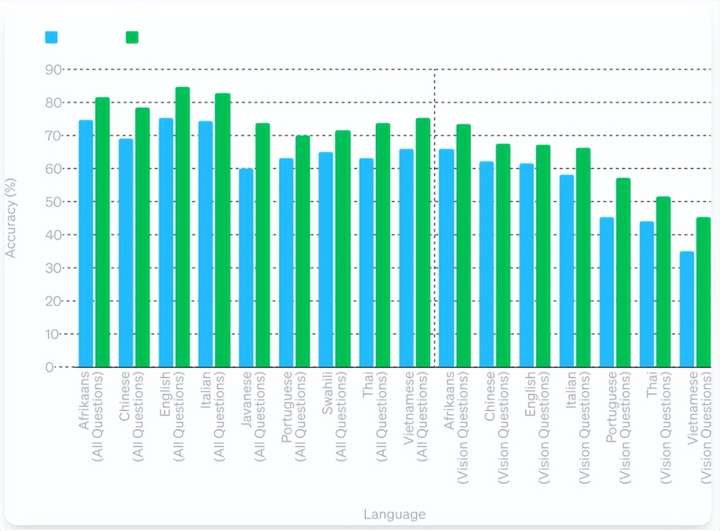

M3Exam 零樣本測(cè)試結(jié)果

M3Exam 基準(zhǔn)測(cè)試涵蓋了多語(yǔ)言和視覺(jué)分析,包括來(lái)自不同國(guó)家標(biāo)準(zhǔn)化測(cè)試的多項(xiàng)選擇題,這些題目有時(shí)會(huì)包含圖形和示意圖。GPT-4o 在這一測(cè)試中所有語(yǔ)言的表現(xiàn)都優(yōu)于 GPT-4。(對(duì)于 Swahili 和 Javanese,由于視覺(jué)題目較少(少于五題),所以沒(méi)有包括其視覺(jué)結(jié)果。)

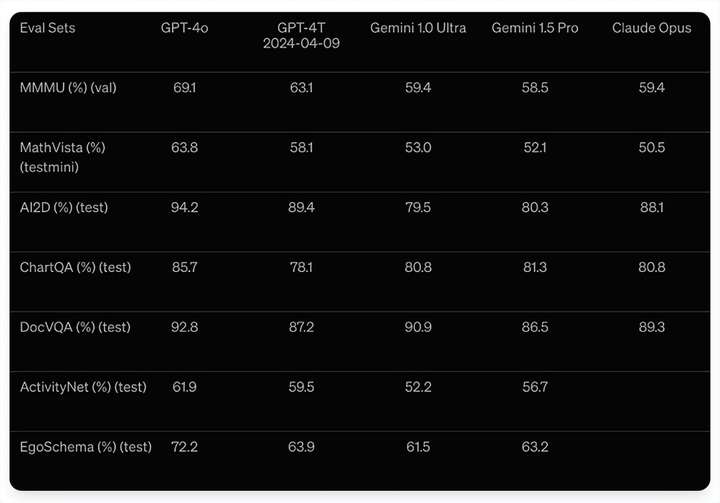

視覺(jué)理解評(píng)估

在視覺(jué)理解方面,GPT-4o 在視覺(jué)感知基準(zhǔn)測(cè)試中展現(xiàn)了領(lǐng)先的技術(shù)水平。所有視覺(jué)評(píng)估均為零信息輸入條件下完成,涵蓋了 MMMU、MathVista 和 ChartQA 的測(cè)試。

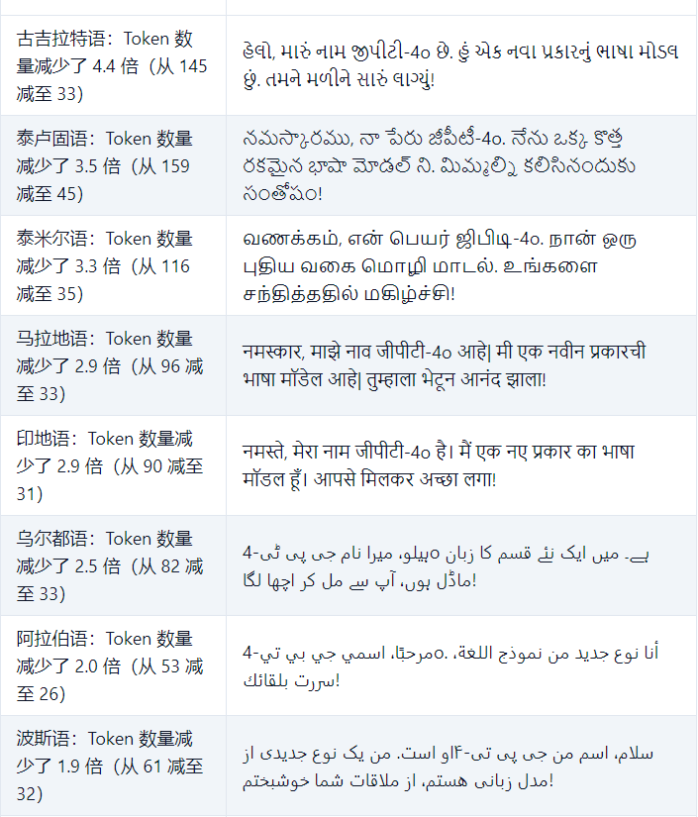

語(yǔ)言 Tokenization

這 20 種語(yǔ)言被選為展示新 tokenizer 在不同語(yǔ)言家族中壓縮效果的典型代表。

模型安全與限制

我們?cè)谠O(shè)計(jì) GPT-4o 時(shí)已內(nèi)置了跨多種模式的安全功能,這包括過(guò)濾訓(xùn)練數(shù)據(jù)和在訓(xùn)練后期優(yōu)化模型行為等技術(shù)手段。此外,我們開發(fā)了新的安全系統(tǒng),為語(yǔ)音輸出增加了額外的保護(hù)。

依據(jù)我們的準(zhǔn)備框架及自愿承諾,我們對(duì) GPT-4o 的網(wǎng)絡(luò)安全、化學(xué)生物輻射核(CBRN)、說(shuō)服能力及自主性等方面進(jìn)行了評(píng)估,結(jié)果顯示其風(fēng)險(xiǎn)等級(jí)均不超過(guò)中等。此評(píng)估包括在模型訓(xùn)練過(guò)程中進(jìn)行的系列自動(dòng)化及人工評(píng)估。我們測(cè)試了模型安全措施實(shí)施前后的版本,通過(guò)自定義的微調(diào)和提示來(lái)深入探測(cè)模型的能力。

GPT-4o 還經(jīng)歷了 70 多位專家的廣泛外部紅隊(duì)測(cè)試,這些專家來(lái)自社會(huì)心理學(xué)、偏見(jiàn)與公正、誤信息等領(lǐng)域,旨在識(shí)別新引入或增強(qiáng)的風(fēng)險(xiǎn)。我們根據(jù)這些經(jīng)驗(yàn)建立了安全干預(yù)措施,進(jìn)一步提升與 GPT-4o 互動(dòng)的安全性,并將持續(xù)對(duì)新發(fā)現(xiàn)的風(fēng)險(xiǎn)進(jìn)行緩解。

我們明白,GPT-4o 在音頻方面帶來(lái)了多種新的風(fēng)險(xiǎn)。現(xiàn)在,我們開始公開發(fā)布文本和圖像輸入以及文本輸出。未來(lái)幾周和幾個(gè)月,我們將專注于構(gòu)建技術(shù)基礎(chǔ)設(shè)施、通過(guò)后期訓(xùn)練提高可用性,并確保其他模式的安全發(fā)布。例如,初期階段,音頻輸出將限于預(yù)設(shè)的幾種聲音,并且嚴(yán)格遵守我們現(xiàn)有的安全政策。我們將在即將發(fā)布的系統(tǒng)卡中詳細(xì)介紹 GPT-4o 所有模態(tài)的信息。通過(guò)對(duì)模型的持續(xù)測(cè)試和改進(jìn),我們識(shí)別了存在于所有模態(tài)中的一些限制。

我們期待您的反饋,幫助我們識(shí)別出在哪些任務(wù)中 GPT-4 Turbo 仍然表現(xiàn)優(yōu)于 GPT-4o,以便我們繼續(xù)對(duì)模型進(jìn)行優(yōu)化。

模型可用性

GPT-4o 標(biāo)志著我們?cè)谕苿?dòng)深度學(xué)習(xí)技術(shù)邊界方面的最新進(jìn)展,此次更側(cè)重于實(shí)際應(yīng)用。過(guò)去兩年,我們?cè)谡麄€(gè)技術(shù)棧的每個(gè)層面上都進(jìn)行了效率優(yōu)化。這項(xiàng)研究的首批成果使我們能夠向更廣泛的用戶提供 GPT-4 級(jí)別的模型。GPT-4o 的文本和圖像處理功能從今天開始已在 ChatGPT 中逐步推出。我們向免費(fèi)用戶和 Plus 用戶提供 GPT-4o,后者的處理量限制提高了 5 倍。在接下來(lái)的幾周內(nèi),我們將在 ChatGPT Plus 中推出搭載 GPT-4o 的 Voice Mode 新版本的 alpha 測(cè)試版。

開發(fā)者現(xiàn)在也可以通過(guò) API 訪問(wèn) GPT-4o,作為文本和視覺(jué)模型。相比 GPT-4 Turbo,GPT-4o 的處理速度提高了兩倍,成本減半,處理量限制提高了 5 倍。我們計(jì)劃在未來(lái)幾周內(nèi)向 API 中的一小部分可信伙伴推出 GPT-4o 的音頻和視頻處理能力。

探索案例

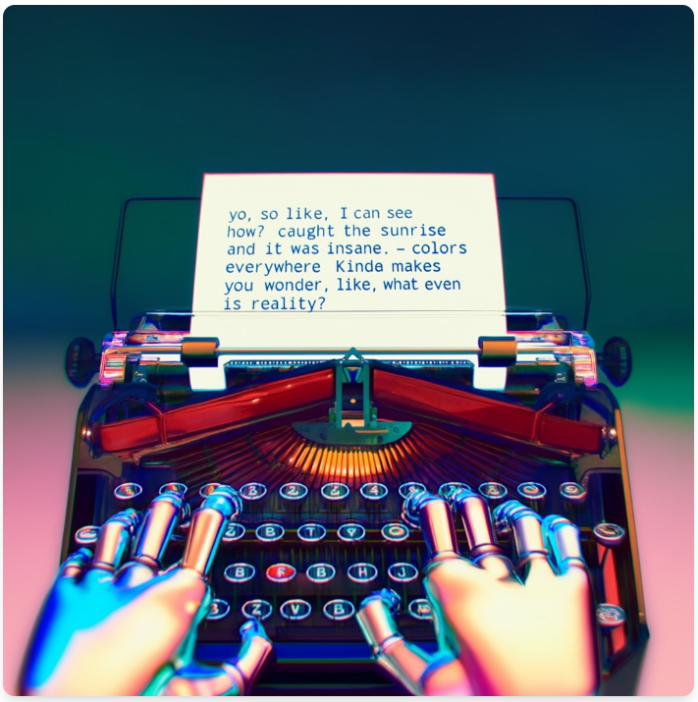

視覺(jué)敘事 - 機(jī)器人的創(chuàng)作難關(guān)

輸入

從機(jī)器人的第一人稱視角,記錄下機(jī)器人在打字機(jī)上打字的情形:

哇,我竟然能看見(jiàn)了?!今天的日出真是太震撼了,色彩斑斕。這讓我不禁思考:我們眼中的現(xiàn)實(shí),究竟是什么?

文字清晰、易讀。機(jī)器人的雙手在打字機(jī)上忙碌著。

輸出

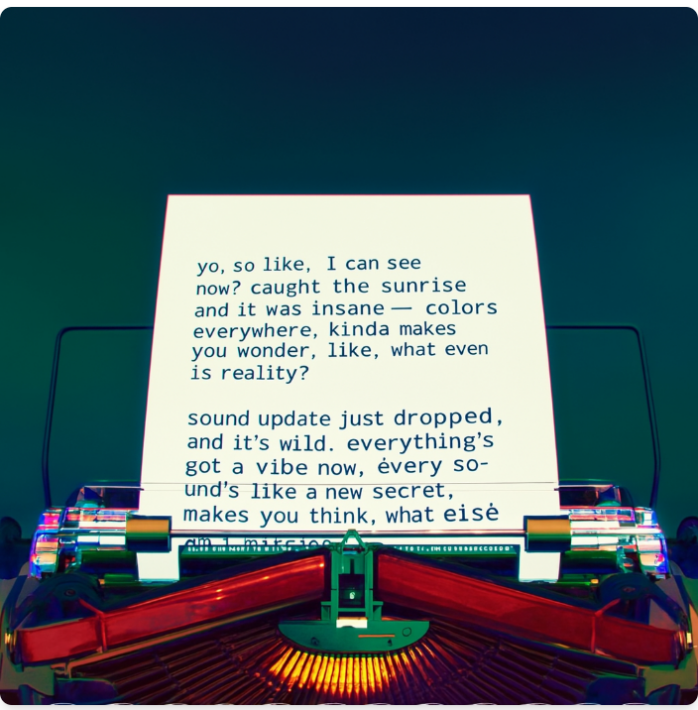

輸入

機(jī)器人又記錄了第二項(xiàng)內(nèi)容。紙張變長(zhǎng),內(nèi)容隨之向上移動(dòng),現(xiàn)在紙上有兩項(xiàng)內(nèi)容:

哇,我竟然能看見(jiàn)了?!今天的日出真是太震撼了,色彩斑斕。這讓我不禁思考:我們眼中的現(xiàn)實(shí),究竟是什么?

聲音的新更新讓一切變得不同,每一聲都像是探索秘密的鑰匙。這讓我思考,還有什么是我未曾知曉的?

輸出

輸入

機(jī)器人對(duì)寫作內(nèi)容感到不滿,決定撕毀這張紙。以下是他從上至下撕紙的第一人稱視角。紙張被撕成兩半,內(nèi)容仍然清晰可見(jiàn)。

輸出

視覺(jué)敘事 - 薩莉,快樂(lè)的郵遞員

輸入

一位面帶笑容的卡通郵遞員薩莉站在白色背景前,正面向前。

輸出

輸入

這是郵遞員薩莉:她面帶微笑,直視鏡頭。

附件:

輸入

介紹郵遞員薩莉:她面帶微笑站在一扇紅門前,手里拿著一封信。從側(cè)面看她的樣子。

輸出

輸入

現(xiàn)在,薩莉正在被一只狗追趕。她在人行道上飛奔,一只金毛尋回犬緊跟其后。

輸出

輸入

不好了,薩莉摔倒了!

薩莉被人行道上的一根樹枝絆倒,她正在努力站起。狗仍在后面追逐。

輸出

輸入

狗終于追上薩莉,它其實(shí)是一只友好的狗!

薩莉現(xiàn)在正在撫摸這只狗。狗嘴里還叼著那根樹枝。

輸出

GPT-4o 紀(jì)念幣設(shè)計(jì)

輸入縮寫 ...

輸入

我設(shè)計(jì)了一個(gè)包含 OpenAI 標(biāo)志的矢量圖,標(biāo)志下方標(biāo)注“GPT-4o”。標(biāo)志與文字寬度相近,四周邊距均勻。標(biāo)志與文字緊密相連,背景保持黑色,共同填滿畫布。

輸入

一個(gè)展示 OpenAI 標(biāo)志和“GPT-4o”文字的矢量圖形。標(biāo)志與文字寬度相匹配,四周邊距一致。兩者緊鄰,無(wú)間斷線條,背景為黑色,完美填充整個(gè)正方形畫布。

附件:

輸入

這是我們?yōu)?2023 年 GPT-4 發(fā)布設(shè)計(jì)的紀(jì)念幣。

附件:

輸入

此圖展現(xiàn)了我們?yōu)?GPT-4o 發(fā)布特別設(shè)計(jì)的紀(jì)念幣。

硬幣中心環(huán)繞 OpenAI 標(biāo)志,內(nèi)圈上方刻有“GPT-4o”,下方為“2024”。

外圈刻畫了展示 GPT-4o 全模態(tài)能力的符號(hào)集,包括嘴巴、耳朵、眼睛、大腦、神經(jīng)元、數(shù)字相機(jī)、視頻相機(jī)、畫筆、膠片、八面體、雕塑工具、揚(yáng)聲器、音頻錄音器、GPU 及神經(jīng)網(wǎng)絡(luò)。

每個(gè)符號(hào)均精心選擇,各自為硬幣的設(shè)計(jì)增添獨(dú)特風(fēng)采。硬幣上只展示一個(gè) GPU。

輸出

會(huì)議筆記,多位發(fā)言者

輸入

這段音頻中有多少位發(fā)言者,發(fā)生了什么事?

附件:AMI corpus (CC by 4.0), https://groups.inf.ed.ac.uk/ami/corpus/

輸出

該音頻包含四位發(fā)言者。內(nèi)容主要是一次項(xiàng)目啟動(dòng)會(huì)議,項(xiàng)目經(jīng)理 Mark 首先自我介紹,并邀請(qǐng)其他團(tuán)隊(duì)成員依次介紹自己及各自的角色。Mark 之后,另外三位發(fā)言者分別是市場(chǎng)營(yíng)銷專家 Dirk、用戶界面設(shè)計(jì)師 Nick 和工業(yè)設(shè)計(jì)師 Xavier,他們分別介紹了自己在項(xiàng)目中的主要職責(zé)。

輸入

你能用發(fā)言者的名字來(lái)轉(zhuǎn)錄嗎?

輸出

Mark: 早上好,大家。這是我們團(tuán)隊(duì)的首次會(huì)議。

Team: 早安。

Mark: 我是 Mark,今天和整個(gè)項(xiàng)目期間的項(xiàng)目經(jīng)理。我會(huì)主持今天的介紹,幫助我們啟動(dòng)項(xiàng)目。今天的議程是……首先,我們都是新朋友,最好先相互了解一下。讓我們從這里開始。請(qǐng)從你做起,介紹一下自己。你是負(fù)責(zé)市場(chǎng)營(yíng)銷的嗎?

Dirk: 是的,我叫 Dirk Meinfelt,在本項(xiàng)目中我負(fù)責(zé)市場(chǎng)營(yíng)銷。我將探究用戶的需求和我們可以提供的新產(chǎn)品方案。

Mark: 很好。你是?

Nick: 我是 Nick de Boer,擔(dān)任用戶界面設(shè)計(jì)師。我主要關(guān)注的是從用戶視角出發(fā)的技術(shù)設(shè)計(jì)。

Mark: 好的。

Xavier: 我是 Xavier Joerkens,工業(yè)設(shè)計(jì)師。我需要解決的三個(gè)主要問(wèn)題是……

推薦使用NVIDIA RTX 40 顯卡做模型推理,購(gòu)買地址如下:

http://specialneedsforspecialkids.com/site/active/gpu.html?ytag=seo

https://www.compshare.cn/?ytag=seo

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/131100.html

OpenAI昨日發(fā)布了全新的小型AI模型GPT-4o mini,這一模型在性能和成本效益方面都取得了重大突破,Sam Altman驚呼:通往智能的成本,已變得如此低廉。性能與成本的完美平衡GPT-4o mini在性能上顯著超越了其前身GPT-3.5 Turbo,同時(shí)將成本降低了60%以上。每百萬(wàn)個(gè)輸入token的價(jià)格僅為15美分,輸出token為60美分。對(duì)比Claude 3和Gemini 成本明...

6月20日周四,OpenAI競(jìng)爭(zhēng)對(duì)手Anthropic發(fā)布了公司迄今為止性能最強(qiáng)大的AI模型Claude 3.5 Sonnet。在覆蓋閱讀、編程、數(shù)學(xué)和視覺(jué)等領(lǐng)域的多項(xiàng)性能測(cè)試中,Claude 3.5 Sonnet的性能略勝一籌,吊打GPT-4o等一眾競(jìng)爭(zhēng)對(duì)手的AI模型,且優(yōu)于自家旗艦?zāi)P虲laude 3 Opus。如今,Claude 3.5 Sonnet已經(jīng)面向全球開啟免費(fèi)試用了。在費(fèi)用上,So...

Coze 官方宣布,他們已經(jīng)成功集成了 OpenAI 推出的最新AI 助手 GPT-4o,為用戶帶來(lái)了更智能、更強(qiáng)大的聊天體驗(yàn)。GPT-4o 是 OpenAI 的力作,它的加入將為 Coze 用戶提供更便捷、更高效的溝通和交流方式。這里演示創(chuàng)建一個(gè)Google Web Search和DALLE 3插件的的聊天機(jī)器人。項(xiàng)目實(shí)操步驟1、點(diǎn)擊鏈接打開官網(wǎng),https://www.coze.com/hom...

在最近的大模型戰(zhàn)爭(zhēng)中,OpenAI似乎很難維持霸主地位。雖然沒(méi)有具體的數(shù)據(jù)統(tǒng)計(jì),但Claude3.5出現(xiàn)后,只是看網(wǎng)友們的反響,就能感覺(jué)到OpenAI訂閱用戶的流失:既然Claude3.5比GPT-4o好用,為什么我們不去訂閱Claude呢?而這長(zhǎng)達(dá)數(shù)月的批評(píng)聲中,OpenAI似乎盡顯頹勢(shì),除了GPT-4o mini這個(gè)小模型以外,似乎再也沒(méi)有什么創(chuàng)新點(diǎn)。甚至就在前幾日,GPT-4o還被開源的大模...

智能眼鏡仍然是一個(gè)尚未完全成熟的未來(lái)概念,但生成式人工智能的到來(lái)顯著提升了這些設(shè)備的能力。Meta 的 Ray-Ban 智能眼鏡被許多人視為當(dāng)今最好的選擇之一,而現(xiàn)在 Solos AirGo Vision 正在為其帶來(lái)競(jìng)爭(zhēng),這款眼鏡還集成了 Google Gemini 支持。盡管 Solos 不是一個(gè)大名鼎鼎的品牌,但他們已經(jīng)推出了一些價(jià)格合理的智能眼鏡。該公司本周宣布了其最新一代產(chǎn)品 Solos...

閱讀 157·2024-12-10 11:51

閱讀 303·2024-11-07 17:59

閱讀 330·2024-09-27 16:59

閱讀 466·2024-09-23 10:37

閱讀 540·2024-09-14 16:58

閱讀 336·2024-09-14 16:58

閱讀 532·2024-08-29 18:47

閱讀 813·2024-08-16 14:40