資訊專欄INFORMATION COLUMN

本文關(guān)鍵闡述了在pytorch中獲得計(jì)算圖和自行求導(dǎo)數(shù),文章內(nèi)容緊扣主題進(jìn)行詳盡的基本介紹,具有很強(qiáng)的實(shí)用價(jià)值,需用的同學(xué)可以參考下

序言:

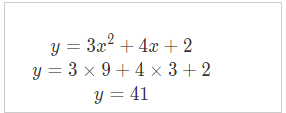

今日聊聊pytorch的計(jì)算圖和自行求導(dǎo)數(shù),我們首先從簡(jiǎn)易事例來說,下邊是個(gè)簡(jiǎn)單函數(shù)設(shè)立了yy和xx相互關(guān)系

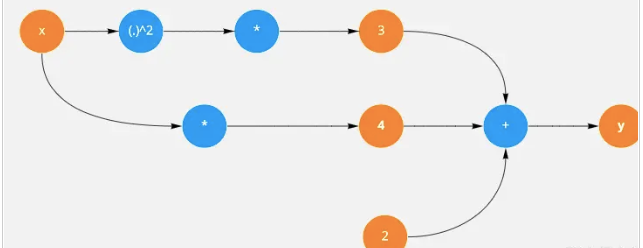

然后我們結(jié)點(diǎn)和邊形式表示上面公式:

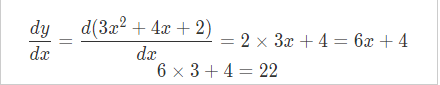

上面的式子可以用圖的形式表達(dá),接下來我們用torch來計(jì)算x導(dǎo)數(shù),首先我們創(chuàng)建一個(gè)tensor并且將其requires_grad設(shè)置為True表示隨后反向傳播會(huì)對(duì)其進(jìn)行求導(dǎo)。

x=torch.tensor(3.,requires_grad=True)

然后寫出

y=3*x**2+4*x+2

y.backward() x.grad

通過調(diào)用y.backward()來進(jìn)行求導(dǎo),這時(shí)就可以通過x.grad來獲得x的導(dǎo)數(shù)

x.requires_grad_(False)

可以通過requires_grad_讓x不參與到自動(dòng)求導(dǎo)

for epoch in range(3): y=3*x**2+4*x+2 y.backward() print(x.grad) x.grad.zero_()

如果這里沒有調(diào)用x.grad_zero_()就是把每次求導(dǎo)數(shù)和上一次求導(dǎo)結(jié)果進(jìn)行累加。

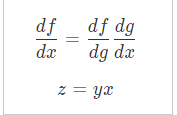

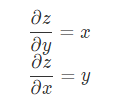

鏈?zhǔn)椒▌t

相對(duì)于z對(duì)x求偏導(dǎo)時(shí),我們可以將y看成常數(shù),這樣x導(dǎo)數(shù)是1那么

x=torch.tensor([1.,2.,3.],requires_grad=True) y=x*2+3 z=y**2 print(out)#tensor(51.6667,grad_fn=<MeanBackward0>) print(x.grad)#tensor([6.6667,9.3333,12.0000])

對(duì)于一個(gè)簡(jiǎn)單的網(wǎng)絡(luò),我們可以手動(dòng)計(jì)算梯度,但是如果擺在你面前的是一個(gè)有152層的網(wǎng)絡(luò)怎么辦?或者該網(wǎng)絡(luò)有多個(gè)分支。這時(shí)你的計(jì)算復(fù)雜程度可想而知。接下來會(huì)帶來更深入自動(dòng)求導(dǎo)內(nèi)部機(jī)制

綜上所述,這篇文章就給大家介紹到這里了,希望可以給大家?guī)韼椭?/p>

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/128846.html

摘要:圖神經(jīng)網(wǎng)絡(luò)是近年發(fā)展起來的一個(gè)很有前景的深度學(xué)習(xí)方向,也是一種強(qiáng)大的圖點(diǎn)云和流形表示學(xué)習(xí)方法。地址基于的幾何深度學(xué)習(xí)擴(kuò)展庫是一個(gè)基于的幾何深度學(xué)習(xí)擴(kuò)展庫,用于不規(guī)則結(jié)構(gòu)輸入數(shù)據(jù),例如圖點(diǎn)云和流形。與相比,訓(xùn)練模型的速度快了倍。 過去十年來,深度學(xué)習(xí)方法(例如卷積神經(jīng)網(wǎng)絡(luò)和遞歸神經(jīng)網(wǎng)絡(luò))在許多領(lǐng)域取得了前所未有的成就,例如計(jì)算機(jī)視覺和語音識(shí)別。研究者主要將深度學(xué)習(xí)方法應(yīng)用于歐氏結(jié)構(gòu)數(shù)據(jù) (Eu...

TensorFlow和PyTorch是兩個(gè)最流行的深度學(xué)習(xí)框架之一。雖然這兩個(gè)框架都可以完成大多數(shù)深度學(xué)習(xí)任務(wù),但它們之間仍有很多區(qū)別。本文將探討TensorFlow和PyTorch之間的一些區(qū)別。 1. 靜態(tài)圖和動(dòng)態(tài)圖 TensorFlow使用靜態(tài)圖,它需要先定義計(jì)算圖,然后再執(zhí)行計(jì)算。這使得TensorFlow在執(zhí)行大規(guī)模計(jì)算時(shí)非常高效。PyTorch使用動(dòng)態(tài)圖,它允許用戶在執(zhí)行計(jì)算時(shí)動(dòng)態(tài)...

摘要:梯度下降算法梯度是個(gè)啥我想最開始接觸梯度的各位是在方向?qū)?shù)那一章接觸這一概念的,如果老師沒怎么講的話可能有些人還不知道梯度是個(gè)向量。在二維條件下,因?yàn)橛辛藘蓚€(gè)偏導(dǎo)數(shù),所以這個(gè)向量能表示一圈。 講你肯定能懂的機(jī)器學(xué)習(xí)多維極值求解事先說明本文面向?qū)W習(xí)過高等數(shù)學(xué)統(tǒng)計(jì)學(xué)和線性代數(shù)基礎(chǔ)知識(shí)的本科生,并假設(shè)讀者擁有基本的矩陣運(yùn)算和求導(dǎo)運(yùn)算的相關(guān)知識(shí),類似梯度,方向?qū)?shù)、Hessian Matrix這些東...

摘要:亞馬遜和華盛頓大學(xué)今天合作發(fā)布了開源的端到端深度學(xué)習(xí)編譯器。項(xiàng)目作者之一陳天奇在微博上這樣介紹這個(gè)編譯器我們今天發(fā)布了基于工具鏈的深度學(xué)習(xí)編譯器。陳天奇團(tuán)隊(duì)對(duì)的性能進(jìn)行了基準(zhǔn)測(cè)試,并與進(jìn)行了比較。 亞馬遜和華盛頓大學(xué)今天合作發(fā)布了開源的端到端深度學(xué)習(xí)編譯器NNVM compiler。先提醒一句,NNVM compiler ≠ NNVM。NNVM是華盛頓大學(xué)博士陳天奇等人2016年發(fā)布的模塊化...

摘要:截止到今天,已公開發(fā)行一周年。一年以來,社區(qū)中的用戶不斷做出貢獻(xiàn)和優(yōu)化,在此深表感謝。所以與衡量它的指標(biāo)包括在機(jī)器學(xué)習(xí)研究論文中的使用。來自香港科技大學(xué)的在上推出了面向普通觀眾的在線課程。 Yann LeCun Twitter截止到今天,PyTorch 已公開發(fā)行一周年。一年以來,我們致力于打造一個(gè)靈活的深度學(xué)習(xí)研究平臺(tái)。一年以來,PyTorch 社區(qū)中的用戶不斷做出貢獻(xiàn)和優(yōu)化,在此深表感謝...

閱讀 911·2023-01-14 11:38

閱讀 878·2023-01-14 11:04

閱讀 740·2023-01-14 10:48

閱讀 1982·2023-01-14 10:34

閱讀 942·2023-01-14 10:24

閱讀 819·2023-01-14 10:18

閱讀 499·2023-01-14 10:09

閱讀 572·2023-01-14 10:02