資訊專欄INFORMATION COLUMN

Python在工作中的應用還是比較的廣泛的,市場上面對于這類人才開出的薪資還是比較的高的。那么,如何使用第三方庫jieba庫與中文分詞進行一個分解呢?下面小編就給大家詳細的做出一個解答。

一、什么是jieba庫

jieba是優秀的中文分詞第三方庫,由于中文文本之間每個漢字都是連續書寫的,我們需要通過特定的手段來獲得其中的每個詞組,這種手段叫做分詞,我們可以通過jieba庫來完成這個過程。

二、jieba分詞原理

jieba庫的分詞原理是利用了一個中文詞庫,將待分詞的內容與分詞詞庫對比,通過圖結構和動態規則劃分方法找到最大概率的詞組。除了分詞,jieba還提供增加自定義中文單詞的功能。

三、jieba庫支持的三種分詞模式

1.精確模式

將句子最精確地分開,適合文本分析;

2.全模式

把句子中所有可以成詞的詞語都掃描出來,速度非常快,但是不能解決歧義;

3.搜索引擎模式

在精確模式的基礎上,對長詞再次切分,提高召回率,適合用于搜索引擎分詞

注:對中文分詞來說,jieba庫只需要一行代碼即可。英文文本不存在分詞問題

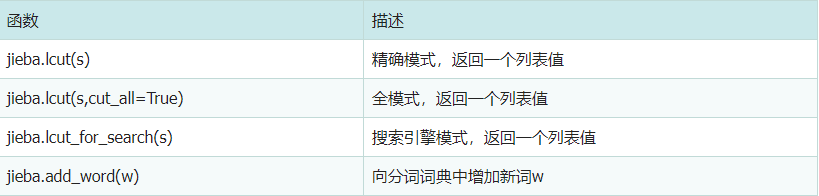

四、jieba庫常用函數

五、jieba實操

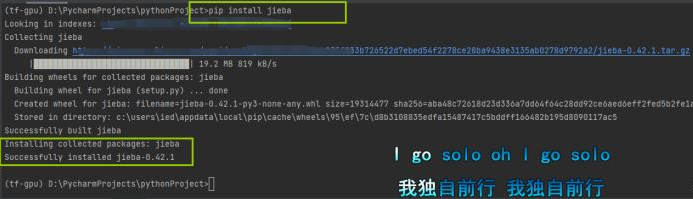

首先你需要安裝jieba庫

pip install jieba

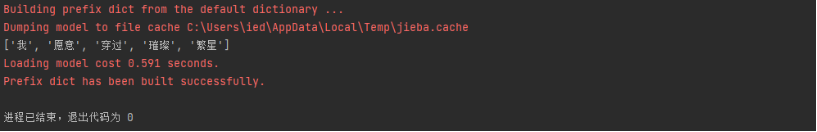

練習一(jieba.lcut)精確模式

jieba.lcut(s)是最常用的中文分詞函數,用于精確模式,將字符串分割成等量的中文詞組。

import jieba

ls=jieba.lcut("我愿意穿過璀璨繁星")

print(ls)

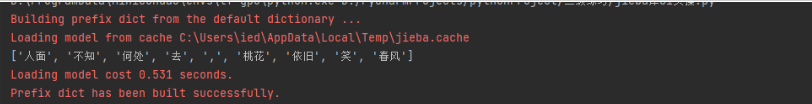

練習二(jieba.lcut(s,cut_all=True))全模式

jieba.lcut(s,cut_all=True)用于全模式,將字符串的所有分詞可能列出來,冗余最大。

import jieba

ls=jieba.lcut("人面不知何處去,桃花依舊笑春風",cut_all=True)

print(ls)

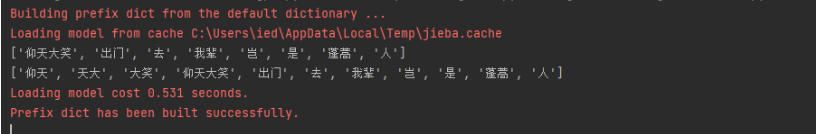

練習三(jieba.lcut_for_search)搜索引擎模式

jieba.lcut_for_search該模式首先執行精確模式,然后在對其中長詞進一步分獲得最終結果

import jieba

ls1=jieba.lcut("仰天大笑出門去我輩豈是蓬蒿人")

ls=jieba.lcut_for_search("仰天大笑出門去我輩豈是蓬蒿人")

print(ls1)

print(ls)

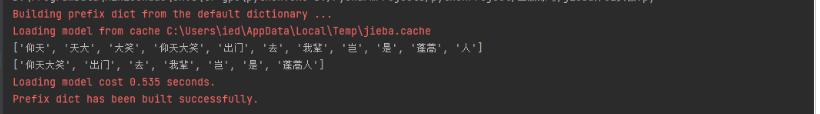

練習四(jieba.add_word(w))增加新詞

import jieba

ls=jieba.lcut_for_search("仰天大笑出門去我輩豈是蓬蒿人")

print(ls)

jieba.add_word("蓬蒿人")

ls1=jieba.lcut("仰天大笑出門去我輩豈是蓬蒿人")

print(ls1)

小結:精確模式因為不產生冗余,最為常用。

到此為止,這篇文章就給大家介紹到這里了,希望可以給大家帶來更多的幫助。

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/128245.html

摘要:據小編簡單了解,已知對工作報告高頻詞匯進行梳理的媒體包括法制日報和新華網。高頻詞詞頻年以來政府工作報告中的提及總數發展經濟改革建設社會推進創新政策企業加強下面是新華網數據新聞部統計的高頻詞匯。 本文首發于微信公眾號號編程派。微信搜索編程派,獲取更多Python編程一手教程及優質資源吧。 上周六,總理在大會堂作政府工作報告,全球媒體矚目。每年都會有媒體對報告中的高頻詞匯進行梳理,我們也可...

摘要:先看效果環境位目標抓取一篇報紙,并提取出關鍵字,然后按照出現次數排序,用在頁面上顯示出來。首先要抓取網頁,但是網頁在控制臺輸出的時候,中文總是亂碼。但是不得不承認,上有很多非常優秀的庫。例如但是這些包我在上安裝的時候總是報錯。 先看效果: showImg(https://segmentfault.com/img/bVRLCc?w=612&h=668); 環境 win7 64位 pyt...

摘要:分詞的算法中文分詞有難度,不過也有成熟的解決方案。例如通過人民日報訓練的分詞系統,在網絡玄幻小說上,分詞的效果就不會好。三的優點是開源的,號稱是中,最好的中文分詞組件。 showImg(https://segmentfault.com/img/remote/1460000016359704?w=1350&h=900); 題圖:by Lucas Davies 一、前言 分詞,我想是大多數...

摘要:前言今天教大家用模塊來生成詞云,我讀取了一篇小說并生成了詞云,先看一下效果圖效果圖一效果圖二根據效果圖分析的還是比較準確的,小說中的主人公就是程理,所以出現次數最多。 前言 今天教大家用wrodcloud模塊來生成詞云,我讀取了一篇小說并生成了詞云,先看一下效果圖: 效果圖一: showImg(https://segmentfault.com/img/remote/1460000015...

閱讀 917·2023-01-14 11:38

閱讀 888·2023-01-14 11:04

閱讀 747·2023-01-14 10:48

閱讀 2025·2023-01-14 10:34

閱讀 954·2023-01-14 10:24

閱讀 829·2023-01-14 10:18

閱讀 504·2023-01-14 10:09

閱讀 581·2023-01-14 10:02