資訊專(zhuān)欄INFORMATION COLUMN

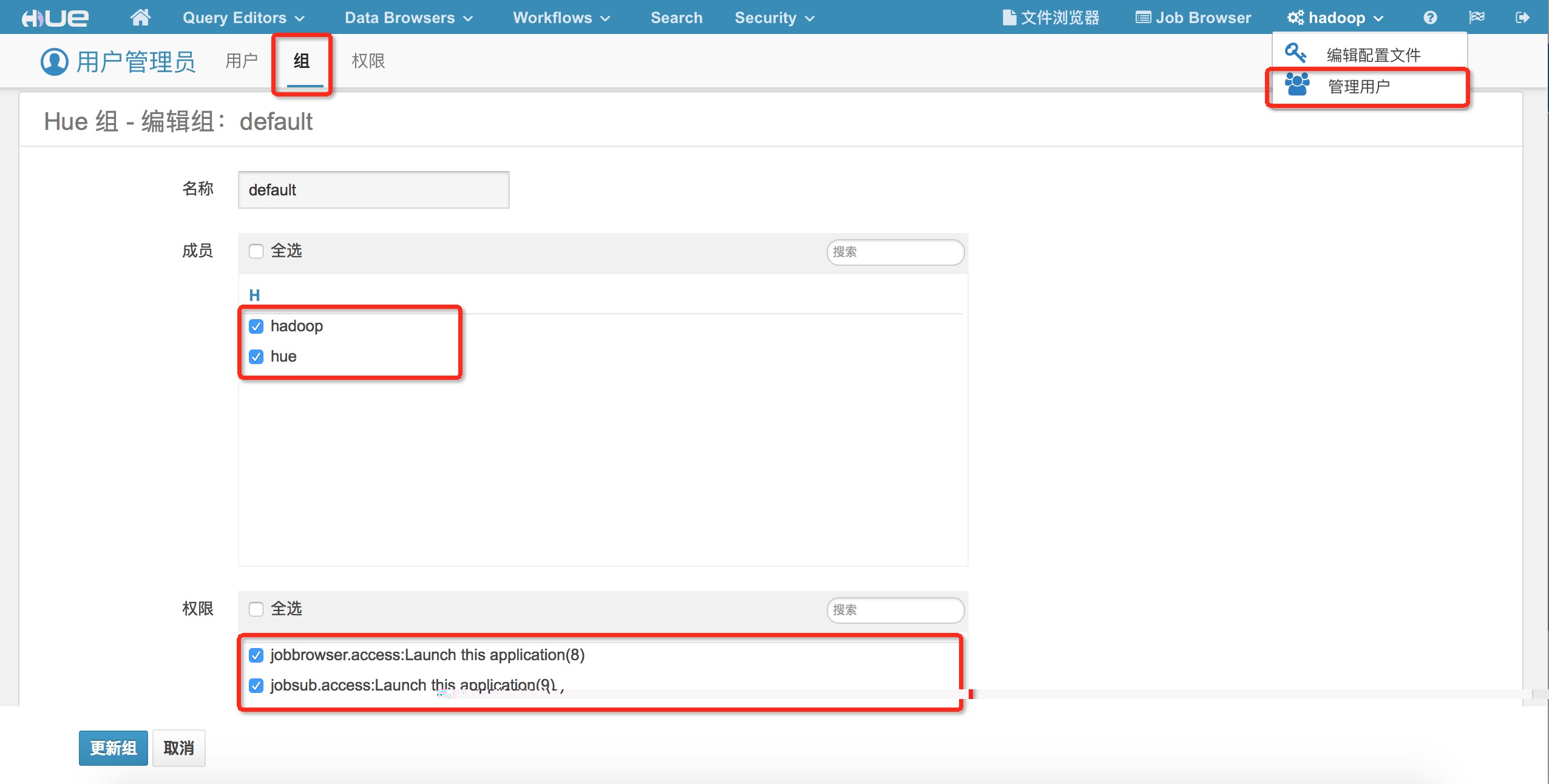

摘要:創(chuàng)建任務(wù)創(chuàng)建任務(wù)選擇這個(gè)標(biāo)簽拖動(dòng)到中。頁(yè)面權(quán)限控制頁(yè)面權(quán)限控制頁(yè)面權(quán)限控制點(diǎn)擊管理用戶組選擇要修改的組名稱,設(shè)置相應(yīng)權(quán)限并保存

Hue是面向 Hadoop 的開(kāi)源用戶界面,可以讓您更輕松地運(yùn)行和開(kāi)發(fā) Hive 查詢、管理 HDFS 中的文件、運(yùn)行和開(kāi)發(fā) Pig 腳本以及管理表。服務(wù)默認(rèn)已經(jīng)啟動(dòng),用戶只需要配置外網(wǎng)IP,在防火墻中配置開(kāi)放端口就可以了。如果沒(méi)有安裝hue,可以在集群的"服務(wù)管理"頁(yè)面開(kāi)啟Hue。

訪問(wèn)地址: http://外網(wǎng)ip:8888

默認(rèn)用戶名/密碼:hadoop/hadoop或者h(yuǎn)ue/hue, 用戶登陸后可以自行更改。

啟用Hue的工作流功能,需要在集群上安裝。可以在集群的"服務(wù)管理"頁(yè)面啟用Oozie。

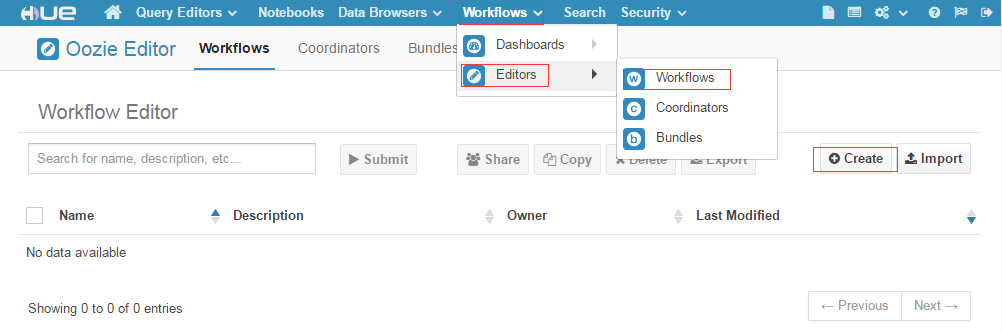

1.1 創(chuàng)建新的工作流在瀏覽器中依次點(diǎn)擊【W(wǎng)orkflows】->【Editors】->【W(wǎng)okflows】,進(jìn)入Workflow Editor。然后點(diǎn)擊頁(yè)面右側(cè)的【Create】按鈕。

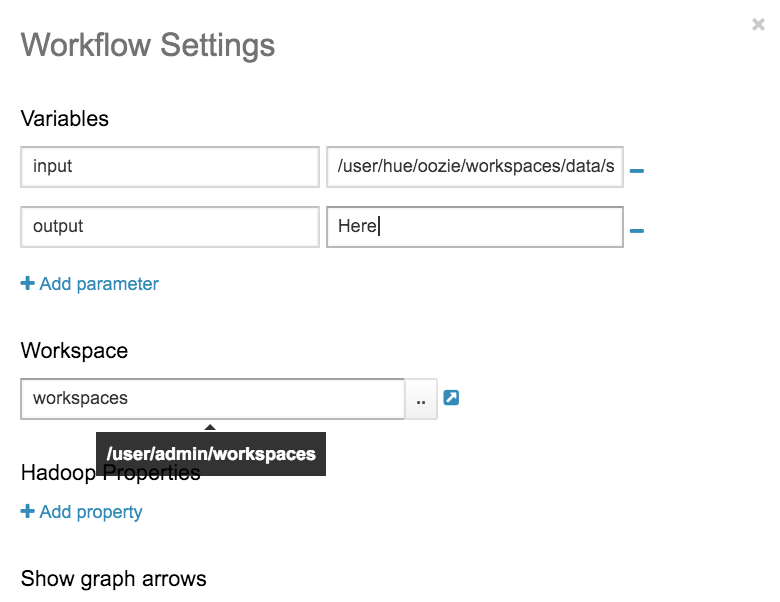

從action中拖動(dòng)spark的標(biāo)簽到工作流中。點(diǎn)擊右上角的【Settings】按鈕,出現(xiàn)一個(gè)彈出窗口,我們可以在這里為Workflow設(shè)置變量名,并設(shè)置Workspace。

現(xiàn)在,添加input和output這兩個(gè)變量,并將Workspace設(shè)置為HDFS的目錄/user/admin/workspaces,如下:

設(shè)置好后,點(diǎn)擊右上角的叉關(guān)閉這個(gè)彈出窗口,回到之前的頁(yè)面(現(xiàn)在還需要自己將Spark Job所需的Jar包放入相應(yīng)的HDFS目錄中)。

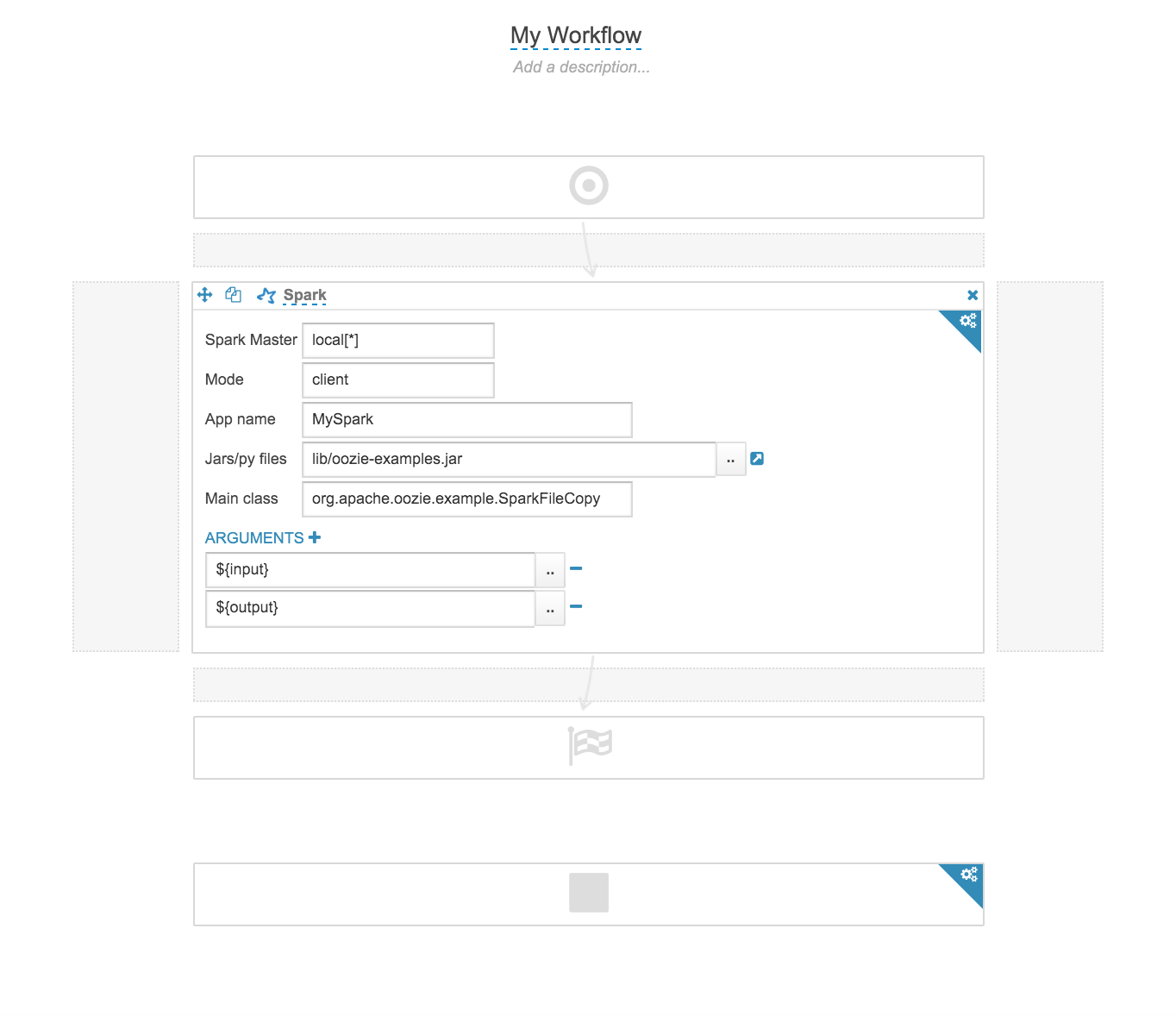

我們將【Spark】圖標(biāo)拖到相應(yīng)的位置,然后繼續(xù)進(jìn)行設(shè)置。我們?cè)O(shè)置了Jar包的路徑 lib/oozie-examples.jar。還要設(shè)置main class。

注意這是HDFS路徑,且是相對(duì)于Workspace的路徑(所以實(shí)際路徑就是/user/admin/workspaces/lib/oozie-examples.jar)

由于這個(gè)main class的作用的是復(fù)制HDFS的文件,它在運(yùn)行時(shí)需要給main方法傳入兩個(gè)參數(shù),分別是src path和dest path,所以這里我們繼續(xù)添加參數(shù),如下圖:

這里的${input}和${output}就是之前我們?cè)凇緎ettings】中設(shè)置的變量名。

好了,一切都設(shè)置好了之后,點(diǎn)擊右上角的【Save】按鈕。

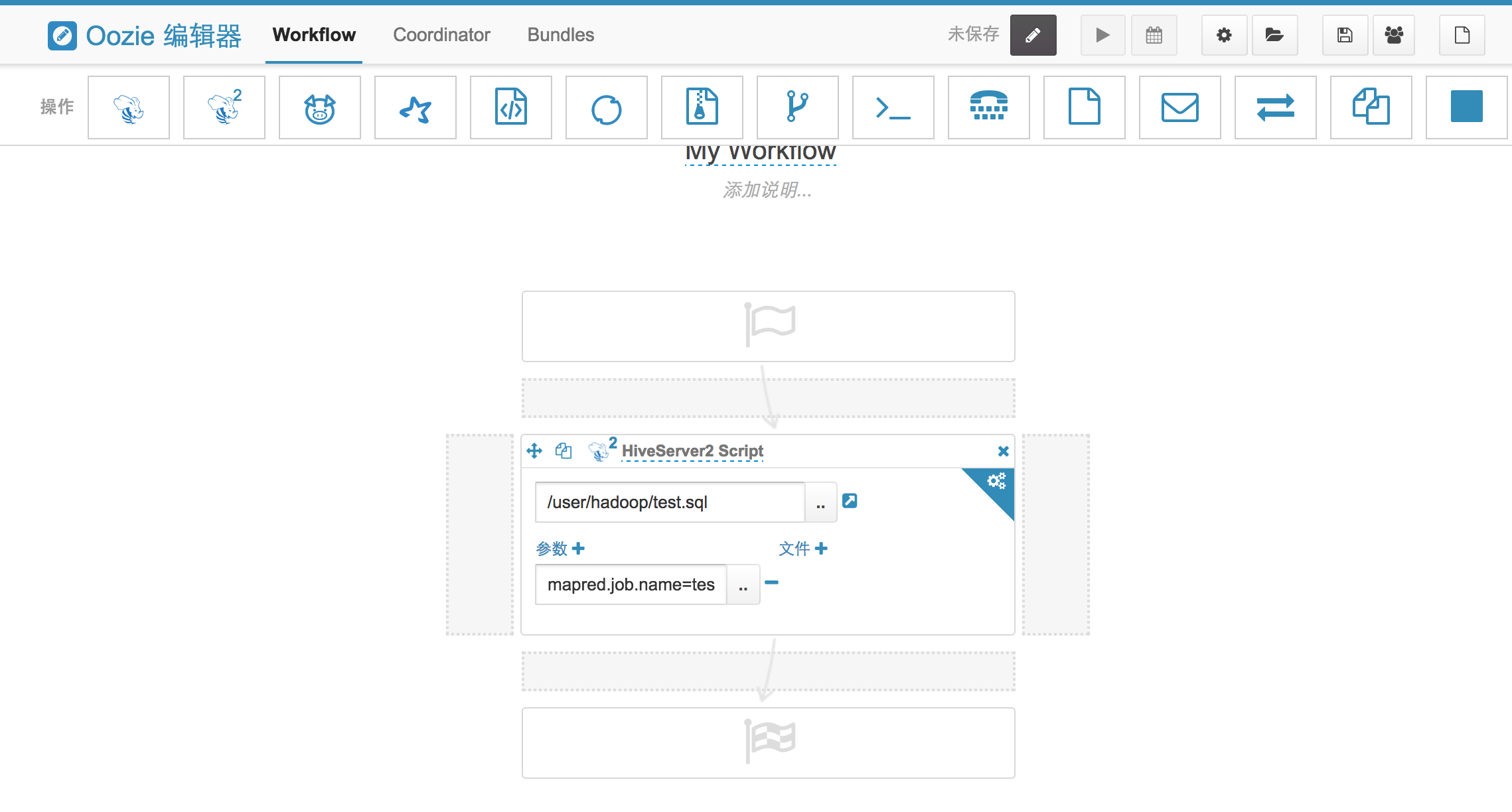

1.3 創(chuàng)建Hive任務(wù)uhadoop上使用的是hive-server2,所以這里選擇hive-server2標(biāo)簽拖動(dòng)到action中。

然后,將準(zhǔn)備好的sql腳本上傳到hdfs上,并配置提交任務(wù)的參數(shù)

如果定義了ufd可以通過(guò)文件的參數(shù)來(lái)指定

最后,保存工作流。

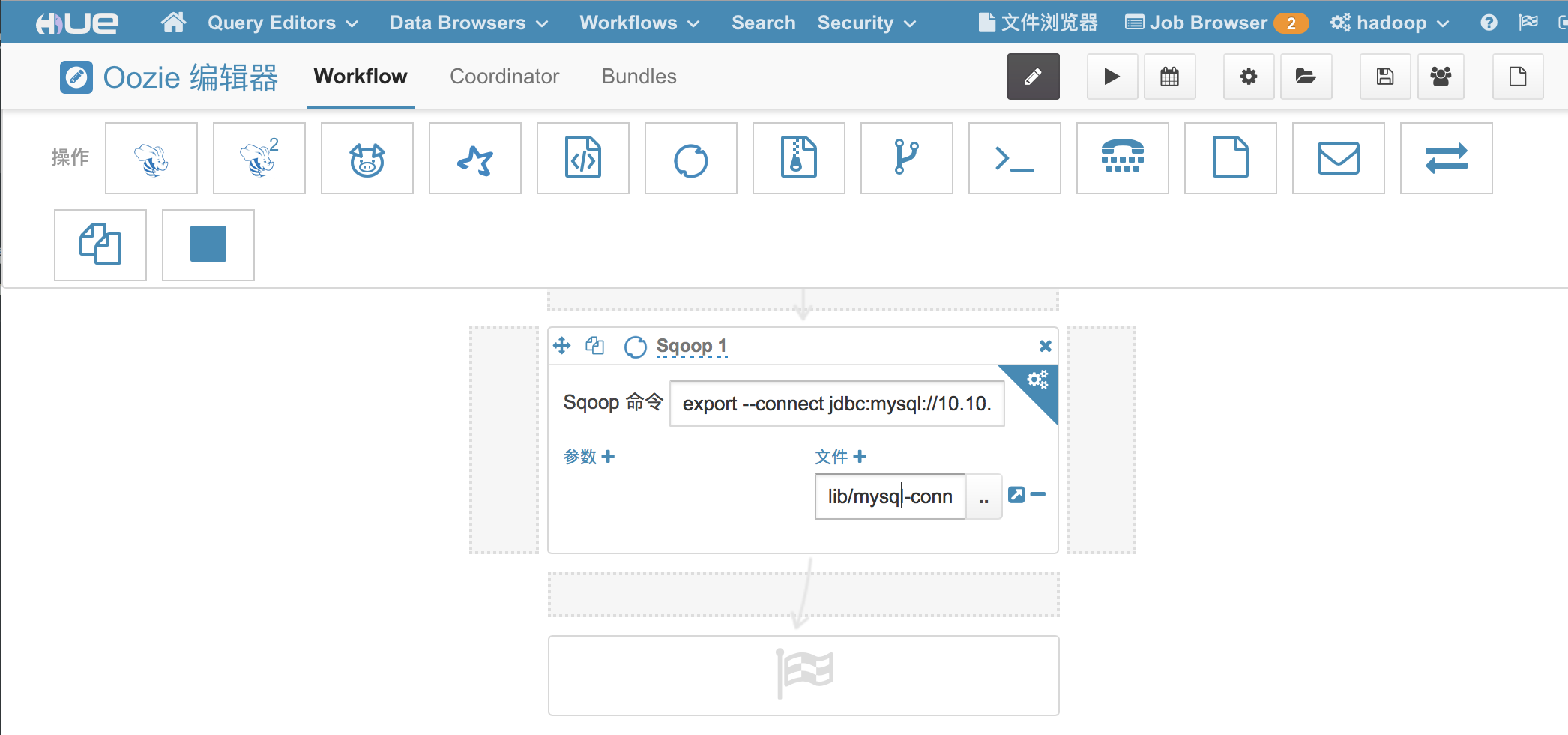

選擇sqoop1這個(gè)標(biāo)簽拖動(dòng)到action中。然后,添加需要執(zhí)行的Sqoop命令。

注意:

1.密碼不能加額外的引號(hào),hue會(huì)把-p 參數(shù)后面的所有內(nèi)容都解釋為密碼;

2.Sqoop 要把任務(wù)分發(fā)到所有的集群節(jié)點(diǎn),要保證集群所有節(jié)點(diǎn)對(duì)目標(biāo)數(shù)據(jù)庫(kù)的讀寫(xiě)權(quán)限。

最后,保存工作流。

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/126757.html

摘要:也可以將托管集群設(shè)置為快捷方式,通過(guò)左側(cè)快捷方式菜單欄點(diǎn)擊進(jìn)入。框架集群中僅部署。用于做存儲(chǔ)集群,有專(zhuān)屬的節(jié)點(diǎn)機(jī)型。節(jié)點(diǎn)管理節(jié)點(diǎn),負(fù)責(zé)協(xié)調(diào)整個(gè)集群服務(wù)。目前僅節(jié)點(diǎn)支持綁定。通過(guò)云主機(jī)內(nèi)網(wǎng)進(jìn)行登錄。登錄密碼為集群創(chuàng)建時(shí)設(shè)置的密碼。 快速上手本篇目錄創(chuàng)建集群提交任務(wù)本文檔將帶領(lǐng)您如何創(chuàng)建UHadoop集群,并使用UHadoop集群完成數(shù)據(jù)處理任務(wù)。創(chuàng)建集群本章簡(jiǎn)單介紹了用戶使用UHadoop服務(wù)...

摘要:集群運(yùn)行慢時(shí),通常會(huì)在日志中可以查找到明顯的異常,或者花費(fèi)時(shí)間長(zhǎng)的操作。檢查集群節(jié)點(diǎn)的運(yùn)行狀態(tài)檢查集群節(jié)點(diǎn)的運(yùn)行狀態(tài)管理群集上部署的各種服務(wù)。如果主節(jié)點(diǎn)遇到性能問(wèn)題,整個(gè)群集都會(huì)受到影響。工作的不均衡分配可能會(huì)導(dǎo)致處理速度較慢。 故障排查本篇目錄任務(wù)執(zhí)行失敗排查工具故障描述集群運(yùn)行速度慢任務(wù)執(zhí)行失敗1.查看console輸出日志查看任務(wù)執(zhí)行時(shí)控制臺(tái)輸出的log,檢查是否有ERROR2.查看任...

摘要:開(kāi)發(fā)指南開(kāi)發(fā)指南開(kāi)發(fā)指南本篇目錄運(yùn)行運(yùn)行定義定義定義工作流,為將多個(gè)按照一定的順序組織起來(lái),按照既定的路徑運(yùn)行的一個(gè)整體。配置將定時(shí)調(diào)度頻率改為分鐘。一個(gè)會(huì)創(chuàng)建并執(zhí)行。例如,,,,則時(shí)間為動(dòng)作的實(shí)際創(chuàng)建時(shí)間。 Oozie開(kāi)發(fā)指南本篇目錄1. 運(yùn)行Coordinator Job2. Coordinator Action3. Coordinator Application4. Coordinat...

摘要:架構(gòu)架構(gòu)元數(shù)據(jù)管理元數(shù)據(jù)管理元數(shù)據(jù)管理創(chuàng)建集群時(shí)可在控制臺(tái)開(kāi)啟元數(shù)據(jù)獨(dú)立管理。若項(xiàng)目中已開(kāi)啟過(guò)元數(shù)據(jù)獨(dú)立管理,則新集群開(kāi)啟該功能時(shí),不再創(chuàng)建新的,而是將新集群的元數(shù)據(jù)存儲(chǔ)于已有的中。 元數(shù)據(jù)管理本篇目錄介紹產(chǎn)品架構(gòu)元數(shù)據(jù)管理介紹UHadoop 支持將 Hive-Metastore 的數(shù)據(jù)庫(kù)獨(dú)立于 Hadoop 集群部署,也支持多個(gè)集群訪問(wèn)同一個(gè) Hive 元數(shù)據(jù)庫(kù),可在控制臺(tái)對(duì)其做管理。產(chǎn)品...

摘要:查看上的歷史日志查看上的歷史日志任務(wù)的日志在任務(wù)運(yùn)行結(jié)束之后會(huì)上傳到上,當(dāng)日志文件過(guò)大無(wú)法通過(guò)來(lái)查看時(shí),可以通過(guò)將日志文件從上下載下來(lái)查看。掛載在允許的主機(jī)上執(zhí)行 常用操作本篇目錄應(yīng)用的Web接口查看日志配置NFS掛載hdfs到本地應(yīng)用的Web接口Hadoop 提供了基于 Web 的用戶界面,可通過(guò)它查看您的 Hadoop 集群。Web 服務(wù)會(huì)在主節(jié)點(diǎn)上運(yùn)行(Active NameNode或...

閱讀 284·2024-11-07 18:25

閱讀 130363·2024-02-01 10:43

閱讀 868·2024-01-31 14:58

閱讀 828·2024-01-31 14:54

閱讀 82766·2024-01-29 17:11

閱讀 3047·2024-01-25 14:55

閱讀 1985·2023-06-02 13:36

閱讀 3032·2023-05-23 10:26