資訊專欄INFORMATION COLUMN

摘要:相比于,它將也作為隱變量納入到變分推斷中。結論綜述本文的結果表明了變分推斷確實是一個推導和解釋生成模型的統一框架,包括和。

作者丨蘇劍林

單位丨廣州火焰信息科技有限公司

研究方向丨NLP,神經網絡

個人主頁丨kexue.fm

前言

我小學開始就喜歡純數學,后來也喜歡上物理,還學習過一段時間的理論物理,直到本科畢業時,我才慢慢進入機器學習領域。所以,哪怕在機器學習領域中,我的研究習慣還保留著數學和物理的風格:企圖從最少的原理出發,理解、推導盡可能多的東西。這篇文章是我這個理念的結果之一,試圖以變分推斷作為出發點,來統一地理解深度學習中的各種模型,尤其是各種讓人眼花繚亂的 GAN。

本文已經掛到 arXiv 上,需要讀英文原稿的可以訪問下方鏈接下載論文 Variational Inference: A Unified Framework of Generative Models and Some Revelations。?

■ 論文 | Variational Inference: A Unified Framework of Generative Models and Some Revelations

■ 鏈接 | https://www.paperweekly.site/papers/2117

■ 作者 | Jianlin Su

下面是文章的介紹。其實,中文版的信息可能還比英文版要稍微豐富一些,原諒我這蹩腳的英語。

近年來,深度生成模型,尤其是 GAN,取得了巨大的成功。現在我們已經可以找到數十個乃至上百個 GAN 的變種。然而,其中的大部分都是憑著經驗改進的,鮮有比較完備的理論指導。

本文的目標是通過變分推斷來給這些生成模型建立一個統一的框架。首先,本文先介紹了變分推斷的一個新形式,這個新形式其實在本人以前的文章中就已經介紹過,它可以讓我們在幾行字之內導出變分自編碼器(VAE)和 EM 算法。然后,利用這個新形式,我們能直接導出 GAN,并且發現標準 GAN 的 loss 實則是不完備的,缺少了一個正則項。如果沒有這個正則項,我們就需要謹慎地調整超參數,才能使得模型收斂。

實際上,本文這個工作的初衷,就是要將 GAN 納入到變分推斷的框架下。目前看來,最初的意圖已經達到了,結果讓人欣慰。新導出的正則項實際上是一個副產品,并且幸運的是,在我們的實驗中這個副產品生效了。

變分推斷新解

假設 x 為顯變量,z 為隱變量,p?(x) 為 x 的證據分布,并且有:

但是由于積分可能難以計算,因此大多數情況下都難以直接優化。?

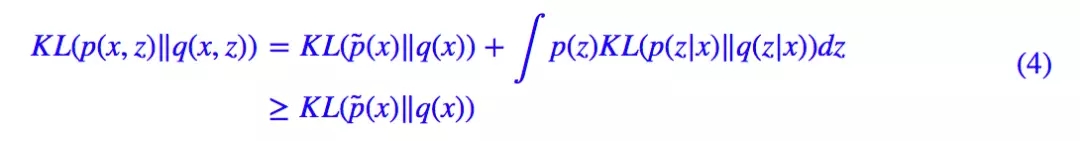

變分推斷中,首先引入聯合分布 p(x,z) 使得p?(x)=∫p(x,z)dz,而變分推斷的本質,就是將邊際分布的 KL 散度 KL(p?(x)‖q(x)) 改為聯合分布的 KL 散度 KL(p(x,z)‖q(x,z)) 或 KL(q(x,z)‖p(x,z)),而:

意味著聯合分布的 KL 散度是一個更強的條件(上界)。所以一旦優化成功,那么我們就得到 q(x,z)→p(x,z),從而 ∫q(x,z)dz→∫p(x,z)dz=p? (x),即 ∫q(x,z)dz 成為了真實分布 p?(x) 的一個近似。

當然,我們本身不是為了加強條件而加強,而是因為在很多情況下,KL(p(x,z)‖q(x,z)) 或 KL(q(x,z)‖p(x,z)) 往往比 KL(p?(x)‖q(x)) 更加容易計算。所以變分推斷是提供了一個可計算的方案。

VAE和EM算法

由上述關于變分推斷的新理解,我們可以在幾句話內導出兩個基本結果:變分自編碼器和 EM 算法。這部分內容,實際上在從較大似然到EM算法:一致的理解方式和變分自編碼器(二):從貝葉斯觀點出發已經詳細介紹過了。這里用簡單幾句話重提一下。

VAE

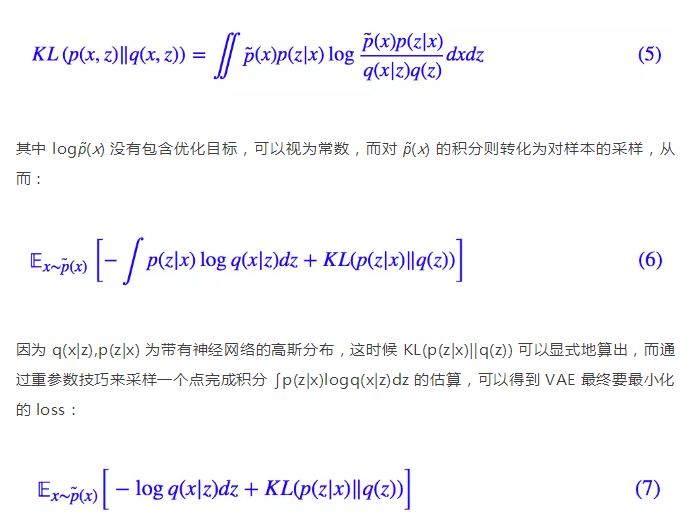

在 VAE 中,我們設 q(x,z)=q(x|z)q(z),p(x,z)=p?(x)p(z|x),其中 q(x|z),p(z|x) 帶有未知參數的高斯分布而 q(z) 是標準高斯分布。最小化的目標是:

EM算法

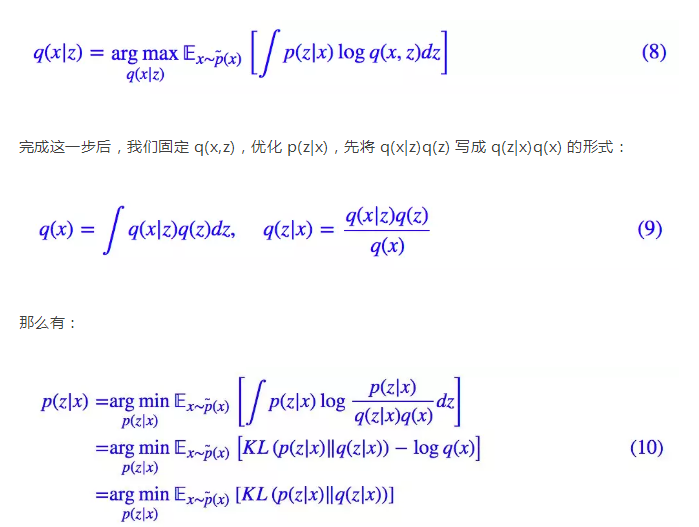

在 VAE 中我們對后驗分布做了約束,僅假設它是高斯分布,所以我們優化的是高斯分布的參數。如果不作此假設,那么直接優化原始目標 (5),在某些情況下也是可操作的,但這時候只能采用交替優化的方式:先固定 p(z|x),優化 q(x|z),那么就有:

由于現在對 p(z|x) 沒有約束,因此可以直接讓 p(z|x)=q(z|x) 使得 loss 等于 0。也就是說,p(z|x) 有理論最優解:

(8),(11) 的交替執行,構成了 EM 算法的求解步驟。這樣,我們從變分推斷框架中快速得到了 EM 算法。

變分推斷下的GAN

在這部分內容中,我們介紹了一般化的將 GAN 納入到變分推斷中的方法,這將引導我們得到 GAN 的新理解,以及一個有效的正則項。?

一般框架

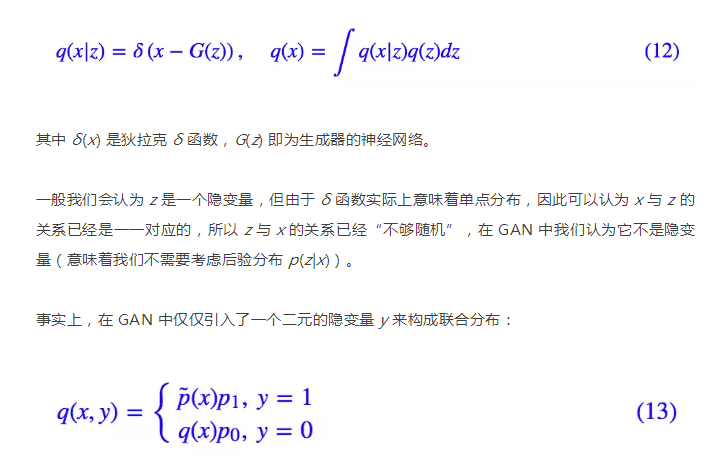

同 VAE 一樣,GAN 也希望能訓練一個生成模型 q(x|z),來將 q(z)=N(z;0,I) 映射為數據集分布 p?(x),不同于 VAE 中將 q(x|z) 選擇為高斯分布,GAN 的選擇是:

這里 p1=1?p0 描述了一個二元概率分布,我們直接取 p1=p0=1/2。另一方面,我們設 p(x,y)=p(y|x)p?(x),p(y|x) 是一個條件伯努利分布。而優化目標是另一方向的 KL(q(x,y)‖p(x,y)):

這里包含了我們不知道的 p?(x),但是假如 D(x) 模型具有足夠的擬合能力,那么跟 (11) 式同理,D(x) 的最優解應該是:

基本分析

可以看到,第一項就是標準的 GAN 生成器所采用的 loss 之一。

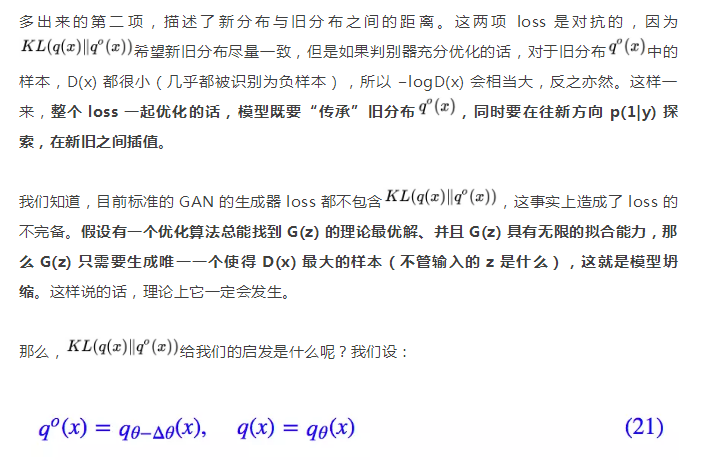

多出來的第二項,描述了新分布與舊分布之間的距離。這兩項 loss 是對抗的,因為希望新舊分布盡量一致,但是如果判別器充分優化的話,對于舊分布

也就是說,假設當前模型的參數改變量為 Δθ,那么展開到二階得到:

而我們用的是基于梯度下降的優化算法,所以 Δθ 正比于梯度,因此標準 GAN 訓練時的很多 trick,比如梯度裁剪、用 adam 優化器、用 BN,都可以解釋得通了,它們都是為了穩定梯度,使得 θ 不至于過大,同時,G(z) 的迭代次數也不能過多,因為過多同樣會導致 Δθ 過大。

還有,這部分的分析只適用于生成器,而判別器本身并不受約束,因此判別器可以訓練到最優。

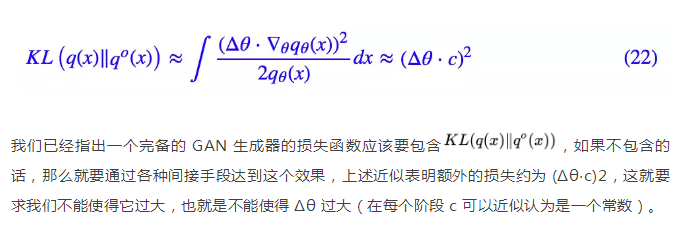

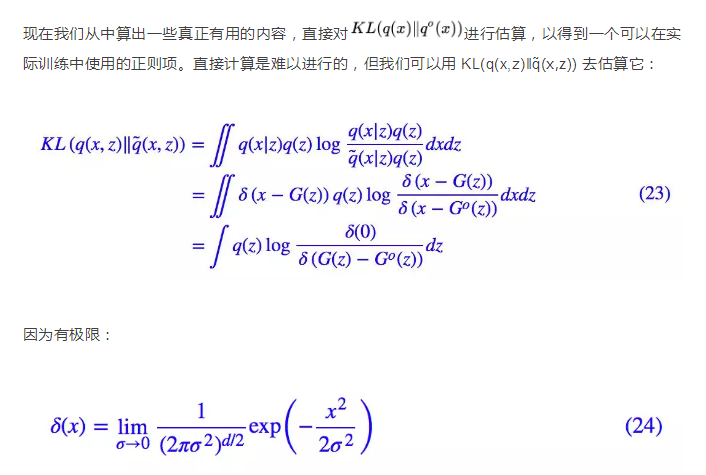

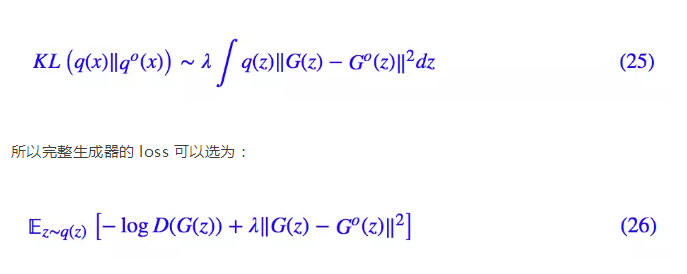

正則項

所以可以將 δ(x) 看成是小方差的高斯分布,代入算得也就是我們有:

也就是說,可以用新舊生成樣本的距離作為正則項,正則項保證模型不會過于偏離舊分布。

下面的兩個在人臉數據 CelebA 上的實驗表明這個正則項是生效的。實驗代碼修改自:

https://github.com/LynnHo/DCGAN-LSGAN-WGAN-WGAN-GP-Tensorflow

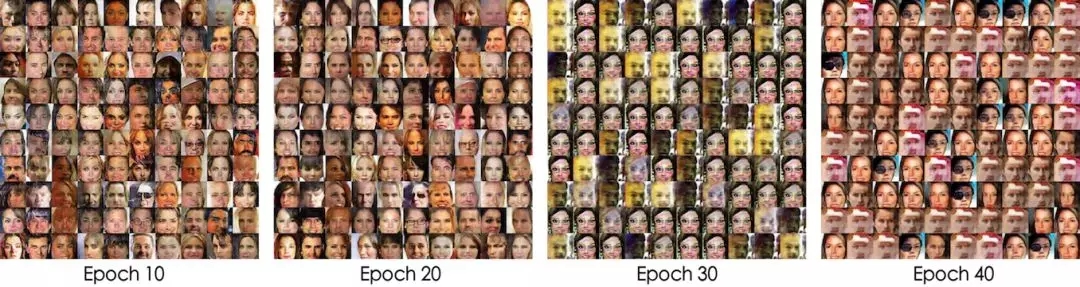

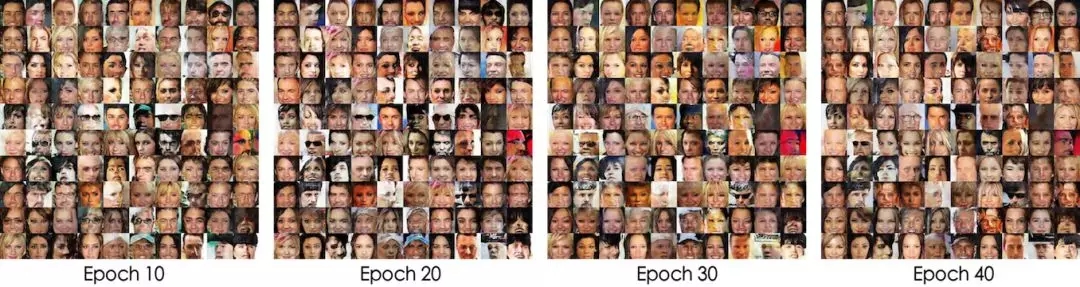

實驗一:普通的 DCGAN 網絡,每次迭代生成器和判別器各訓練一個 batch。

不帶正則項,在25個epoch之后模型開始坍縮

帶有正則項,模型能一直穩定訓練

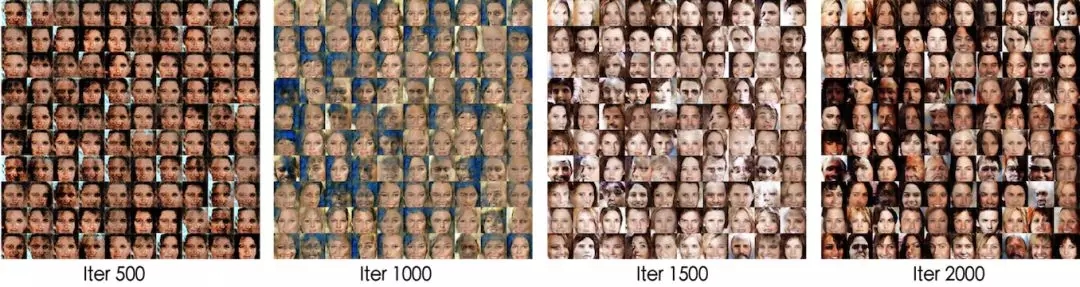

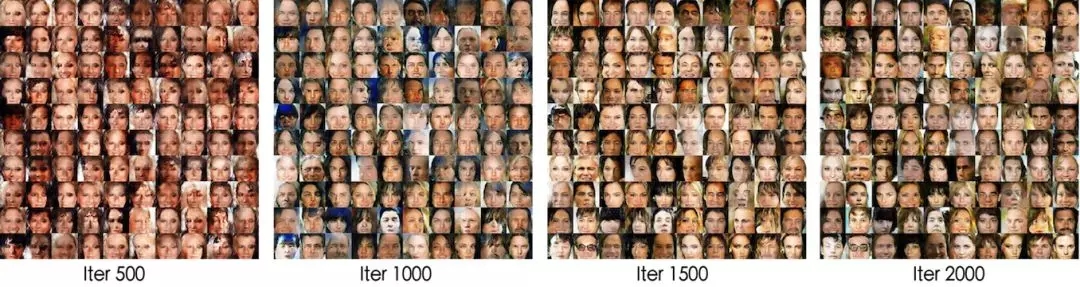

實驗二:普通的 DCGAN 網絡,但去掉 BN,每次迭代生成器和判別器各訓練五個 batch。

不帶正則項,模型收斂速度比較慢

帶有正則項,模型更快“步入正軌”

GAN相關模型

對抗自編碼器(Adversarial Autoencoders,AAE)和對抗推斷學習(Adversarially Learned Inference,ALI)這兩個模型是 GAN 的變種之一,也可以被納入到變分推斷中。當然,有了前述準備后,這僅僅就像兩道作業題罷了。?

有意思的是,在 ALI 之中,我們有一些反直覺的結果。

GAN視角下的AAE

事實上,只需要在 GAN 的論述中,將 x,z 的位置交換,就得到了 AAE 的框架。?

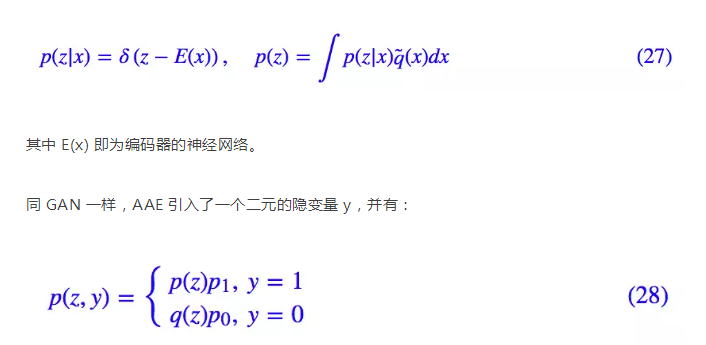

具體來說,AAE 希望能訓練一個編碼模型 p(z|x),來將真實分布 q?(x) 映射為標準高斯分布 q(z)=N(z;0,I),而:

同樣直接取 p1=p0=1/2。另一方面,我們設 q(z,y)=q(y|z)q(z),這里的后驗分布 p(y|z) 是一個輸入為 z 的二元分布,然后去優化 KL(p(z,y)‖q(z,y)):

現在我們優化對象有 q(y|z) 和 E(x),記 q(0|z)=D(z),依然交替優化:先固定 E(x),這也意味著 p(z) 固定了,然后優化 q(y|z),這時候略去常量,得到優化目標為:

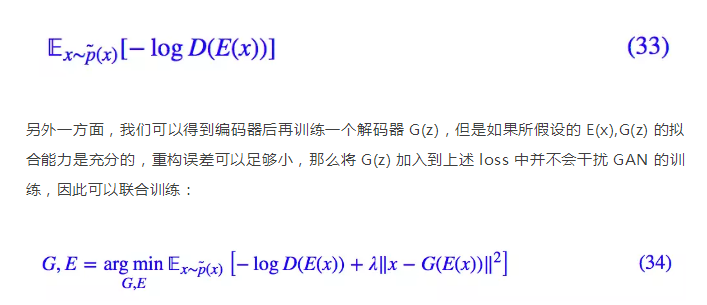

一方面,同標準 GAN 一樣,謹慎地訓練,我們可以去掉第二項,得到:

反直覺的ALI版本

ALI 像是 GAN 和 AAE 的融合,另一個幾乎一樣的工作是 Bidirectional GAN (BiGAN)。相比于 GAN,它將 z 也作為隱變量納入到變分推斷中。具體來說,在 ALI 中有:

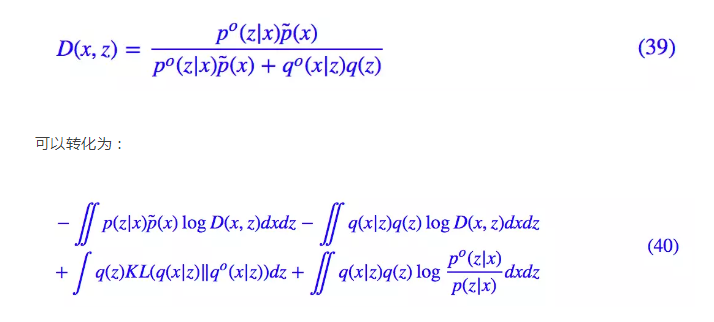

等價于最小化:

跟 VAE 一樣,對 p(z|x) 和 q(x|z) 的期望可以通過“重參數”技巧完成。接著固定 D 來優化 G,E,因為這時候有 E 又有 G,整個 loss 沒得化簡,還是 (37) 那樣。但利用 D 的最優解:

由于 q(x|z),p(x|z) 都是高斯分布,事實上后兩項我們可以具體地算出來(配合重參數技巧),但同標準 GAN 一樣,謹慎地訓練,我們可以簡單地去掉后面兩項,得到:

它們都不等價于 (41)。針對這個差異,事實上筆者也做了實驗,結果表明這里的 ALI 有著和標準的 ALI 同樣的表現,甚至可能稍好一些(可能是我的自我良好的錯覺,所以就沒有放圖了)。這說明,將對抗網絡視為一個極大極小問題僅僅是一個直覺行為,并非總應該如此。

結論綜述

本文的結果表明了變分推斷確實是一個推導和解釋生成模型的統一框架,包括 VAE 和 GAN。通過變分推斷的新詮釋,我們介紹了變分推斷是如何達到這個目的的。?

當然,本文不是第一篇提出用變分推斷研究 GAN 這個想法的文章。在《On Unifying Deep Generative Models》一文中,其作者也試圖用變分推斷統一 VAE 和 GAN,也得到了一些啟發性的結果。但筆者覺得那不夠清晰。事實上,我并沒有完全讀懂這篇文章,我不大確定,這篇文章究竟是將 GAN 納入到了變分推斷中了,還是將 VAE 納入到了 GAN 中。相對而言,我覺得本文的論述更加清晰、明確一些。?

看起來變分推斷還有很大的挖掘空間,等待著我們去探索。

聲明:文章收集于網絡,如有侵權,請聯系小編及時處理,謝謝!

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4814.html

摘要:本文將討論兩種可用于解決貝葉斯推理問題的主要方法基于采樣的馬爾可夫鏈蒙特卡羅,簡稱方法和基于近似的變分推理,簡稱方法。而貝葉斯推理則是從貝葉斯的角度產生統計推斷的過程。貝葉斯推理問題還可能會產生一些其他的計算困難。 全文共6415字,預計學習時長20分鐘或更長 showImg(https://segmentfault.com/img/bVbvFZZ?w=1280&h=853); 圖片來...

摘要:例如,即插即用生成網絡通過優化結合了自動編碼器損失,損失,和通過與訓練的分類器定于的分類損失的目標函數,得到了較高水平的樣本。該論文中,作者提出了結合的原則性方法。 在機器學習研究領域,生成式對抗網絡(GAN)在學習生成模型方面占據著統治性的地位,在使用圖像數據進行訓練的時候,GAN能夠生成視覺上以假亂真的圖像樣本。但是這種靈活的算法也伴隨著優化的不穩定性,導致模式崩潰(mode colla...

摘要:老顧受邀在一些大學和科研機構做了題為深度學習的幾何觀點的報告,匯報了這方面的進展情況。昨天年月日,嚴東輝教授邀請老顧在泛華統計協會舉辦的應用統計會議上做了深度學習的幾何觀點的報告。小結最優傳輸理論可以用于解釋深度學習中的概率分布變換。 (最近,哈佛大學丘成桐先生領導的團隊,大連理工大學羅鐘鉉教授、雷娜教授領導的團隊應用幾何方法研究深度學習。老顧受邀在一些大學和科研機構做了題為深度學習的幾何觀...

摘要:自年提出生成對抗網絡的概念后,生成對抗網絡變成為了學術界的一個火熱的研究熱點,更是稱之為過去十年間機器學習領域最讓人激動的點子。 自2014年Ian Goodfellow提出生成對抗網絡(GAN)的概念后,生成對抗網絡變成為了學術界的一個火熱的研究熱點,Yann LeCun更是稱之為過去十年間機器學習領域最讓人激動的點子。生成對抗網絡的簡單介紹如下,訓練一個生成器(Generator,簡稱G...

摘要:百度網盤提取碼最近一直關注貪心學院的機器學習訓練營,發現這門課講的很有深度,不僅適合職場也適合科研人員,加入行業拿到高薪僅僅是職業生涯的開始。 ??百度網盤??提取碼:u6C4最近一直關注貪心學院的機器學習訓練營,發現這門課講的很有深度,不僅適合職場也適合科研人員,加入AI行業拿到高薪僅僅是職業生涯的開始。現階段AI人才結...

閱讀 3371·2023-04-25 14:07

閱讀 3437·2021-09-28 09:35

閱讀 2079·2019-08-30 15:55

閱讀 1396·2019-08-30 13:48

閱讀 2496·2019-08-30 13:16

閱讀 3196·2019-08-30 12:54

閱讀 3231·2019-08-30 11:19

閱讀 1868·2019-08-29 17:17