資訊專欄INFORMATION COLUMN

摘要:本文參考文獻被引次數被引次數今天要講的一個模型是由人工智能研究院提出來的完全基于卷積神經網絡的框架,我在之前的推送中已經講過好多次了,傳統的模型是基于來實現的,特別是,這就帶來了計算量復雜的問題。

本文參考文獻:

Gehring J, Auli M, Grangier D, et al. Convolutional Sequence to Sequence Learning[J]. arXiv preprint arXiv:1705.03122, 2017.

被引次數:13

Dauphin Y N, Fan A, Auli M, et al. Language modeling with gated convolutional networks[J]. arXiv preprint arXiv:1612.08083, 2016.

被引次數:24

今天要講的一個模型是由Facebook人工智能研究院提出來的完全基于卷積神經網絡的seq2seq框架,seq2seq我在之前的推送中已經講過好多次了,傳統的seq2seq模型是基于RNN來實現的,特別是LSTM,這就帶來了計算量復雜的問題。Facebook作出大膽改變,將編碼器、解碼器、注意力機制甚至是記憶單元全部替換成卷積神經網絡,想法是不是簡單粗暴?雖然單層CNN只能看到固定范圍的上下文,但是將多個CNN疊加起來就可以很容易將有效的上下文范圍放大。Facebook將此模型成功地應用到了英語-法語機器翻譯、英語-德語機器翻譯,不僅刷新了二者前期的記錄,而且還將訓練速度提高了一個數量級,無論是GPU還是CPU上。

在詳細開始介紹Facebook的conv seq2seq模型之前,我們需要回顧一下Gated CNN,這個同樣是Facebook在去年底提出來的用于語言建模的模型。

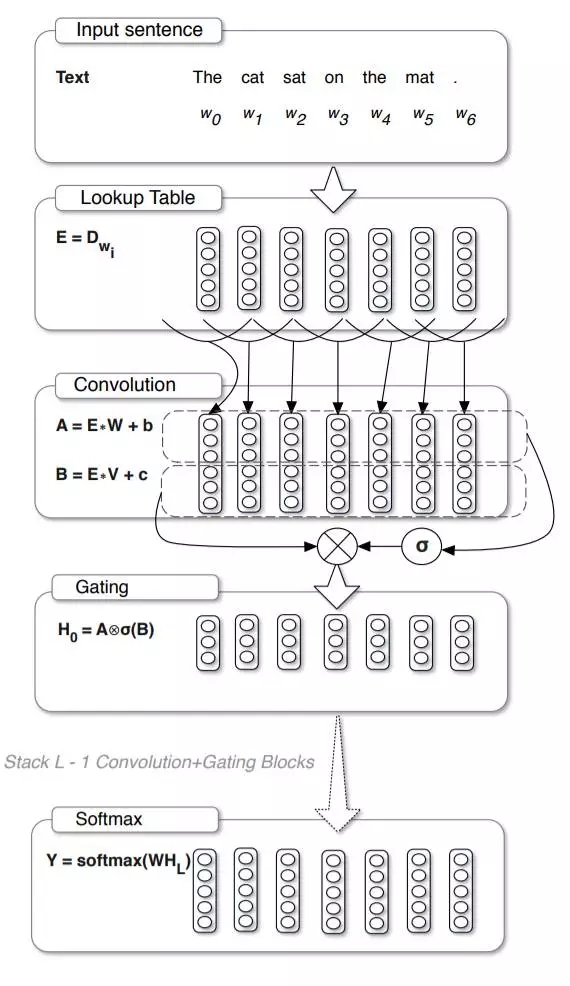

用于語言建模的Gated CNN模型如下圖所示,可以看到,最上層的word embedding操作與傳統的語言建模沒有區別,緊接著就是對這些embedding向量劃分時間窗并做卷積操作,注意這里使用了兩個卷積神經網絡,這兩個神經網絡中的其中一個通過激活函數一個與另外一個進行相乘,得到最終的輸出。說到這里,應該有讀者已經發現了其中一個卷積神經網絡的功能就是充當了閘門的作用,即控制著多少有用的信息作為最終的輸出。同時,實驗結果也表明Gated CNN在WikiText-103上取得了較好的效果。

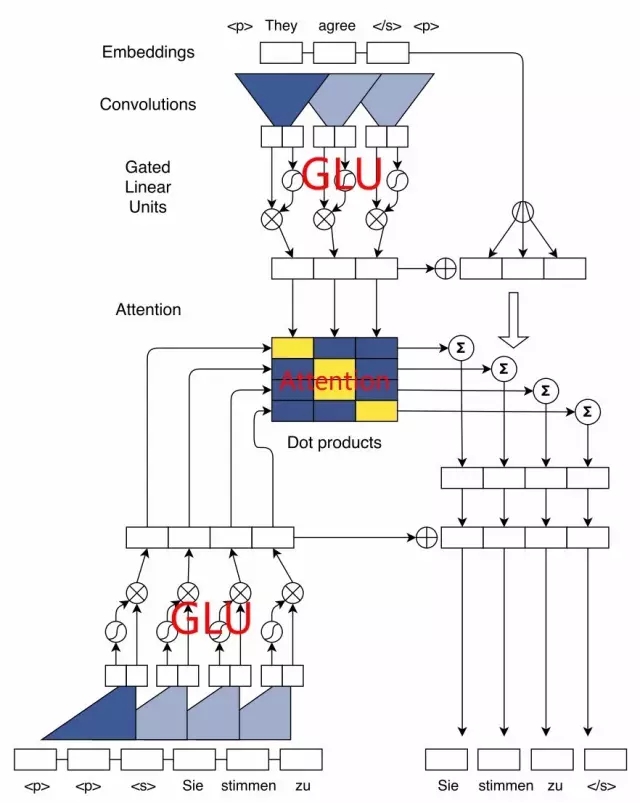

在conv seq2seq這篇文章中,也使用了Gated CNN以及Residual connection,文中的模型結構圖如下所示,下面我來仔細說明一下這里的計算細節。

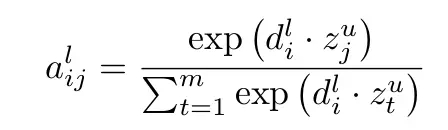

對于編碼器,原始的單詞首先需要經過embedding層得到其相應的embedding向量,然后將embedding向量作為Gated CNN的輸入,這里需要注意的是,為了保證經過卷積操作之后與之前的輸入長度一致,卷積需要做pad操作。模型中有兩個地方都使用到了GLU(Gated Linear Unit),我在圖中已經用紅色字眼標出,編碼器的embedding和解碼器的embedding分別通過各自的GLU單元得到各自的分布式狀態,將兩個狀態矩陣進行點乘即可得到注意力權重,圖中已用紅色字體Attention標出,具體的注意力權重的計算如下公式所示:

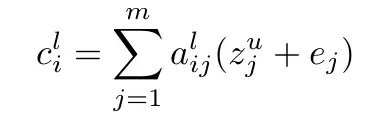

注意到圖中編碼器的embedding和編碼器的狀態進行相加,并且乘上注意力權重,得到的結果文中稱之為條件輸入c,這里我們可以對比傳統的注意力機制,傳統的注意力機制是直接將注意力權重和編碼器的狀態進行相乘,而這里引入了embedding量,文中解釋是因為embedding可以在做預測的時候可以結合具體元素的信息,增加了位置感,條件輸入c的計算如下圖公式所示:

將條件輸入c加上解碼器的狀態,即可得到輸出序列的概率,以上就是conv seq2seq的模型結構。作者最終在機器翻譯上相比其他RNN的模型速度提高了近10倍!

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4631.html

摘要:通過兩年的發展,今天我們可以肯定地說放棄你的和有證據表明,谷歌,,等企業正在越來越多地使用基于注意力模型的網絡。 摘要: 隨著技術的發展,作者覺得是時候放棄LSTM和RNN了!到底為什么呢?來看看吧~ showImg(https://segmentfault.com/img/bV8ZS0?w=800&h=533); 遞歸神經網絡(RNN),長期短期記憶(LSTM)及其所有變體: 現在是...

摘要:百度網盤提取碼最近一直關注貪心學院的機器學習訓練營,發現這門課講的很有深度,不僅適合職場也適合科研人員,加入行業拿到高薪僅僅是職業生涯的開始。 ??百度網盤??提取碼:u6C4最近一直關注貪心學院的機器學習訓練營,發現這門課講的很有深度,不僅適合職場也適合科研人員,加入AI行業拿到高薪僅僅是職業生涯的開始。現階段AI人才結...

閱讀 3061·2021-10-27 14:16

閱讀 2877·2021-09-24 10:33

閱讀 2284·2021-09-23 11:21

閱讀 3228·2021-09-22 15:14

閱讀 810·2019-08-30 15:55

閱讀 1674·2019-08-30 15:53

閱讀 1740·2019-08-29 11:14

閱讀 2190·2019-08-28 18:11