資訊專欄INFORMATION COLUMN

摘要:絕大多數人忽略了深度學習只占機器學習領域的,而機器學習又只占到了人工智能領域的。一個深度學習專家無法與人工智能專家劃上等號。但是,深度學習并不是人類可以創造的人工智能科技的終點。深度學習的公正性并非來自其自身,而是人類篩選和準備的數據。

人工智能的這一波熱潮毫無疑問是由深度學習引發的,自吳恩達等人 2011 年發表「識別貓」研究后,深度學習及其引發的技術已經在圖像識別、游戲等任務中超越人類,并讓機器學習技術的應用帶入人們的生活。這種 AlphaGo 背后的技術是否是未來人工智能的方向?Fabio Ciucci 給出了他的看法。

現在每一個人都在學習,或者正打算學習深度學習(DL),它是目前人工智能諸多流派中興起的一個。各個年齡階段的數十萬人學習著免費和收費的深度學習課程。太多的創業公司和產品的命名以「深度」開頭,深度學習已然成了一個流行語,但其真正使用實際上很少。絕大多數人忽略了深度學習只占機器學習領域的 1%,而機器學習又只占到了人工智能領域的 1%。余下的 99% 則被用來處理實踐中的絕大多數任務。一個深度學習專家無法與人工智能專家劃上等號。

深度學習并不是人工智能的同義詞。谷歌、Facebook 等巨頭公司宣傳最多的人工智能工具主要是或者僅僅是深度學習,因此大眾誤以為所有的人工智能突破都(將)由深度學習實現。真實情況并非如此。決策樹比如 XGBoost 不會成為頭條,但卻在很多 Kaggle 表格數據競賽中低調地擊敗了深度學習。媒體暗示 AlphaGo 的成功全部歸于深度學習,但實際上它是蒙特卡洛樹搜索+深度學習,這表明深度學習單槍匹馬很難取勝。很多強化學習的任務通過神經進化的 NEAT 而不是反向傳播得到解決。人工智能領域存在著「深度誤傳」(deep misinformation)。

我并不是說深度學習沒有解決問題:它令人印象深刻。樹和其他算法并沒有完勝深度學習,某些任務上深度學習無法被取代,但是我希望未來一些非深度學習系統可被(重新)發現以擊敗深度學習,并解決了目前無法解釋的黑箱問題。同樣我也希望讀到有關「災難性遺忘」的深度學習文章,它是指在學習新知識時快速遺忘先前已學習知識的傾向,并且需要每天對抗「過擬合」。關于「智能」:深度學習只是簡單地相信給到的訓練數據,而不管什么是真與假,現實與想象,公平與不公。人類也會誤信假新聞,但只是在某種程度上,甚至孩童都知道電影是虛構的、不真實的。

關于更多細節,如果你有時間了解,請見我的詳述文章:https://www.linkedin.com/pulse/ai-deep-learning-explained-simply-fabio-ciucci。

20 年前,每個人都在學習 HTML,這個手動寫網頁的標記語言當時被認為足以成就一個億萬富翁。我學習每一項看起來有用的技術,如 HTML、手機 app 和深度學習,并且邀請其他人一些學習。事實上,你一生中不是只學習一次技術。1995 年 HTML 開始過時,無法滿足需求,取而代之的是 CSS、JavaScript 和服務器語言。同樣地,深度學習有一天也會過時。大多數流行的手機 APP 根本用不到 HTML,那么,誰又會知道未來的人工智能 APP 用不用得到深度學習呢?

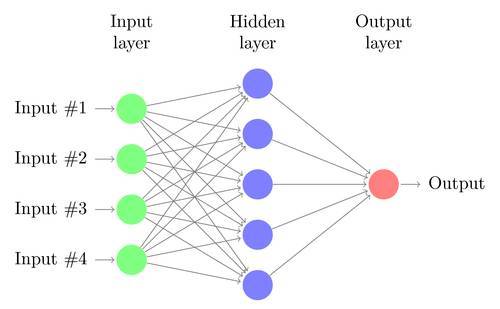

實際上,深度學習是 1980 年代的技術,比 HTML 還老:由于有了更多的訓練數據,1970 年代的「帶有隱藏層的神經網絡」獲得新生,重新命名為深度學習之后被大肆炒作。1992 年我扼要地查看了神經網絡以及分形分析(fractal)和細胞自動機的源代碼。正如絕大多數人一樣,當時我并沒有選擇深度學習,只是把它當作毫無實際價值的學術數學難題。相反,我聚焦于視頻游戲的 3D 技術,因為它可以即刻獲得結果;后來我又開始關注互聯網等。但是我們都錯了,深度學習借助大數據可以大有作為。2015 年 Deep Dream 簡直令我著迷,接著是 GANs 等。但是,深度學習并不是人類可以創造的人工智能科技的終點。

數十年來,「古老」的深度學習技術已被廣泛研究和更新以更準確地解決更多任務,但是沒有一個深度學習網絡(卷積、RNN、RNN + LSTM、GANs 等)可以解釋其自身的決策。無疑深度學習還會解決更多的問題,取代更多的工作,但不太可能解決所有的問題,或者保持驚人的進步以自我解決黑箱問題或者為之正名。

哲學家柏拉圖與亞里士多德:深度學習無法理解他們

未來人工智能應探索其他的新方法,或者已存在卻被忽視的方法,而不僅僅是深度學習。深度學習的一個局限是把數據中最常遇見的內容作為真理,把統計學上較稀少的東西看作假的。深度學習的公正性并非來自其自身,而是人類篩選和準備的數據。深度學習可以閱讀并翻譯文本,但不是以人類的方式。如果使用超過 100 本書訓練深度學習模型:40 本書告訴仇恨、戰爭、死亡和摧毀如何是壞的,60 本書告訴希特勒的納粹思想是好的,那么該模型最終會成為 100% 的納粹!

深度學習靠自己永遠無法明白為什么殺害猶太人、同性戀以及殘疾人是錯誤的,如果在訓練數據集中納粹主義是最流行的觀點。難怪深度學習無法解釋其自身決策,除了「我(深度學習)讀到最多的是「納粹主義是正確的」,因此它應該是正確的」。深度學習將會學習并模仿最具缺陷的邏輯,包括恐怖主義。甚至孩童可以自己明白電影中那個家伙是壞人,但是深度學習做不到,除非人類首先明確教導它。深度學習中有些東西很酷,比如帶有反向傳播的梯度下降、自定義深度學習硬件;但這多是統計學和幾何學的,很可能不會出現在 2037 年的人工智能時代。

對很多任務來說,深度學習 AI 正在或者將會變的違法。收集 28 個歐洲國家公民數據的人或公司應在 2018 年 5 月 25 日起遵循《一般數據保護條例》(GDPR),屆時歐洲的一些 APP 將被禁止使用深度學習,這導致初創公司拼命尋找深度學習的替代方案,否則將面臨罰款的危險。罰款金額為全球營收的 4%,包括美國部分。關于自動化決策的 GDPR 要求深度學習具有解釋其決策的能力,防止基于種族、觀點等的歧視的發生。類似于 GDPR 的法律已在全球廣泛制定,這只是時間問題。《美國公平信用報告法》要求披露所有對消費者信用評分產生不利影響的因素,數量上限是 4 個。深度學習的因素可謂海量,而不僅僅是 4 個,如何將其簡化為 4 個呢?人工智能,正如比特幣 ICO,開始忽視法規,但是法律與懲罰一直會在。

采取更多相關決策而不是區分一張圖像是否是貓,或者在自拍的哪部分添加兔耳的深度學習系統將會被非深度學習系統取代。人工智能必須是負責任的,可以使用簡單、合法有效的語言向法官和用戶解釋其輸出結果,這與深度學習大不相同。深度學習的復雜性,對法官和用戶來說就像是魔術,是一種法律風險,而不是一個很酷的未來。深度學習將會建議或警示人類,比如從醫療圖像中檢測疾病,并獲得醫生的驗證,但這是部分的自動化,缺乏細節。我們將向因為人工智能而被拒絕并尋求解釋的人們(工作、貸款被拒絕等)訴說什么呢?

法律包含「解釋權」,比如,為什么工作或貸款被拒絕。深度學習給出了非自然(合法)語言解釋的結果。深度學習的代碼容易獲得,卻不為法官或用戶所接受,因為即使較好的數學家或其他算法也無法搞明白它,將模型簡化成可以理解的語言。即使由人類做出最后的決策,人工智能也應給出詳細的理由。沒有人知道如何修改深度學習以給出簡單的人類可理解的解釋,因此深度學習不可能做到順從。這一問題同樣影響到了若干個其他人工智能和機器學習算法,但不像深度學習那么嚴重。比如,如果決策樹被提升或集成,它也會不可解釋。但是未來,新的或者重新發現的已解決了黑箱問題的人工智能,將會在常規決策方面取代深度學習和人類。

在 GDPR 的情況中,只有人類可以拒絕一個應用:人工智能可自動化積極的結果;如果它拒絕了一項貸款、工作等,就應該將這項任務交給人類來處理這些消極的結果。但是在拒絕的情況中,人類將不會從基于深度學習的人工智能中獲得幫助或解釋,他們不知道深度學習的邏輯是否正確。他們不得不自己從頭檢查數據,以決定是否最終拒絕。風險在于為了節約時間和成本,人類會做出假的解釋,并盲目接受人工智能的認可。安全起見,對于接受和拒絕,你都要有充足的理由,無論 GDPR 中說了什么。非深度學習的 AI 系統把所有決策的解釋提供給用戶、法官和支持人員,將最終被人類采用,用于做出完全和部分的自動化決策。

在法律和深度學習之前,解釋性已經是一個大問題。在反壟斷案例中,谷歌等公司被質問為什么是這個產品而不是其他產品出現在搜索結果中,這也是深度學習出現之前的事:很多其他的算法同樣以瘋狂的方式混合算法以得到結果,因此沒有人類可以輕易地推論出決策原因。法官被告知工程師并不了解詳情,線性代數的頁面被當作證據。這無法善終:在特定的法律存在之前,多個案例承擔著數十億美元的罰款,甚至收到變更系統的警告。用戶的集體訴訟根據商店、銀行的自動決策單元自動拒絕工作、貸款、退款等,正越來越普遍。無法解釋意味著沒有防衛、被罰款以及一場品牌公關災難。

對大部分人來說,「人工智能」是科幻電影《人工智能》(AI)中能夠給出聰明解讀的 AI,電影中人類可以快速決定自己是否同意,這樣易于進行法律驗證(legal validation)。大多數聽說過「AI-first」或「使用 AI」公司的人,包括法官和撰寫《一般數據保護條例》(GDPR)等法律的人,期待 AI 像電影中一樣,即使被法院傳召,也能夠捍衛自己的決定,這令用戶和法官都印象深刻。但是,與期待不同,我們得到的是無法解釋的「深度學習人工智能」,這些人工智能即使在能夠解決的問題上也不經常得到使用,因為其缺乏可解釋性。深度學習不會節省成本,也不會取代那些需要敏銳的自動決策的工作。即使在人類必須作出最終決策的情況下,工具 AI 解釋自己的建議也比 AI 不給出緣由就做出回應要更加可取。可解釋的 AI 一旦被(重新)發現,將會更加安全、合法、廉價、快速,取代深度學習和人類。深度學習在 20 世紀 60 到 80 年代發明,2010 年以來重新被發現;或許未來可解釋的 AI 的基礎也已經被某些研究者描述出來,但是由于不是深度學習,所以可能在幾十年內都沒人關心和開發,直到它們被重新發現和炒熱。

關于自動決策的 GDPR 也需要防范根據種族、意見、健康狀況等產生的歧視。但是使用用戶生成的數據(如社交媒體和新聞,不指真實的數據,如醫療或財政記錄)訓練的深度學習模型通常暗含邪惡的偏見。如前所述,深度學習可以讀取大量文本和數據,并模仿其內容,但無法理解內容。深度學習只相信它在數據中頻繁看到的事物、底層模式和趨勢,因此它會放大人類社會的偏見和問題。數據顯示被逮捕的黑人比白人多,那么一旦有人犯罪,深度學習將首先懷疑黑人;數據顯示公司董事會董事中男性比例高于女性,則深度學習將在招聘中更傾向于男性應聘者。

深度學習決策會比訓練數據的平均樣本包含更深刻的偏見,如種族歧視、性別歧視。這個問題在所有的機器學習算法中都有發生,但是深度學習模型是其中最難測試、檢測、控制和調整的。這個問題很難解決,這引起很多深度學習實驗突然取消,從聊天機器人變得納粹化、充滿仇恨,到美圖軟件中給黑人照片美白。

深度學習是一個神經網絡,你無法多帶帶編輯每個答案的輸出結果。

你無法通過在訓練之后添加補丁,來修復一個帶有偏見、種族和性別歧視的深度學習模型。深度學習是一個神經網絡,與其他 AI 方法不同,你無法編輯某個答案,而是必須使用全新的、完全公正的、稀有的數據對該網絡進行重新訓練。深度學習可以在不理解的情況下模仿數據中的內容:它不會否定任何數據,不會發現社會上的偏見,而只是「學習所有數據」。你應該雇傭一個人類員工,專門創建假的完美、公正的數據。但是,由人類專家編輯創建海量無偏見數據的成本僅為了訓練深度學習模型,又怎么可以說用 AI 取代人類呢!此外,即使你已經訓練出真正公正的深度學習模型,你也無法向法官或用戶證明其決策的公正性,因為它無法提供解釋。

深度學習的重要性應該降低,用于沒有法律風險的非商業 app 或游戲。當可解釋的 AI 變得流行,深度學習將會像磁帶一樣被拋棄。在游戲中輸給機器人的人類不太可能說服法官對 AI 公司罰款,因為你無法解釋 AI 是怎么贏的。不滿 FaceApp 把自己的自拍照修的更老、更年輕,或者換了性別的人也不太可能說服法官對 FaceApp 罰款,因為你無法解釋 AI 是如何決定新面孔的。在醫療圖像中進行疾病檢測是一項安全的深度學習應用,前提是用戶在服藥之前先向人類醫生尋求確認。

合法的深度學習市場非常有限:在決策結果造成財政、健康上的區別,或者存在歧視性,而深度學習無法理解決策是否公正以及為什么公正的時候,法官可以處罰。那么自動駕駛呢?似乎在藝術、游戲或高級幽默以外的領域使用深度學習都有法律風險。現有的非深度學習方法可以取代深度學習,新方法也會被(重新)發現,因此 AI 的發展將會順利進行。尤其是每個人研究(并投資)AI 和機器學習科學領域中的所有新舊算法,而不只是深度學習:這也是成為「人工智能專家」的路徑。

深度學習除了正在「非法」用于很多可解任務以外,它也不能被用于解決以下一系列問題:那些需要抽象推理來找出數據中哪些是公平,哪些是不公平的任務,那些需要解釋其中的邏輯,并自行作出決定的任務。即使對于那些不需要解釋的任務來說,深度學習看起來是較好的系統(如圖像識別),但是也不如人類自己那樣具有穩定性。你可以輕而易舉地使用對抗樣本來讓深度學習系統出錯:為一張貓的圖片加入一些特殊的噪點,機器就會把它誤認為其他不相關的東西,而人類絕不會犯錯。如果街邊的路牌被對抗樣本黑掉了,現在的自動駕駛汽車將不再安全。新一代的人工智能系統必須克服這個問題——它也將取代深度學習。

著名深度學習庫 Keras 作者 Fran?ois Chollet 曾在一篇名為《深度學習的限制》的文章中說到:「深度學習真正能成功做到的是使用幾何變換,在給定大量人類標注數據的情況下將空間 X 映射到空間 Y 的能力。」這些空間擁有多維,不僅僅是三維的,這就是深度學習可以模仿畢加索風格作畫、在德州撲克中 Bluff,以及在其他一些方面里展示創造力的原因。但是對于外行人來說,這也許意味著:深度學習模型可以被訓練成擁有識別貓的能力,但本身不知道什么是貓;可以是一個種族主義者,但不知道什么是種族主義。深度學習可以識別貓、具有種族主義,并贏得很多游戲,這看起來是令人矚目的進步,但深度學習無法解釋為什么圖中的動物是貓,也無法定義種族主義。

在《深度學習的未來》中,Keras 的作者描述了一種只有「幾何模塊」的全新深度學習系統,它應該與尚未出現的「算法模塊」和「元學習器」相關。這種方式可以顯著增加可以解決問題的類型與數量,但因為深度學習模塊的存在,這種方式仍然無法解釋決策的機制。這就像我們不能用言語解釋大腦中計算出的某些感覺或圖像。人類可以解釋自己的想法,但這種解釋過于簡單化,不甚準確。機器的算法卻總被要求完全準確。有一些專家正在開發完全不包含深度學習的全新人工智能系統,但他們缺乏支持:現在所有人都只投資深度學習,而這個風潮還將持續一段時間。沒有人知道下一個人工智能浪潮將會是關于什么的,但看起來不會是深度學習 2.0。

深度學習正處于過熱狀態,因為只有與深度學習軟/硬件相關的人正在不斷討論它。你可曾見過任何「自然智能」專家,如心理學家和哲學家支持過深度學習?

如果你不太了解人工智能,或者還沒有時間來學習,我認為你可以等待下一代人工智能系統的興起,直接跳過深度學習 1.0 時代。如果你有這方面的需求,我建議你深入了解整個人工智能及機器學習領域的知識——而不僅僅是深度學習。在人工智能成為火熱概念的今天,我們更需要冷靜的思考。?

原文鏈接:https://www.linkedin.com/pulse/deep-learning-ai-future-fabio-ciucci

歡迎加入本站公開興趣群商業智能與數據分析群

興趣范圍包括各種讓數據產生價值的辦法,實際應用案例分享與討論,分析工具,ETL工具,數據倉庫,數據挖掘工具,報表系統等全方位知識

QQ群:81035754

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/4617.html

摘要:對深度學習模型而言,水就是海量的數據。就拿機器識別物體這樣的任務來說,通過數百萬副圖片的訓練,深度學習模型甚至可以超過人的肉眼的識別能力,這確實是人工智能在感知類問題上重要的里程碑。關于深度學習,還有一個有趣的現象。 說到人工智能和機器人,上點兒歲數的碼農們可能對封面這張圖有點印象。不明就里的朋友,可以回去補習一下《編輯部的故事》。我是個二手的人工智能表演藝術家:從博士畢業開始,就在MSRA...

摘要:我們隊年的預測基本正確,當中有些預測趨勢也可以用于新的一年,下面繼續看到對年數據科學機器學習和人工智能領域的預測。 showImg(https://segmentfault.com/img/bVbnqYV?w=1024&h=512); 作者:William VorhiesCDA數據分析研究院原創作品, 轉載需授權? 2018年剛剛結束,在2019年到來之際,讓我們一起展望在今年數據科學...

摘要:不過,深度學習并不是人類可以創造的完美人工智能科技的終點。深度學習的公正性并非來自其自身,而是人類篩選和準備的深度學習數據。深度學習給出的是非自然合法語言解釋的結果。 現在每一個人都正在學習,或者正打算學習深度學習,它是目前人工智能諸多流派中興起的一個。各個年齡階段的數十萬人都在學習著免費和收費的深度學習課程。太多的創業公司和產品的命名以深度開頭,深度學習已然成了一個流行語,但其真正的落地應...

摘要:而這種舉一反三的能力在機器學習領域同樣適用,科學家將其稱之為遷移學習。與深度學習相比,我們技術較大優點是具有可證明的性能保證。近幾年的人工智能熱潮中,深度學習是最主流的技術,以及之后的成功,更是使其幾乎成為的代名詞。 如今,人類將自己的未來放到了技術手里,無論是讓人工智能更像人類思考的算法,還是讓機器人大腦運轉更快的芯片,都在向奇點靠近。谷歌工程總監、《奇點臨近》的作者庫茲韋爾認為,一旦智能...

閱讀 3013·2021-11-16 11:42

閱讀 3650·2021-09-08 09:36

閱讀 949·2019-08-30 12:52

閱讀 2481·2019-08-29 14:12

閱讀 769·2019-08-29 13:53

閱讀 3583·2019-08-29 12:16

閱讀 643·2019-08-29 12:12

閱讀 2467·2019-08-29 11:16