資訊專欄INFORMATION COLUMN

摘要:大家好,我是黃文堅(jiān),今天給大家講講深度學(xué)習(xí)。我們?cè)賮?lái)看看這兩個(gè)深度學(xué)習(xí)的網(wǎng)絡(luò),左邊是策略網(wǎng)絡(luò),我走到一步的時(shí)候,分析棋盤上每個(gè)位置有多大價(jià)值,給每個(gè)位置打一個(gè)分?jǐn)?shù)。可以說深度學(xué)習(xí)讓機(jī)器人擁有幾歲小孩拾起物體的能力。

大家好,我是黃文堅(jiān),今天給大家講講深度學(xué)習(xí)。我不講技術(shù)原理,講講技術(shù)應(yīng)用。

深度學(xué)習(xí)是我們明略重要的研究方向,是未來(lái)實(shí)現(xiàn)很多令人驚嘆的功能的工具,也可以說是通向人工智能的必經(jīng)之路。

1.深度學(xué)習(xí)的豐富應(yīng)用

Google研究的無(wú)人駕駛,其組件由兩個(gè)部分組成,一個(gè)是眼睛,一個(gè)是大腦,眼睛是激光測(cè)距儀和視頻攝像頭,汽車收集到這些視頻信號(hào)之后,并不能很好的識(shí)別,為了讓汽車能理解我們需要一個(gè)大腦,這個(gè)大腦就是深度學(xué)習(xí),通過深度學(xué)習(xí)我們可以告訴我們的車載的計(jì)算機(jī),現(xiàn)在前面有什么樣的物體,并且結(jié)構(gòu)化的抽取出來(lái)。

比如說這個(gè)是通過擋風(fēng)玻璃看到的畫面,讓機(jī)器理解,必須要判斷視野內(nèi)的物體是移動(dòng)還是靜止,如果是靜止的話,可以當(dāng)作是安全的物體,只需避讓即可,如果是移動(dòng)的物體,那么還需要我們判斷他的速度和行駛方向進(jìn)行相應(yīng)的路線規(guī)劃。

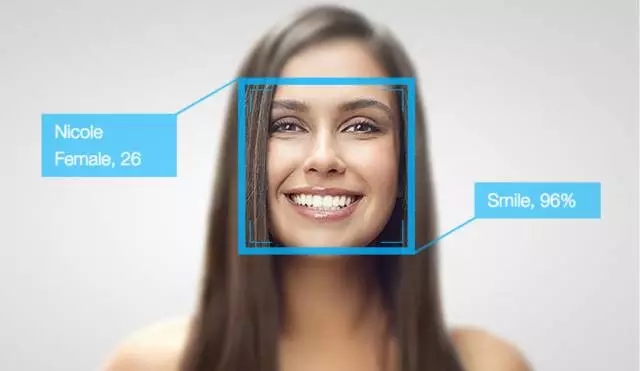

人臉識(shí)別,我們有很多技術(shù)做人臉識(shí)別,人臉識(shí)別可以做什么其他的東西呢?

深度學(xué)習(xí)不止告訴我們?nèi)四樤趫D片中哪個(gè)位置,甚至告訴我這個(gè)人臉是誰(shuí)的臉,是男性、女性,多大歲數(shù)都可以學(xué)習(xí)出來(lái),包括人臉部的重要結(jié)點(diǎn)位置可以猜出來(lái)這個(gè)人是什么樣的表情,甚至通過分析他嘴唇的動(dòng)作,可以說這個(gè)人在說什么話,包括頭發(fā)的顏色,戴什么樣的墨鏡,嘴唇涂什么樣的唇膏都可以識(shí)別出來(lái)。

格林深瞳的例子,比如說我們?cè)谥匾獧C(jī)構(gòu)里面可以有安防監(jiān)控,深度學(xué)習(xí)訓(xùn)練的卷積神經(jīng)網(wǎng)絡(luò)CNN,可以識(shí)別被監(jiān)控的人員是否有異常的舉動(dòng),還有就是對(duì)車輛的追捕,這輛車是否有逃逸的可能性,超速行駛,逆行變道的風(fēng)險(xiǎn)。

AlphaGo 2016年3月,Google DeepMind研發(fā)的AlphaGo 4:1 戰(zhàn)勝了世界冠軍李世石。標(biāo)志了一個(gè)時(shí)代的終結(jié)和一個(gè)時(shí)代的開始,人類在完全信息博弈的競(jìng)技中敗北,人工智能發(fā)展的元年開始。

圍棋很難被攻破的原因就是復(fù)雜度太高了.

每一步棋都有300多種可能,一盤棋平均有200多步,總的狀態(tài)數(shù)量超過了整個(gè)宇宙中所有原子的數(shù)量,不可能被搜索完整的狀態(tài),我們只能通過估算和直覺進(jìn)行圍棋的計(jì)算和思考。

象棋很早就被攻破了,圍棋可以堅(jiān)持這么久。深度學(xué)習(xí)可以讓機(jī)器有人類的直覺,預(yù)測(cè)人下一步要走什么,同時(shí)分析及其應(yīng)該走哪一步。所以說DeepMind研發(fā)的AlphaGo,基本上做到了知己知彼。

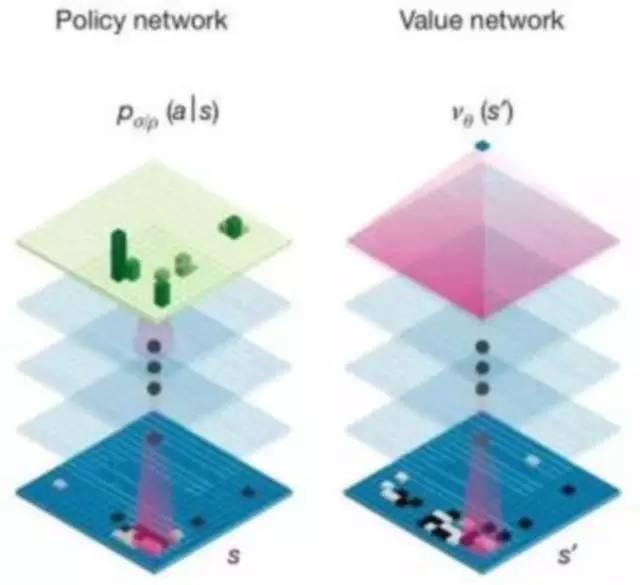

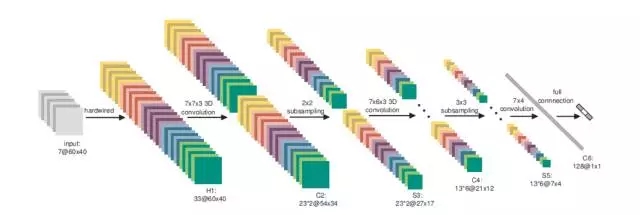

我們?cè)賮?lái)看看這兩個(gè)DeepMind深度學(xué)習(xí)的網(wǎng)絡(luò),左邊是策略網(wǎng)絡(luò),我走到一步的時(shí)候,分析棋盤上每個(gè)位置有多大價(jià)值,給每個(gè)位置打一個(gè)分?jǐn)?shù)。右邊這個(gè)估值網(wǎng)絡(luò)是估算黑白雙方的勝率的神經(jīng)網(wǎng)絡(luò)。

通過這兩個(gè)網(wǎng)絡(luò)的結(jié)合,再加上一些之前通用搜索的方法,比如蒙特卡洛搜索樹,可以讓計(jì)算機(jī)擁有一個(gè)非常強(qiáng)的對(duì)戰(zhàn)能力。

事實(shí)上是通過復(fù)盤的結(jié)果,AlphaGo和李世石對(duì)戰(zhàn)的時(shí)候,AlphaGo從一開始就認(rèn)為自己的勝率有60%以上,到最后基本達(dá)到了90%,他對(duì)整個(gè)棋盤的控制超過了人類的理解了,情況并不是很多評(píng)論員所認(rèn)為的可能雙方還是均勢(shì),李世石還有機(jī)會(huì)等等。大局完全都在AlphaGo的掌握當(dāng)中。

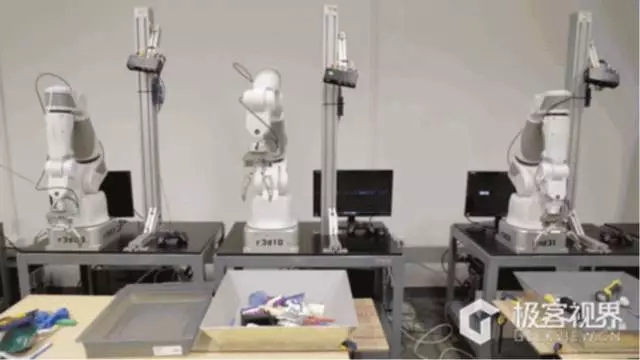

Deep Q Net,深度強(qiáng)化學(xué)習(xí)可以教會(huì)機(jī)器人如何靈活使用機(jī)械臂完成任務(wù)。

如果之前讓一個(gè)機(jī)器人編程,讓他去夾一個(gè)物體,不能有太多的干擾,否則就無(wú)法實(shí)現(xiàn)準(zhǔn)確的抓取。現(xiàn)在我隨便放一盒子?xùn)|西,深度強(qiáng)化網(wǎng)絡(luò)可以自動(dòng)訓(xùn)練這個(gè)機(jī)器人拿什么樣的物體,同時(shí)訓(xùn)練它怎么去夾,第一次沒有夾到那就再學(xué)習(xí),再嘗試,直到學(xué)會(huì)。

可以說深度學(xué)習(xí)讓機(jī)器人擁有幾歲小孩拾起物體的能力。

Google DeepDream實(shí)現(xiàn)夢(mèng)幻般的圖片生產(chǎn),仿若夢(mèng)魘一般。

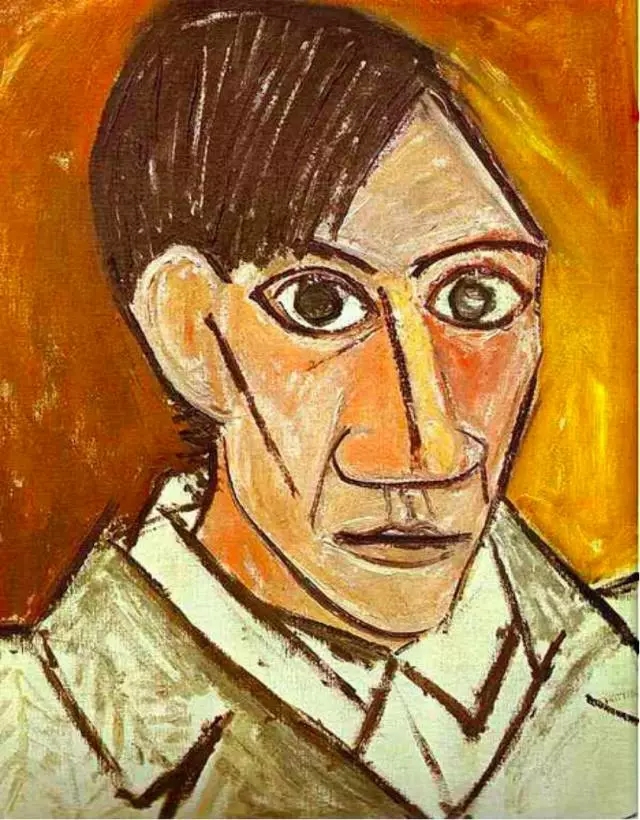

大家看這個(gè)圖,下邊這個(gè)圖是不是有點(diǎn)抽象,這個(gè)畫是用深度學(xué)習(xí)網(wǎng)絡(luò)自動(dòng)生成出來(lái)的,基本原理就是人觀察一張圖片的時(shí)候,記不住所有的細(xì)節(jié),在我們腦子里重構(gòu)的時(shí)候會(huì)用之前的經(jīng)驗(yàn)和概念在腦中塑造一個(gè)新的圖片,而深度學(xué)習(xí)也是這個(gè)意思,在大數(shù)據(jù)量的需要上,積累了很多過往的經(jīng)驗(yàn)和數(shù)據(jù),我們給他一幅圖片重構(gòu)的時(shí)候,就制造出一個(gè)仿佛做夢(mèng)或者腦海中胡思亂想的時(shí)候?qū)@個(gè)圖片產(chǎn)生的理解。所以我們可以說,它已經(jīng)具備了人類對(duì)事物抽象和重構(gòu)的能力。?

使用深度學(xué)習(xí)實(shí)現(xiàn)的EasyStyle,可以將任意圖片內(nèi)容與另一種圖片風(fēng)格融合

這個(gè)圖可能大家很熟悉,最上邊這位是美國(guó)總統(tǒng)競(jìng)選人Trump, 中間這幅畫是著名畫家的畫作,通過深度神經(jīng)網(wǎng)絡(luò)結(jié)合我們可以合成下面的圖,沒有進(jìn)行任何算法的調(diào)優(yōu),它獲取上邊這個(gè)圖內(nèi)容的信息,再獲取中間這個(gè)圖風(fēng)格的信息,完美的結(jié)合就成了中間這張圖。

Neural Doodle – 將涂鴉變成繪畫

比如說隨手涂鴉一幅畫,可以得到一幅像模像樣的一幅山水畫。

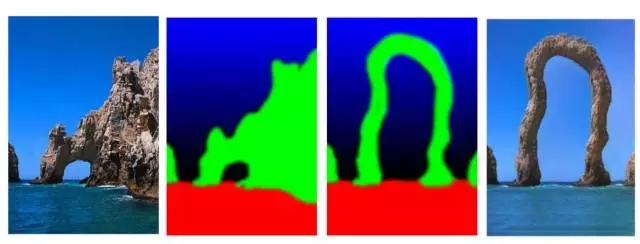

我們還可以先解析一幅圖的主要組成部分,然后調(diào)整其中的形狀,再把原來(lái)的圖重構(gòu)出來(lái),我們可以得出現(xiàn)實(shí)生活中不存在的圖,這個(gè)是類似于人腦對(duì)物體的解析和重構(gòu)的能力。

Image Analogies – 使用深度學(xué)習(xí)變形圖片

Deep Q Net - 深度強(qiáng)化網(wǎng)絡(luò)實(shí)現(xiàn)AI自動(dòng)玩游戲

GoogleDeepMind除了做圍棋軟件還有實(shí)現(xiàn)自動(dòng)玩游戲的AI,人類學(xué)習(xí)并不是一個(gè)監(jiān)督和非監(jiān)督的過程,是一個(gè)獎(jiǎng)懲的機(jī)制,你做對(duì)的時(shí)候會(huì)有好的刺激,比如說我哭了,我媽媽過來(lái)把飯拿過來(lái)了,我吃了,很高興,我下次可能餓了還要再哭。這套系統(tǒng)也是這樣的,隨即采取一些策略獲得比較高分的時(shí)候,他會(huì)記住這個(gè)策略。這幅圖是太空大戰(zhàn)游戲,使用程序玩游戲已經(jīng)超過了世界上玩這個(gè)游戲選手的較高水平了。

動(dòng)態(tài)記憶網(wǎng)絡(luò)實(shí)現(xiàn)的圖片問答系統(tǒng)

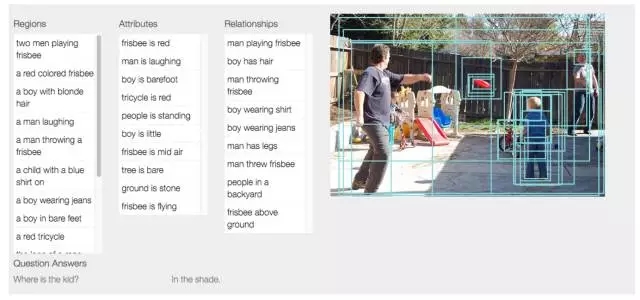

我們可以看看這幅圖,左邊是使用一個(gè)基于LSTM長(zhǎng)短期記憶網(wǎng)絡(luò)的動(dòng)態(tài)來(lái)對(duì)一段語(yǔ)言進(jìn)行理解,并回答問題。而右邊則是直接對(duì)圖片進(jìn)行提問并讓計(jì)算機(jī)回答,使用的技術(shù)是動(dòng)態(tài)記憶網(wǎng)絡(luò)。

目前我們可以做到這種程度,問左上角大巴的顏色是什么,最后轉(zhuǎn)換成語(yǔ)言回答,雖然回答只是簡(jiǎn)單的單詞,但是事實(shí)上深度神經(jīng)網(wǎng)絡(luò)已經(jīng)理解你的問題,同時(shí)在圖片上理解相關(guān)要素,然后再解析,回答你的能力了。其他幾個(gè)圖也是類似的概念。

其實(shí)深度學(xué)習(xí)學(xué)習(xí)的發(fā)展是離不開研究人員對(duì)數(shù)據(jù)集的探索的.

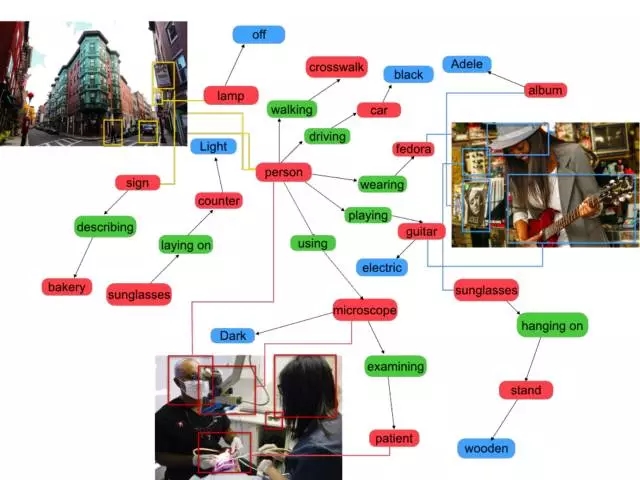

之前我們有一個(gè)知名的數(shù)據(jù)集叫做ImageNet,是有幾百萬(wàn)張圖片讓深度學(xué)習(xí)網(wǎng)絡(luò)訓(xùn)練和測(cè)試。現(xiàn)在它升級(jí)了,叫Visual Genome,不止對(duì)圖片分類,還要看出有什么關(guān)聯(lián)。

比如說這里有一個(gè)女人,戴著帽子,和帽子是什么關(guān)系,是佩戴的關(guān)系。她拿著吉他是拿和演奏的關(guān)系,我們要找不同物體之間存在的關(guān)系。

這個(gè)圖是一個(gè)簡(jiǎn)單的例子, 深度神經(jīng)網(wǎng)絡(luò)可以解析出這個(gè)圖片上有兩個(gè)成人和小孩,小孩扔飛盤,大人在看,我們要把關(guān)聯(lián)的關(guān)系、動(dòng)態(tài)的關(guān)系都挖掘出來(lái)。?

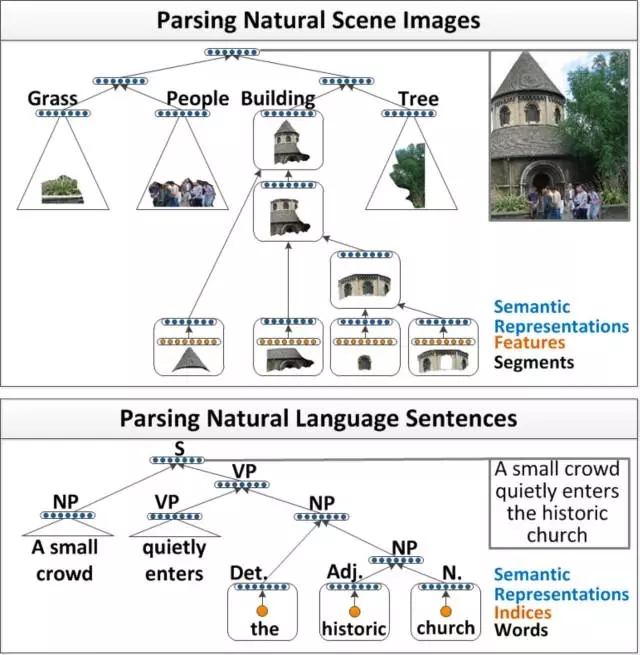

圖像識(shí)別與NLP,使用Deep Learning解析圖像中的結(jié)構(gòu)化信息,并生成描述性語(yǔ)言

我們看看這幅圖上能做什么,我們可以讓深度神經(jīng)網(wǎng)絡(luò)先嘗試?yán)斫膺@幅畫的結(jié)構(gòu),然后再用語(yǔ)言把這幅畫描述出來(lái),比如生成這樣一段話:這張圖右邊有一棵樹,左邊有一個(gè)塔,塔有一個(gè)塔尖和一個(gè)塔身組成,塔身上有三個(gè)窗戶,有一個(gè)門。塔前有許多人在站著。

Word Embedding, 或者Distributed Representation, 中文叫詞向量,是使用深度學(xué)習(xí)學(xué)習(xí)出來(lái)的單詞的向量化表示,有如下特性:

King – Man ? Queen – Woman

同時(shí)意思相似的詞,在空間位置上距離相近

詞向量把我們常用的詞匯轉(zhuǎn)化為空間中的某一個(gè)點(diǎn),點(diǎn)有什么特性呢: 如果詞匯意思相近的話,在空間中位置應(yīng)該也是相近的,左上角可以找到許多點(diǎn)都是城市,雖然深度神經(jīng)網(wǎng)絡(luò)不知道北京、倫敦在什么地方,里面有什么建筑也都不知道,但是通過大量的學(xué)習(xí)出來(lái)城市的概念,并把他們放在空間中很相近的位置。我們并沒有任何的語(yǔ)言和數(shù)據(jù)教它,是他通過大量的學(xué)習(xí)自己發(fā)現(xiàn)的。

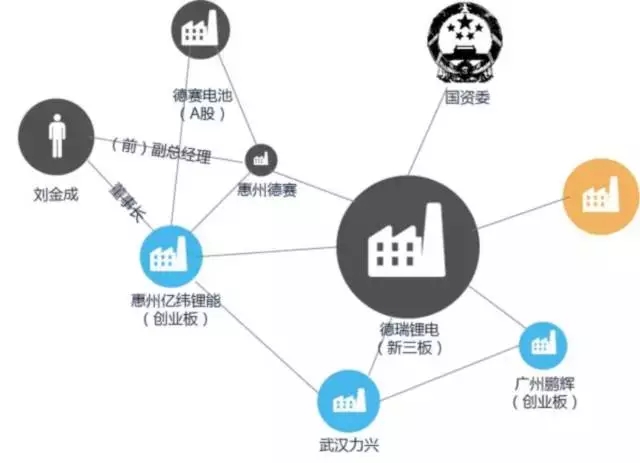

我們學(xué)習(xí)構(gòu)建一個(gè)深度的知識(shí)圖譜可以用在企業(yè)關(guān)系的挖掘,有一家上市公司,比如說是做鋰電池的,可以找到他投融資的企業(yè),并將上下游競(jìng)爭(zhēng)關(guān)系全部聯(lián)起來(lái),這些企業(yè)之間會(huì)有信息的傳遞,如果網(wǎng)絡(luò)構(gòu)建足夠大可以有一個(gè)模型,分析預(yù)測(cè)這個(gè)上市公司股價(jià)以后未來(lái)的走勢(shì)。

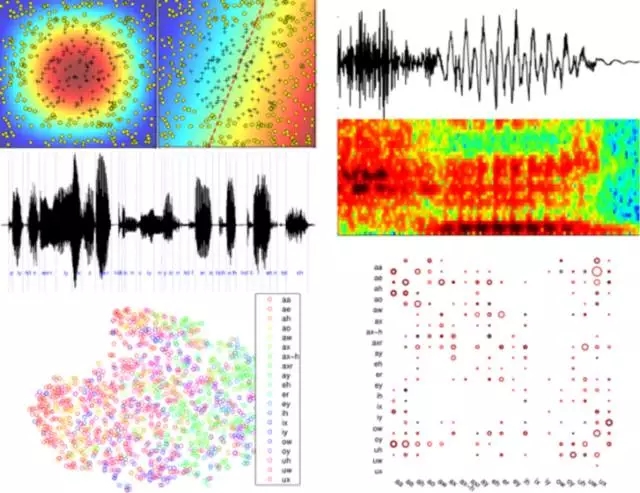

語(yǔ)音識(shí)別,百度最近有一個(gè)語(yǔ)音識(shí)別,叫雙向循環(huán)神經(jīng)網(wǎng)絡(luò)BDRNN,可以把每個(gè)音節(jié)都識(shí)別出來(lái),發(fā)音中略微有一些口音和錯(cuò)誤,也能夠把大致的意思正確的識(shí)別出來(lái)。這個(gè)是語(yǔ)音識(shí)別的可視化的圖像,我們把語(yǔ)音信號(hào)降維成一個(gè)平面的圖,你會(huì)發(fā)現(xiàn)同一個(gè)元音音節(jié)和輔音音節(jié)在平面當(dāng)中很相近的,都被抽象成有相鄰關(guān)系的點(diǎn),說明它真正理解了語(yǔ)音這個(gè)聲頻信號(hào)代表的含義。

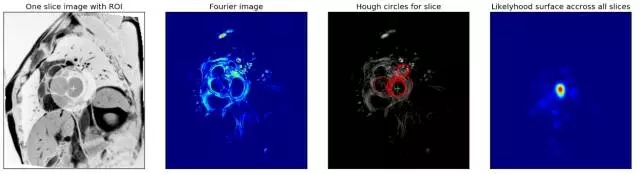

作為醫(yī)療診斷的重要根據(jù),這是去年特別有名的心臟疾病診斷的比賽,當(dāng)時(shí)參加比賽的最后獲得冠軍的隊(duì)伍,他們做到了準(zhǔn)確度甚至超過了專家的水平。將幾萬(wàn)張圖片給深度學(xué)習(xí)的網(wǎng)絡(luò)學(xué)習(xí)規(guī)律,其中正確答案是五位專家商討得到的,但是計(jì)算機(jī)的水平超過了單個(gè)專家的診斷水平。

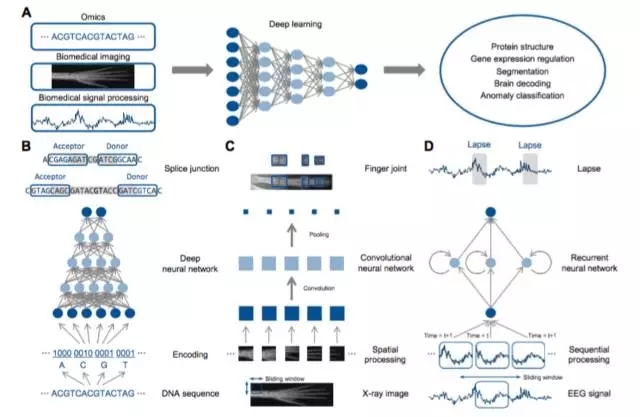

Deep Learning in Bioinformatics:深度學(xué)習(xí)在生物醫(yī)學(xué)領(lǐng)域,比如醫(yī)學(xué)圖像處理、醫(yī)學(xué)信號(hào)處理等有很好的應(yīng)用基礎(chǔ)

對(duì)DNA的解析,有很多遺傳病是基因突變引起的,可能不是某一兩個(gè)節(jié)點(diǎn),可能是同時(shí)有幾千個(gè)節(jié)點(diǎn)發(fā)生了問題,讓人判斷究竟怎么組合才會(huì)出問題是不可能了。這個(gè)時(shí)候深度學(xué)習(xí)可以來(lái)告訴我們,我們拿到一個(gè)人DNA之后,可以自動(dòng)分析出來(lái)你在未來(lái)得某種疾病的幾率有多少,可以提早的預(yù)防治療。

2.深度學(xué)習(xí)到底為什么這么厲害

深度學(xué)習(xí)是一個(gè)對(duì)特征不斷抽象的過程,我們給他一個(gè)圖片,深度神經(jīng)網(wǎng)絡(luò)首先提取出點(diǎn)和邊,然后組合成人局部的器官,比如說一個(gè)眼睛和鼻子,局部的器官之后可以把拼接成一個(gè)個(gè)人臉,人臉外貌上有差異,我們用模版再匹配出最相似的就可以看看有沒有人臉。

深度學(xué)習(xí)非常像人的學(xué)習(xí)過程,你必須一層一層的抽象才能理解更深的概念,之所以叫深度是有多層的學(xué)習(xí)網(wǎng)絡(luò),每一層是把特征抽象更高階的概念,理解非常復(fù)雜的事物。

這是深度學(xué)習(xí)網(wǎng)絡(luò)可視化的結(jié)果,我們給一個(gè)識(shí)別數(shù)字的神經(jīng)網(wǎng)絡(luò)一張數(shù)字‘8’的圖,可以清楚的看到每一層神經(jīng)網(wǎng)絡(luò)對(duì)原圖進(jìn)行了哪些特征變換。?

這是一個(gè)深度學(xué)習(xí)常見的卷積結(jié)構(gòu),細(xì)節(jié)不講了,大家可以感受一下,其中主要了Convolution Layer, Max-Pooling Layer, 以及ReLu Activation。

?Auto-Encoder(Layer-wise Training), RBM, DBN

? PReLu, RReLu

? Dropout

? RNN, LSTM

? Max-Out

? Highway (Residual Net)

? Batch normalization

Weight normalization

隨著研究的不斷深入,深度學(xué)習(xí)還有著各種各樣的變種和組件,上面是一些的關(guān)于深度學(xué)習(xí)的研究成果。

3.深度學(xué)習(xí)在實(shí)際項(xiàng)目中

我們講講深度學(xué)習(xí)在我們明略項(xiàng)目中的應(yīng)用。我們有個(gè)很大的制造業(yè)客戶,他們有個(gè)故障預(yù)測(cè)的項(xiàng)目。我們能做什么呢?

深度學(xué)習(xí)除了建模的能力比普通的強(qiáng)一點(diǎn),還可以學(xué)習(xí)時(shí)間序列的結(jié)構(gòu),設(shè)備傳感器的數(shù)據(jù)是一個(gè)時(shí)間序列,每一秒鐘或者多少毫秒產(chǎn)品信號(hào),我們用傳統(tǒng)的方法很難處理這么高緯度,這么大數(shù)據(jù)量的模型法國(guó),深度學(xué)習(xí)可以理解在時(shí)間上的關(guān)系,大大提高我們對(duì)故障分類的預(yù)測(cè)。

另外一個(gè)就是在銀行對(duì)不良客戶檢測(cè)的模型中,我們有數(shù)百維的儲(chǔ)蓄、消費(fèi)、信貸特征如果我們請(qǐng)專家來(lái)做非常困難,因?yàn)楹芏鄷r(shí)候,當(dāng)你的特征太多了,很難想到那么多規(guī)則的組合,用深度學(xué)習(xí)可以進(jìn)行自動(dòng)特征組合。

比如說發(fā)現(xiàn)我的銀行的儲(chǔ)蓄額很高,但是可能在月底突然取出來(lái)了,可能就代表著我可能只是臨時(shí)在里面,跟別人借的錢放在里面,并不是我有這么高的資金做抵押,這個(gè)時(shí)候發(fā)現(xiàn)的時(shí)候,就可以排除在外,這個(gè)可能就超過了很多行業(yè)專家的工作效率了。 ??

深度學(xué)習(xí)對(duì)我們的DataInsight是前沿重要的方向,我們會(huì)推出軟硬一體的解決方案,我們也會(huì)使用TESLA GPU做深度學(xué)習(xí)加速器。

Q&A

Q1:深度學(xué)習(xí)看上去很復(fù)雜,對(duì)于新手應(yīng)該怎么去學(xué),能不能推薦一些深度學(xué)習(xí)方面的書籍和流行的框架?

A1:深度學(xué)習(xí)的數(shù)學(xué)理論其實(shí)并不復(fù)雜,但是需要注意的細(xì)節(jié)太多了,我們需要大量的時(shí)間來(lái)消化理解各個(gè)概念,對(duì)于新手,我推薦先上手代碼,再研究原理,目前的深度學(xué)習(xí)框架非常之多,包括TensorFlow, theano, lasagne, keras, sknn, no learn, caffe, mxnet, leaf, torch7, convnetjs等。tensorflow目前是github上最火的框架,我本人也是TensorFlow前20的contributor, 但是目前并不推薦新手直接使用Tensorflow,新手最簡(jiǎn)單易用的框架是keras,沒有之一,可以先看上面的tutorial上手代碼,理論方面,可以先學(xué)習(xí)MIT出的 Deep Learnign的書來(lái)學(xué)習(xí),這一本作者包括深度學(xué)習(xí)三巨頭Bengio?

Q2:dl在明略的具體應(yīng)用場(chǎng)景,遇到的困難?

A2:DL在明略的應(yīng)用確實(shí)不是完全一帆風(fēng)順,我們?cè)诓渴鸫罱℅PU集群來(lái)訓(xùn)練DL時(shí)就需要非常多的坑,現(xiàn)在我們的產(chǎn)品DataInsight可以自動(dòng)的幫我們解決這個(gè)環(huán)境問題,在數(shù)據(jù)上,我們需要收集比較大量的數(shù)據(jù),才可以讓DL發(fā)揮出強(qiáng)大的威力,在數(shù)據(jù)上,我們需要收集比較大量的數(shù)據(jù),才可以讓DL發(fā)揮出強(qiáng)大的威力,量級(jí)起碼需要在十萬(wàn)條數(shù)據(jù)以上,較好是百萬(wàn)以上,然后就是參數(shù)調(diào)試的問題,不同的網(wǎng)絡(luò)結(jié)構(gòu),激活函數(shù),dropout,learning rate,參數(shù)實(shí)在太多,可能對(duì)初學(xué)者來(lái)說,感覺像是噩夢(mèng),然而隨著對(duì)DL理論的理解,我們可以清晰的指導(dǎo)自己調(diào)參的思路,選擇一條較佳的道路去解決這個(gè)問題,什么時(shí)候用CNN,什么時(shí)候用RNN,什么時(shí)候用dropout,都是很有意思,并且很有內(nèi)在道理的。能推薦幾本書?或者資源嗎? 關(guān)于這個(gè)問題,我推薦去github上有一個(gè)項(xiàng)目叫 awesome deeplearning,上面有非常多的關(guān)于DL的資源

Q3:請(qǐng)問現(xiàn)在對(duì)深度學(xué)習(xí)有一定理解,也有過相關(guān)經(jīng)歷用過keras等,請(qǐng)問怎么樣更深入學(xué)習(xí)?

A3:如果對(duì)基礎(chǔ)代碼熟練了,可以嘗試去學(xué)習(xí)DL各個(gè)變種以及組件的原理,并在比較底層的框架,如theano,tensofrflow上自己實(shí)現(xiàn)?

Q4:我是深度學(xué)習(xí)的碩士,請(qǐng)問現(xiàn)在有哪些工作還可以去做?

A4: 目前在NLP方向的研究還沒有像CV和語(yǔ)音識(shí)別爆發(fā)起來(lái),還存在很多灌水的空間

Q5:內(nèi)存和數(shù)據(jù)庫(kù)以及CPU是否是深度學(xué)習(xí)的瓶頸?如果是則使用什么數(shù)據(jù)庫(kù)能達(dá)到相應(yīng)性能?

A5: 深度學(xué)習(xí)一般使用GPU訓(xùn)練,顯存可能會(huì)成為瓶頸,數(shù)據(jù)庫(kù),cpu一般不會(huì)成為瓶頸

Q6:請(qǐng)問對(duì)于圖像處理,是否用不到RNN? 這個(gè)問題很有意思

A6:RNN用于有時(shí)間上前后關(guān)系的序列,以及需要記憶的網(wǎng)絡(luò),很有優(yōu)勢(shì),可以說的是,在視頻中,肯定是可以用到的,還有剛才的圖片問答的整體系統(tǒng)中,也是需要用到RNN的。?

Q7:請(qǐng)問深度學(xué)習(xí)在能應(yīng)用在教育大數(shù)據(jù)分析中嗎

A7: DL基本可以用于任何數(shù)據(jù)集和問題,前提是有足夠多的數(shù)據(jù)量,這個(gè)是最重要的瓶頸,然而隨著對(duì)DL理論的理解,我們可以清晰的指導(dǎo)自己調(diào)參的思路,選擇一條較佳的道路去解決這個(gè)問題,可否稍微詳細(xì)介紹下較佳道路? 最重要的是網(wǎng)絡(luò)結(jié)構(gòu),先設(shè)計(jì)好是用CNN還是RNN,用多深的網(wǎng)絡(luò),用不用maxpooling,接下來(lái)就是Activation 函數(shù)的選擇了,目前比較好的是relu系列的,包括PRelu, Leaky Relu, RRelue, 另一個(gè)選擇就是maxout.如果需要處理復(fù)雜問題,可以考慮highway或resnet,這兩個(gè)可以訓(xùn)練非常深的網(wǎng)絡(luò),如果過擬合嚴(yán)重,可以考慮dropout或者regularization。最后,再考慮hidden layer unit number, learning rate等等?

Q8:請(qǐng)問spark中那些可以在深度學(xué)習(xí)中應(yīng)用呢?

A8: 目前有很多應(yīng)用在spark中的DL框架,包括Elephas(依賴Keras), SparkNet, CaffeOnSpark(依賴Caffe)

Q9:請(qǐng)問在圖像處理領(lǐng)域,DL還有哪方面的事情可以去研究?

A9:目前比較火的一個(gè)方向是 圖像生成,DCGAN, 還有利用DL進(jìn)行去噪,甚至是超分辨率,去模糊等方面的研究

Q10:在relu等方法之后,一定程度上減輕了梯度擴(kuò)散的問題,請(qǐng)問網(wǎng)絡(luò)層數(shù)該如何選擇(顯然不是越多越好)?或者說,現(xiàn)階段限制網(wǎng)絡(luò)層數(shù)的主要原因有哪些?

A10:網(wǎng)絡(luò)層數(shù)過深目前依然會(huì)帶來(lái)一些問題,比如訓(xùn)練過難,局部最優(yōu),鞍點(diǎn)等問題,還有就是也有過擬合的可能,如果問題確實(shí)非常復(fù)雜,比如圖片分類,我們可以使用resnet或者h(yuǎn)ighway來(lái)訓(xùn)練超深的網(wǎng)絡(luò),如果是簡(jiǎn)單一些的問題,我們可以考慮在深層一些的網(wǎng)絡(luò)中加入類似dropout, weight regularization等減輕過擬合.

Q11:我是新手,想問下深度學(xué)習(xí)需要哪些技術(shù)和理論基礎(chǔ)?

A11:DL,首先需要在線性代數(shù)方面的基礎(chǔ)知識(shí),其次還有概率論,凸優(yōu)化,基礎(chǔ)數(shù)據(jù)挖掘概念等知識(shí)?

Q12:DL在政務(wù)領(lǐng)域有哪些應(yīng)用?

A12:可以參見MIT的Deep learning的書籍,里面有很基礎(chǔ)的講解,可以簡(jiǎn)單入門?

Q13:與VR有什么交叉點(diǎn)嗎?

A13:與VR關(guān)聯(lián)可能不大,但是與AR關(guān)系很大,因?yàn)锳R需要先識(shí)別出圖像中的實(shí)體,再去進(jìn)行augmentation增強(qiáng),其中的識(shí)別需要用到DL?

Q14:分布式環(huán)境上的深度學(xué)習(xí),老師最推崇哪個(gè)?

A14:分布式的深度學(xué)習(xí)框架,最推薦tensorflow,在100臺(tái)節(jié)點(diǎn)的gpu服務(wù)器集群上,tensorflow的總體性能是單節(jié)點(diǎn)的56倍,也就是可以達(dá)到56%的分布式效率,遠(yuǎn)超其他框架

Q15:先請(qǐng)問黃老師一個(gè)不正經(jīng)的問題:有哪些任務(wù)目前為止的實(shí)驗(yàn)結(jié)果表明不適合DL?

A15:稀疏特征的數(shù)據(jù)上,DL并不適用,比如適用bag of words再接DL效果一就很差,還有一個(gè)就是小數(shù)據(jù)量上DL可能會(huì)嚴(yán)重欠擬合?

Q16:話說對(duì)于一個(gè)大陸的學(xué)校的學(xué)生。如果本校沒有什么出色老師研究這方面,怎么入門?

A16:建議先研究代碼,先研讀keras的tutorial中的sample code, 然后再讀MIT的Deep Learning這本書,最后讀論文,通過tensorflow或者theano復(fù)現(xiàn)論文的方法。?

Q17:如何保證程序不被壞的數(shù)據(jù)教壞,比如垃圾數(shù)據(jù),或者惡意構(gòu)造的數(shù)據(jù),以影響其本身的學(xué)習(xí)精度,就像微軟的小冰,最近看到國(guó)外版本好像都要下線了,就是被人教壞了 .

A17:這個(gè)問題很有趣,目前確實(shí)沒有什么特別好的辦法解決這個(gè)問題,可能需要在網(wǎng)絡(luò)結(jié)構(gòu)上使用減輕過擬合的組件和策略,并且避免使用過大的learning rate和過小的batch size。

Q18:?請(qǐng)問黃老師 在金融風(fēng)控征信方式 dl應(yīng)用場(chǎng)景 能舉些典型例子么

A18:在政務(wù)和金融領(lǐng)域的應(yīng)用,比如使用DL實(shí)現(xiàn)自動(dòng)的征信打分模型,政府或者銀行擁有超大規(guī)模的數(shù)據(jù),完全可以滿足DL的需求,加上DL自動(dòng)組合特征的能力,是完全可以在準(zhǔn)確度上超過其他模型的。

歡迎加入本站公開興趣群商業(yè)智能與數(shù)據(jù)分析群

興趣范圍包括各種讓數(shù)據(jù)產(chǎn)生價(jià)值的辦法,實(shí)際應(yīng)用案例分享與討論,分析工具,ETL工具,數(shù)據(jù)倉(cāng)庫(kù),數(shù)據(jù)挖掘工具,報(bào)表系統(tǒng)等全方位知識(shí)

QQ群:81035754

文章版權(quán)歸作者所有,未經(jīng)允許請(qǐng)勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請(qǐng)注明本文地址:http://specialneedsforspecialkids.com/yun/4339.html

摘要:但是在傳統(tǒng)的機(jī)器學(xué)習(xí)中,特征和算法都是人工定義的。傳統(tǒng)的深度學(xué)習(xí)中,是由人來(lái)決定要解決什么問題,人來(lái)決定用什么目標(biāo)函數(shù)做評(píng)估。 隨著柯潔與AlphaGo結(jié)束以后,大家是不是對(duì)人工智能的底層奧秘越來(lái)越有興趣?深度學(xué)習(xí)已經(jīng)在圖像分類、檢測(cè)等諸多領(lǐng)域取得了突破性的成績(jī)。但是它也存在一些問題。首先,它與傳統(tǒng)的機(jī)器學(xué)習(xí)方法一樣,通常假設(shè)訓(xùn)練數(shù)據(jù)與測(cè)試數(shù)據(jù)服從同樣的分布,或者是在訓(xùn)練數(shù)據(jù)上的預(yù)測(cè)結(jié)果與在...

摘要:對(duì)深度學(xué)習(xí)模型而言,水就是海量的數(shù)據(jù)。就拿機(jī)器識(shí)別物體這樣的任務(wù)來(lái)說,通過數(shù)百萬(wàn)副圖片的訓(xùn)練,深度學(xué)習(xí)模型甚至可以超過人的肉眼的識(shí)別能力,這確實(shí)是人工智能在感知類問題上重要的里程碑。關(guān)于深度學(xué)習(xí),還有一個(gè)有趣的現(xiàn)象。 說到人工智能和機(jī)器人,上點(diǎn)兒歲數(shù)的碼農(nóng)們可能對(duì)封面這張圖有點(diǎn)印象。不明就里的朋友,可以回去補(bǔ)習(xí)一下《編輯部的故事》。我是個(gè)二手的人工智能表演藝術(shù)家:從博士畢業(yè)開始,就在MSRA...

摘要:同時(shí),也會(huì)催生出超人類。年,深藍(lán)戰(zhàn)勝人類國(guó)際象棋冠軍,標(biāo)記著人工智能往前邁開了重要一大步。年大勝柯潔,人工智能即將碾軋人類的話題遍進(jìn)入大眾視野,迅即引起普遍的狂熱和焦慮。 showImg(http://upload-images.jianshu.io/upload_images/13825820-1b6450ee3f490762.jpg?imageMogr2/auto-orient/s...

摘要:如果這個(gè)場(chǎng)景足夠簡(jiǎn)單的話,深度學(xué)習(xí)并不能表現(xiàn)出相對(duì)于其它基于傳統(tǒng)模式識(shí)別方法的優(yōu)勢(shì)。這是深度學(xué)習(xí)目前受到關(guān)注的一個(gè)非常重要的原因。通過積累大量的數(shù)據(jù)進(jìn)行足夠的訓(xùn)練,基于深度學(xué)習(xí)的系統(tǒng)可以給出最優(yōu)規(guī)劃。 谷歌和李世石的人機(jī)大戰(zhàn)引爆了公眾對(duì)于人工智能的關(guān)注,也讓基于深度學(xué)習(xí)的人工智能成為汽車業(yè)界關(guān)注的重點(diǎn),那么深度學(xué)習(xí)在智能駕駛的應(yīng)用場(chǎng)景下有什么幫助呢?自動(dòng)駕駛最先出現(xiàn)在美國(guó),而不是歐洲或者日本...

閱讀 3728·2021-09-22 15:49

閱讀 3298·2021-09-08 09:35

閱讀 1421·2019-08-30 15:55

閱讀 2320·2019-08-30 15:44

閱讀 713·2019-08-29 16:59

閱讀 1597·2019-08-29 16:16

閱讀 478·2019-08-28 18:06

閱讀 889·2019-08-27 10:55