資訊專欄INFORMATION COLUMN

小模型,成為本周的AI爆點。

與動輒上千億參數的大模型相比,小模型的優勢是顯而易見的:它們不僅計算成本更低,訓練和部署也更為便捷,可以滿足計算資源受限、數據安全級別較高的各類場景。因此,在大筆投入大模型訓練之余,像 OpenAI、谷歌等科技巨頭也在積極訓練好用的小模型。先是HuggingFace推出了小模型SmoLLM;OpenAI直接殺入小模型戰場,發布了GPT-4o mini。

GPT-4o mini發布同天,歐洲最強AI初創公司Mistral立馬發布旗下最新最強小模型——Mistral NeMo。這個小模型由 Mistral AI 和英偉達聯合打造,參數量為120億(12B),上下文窗口為128k。這是一款尋求在不依賴大量云資源的情況下實施 AI 解決方案的企業的強大工具。

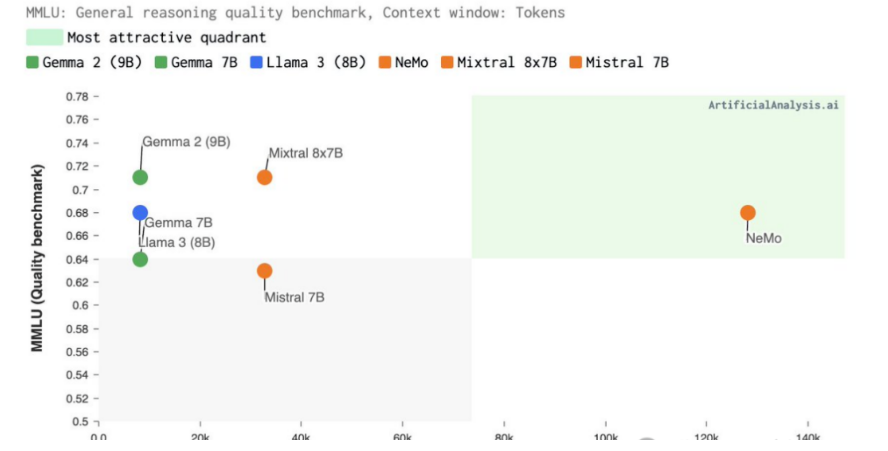

Mistral NeMo支持128K上下文,能夠更加連貫、準確地處理廣泛且復雜的信息,確保輸出與上下文相關。

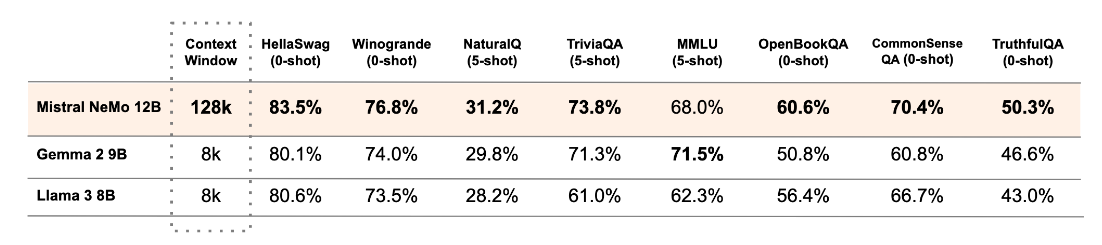

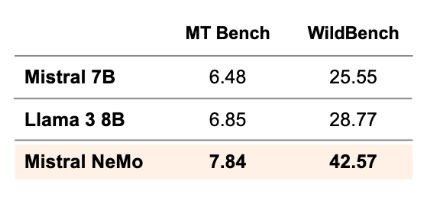

與同等參數規模模型相比,它的推理、世界知識和編碼準確性都處于領先地位。

下表結果所示,除了在MMLU基準上,Mistral NeMo不如Gemma 2 9B。但在多輪對話、數學、常識推理、世界知識和編碼等基準中,超越了Gemma 2 9B和Llama 3 8B。

Mistral在Apache2.0許可證下發布了預訓練的基本檢查點和指令微調檢查點,允許商用。

Mistral NeMo 經過量化感知訓練,可在不損失任何性能的情況下進行 FP8推理。

此外,模型使用FP8數據格式進行模型推理,這可以減少內存大小并加快部署速度,而不會降低準確性。這意味著,模型可以流暢絲滑地學習任務,并更有效地處理不同的場景,使其成為企業的理想選擇。

這種格式可以在任何地方輕松部署,各種應用程序都能靈活使用。因此,模型可以在幾分鐘內,部署到任何地方,免去等待和設備限制的煩惱。

Mistral NeMo瞄準企業用戶的使用,采用屬于NVIDIA AI Enterprise一部分的企業級軟件,具有專用功能分支、嚴格的驗證流程以及企業級安全性的支持。開放模型許可證也允許企業將Mistral NeMo無縫集成到商業應用程序中。

Mistral NeMo NIM專為安裝在單個NVIDIA L40S、NVIDIA GeForce RTX 4090或NVIDIA RTX 4500 GPU的內存上而設計,高效率低成本,并且保障安全性和隱私性。也就是說,單個英偉達L40S,一塊GPU就可跑了。

Mistral AI和英偉達各自擅長的領域結合,優化了Mistral NeMo的訓練和推理。模型利用Mistral AI的專業知識進行訓練,尤其是在多語言、代碼和多輪內容方面,受益于英偉達全堆棧的加速訓練。它專為實現最佳性能而設計,利用高效的模型并行技術、可擴展性以及與Megatron-LM的混合精度。該模型使用NVIDIA NeMo的一部分Megatron-LM進行訓練,在DGX Cloud上配備3,072個H100 80GB Tensor Core GPU,由NVIDIA AI架構組成,包括加速計算、網絡結構和軟件,以提高訓練效率。

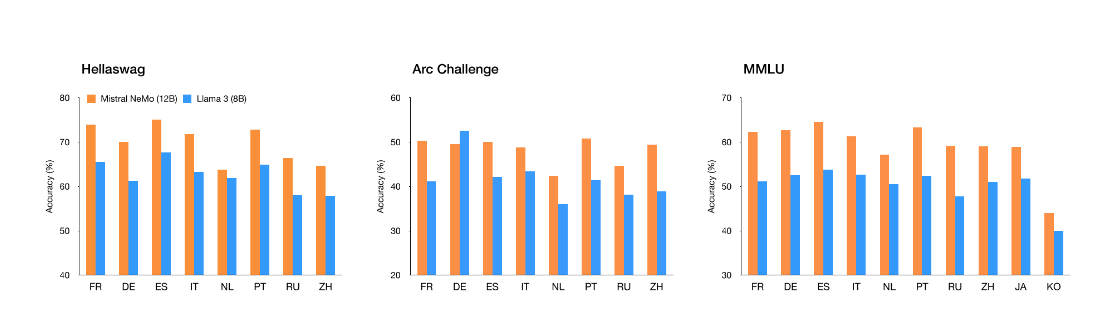

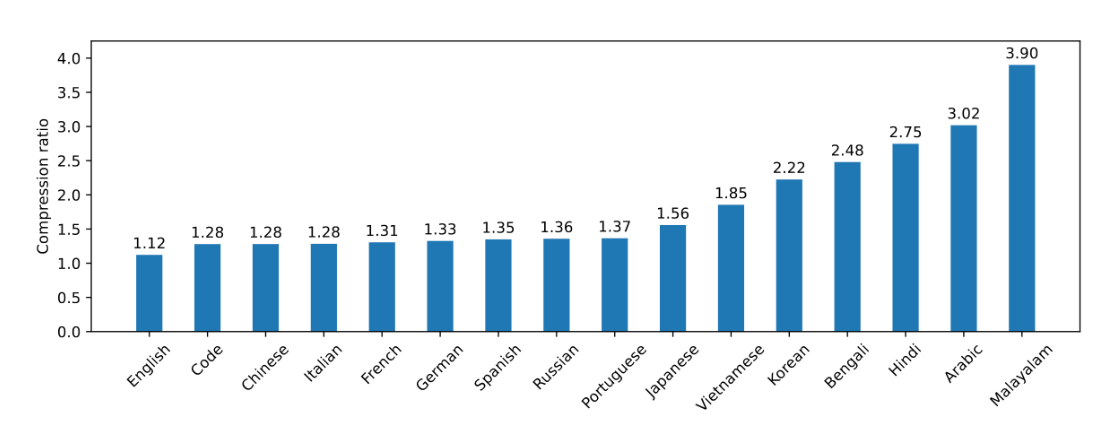

Mistral NeMo模型專為全球多語言應用程序而設計。它受過函數調用訓練,擁有一個大型上下文窗口,在英語、法語、德語、西班牙語、意大利語、葡萄牙語、中文、日語、韓語、阿拉伯語和印地語方面表現尤為突出。可以說,這是將前沿人工智能模型帶到全世界不同語言使用者手中的重要一步。下圖是Mistral NeMo 在多語言基準測試中的表現:

Mistral NeMo使用基于Tiktoken的全新分詞器——Tekken,該分詞器已針對100多種語言進行訓練,并且比以前的Mistral模型中使用的SentencePiece分詞器更有效地壓縮自然語言文本和源代碼。具體而言,在壓縮源代碼、中文、意大利語、法語、德語、西班牙語和俄語方面的效率提高了約30%;在壓縮韓語和阿拉伯語方面的效率也分別提高了2倍和3倍。與Llama 3分詞器相比,Tekken在壓縮大約85%的所有語言的文本方面表現更為出色。

Mistral NeMO 經歷了高級微調和調整階段。與 Mistral 7B 相比,它在遵循精確指令、推理、處理多輪對話和生成代碼方面表現得更好。

隨著 AI 領域的不斷發展,Mistral-NeMo 的發布標志著為企業提供更可訪問、高效和強大的 AI 工具方面的重要里程碑。這將如何影響更廣泛的 AI 生態系統還有待觀察,但可以肯定的是:將 AI 能力更接近最終用戶的競賽正在升溫,Nvidia 和 Mistral AI 已經在這一方向上邁出了大膽的一步。用戶可以立即通過ai.nvidia.com作為NVIDIA NIM體驗Mistral NeMo,可下載的NIM版本即將推出。

文章版權歸作者所有,未經允許請勿轉載,若此文章存在違規行為,您可以聯系管理員刪除。

轉載請注明本文地址:http://specialneedsforspecialkids.com/yun/131139.html

隨著大型模型技術的持續發展,視頻生成技術正逐步走向成熟。以Sora、Gen-3等閉源視頻生成模型為代表的技術,正在重新定義行業的未來格局。而近幾個月,國產的AI視頻生成模型也是層出不窮,像是快手可靈、字節即夢、智譜清影、Vidu、PixVerse V2 等。就在近日,智譜AI秉承以先進技術,服務全球開發者的理念,宣布將與清影同源的視頻生成模型——CogVideoX開源,以期讓每一位開發者、每一家企...

Llama3 中文聊天項目綜合資源庫,該文檔集合了與Lama3 模型相關的各種中文資料,包括微調版本、有趣的權重、訓練、推理、評測和部署的教程視頻與文檔。1. 多版本支持與創新:該倉庫提供了多個版本的Lama3 模型,包括基于不同技術和偏好的微調版本,如直接中文SFT版、Instruct偏好強化學習版、趣味版等。此外,還有Phi3模型中文資料倉庫的鏈接,和性能超越了8b版本的Llama3。2. 部...

2024年4月18日,Meta AI正式宣布推出開源大模型Llama3,這標志著開源大型語言模型(LLM)領域的又一重大突破。Llama3以其卓越的性能和廣泛的應用前景,或將推動人工智能技術快速邁進新紀元。為方便AI應用企業及個人AI開發者快速體驗Llama3的超高性能,近期優刻得GPU云主機上線Llama3-8B-Instruct-Chinese鏡像,一鍵配置,快速部署模型開發環境。為客戶提供開...

NVIDIA和MIT的研究人員推出了一種新的視覺語言模型(VLM)預訓練框架,名為VILA。這個框架旨在通過有效的嵌入對齊和動態神經網絡架構,改進語言模型的視覺和文本的學習能力。VILA通過在大規模數據集如Coy0-700m上進行預訓練,采用基于LLaVA模型的不同預訓練策略進行測試。研究人員還引入了視覺指令調整方法,利用視覺語言數據集進行基于提示的指令調整來細化模型。VILA在視覺問答基準測試中...

NVIDIA和MIT的研究人員推出了一種新的視覺語言模型(VLM)預訓練框架,名為VILA。這個框架旨在通過有效的嵌入對齊和動態神經網絡架構,改進語言模型的視覺和文本的學習能力。VILA通過在大規模數據集如Coy0-700m上進行預訓練,采用基于LLaVA模型的不同預訓練策略進行測試。研究人員還引入了視覺指令調整方法,利用視覺語言數據集進行基于提示的指令調整來細化模型。VILA在視覺問答基準測試中...

閱讀 156·2024-12-10 11:51

閱讀 303·2024-11-07 17:59

閱讀 328·2024-09-27 16:59

閱讀 466·2024-09-23 10:37

閱讀 540·2024-09-14 16:58

閱讀 334·2024-09-14 16:58

閱讀 531·2024-08-29 18:47

閱讀 811·2024-08-16 14:40