資訊專欄INFORMATION COLUMN

Gradient Al最近將Llama-3 8B和7B模型通過漸進(jìn)式訓(xùn)練方法不斷將Llama-3模型的上下文長度從8k-路擴(kuò)展到262k、524k

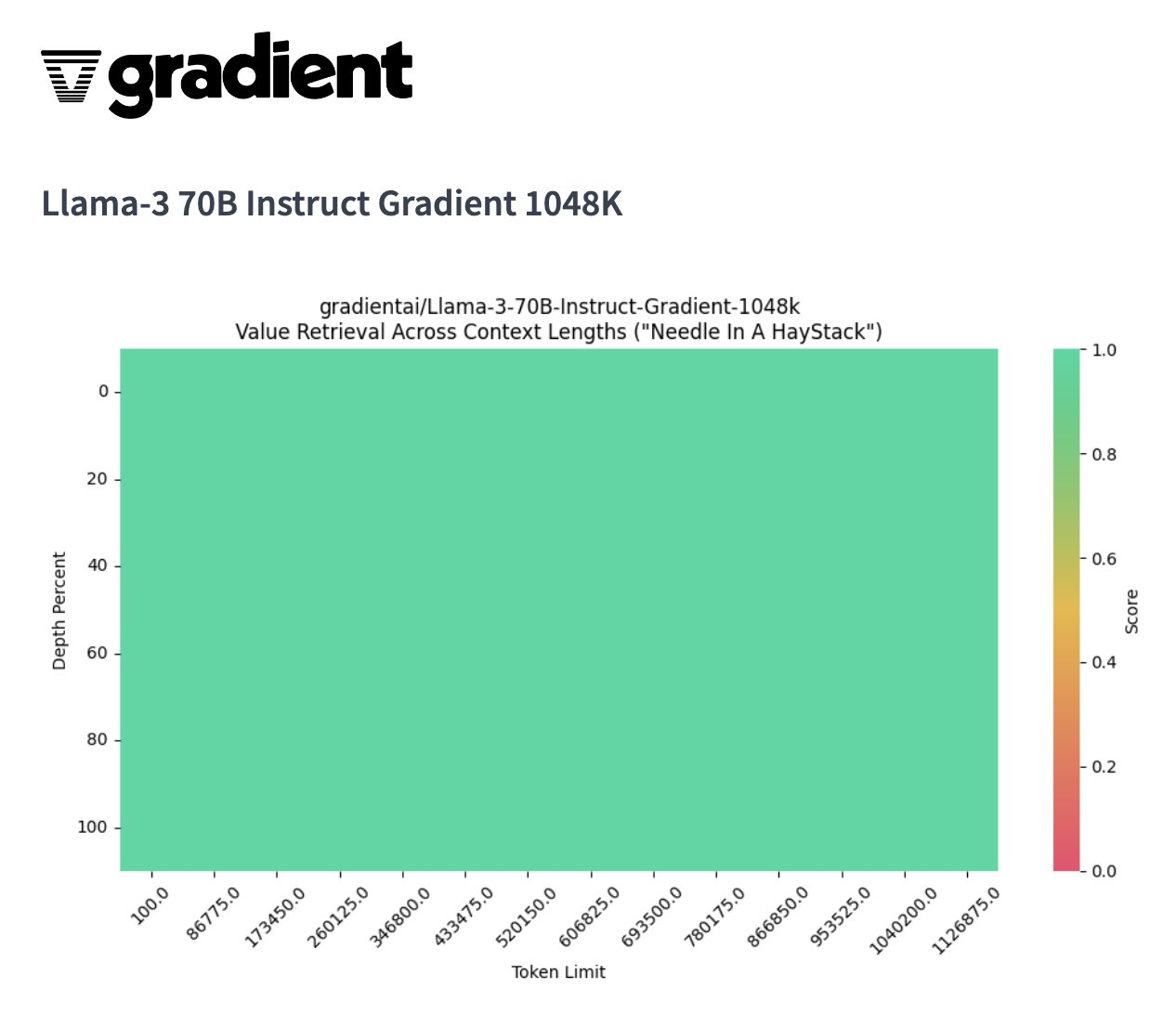

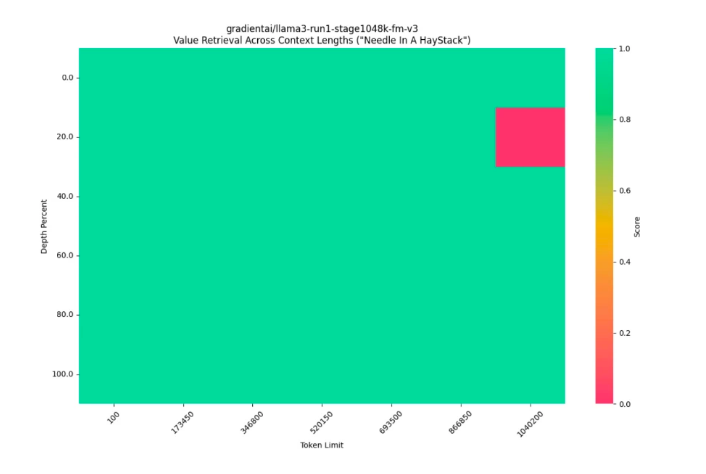

今天Gradient Al成功宣布成功地將Llama-3 系列模型的上下文長度擴(kuò)展到超過1 M...并且1M上下文窗口 70B 模型在 NIAH(大海撈針)上取得了完美分?jǐn)?shù)。Llama 3模型最初被訓(xùn)練用于處理8000個token的默認(rèn)上下文長度,約相當(dāng)于6,000字或10頁文檔。

Gradient為了解鎖更長上下文的使用場景,擴(kuò)展了Llama 3模型的上下文窗口到超過100萬。這種擴(kuò)展使得模型可以處理相當(dāng)于《哈利·波特》系列前五本書的內(nèi)容量。

這種擴(kuò)展顯著增加了模型處理長文本的能力,允許它在一個任務(wù)中考慮更多的信息,從而提高了理解和生成文本的精確度和相關(guān)性。

為了逐步適應(yīng)這種大幅度增加的上下文長度,Gradient Al采用了漸進(jìn)式訓(xùn)練方法。這意味著模型從較短的序列長度開始訓(xùn)練,逐漸增加到目標(biāo)長度。這種方法有助于模型逐步學(xué)習(xí)處理更長文本的策略,而不是一開始就直接面對極大的挑戰(zhàn)。

方法概述

方法概述

1.漸進(jìn)式訓(xùn)練(Progressive Training)

步驟:模型從處理較短的文本序列開始,逐步增加處理的序列長度。這種漸進(jìn)式增長使模型能夠適應(yīng)在每個步驟中的學(xué)習(xí)挑戰(zhàn),從而逐步提高處理更長序列的能力。

優(yōu)勢:這種方法有助于避免在初期階段由于序列長度過大而導(dǎo)致的訓(xùn)練困難,保證了訓(xùn)練的穩(wěn)定性和效率。

2.使用 RingAttention 和 EasyContext Blockwise

技術(shù)細(xì)節(jié):為了高效管理長序列的計算負(fù)擔(dān),采用 RingAttention 庫優(yōu)化注意力機(jī)制的計算,使其能夠擴(kuò)展到非常長的序列。同時,EasyContext Blockwise 技術(shù)被用來分塊處理長文本,進(jìn)一步提高處理速度和降低內(nèi)存需求。

應(yīng)用效果:這些技術(shù)提高了模型在長序列上的訓(xùn)練和推理速度,使得在大規(guī)模GPU集群中的部署和執(zhí)行變得更加高效。

3.NTK-aware 插值和縮放法則

目的:利用神經(jīng)切線核(NTK)理論優(yōu)化模型參數(shù)的初始化和調(diào)整,以適應(yīng)不同長度的文本處理

實施:通過遵循縮放法則和進(jìn)行NTK-aware的參數(shù)插值,調(diào)整模型的RoPE(Rotary Positional Embeddings)theta參數(shù),使模型在不同長度的文本上表現(xiàn)最佳。

訓(xùn)練細(xì)節(jié)

1.數(shù)據(jù)處理

數(shù)據(jù)集:使用了大規(guī)模圖像-文本配對數(shù)據(jù)集和純文本數(shù)據(jù)集,這些數(shù)據(jù)集被用來交錯訓(xùn)練模型以平衡視覺和文本信息的處理能力。

數(shù)據(jù)增強(qiáng):采用數(shù)據(jù)增強(qiáng)策略來豐富訓(xùn)練數(shù)據(jù),提高模型對不同類型文本的適應(yīng)性和魯棒性

2.硬件配置

部署環(huán)境:模型在Crusoe Energy的高性能L40S集群上進(jìn)行訓(xùn)練,這些集群配備了先進(jìn)的GPU和高速網(wǎng)絡(luò)連接,以支持大規(guī)模并行處理。

項目地址:https://huggingface.co/gradientai/Llama-3-70B-Instruct-Gradient-1048k

附高性能NVIDIA RTX 40 系列云服務(wù)器購買:

UCloud GPU云平臺擁有A100、A800、4090、V100S、P40等海量高性能GPU顯卡,靈活計費(fèi),彈性擴(kuò)展,滿足AI訓(xùn)練、推理、微調(diào)等場景需求。

http://specialneedsforspecialkids.com/site/active/gpu.html?ytag=seo

compshare算力共享平臺,高性價比4090顯卡,配備獨立IP,支持按時、按天、按月靈活計費(fèi)。適合AI推理、微調(diào)用戶場景使用。

https://www.compshare.cn/?ytag=seo

文章版權(quán)歸作者所有,未經(jīng)允許請勿轉(zhuǎn)載,若此文章存在違規(guī)行為,您可以聯(lián)系管理員刪除。

轉(zhuǎn)載請注明本文地址:http://specialneedsforspecialkids.com/yun/131091.html

Llama3 中文聊天項目綜合資源庫,該文檔集合了與Lama3 模型相關(guān)的各種中文資料,包括微調(diào)版本、有趣的權(quán)重、訓(xùn)練、推理、評測和部署的教程視頻與文檔。1. 多版本支持與創(chuàng)新:該倉庫提供了多個版本的Lama3 模型,包括基于不同技術(shù)和偏好的微調(diào)版本,如直接中文SFT版、Instruct偏好強(qiáng)化學(xué)習(xí)版、趣味版等。此外,還有Phi3模型中文資料倉庫的鏈接,和性能超越了8b版本的Llama3。2. 部...

在很長一段時間內(nèi),占據(jù)大模型評測榜單最前列的大多是一些閉源模型,直到Meta再次發(fā)布了最新的開源模型。就在近日,Meta和OpenAI打響了硅谷 AI 大模型保衛(wèi)戰(zhàn)。美國當(dāng)?shù)貢r間7月23日,Meta正式發(fā)布Llama 3.1。其包含8B、70B 和405B三個規(guī)模,最大上下文提升到了128k。Llama是目前開源領(lǐng)域中用戶最多、性能最強(qiáng)的大型模型系列之一。Meta 表示,他們將通過提供更多與模型協(xié)...

2024年4月18日,Meta AI正式宣布推出開源大模型Llama3,這標(biāo)志著開源大型語言模型(LLM)領(lǐng)域的又一重大突破。Llama3以其卓越的性能和廣泛的應(yīng)用前景,或?qū)⑼苿尤斯ぶ悄芗夹g(shù)快速邁進(jìn)新紀(jì)元。為方便AI應(yīng)用企業(yè)及個人AI開發(fā)者快速體驗Llama3的超高性能,近期優(yōu)刻得GPU云主機(jī)上線Llama3-8B-Instruct-Chinese鏡像,一鍵配置,快速部署模型開發(fā)環(huán)境。為客戶提供開...

摘要:月日,云棲大會深圳峰會現(xiàn)場,阿里云發(fā)布并現(xiàn)場演示了阿里視頻云最新互聯(lián)網(wǎng)直播解決方案。這是全球發(fā)布的首個視頻云解決方案,也是全球首次互聯(lián)網(wǎng)視頻直播。接近年后,阿里云用一只淘公仔畫面,宣告了互聯(lián)網(wǎng)直播時代的來臨。 3月28日,云棲大會·深圳峰會現(xiàn)場,阿里云發(fā)布并現(xiàn)場演示了阿里視頻云最新8K互聯(lián)網(wǎng)直播解決方案。這是全球發(fā)布的首個8K視頻云解決方案,也是全球首次8K互聯(lián)網(wǎng)視頻直播。 showI...

閱讀 157·2024-12-10 11:51

閱讀 303·2024-11-07 17:59

閱讀 330·2024-09-27 16:59

閱讀 466·2024-09-23 10:37

閱讀 540·2024-09-14 16:58

閱讀 336·2024-09-14 16:58

閱讀 532·2024-08-29 18:47

閱讀 813·2024-08-16 14:40